1.简述人工智能、机器学习和深度学习三者的联系与区别。

人工智能是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。

机器学习是一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。专门研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。它是人工智能的核心,是使计算机具有智能的根本途径。

深度学习是机器学习领域中一个新的研究方向,它被引入机器学习使其更接近于最初的目标——人工智能。深度学习是一类模式分析方法的统称,就具体研究内容而言,主要涉及三类方法:基于卷积运算的神经网络系统,即卷积神经网络;基于多层神经元的自编码神经网络;以多层自编码神经网络的方式进行预训练,进而结合鉴别信息进一步优化神经网络权值的深度置信网络。

简而言之,机器学习是一种实现人工智能的方法,深度学习是一种实现机器学习的技术。人工智能最大,次之是机器学习,最后是深度学习;人工智能包含机器学习,机器学习包含深度学习。

2. 全连接神经网络与卷积神经网络的联系与区别。

相同点:都是通过一层一层的节点组织起来的,每一个节点就是一个神经元;结构相似,卷积神经网络的输入输出以及训练的流程和全连接神经网络也基本一致。

区别:在全连接神经网络中,每相邻两层之间的节点都有边相连,于是会将每一层的全连接层中的节点组织成一列,这样方便显示连接结构。而对于卷积神经网络,相邻两层之间只有部分节点相连,为了展示每一层神经元的维度,一般会将每一层卷积层的节点组织成一个三维矩阵。全连接神经网络和卷积神经网络的唯一区别就是神经网络相邻两层的连接方式。

3.理解卷积计算。

以digit0为例,进行手工演算。

from sklearn.datasets import load_digits #小数据集8*8

digits = load_digits()

| 0 | 0 | 5 | 13 | 9 | 1 | 0 | 0 |

| 0 | 0 | 13 | 15 | 10 | 15 | 5 | 0 |

| 0 | 3 | 15 | 2 | 0 | 11 | 8 | 0 |

| 0 | 4 | 12 | 0 | 0 | 8 | 8 | 0 |

| 0 | 5 | 8 | 0 | 0 | 9 | 8 | 0 |

| 0 | 4 | 11 | 0 | 1 | 12 | 7 | 0 |

| 0 | 2 | 14 | 5 | 10 | 12 | 0 | 0 |

| 0 | 0 | 6 | 13 | 10 | 0 | 0 | 0 |

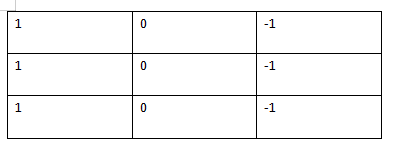

卷积核:

卷积结果:

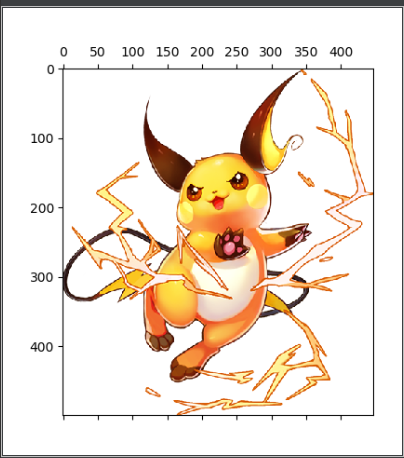

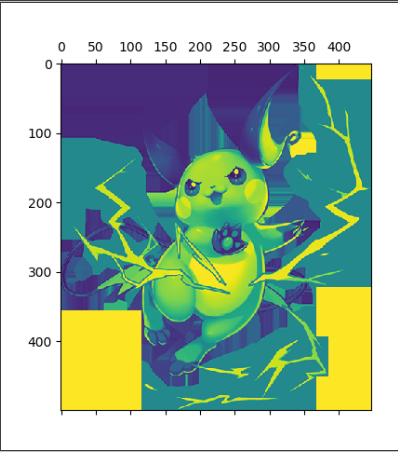

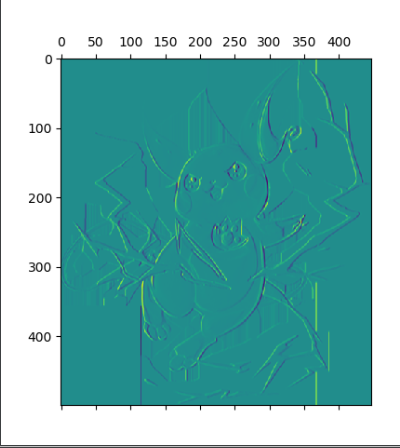

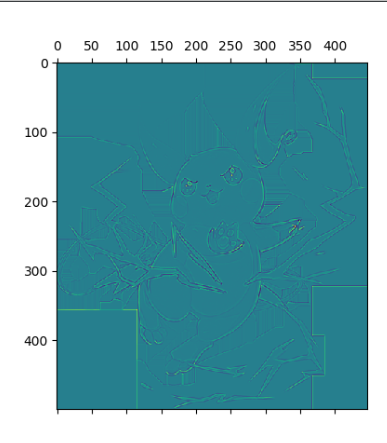

4.理解卷积如何提取图像特征。

读取一个图像;

以下矩阵为卷积核进行卷积操作;

显示卷积之后的图像,观察提取到什么特征。

| 1 | 0 | -1 |

| 1 | 0 | -1 |

| 1 | 0 | -1 |

| 1 | 1 | 1 |

| 0 | 0 | 0 |

| -1 | -1 | -1 |

| -1 | -1 | -1 |

| -1 | 8 | -1 |

| -1 | -1 | -1 |

卷积API

scipy.signal.convolve2d

tf.keras.layers.Conv2D

源代码:

from PIL import Image

import matplotlib.pyplot as plt

import numpy as np

from scipy.signal import convolve2d

I=Image.open(r'D:桌面机器学习截图皮卡丘.jpg')

L=I.convert('L')

cat=np.array(I) #原图

plt.matshow(cat)

plt.show()

catg=np.array(L) #灰质图

plt.matshow(catg)

plt.show()

k1=np.array([[1,0,-1],[1,0,-1],[1,0,-1]]) #垂直边缘检测

k2=np.array([[1,1,1],[0,0,0],[-1,-1,-1]]) #水平边缘检测

k3=np.array([[-1,-1,-1],[-1,8,-1],[-1,-1,-1]]) #中间检测

#boundary:边界填充方式,mode卷积类型

cat1=convolve2d(catg,k1,boundary='symm',mode='same')

cat2=convolve2d(catg,k2,boundary='symm',mode='same')

cat3=convolve2d(catg,k3,boundary='symm',mode='same')

plt.matshow(cat1)

plt.show()

plt.matshow(cat2)

plt.show()

plt.matshow(cat3)

plt.show()

原图: 灰质图:

垂直边缘: 水平边缘:

中间检测:

5. 安装Tensorflow,keras

参考:https://blog.csdn.net/u011119817/article/details/88309256

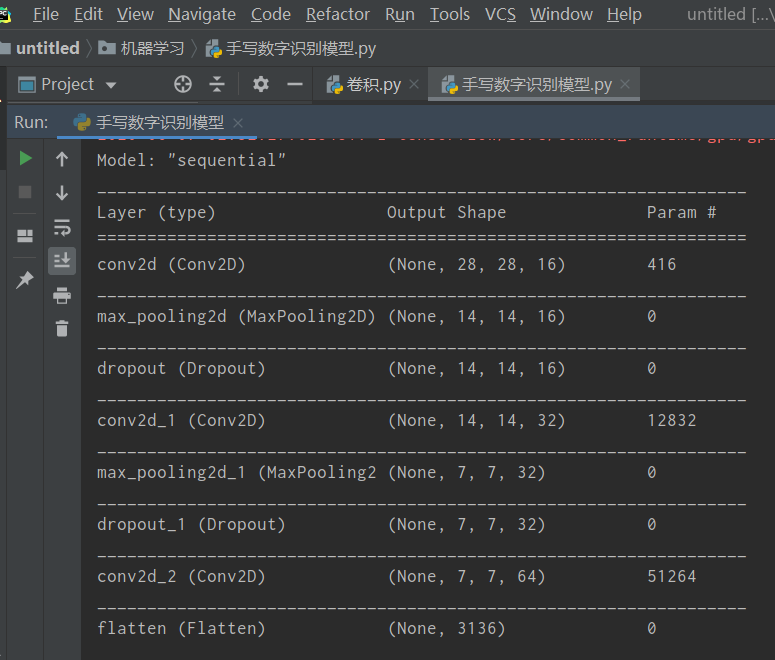

6. 设计手写数字识别模型结构,注意数据维度的变化。

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Flatten, Conv2D, MaxPool2D

model = tf.keras.Sequential()

model.add(Conv2D(…))

model.add(MaxPool2D(…))

...

#可以上传手动演算的每层数据结构的变化过程。model.summary()

参考:

https://www.jianshu.com/p/afe485aa08ce

https://blog.csdn.net/junjun150013652/article/details/82217571

源代码:

# 导入相关包

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Dropout, Flatten, Conv2D, MaxPool2D

# 建立模型

model = Sequential()

model.add(Conv2D(filters=16,kernel_size=(5, 5),padding='same',

input_shape=(28, 28, 1),activation='relu')) # 一层卷积

model.add(MaxPool2D(pool_size=(2, 2))) # 池化层1

model.add(Dropout(0.25))

model.add(Conv2D(filters=32,kernel_size=(5, 5),padding='same',activation='relu')) # 二层卷积

model.add(MaxPool2D(pool_size=(2, 2))) # 池化层2

model.add(Dropout(0.25))

model.add(Conv2D(filters=64,kernel_size=(5, 5),padding='same',activation='relu')) # 三层卷积

model.add(Flatten()) # 平坦层

model.add(Dense(128, activation='relu')) # 全连接层

model.add(Dropout(0.25))

model.add(Dense(10, activation='softmax')) # 激活函数

model.summary()

每层数据结构的变化过程: