版权声明:本文为博主原创文章,未经博主同意不得转载。

https://blog.csdn.net/peghoty/article/details/28329603

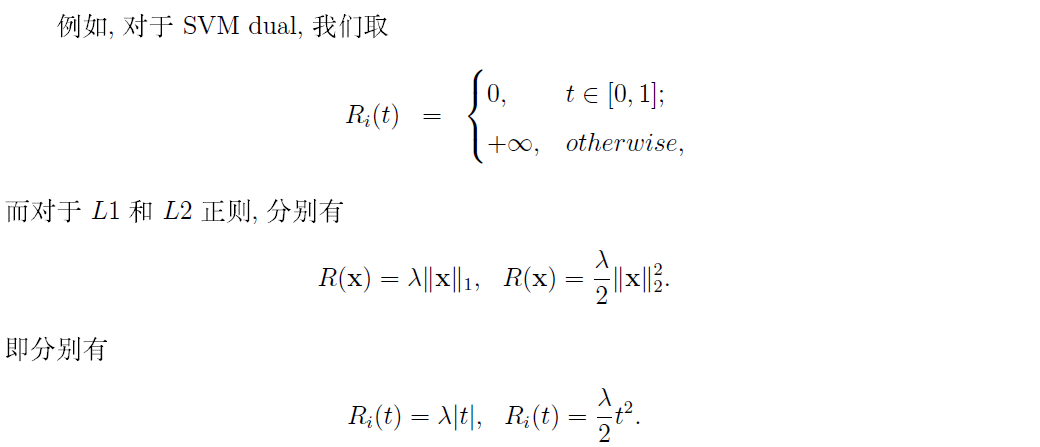

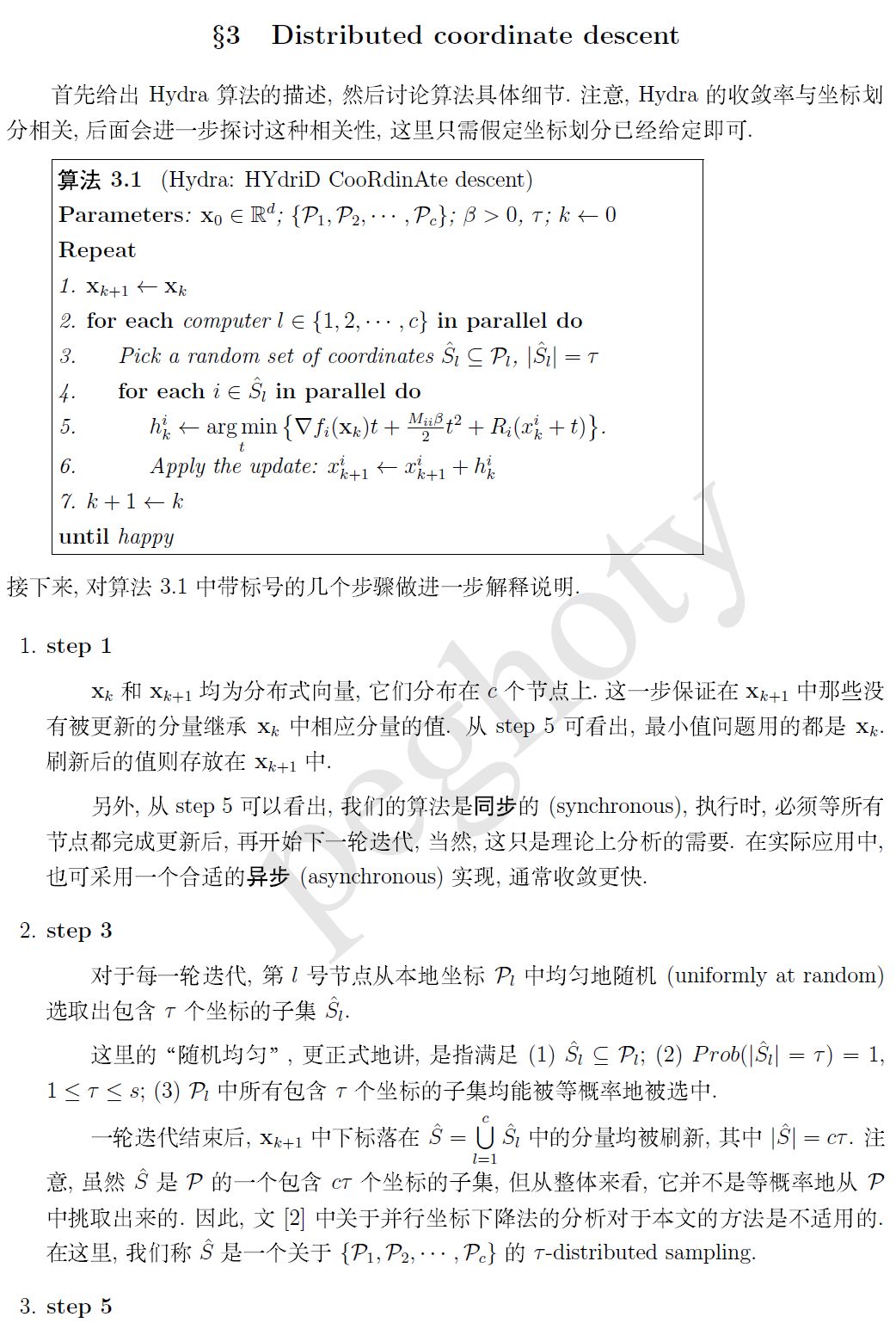

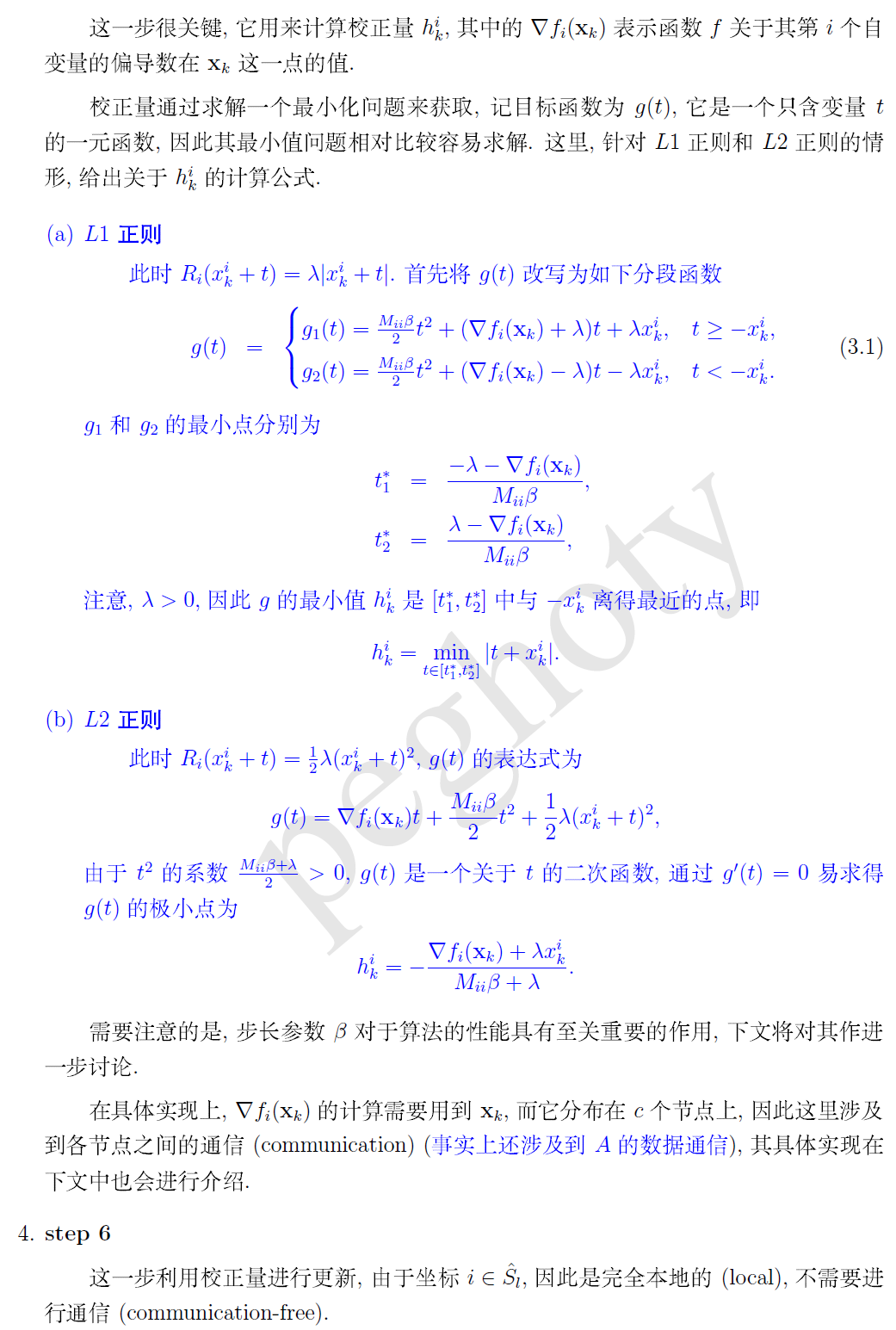

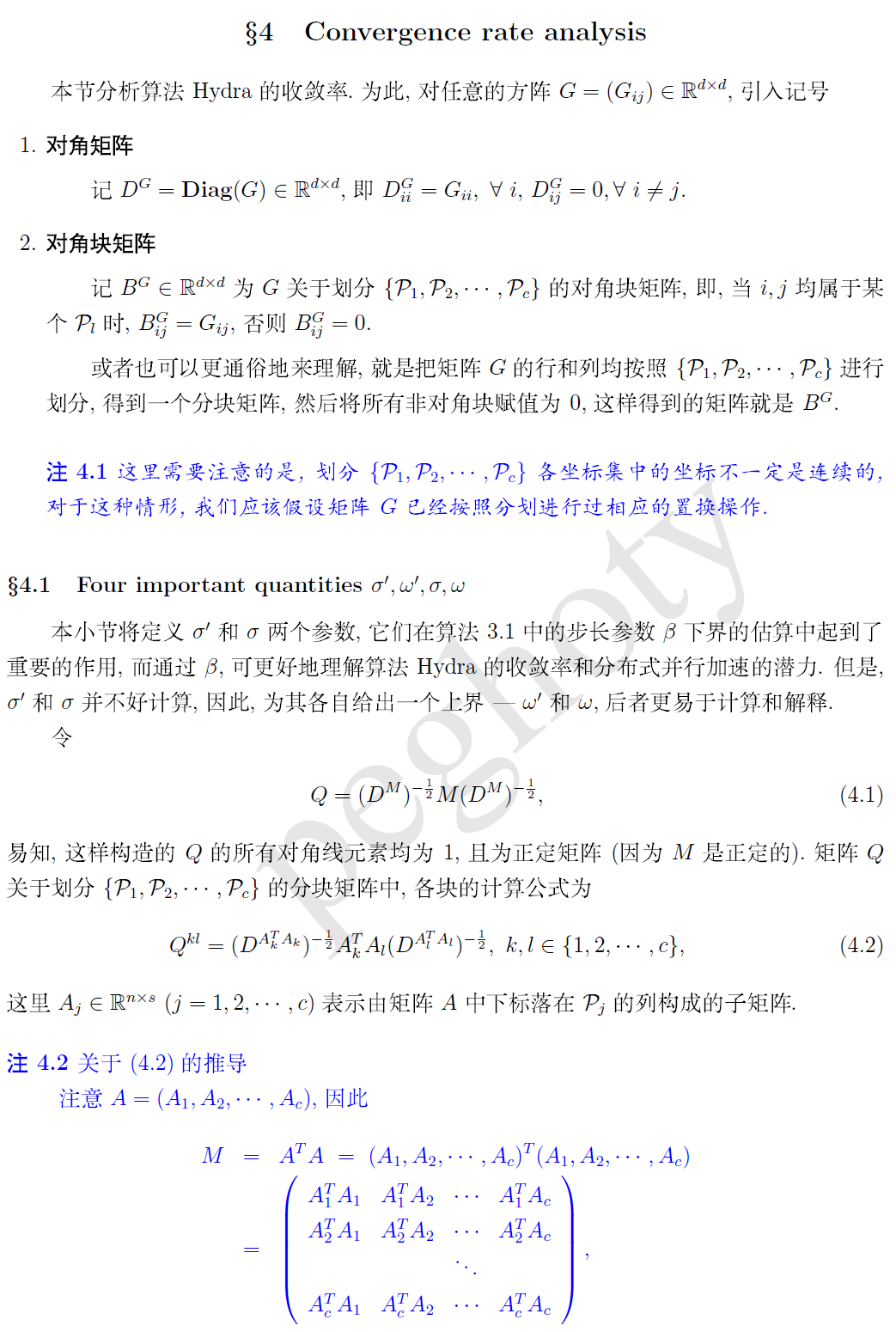

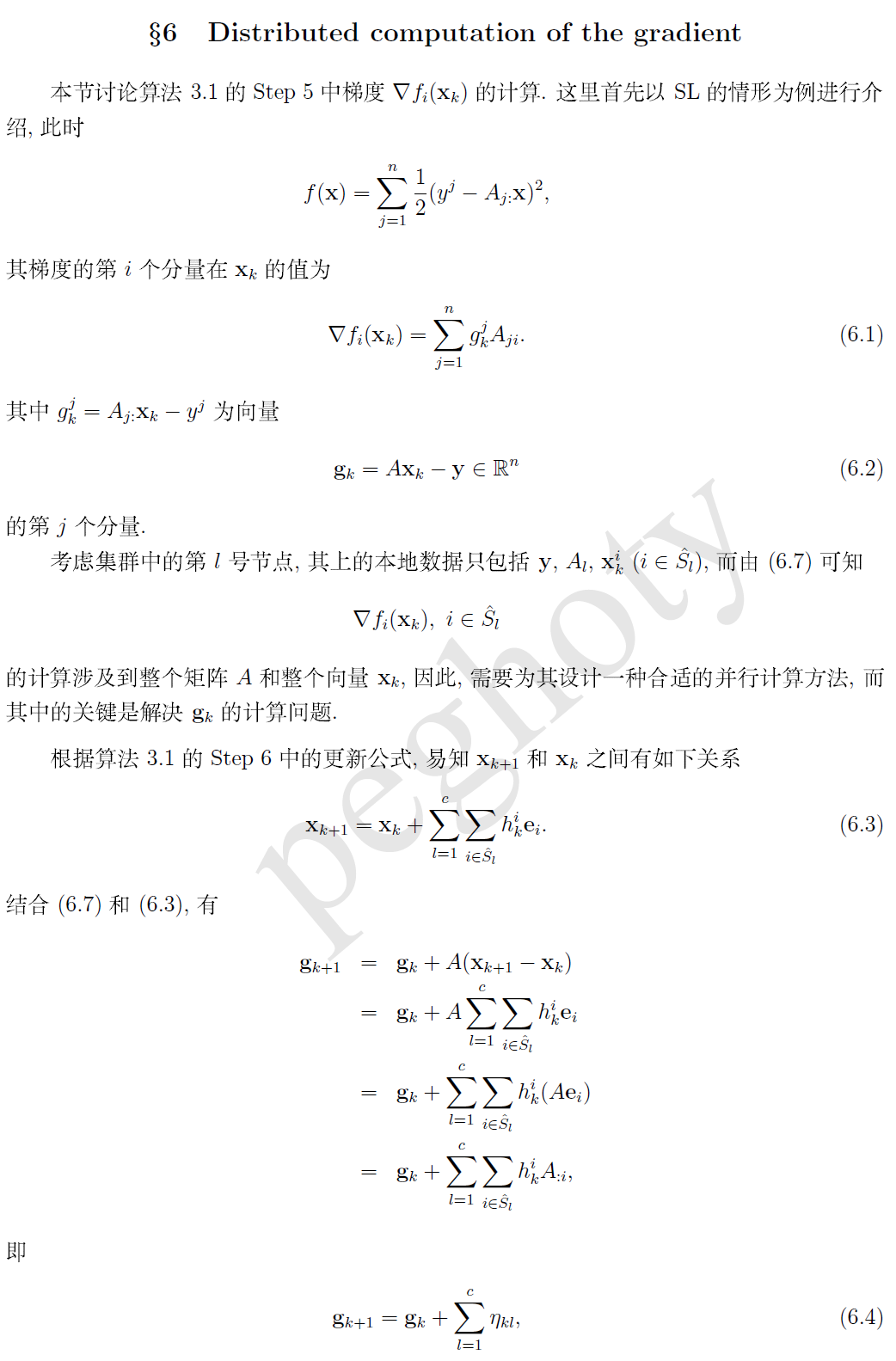

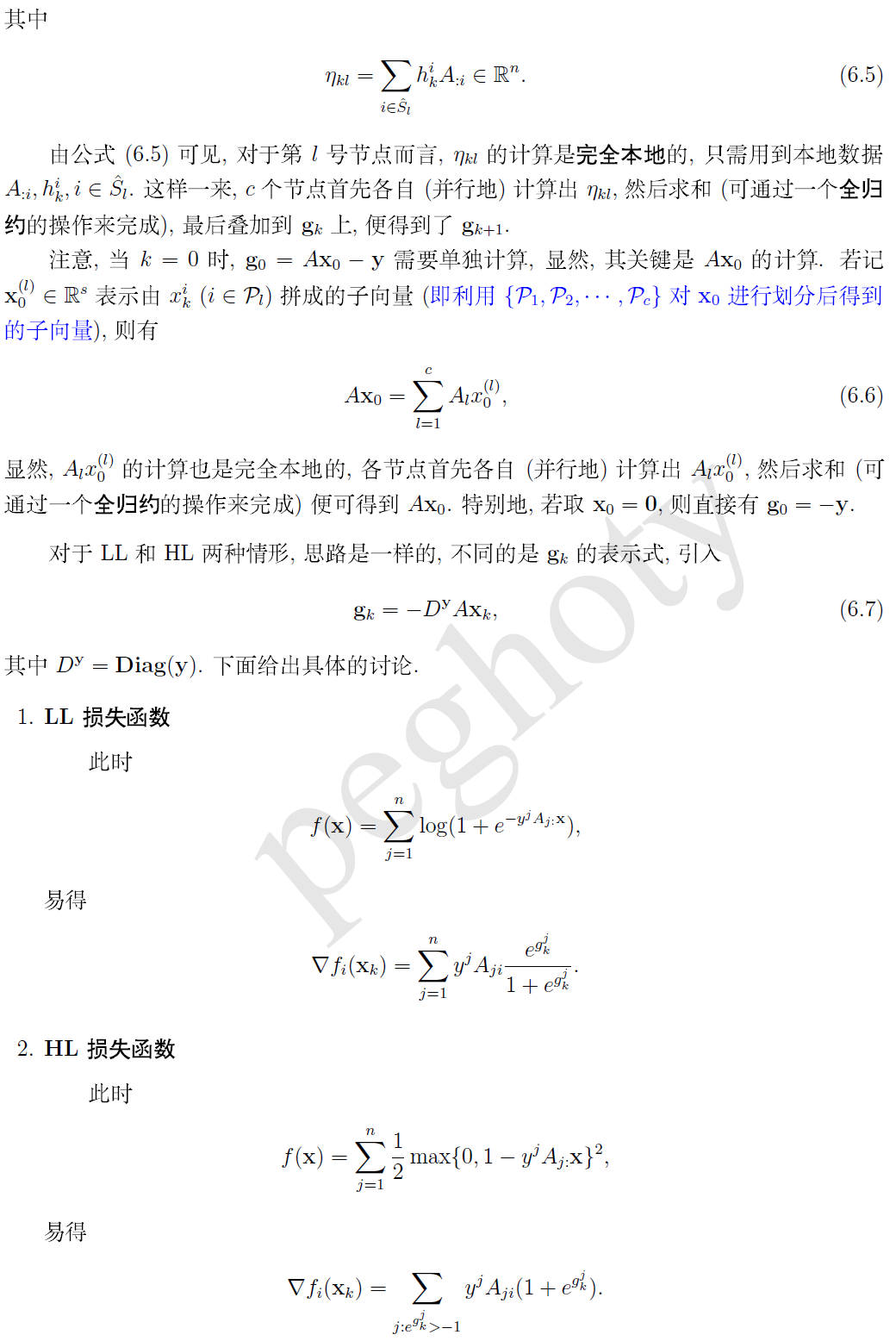

在机器学习中,模型的训练是一个非常重要的过程,它一般是对一个目标函数进行优化。从而获取模型的參数。比較常见的优化算法包含梯度下降法、牛顿法与拟牛顿法等。但在大数据的背景下。尤其对于并行实现来说。优化算法一般是越简单越好,如坐标下降法(CD)和随机梯度下降法(SCG)就比較受欢迎。

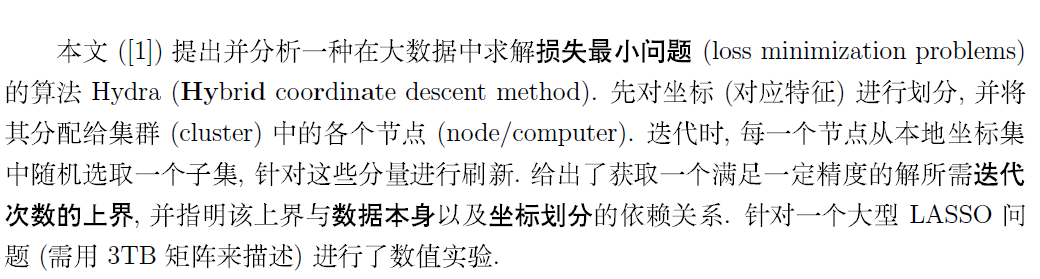

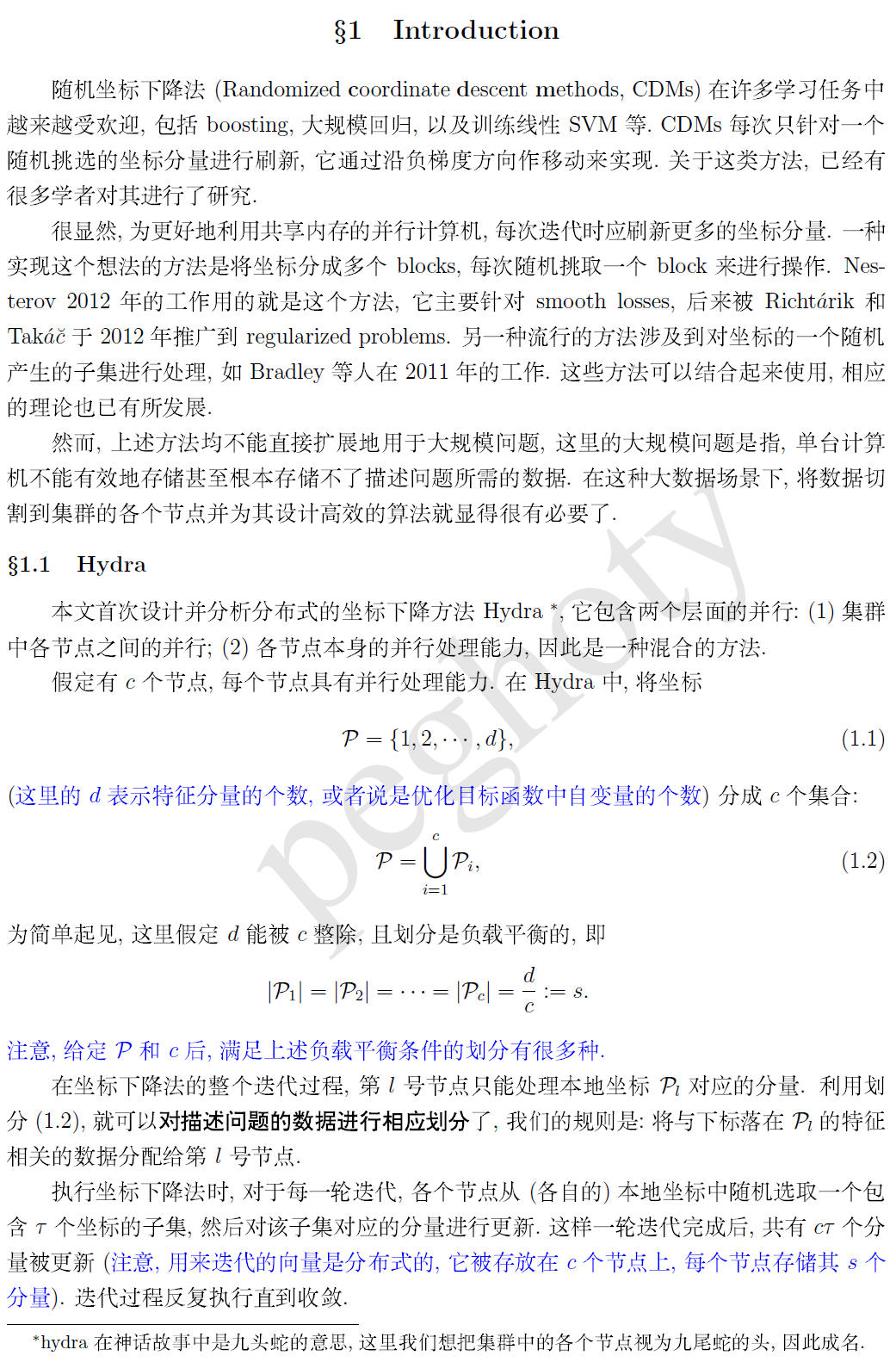

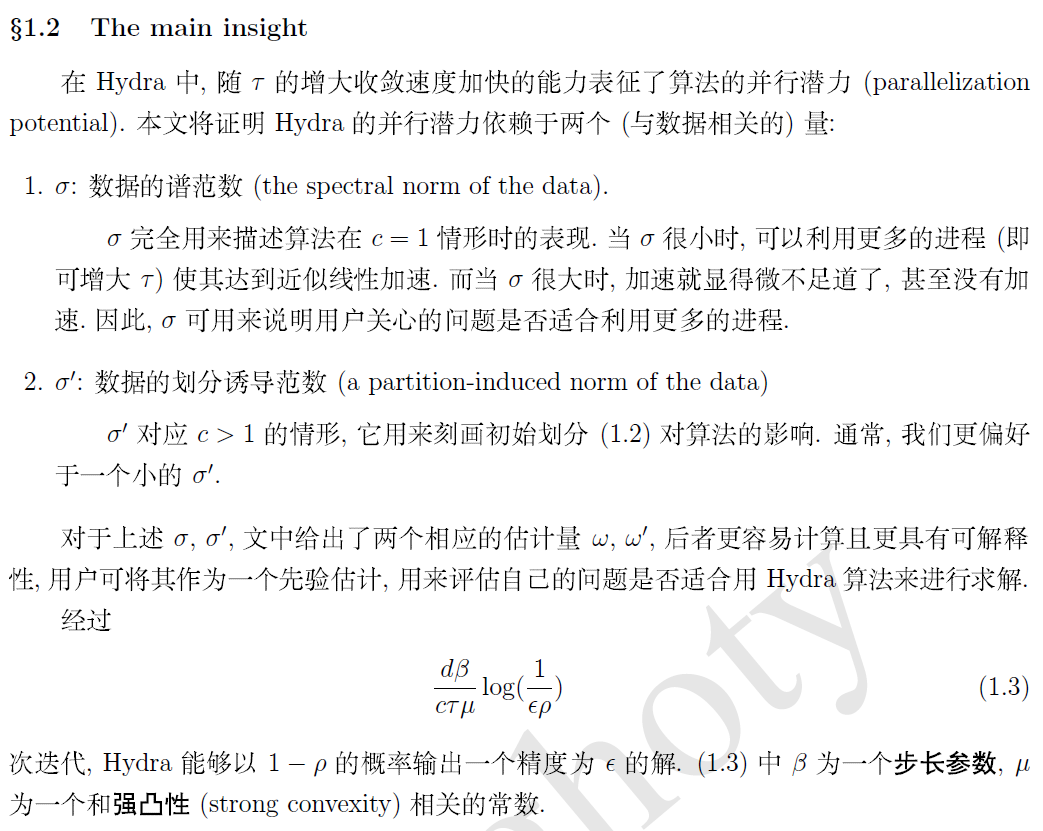

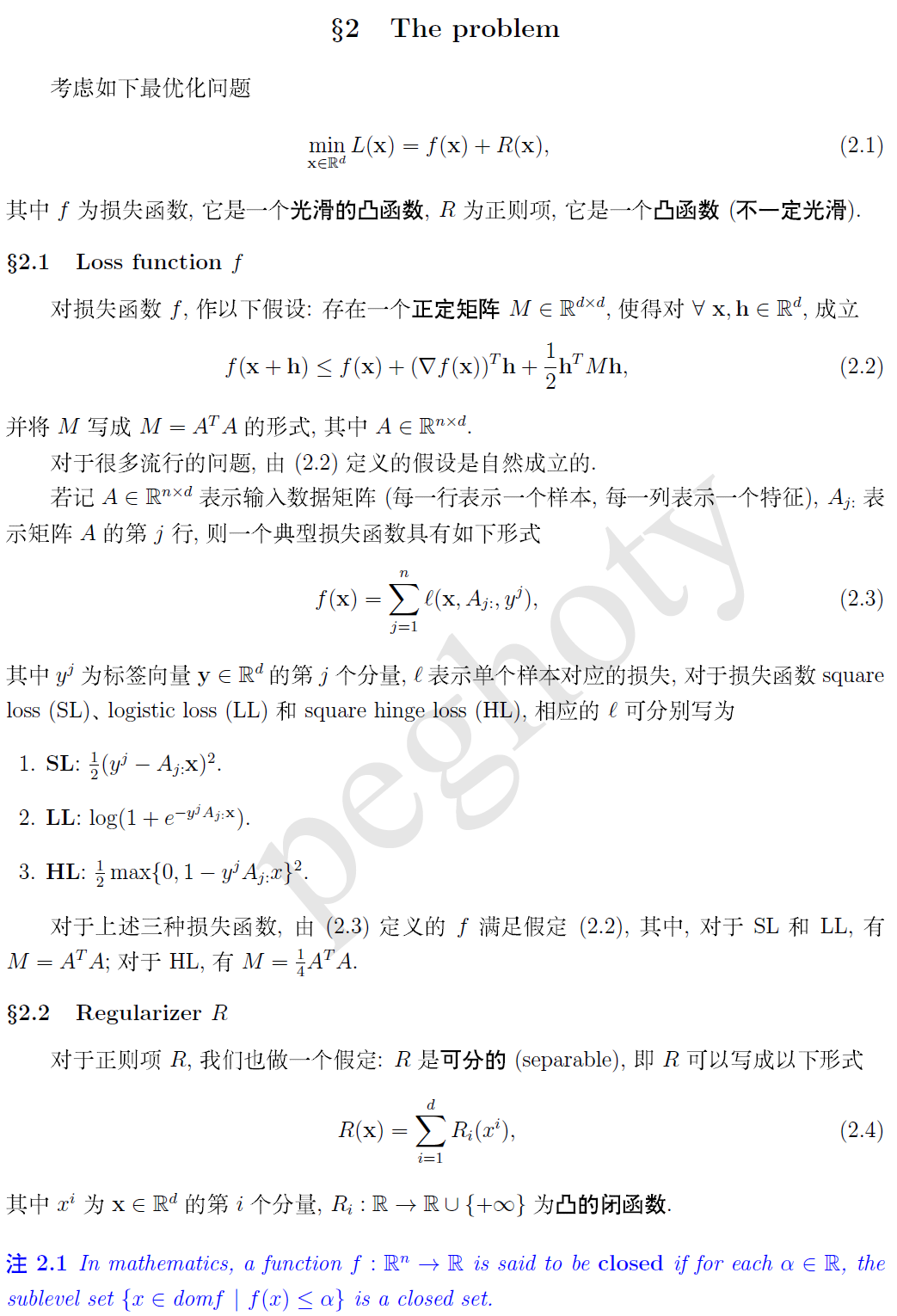

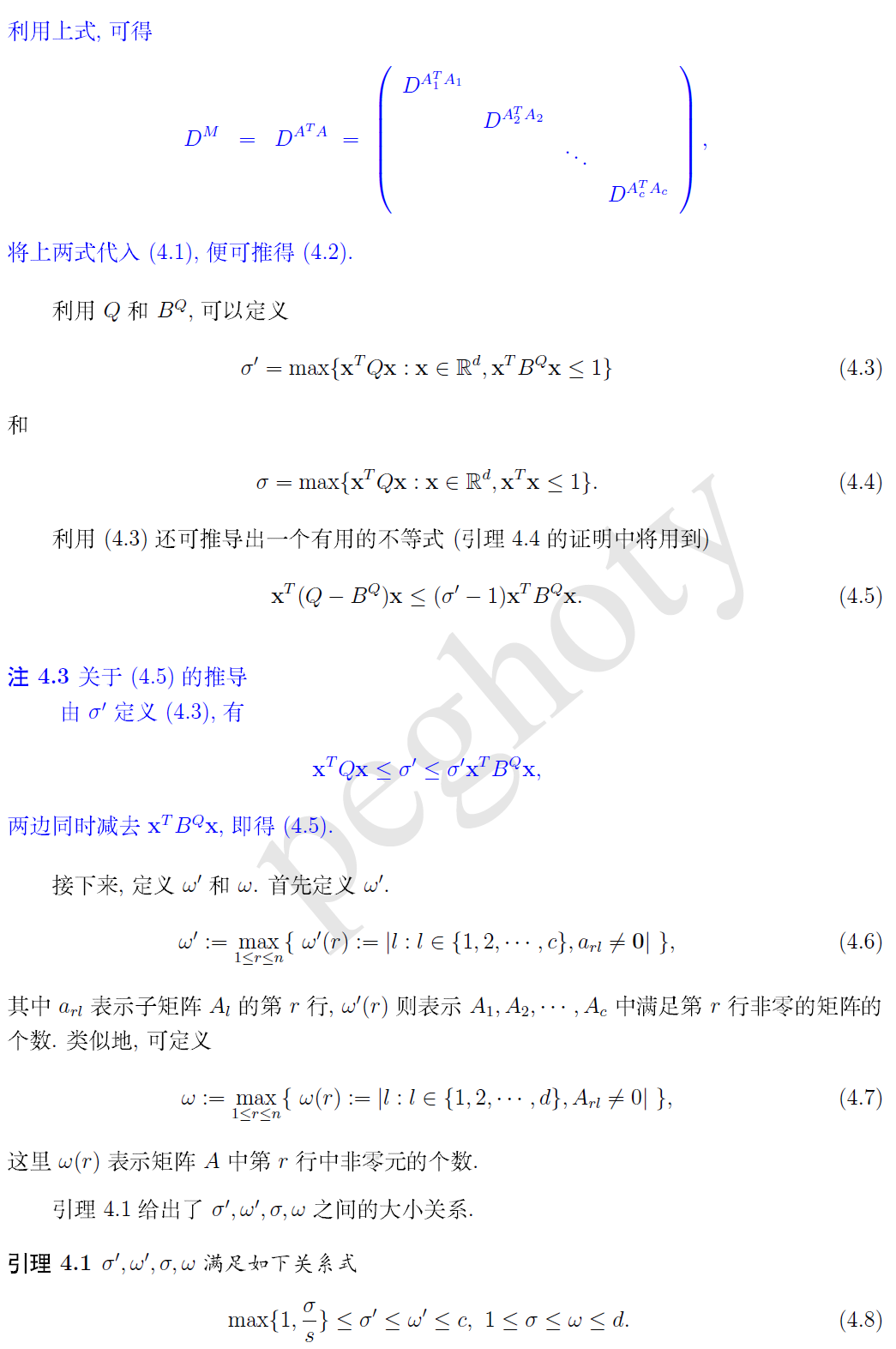

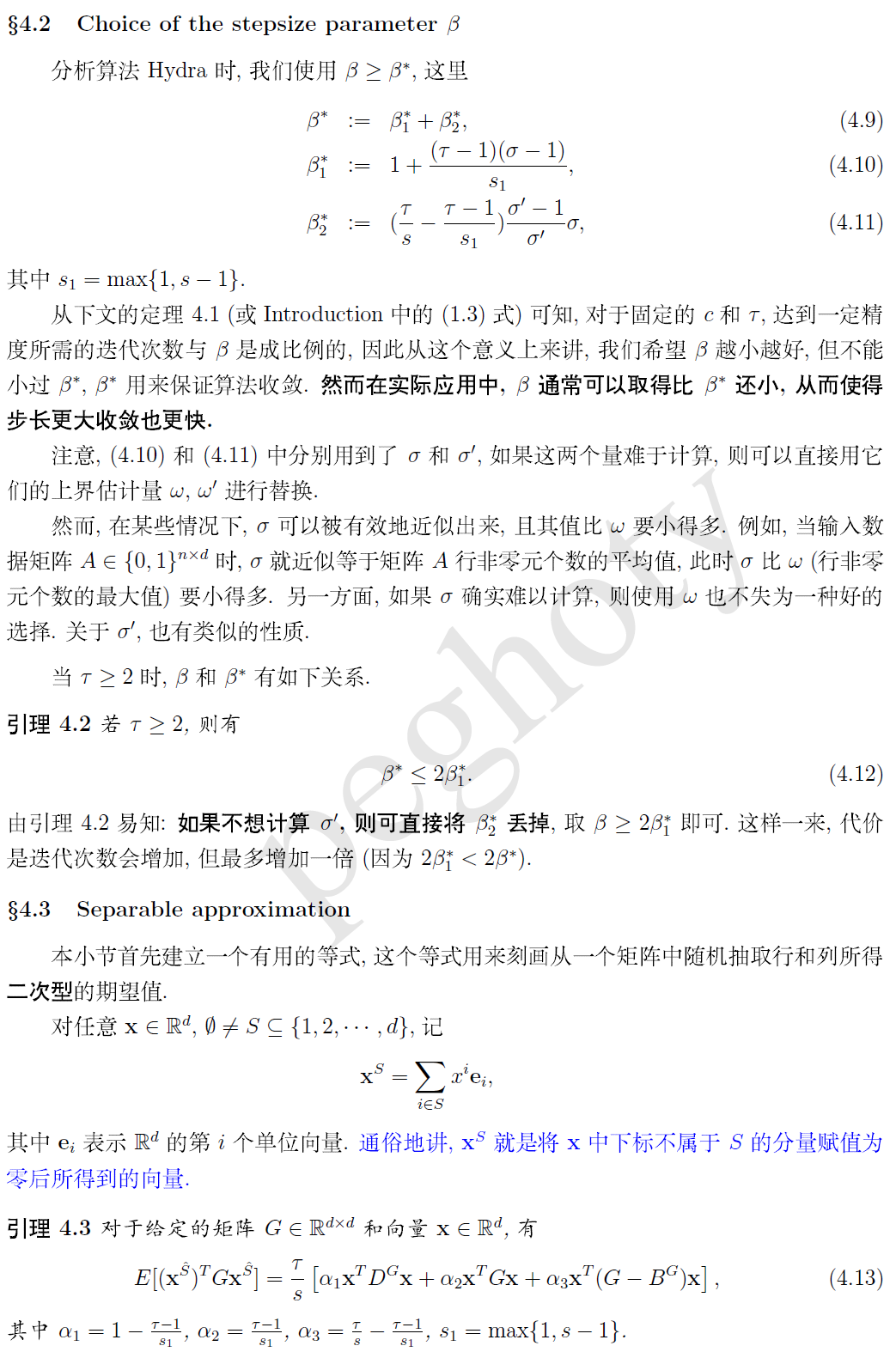

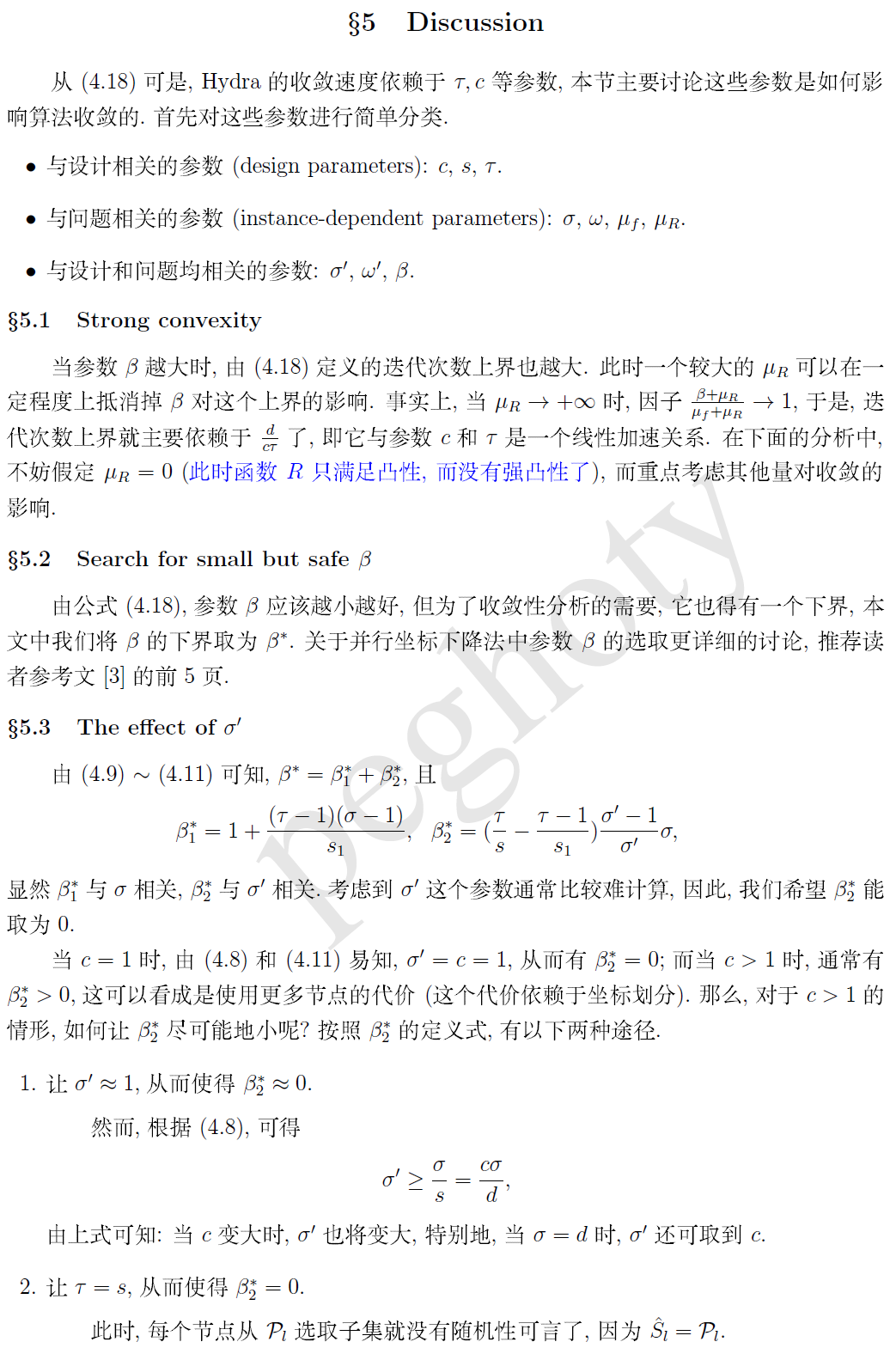

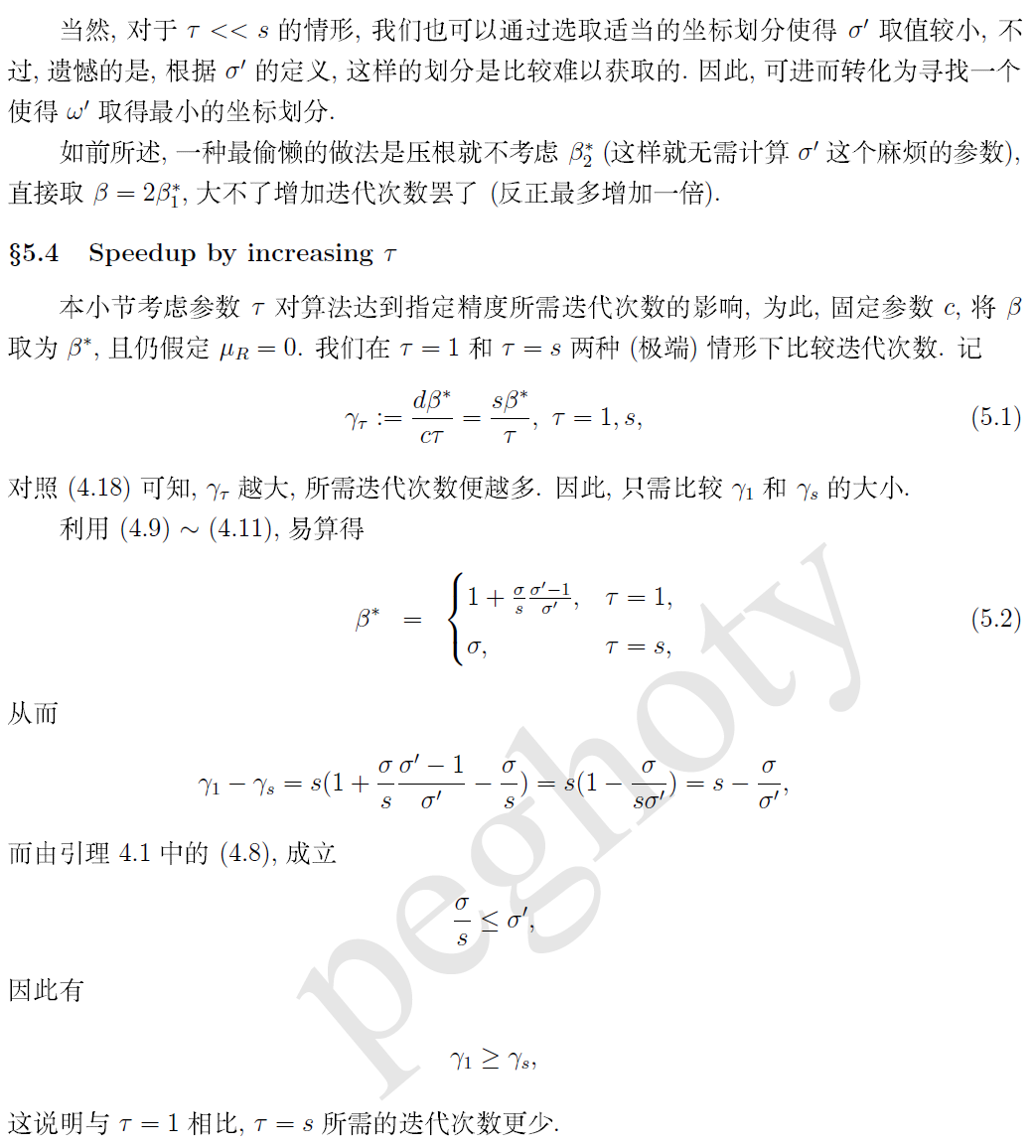

本文是阅读完论文 Distributed Coordinate Descent Method for Learning with Big Data 后的一则笔记。主要介绍算法 Hydra (一种分布式坐标下降法)的算法框架、收敛性理论、參数选取和并行实现细节。

作者: peghoty

出处: http://blog.csdn.net/itplus/article/details/28329603

欢迎转载/分享, 但请务必声明文章出处.