一、需求

最近准备爬取某电商网站的数据,先不考虑代理、分布式,先说效率问题(当然你要是请求的太快就会被封掉,亲测,400个请求过去,服务器直接拒绝连接,心碎),步入正题。一般情况下小白的我们第一个想到的是for循环,这个可是单线程啊。那我们考虑for循环直接开他个5个线程,问题来了,如果有一个url请求还没有回来,后面的就干等,这么用多线程等于没用,到处贴创可贴。

二、性能考虑

确定要用多线程或者多进程了,那我们到底是用多线程还是多进程,有些人对多进程和多线程有一定的偏见,就因为python的GIL锁,下面我们说一下这两个东西的差别。

三、多线程:

一般情况下我们启动一个.py文件,就等于启动了一个进程,一个进程里面默认有一个线程工作,我们使用的多线程的意思就是在一个进程里面启用多个线程。但问题来了,为什么要使用多线程呢?我知道启动一个进程的时候需要创建一些内存空间,就相当于一间房子,我们要在这个房子里面干活,你可以想一个人就等于一个线程,你房子里面有10个人的空间跟有20个人的空间,正常情况下是不一样的,因为我们知道线程和线程之间默认是可以通信的(进程之间默认是不可以通信的,不过可以用技术实现,比如说管道)。可以多线程为了保证计算数据的正确性,所以出现了GIL锁,保证同一时间只能有一个线程在计算。GIL锁你可以基本理解为,比如在这个房间里要算一笔账,在同一时间内只能有一个人在算这笔账,想一个问题,如果这笔账5个人就能算清楚,我需要10平米的房间就行,那为什么要请10个人,花20平米呢?所以并不是开的线程越多越好。但是,但是,但是,注意大家不用动脑筋(CPU计算)算这笔账的时候可以去干别的事(比如说5个人分工,各算一部分),比如说各自把自己算完后的结果记录在账本上以便后面对账,这个的话每个人都有自己的账本,所以多线程适合IO操作,记住了就算是适合IO操作,也不代表说人越多越好,所以这个量还是得根据实际情况而定。

示例:

1 import requests 2 from concurrent.futures import ThreadPoolExecutor 3 4 urls_list = [ 5 'https://www.baidu.com', 6 'http://www.gaosiedu.com', 7 'https://www.jd.com', 8 'https://www.taobao.com', 9 'https://news.baidu.com', 10 ] 11 pool = ThreadPoolExecutor(3) 12 13 def request(url): 14 response = requests.get(url) 15 return response 16 17 def read_data(future,*args,**kwargs): 18 response = future.result() 19 response.encoding = 'utf-8' 20 print(response.status_code,response.url) 21 22 def main(): 23 for url in urls_list: 24 done = pool.submit(request,url) 25 done.add_done_callback(read_data) 26 27 if __name__ == '__main__': 28 main() 29 pool.shutdown(wait=True)

四、多进程:

上面我们介绍了多线程(线程池),现在我们聊聊进程池,我们知道一个进程占用一个CPU,现在的配置CPU一般都是4核,我们启动两个进程就是分别在两个CPU里面(两个内核)各运行一个进程,我知道进程里面才有线程,默认是一个。但是有个缺点,按照上面的说法,开两个进程占用的内存空间是开一个进程占用内存空间的2倍。CPU就占用了2个核,电脑还得干别的事儿对吧,不能冒冒失失瞎用。开的太多是不是其他程序就得等着,我们思考一下,占用这么多的内存空间,利用了多个CPU的优点为了什么?CPU是用来做什么的?没错就是用来计算的,所以在CPU密集运算的情况下建议用多进程。注意,具体要开几个进程,根据机器的实际配置和实际生产情况而定。

1 import requests 2 from concurrent.futures import ProcessPoolExecutor 3 4 urls_list = [ 5 'https://www.baidu.com', 6 'http://www.gaosiedu.com', 7 'https://www.jd.com', 8 'https://www.taobao.com', 9 'https://news.baidu.com', 10 ] 11 pool = ProcessPoolExecutor(3) 12 13 def request(url): 14 response = requests.get(url) 15 return response 16 17 def read_data(future,*args,**kwargs): 18 response = future.result() 19 response.encoding = 'utf-8' 20 print(response.status_code,response.url) 21 22 def main(): 23 for url in urls_list: 24 done = pool.submit(request,url) 25 done.add_done_callback(read_data) 26 27 if __name__ == '__main__': 28 main() 29 pool.shutdown(wait=True)

总结:

1、多线程适合IO密集型程序

2、多进程适合CPU密集运算型程序

五、协程:

协程:又称微线程纤程。英文名Coroutine。那协程到底是个什么东西,通俗的讲就是比线程还要小的线程,所以才叫微线程。

主要作用:有人要问了,在python中线程是原子操作(意思就是说一句话或者一个动作就能搞定的操作或者计算),怎么还有个叫协程的呢?

优点:

1、使用高并发、高扩展、低性能的;一个CPU支持上万的协程都不是问题。所以很适合用于高并发处理。

2、无需线程的上下文切换开销(乍一看,什么意思呢?我们都知道python实际上是就是单线程,那都是怎么实现高并发操作呢,就是CPU高速的切换,每个任务都干一点,最后看上去是一起完事儿的,肉眼感觉就是多线程、多进程)

缺点:

1、无法利用CPU的多核优点,这个好理解,进程里面包含线程,而协程就是细分后的线程,也就是说一个进程里面首先是线程其后才是协程,那肯定是用不了多核了,不过可以多进程配合,使用CPU的密集运算,平时我们用不到。

1、一般情况下用的比较多的是asyncio或者是gevent这两个技术实现协程,asyncio是python自带的技术,gevent第三方库,个人比较喜欢gevent这个技术。

gevent:

安装:gevent需要安装greenlet,因为它是使用到了greenlet这个库。

pip3 install greenlet pip3 install gevent

1、gevent的基本实现,按照下面的写法,程序启动后将会开启许许多多的协程,反而特别影响性能。

1 import requests 2 import gevent 3 from gevent import monkey 4 5 #把当前的IO操作,打上标记,以便于gevent能检测出来实现异步(否则还是串行) 6 monkey.patch_all() 7 8 9 def task(url): 10 ''' 11 1、request发起请求 12 :param url: 13 :return: 14 ''' 15 response = requests.get(url) 16 print(response.status_code) 17 18 gevent.joinall([ 19 gevent.spawn(task,url='https://www.baidu.com'), 20 gevent.spawn(task,url='http://www.sina.com.cn'), 21 gevent.spawn(task,url='https://news.baidu.com'), 22 ])

2、有一个改进版本,就是可以设置到底让它一次发起多少个请求(被忘了,协程=高并发现实之一)。其实里面就是利用gevnet下的pool模块里面的Pool控制每次请求的数量。

1 import requests 2 import gevent 3 from gevent import monkey 4 from gevent.pool import Pool 5 6 #把当前的IO操作,打上标记,以便于gevent能检测出来实现异步(否则还是串行) 7 monkey.patch_all() 8 9 10 def task(url): 11 ''' 12 1、request发起请求 13 :param url: 14 :return: 15 ''' 16 response = requests.get(url) 17 print(response.status_code) 18 19 20 #控制最多一次向远程提交多少个请求,None代表不限制 21 pool = Pool(5) 22 gevent.joinall([ 23 pool.spawn(task,url='https://www.baidu.com'), 24 pool.spawn(task,url='http://www.sina.com.cn'), 25 pool.spawn(task,url='https://news.baidu.com'), 26 ])

3、还有一版本,每次我们都要装greenlet和gevent这肯定是没法子,但是,我们上面写的这个改进版还是有点麻烦,所以就有人写了100多行代码把它们给搞到了一起,对就是搞到了一起,叫grequests,就是前者两个技术的结合。

pip3 install grequests

这个版本是不是特别变态,直接把requests、greenlet、gevent、Pool都省的导入了,但是装还是要装的,有人说从下面代码中我没看到Pool的参数啊,grequests.map(request_list,size=5),size就是你要同时开几个协程,还有参数你得点进去看,是不是很牛,很轻松

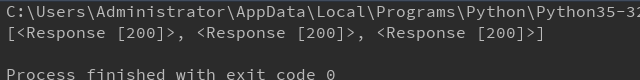

1 import grequests 2 3 request_list = [ 4 grequests.get('https://www.baidu.com'), 5 grequests.get('http://www.sina.com.cn'), 6 grequests.get('https://news.baidu.com'), 7 ] 8 # ##### 执行并获取响应列表 ##### 9 response_list = grequests.map(request_list,size=5) 10 print(response_list)

结果返回一个列表,你可以再迭代一下就行了。