监督学习:

- 线性回归,逻辑回归,神经网络,支持向量机。

非监督学习:

- K-means,PCA,异常检测

应用:

- 推荐系统,大规模机器学习

机器学习系统优化:

- 偏差/方差,正则化,下一步要进行的工作:评估学习算法(精确率,召回率),学习曲线,错误分析,上限分析

1. 监督学习

1.1 线性回归

假设函数

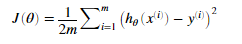

代价函数

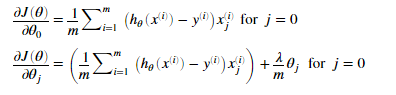

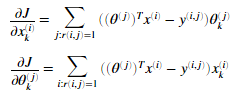

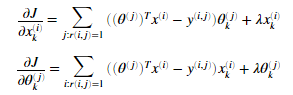

梯度

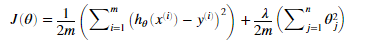

正则化线性回归代价函数

正则化线性回归梯度

特征缩放

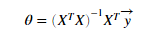

正规方程法

1.2 逻辑回归

假设函数

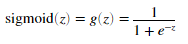

g为sigmod函数定义为

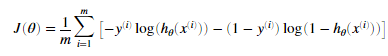

代价函数

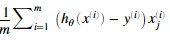

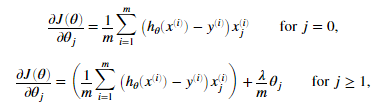

梯度

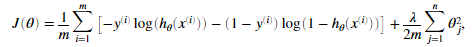

正则化的逻辑回归代价函数

正则化的逻辑回归梯度

1.3 神经网络

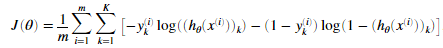

代价函数

正则化的代价函数

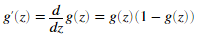

simoid函数与其偏导数

随机初始化

应对参数Theta进行随机初始化。不能全设为0.

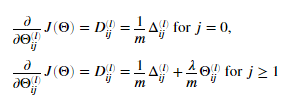

反向传播算法

通过后一层神经元的偏导数计算当前层神经元的偏导数。

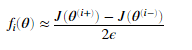

梯度检测

正则化神经网络

1.4 支持向量机

训练

MATLAB的svmTrain函数

参数C

与正则化的1/λ类似

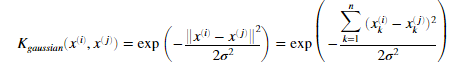

高斯核

将数据从低维空间映射到高维空间

2. 监督学习

2.1 K-means聚类

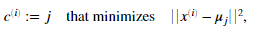

步骤

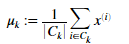

1. 把每个样本点指定给离它最近的聚类中心

2.使用分配给聚类中心的点计算这些点的平均值,并指定为新的聚类中心

随机初始化聚类中心

不同的聚类中心会生成不同的聚类效果,应多次随机初始化聚类中心,找到最合适的聚类。

优化目标

![]()

2.2 主成分分析

步骤

1.计算特征协方差矩阵

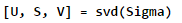

2.通过协方差矩阵进行奇异值分解

3.数据集映射到主成分

协方差矩阵

奇异值分解

2.3 异常检测

高斯分布

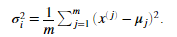

其中μ是均值 是方差。

是方差。

高斯分布参数

平均值

方差

阈值

用于预测样本是否异常

通过计算不同阈值的F1 score来选择。

多元高斯分布参数

平均值 μ

协方差矩阵 Σ

3. 应用

3.1 推荐系统

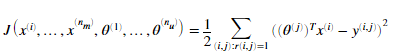

协同过滤算法代价函数

协同过滤算法梯度

正则化协同过滤算法代价函数

正则化协同过滤算法梯度

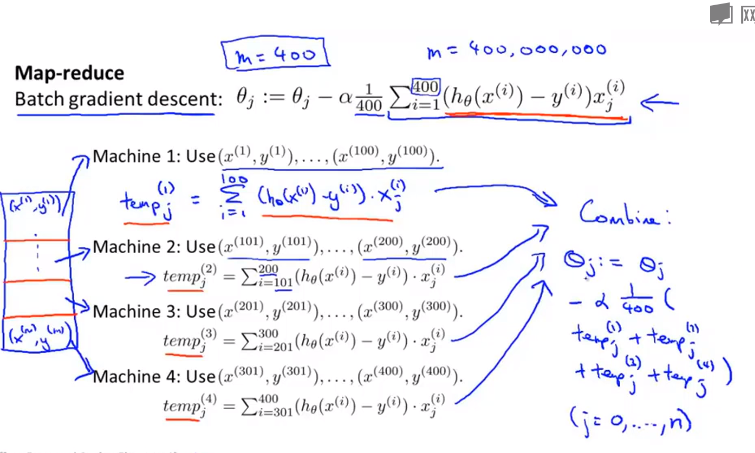

3.2 大规模机器学习

数据

高方差:正大数据量

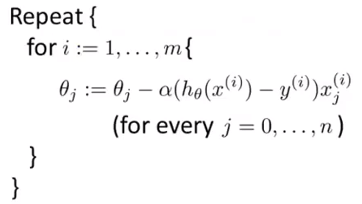

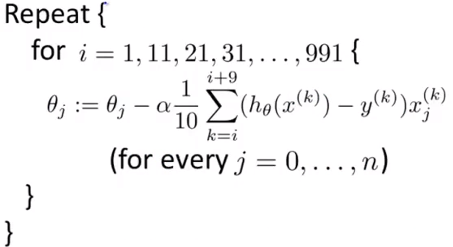

随机梯度下降

批量梯度下降

在线学习

减少映射

4. 机器学习系统优化

4.1 偏差和方差

训练误差

高偏差

欠拟合,增加特征,减少正则化lambda值

高方差

过拟合,减少特征,增大正则化lambda值

4.2 正则化

解决过拟合问题,为每个参数加上惩罚

选择lambda

使用交叉验证机选择lambda

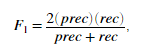

4.3 精确率,召回率

F1 score

精确率和召回率

精确率是针对我们预测结果而言的,它表示的是预测为正的样本中有多少是真正的正样本。那么预测为正就有两种可能了,一种就是把正类预测为正类(TP),另一种就是把负类预测为正类(FP)

召回率是针对我们原来的样本而言的,它表示的是样本中的正例有多少被预测正确了。那也有两种可能,一种是把原来的正类预测成正类(TP),另一种就是把原来的正类预测为负类

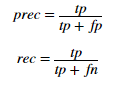

4.4 学习曲线

高方差

高偏差

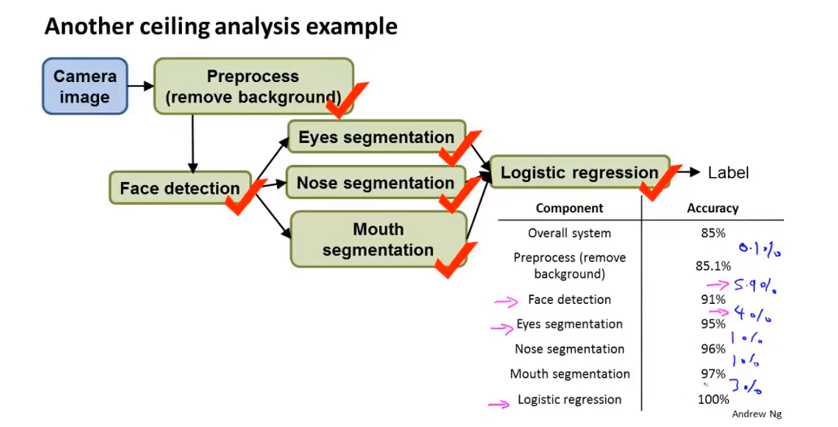

4.5 上限分析