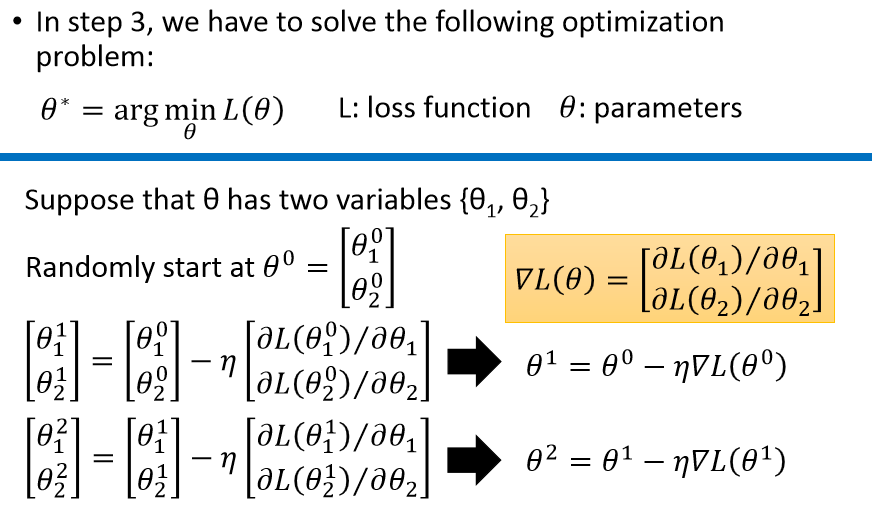

其中,learning rate:η

其中,learning rate:η  :梯度,它实际是个vector。Gradient可以考虑成Loss等高线的法线方向

:梯度,它实际是个vector。Gradient可以考虑成Loss等高线的法线方向

learning rate要小心调节

红线的learning rate就是刚刚好,蓝线太慢了,绿线黄线太快了。可以通过画右边图来观察。

红线的learning rate就是刚刚好,蓝线太慢了,绿线黄线太快了。可以通过画右边图来观察。

越学习越慢,不同的参数最好提供不同的learning rate。

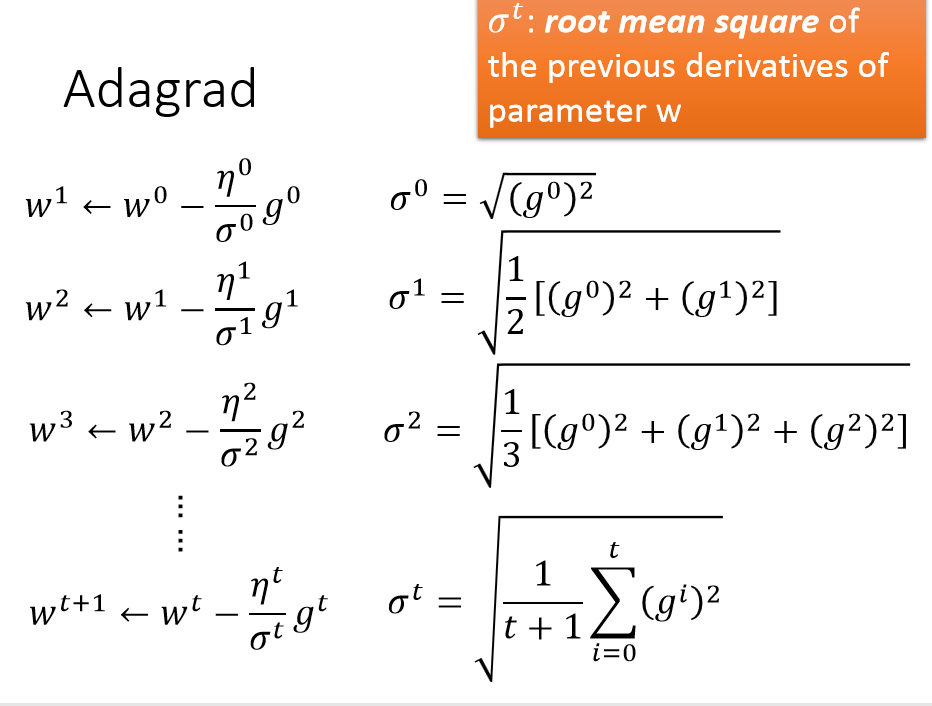

怎么选择learning rate呢?可以采用Adagrad

实际举例:

σt类似累计梯度的平方?

这里是只有一个参数的情况。

这里是只有一个参数的情况。

最好的方法是考虑二次微分,Adagrad就考虑了二次微分。

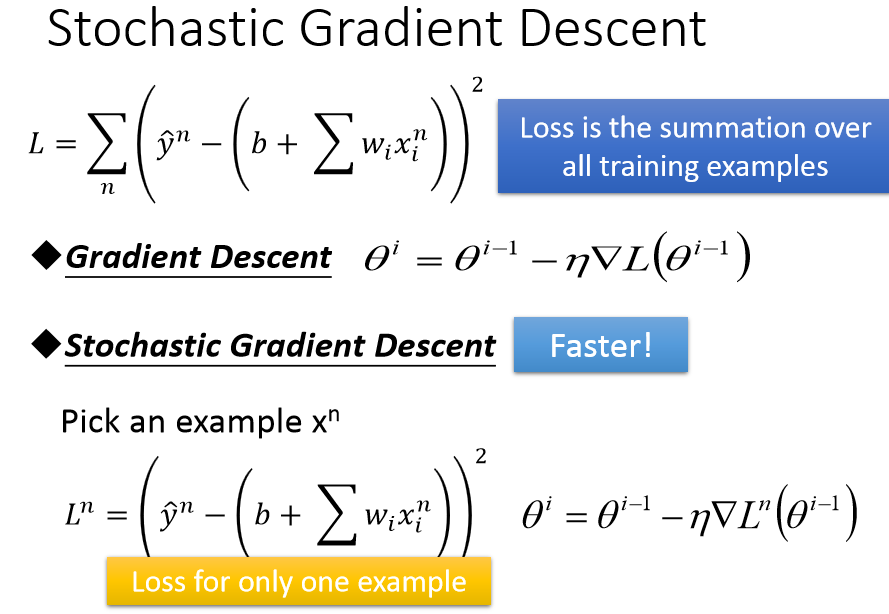

Stochastic Gradient Descent随机梯度下降

先只考虑一个xn ,只算它的Loss,Gradient

先只考虑一个xn ,只算它的Loss,Gradient

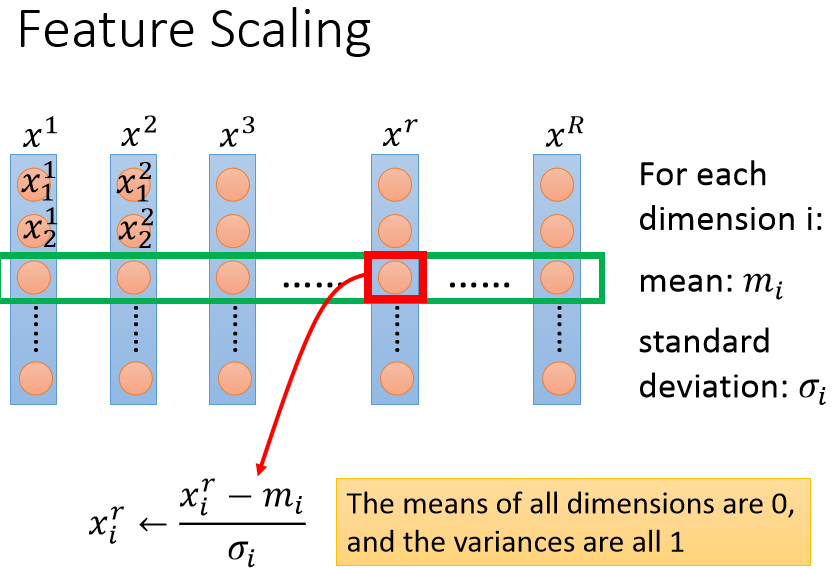

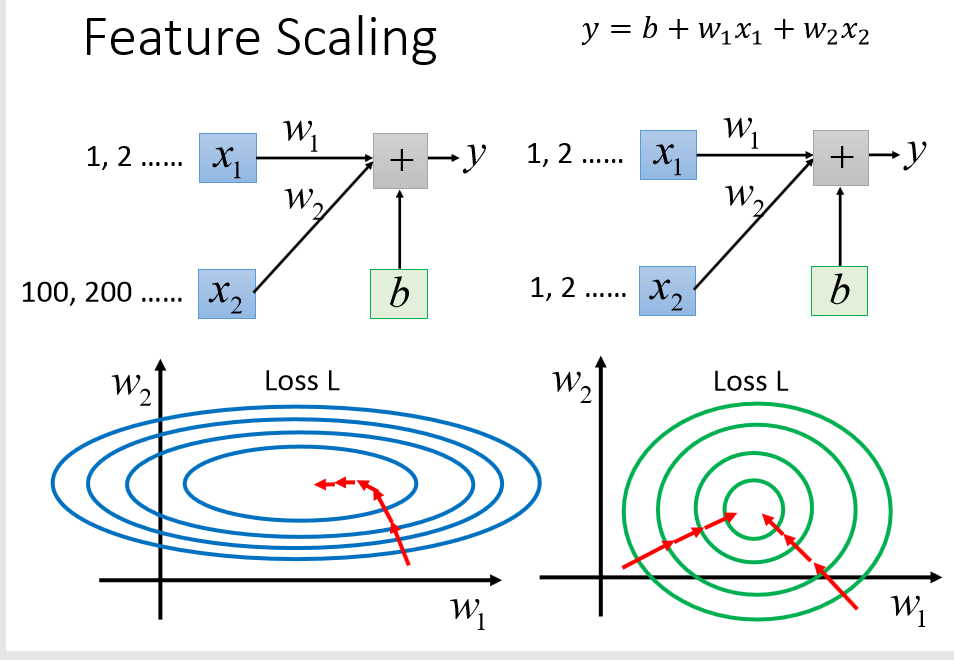

Feature Scaling特征缩放:

x1本身比较小而x2比较大时,x2原本就会对loss产生比较大的影响。

x1本身比较小而x2比较大时,x2原本就会对loss产生比较大的影响。

可以采用scaling方法: