Hbase安装

放入

master中

使用

连接虚拟机 master,slave1,slave2

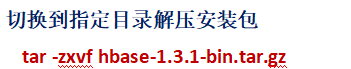

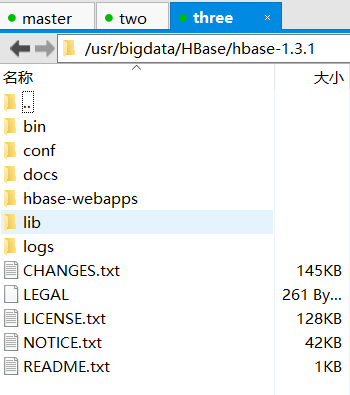

到指定的文件目录下解压夹包

解压完成.........

进入解压目录的conf文件夹,修改hbase-site.xml文件

<property>

<name>hbase.rootdir</name>

<value>hdfs://master:9000/hbase</value>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<property>

<name>hbase.master</name>

<value>master</value>

</property>

<property>

<name>hbase.zookeeper.quorum</name>

<value>master,slave1,slave2</value>

</property>

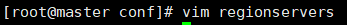

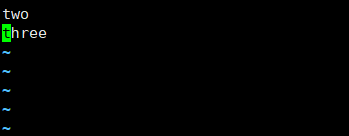

修改regionservers文件

子虚拟机名称:

如:

slave1

slave2

修改hbase-env.sh文件(根据自身环境路径配置)

export JAVA_HOME=/usr/bigdata/jdk/jdk1.8.0_121

export HADOOP_HOME=/usr/bigdata/jiqun/hadoop-2.8.0

export HBASE_HOME=/usr/bigdata/HBase/hbase-1.3.1

export HBASE_MANAGES_ZK=true

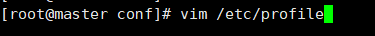

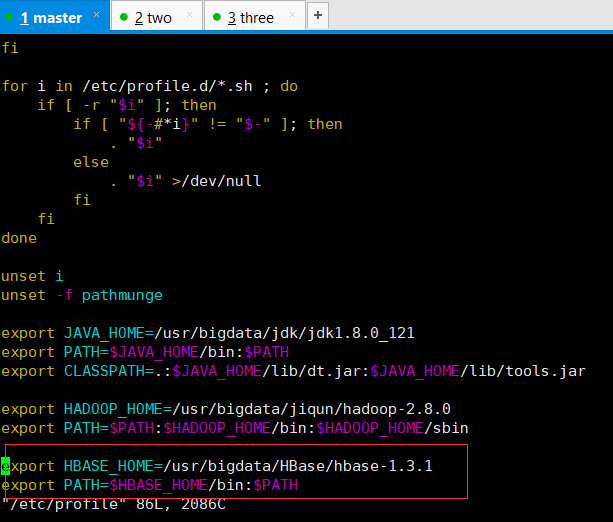

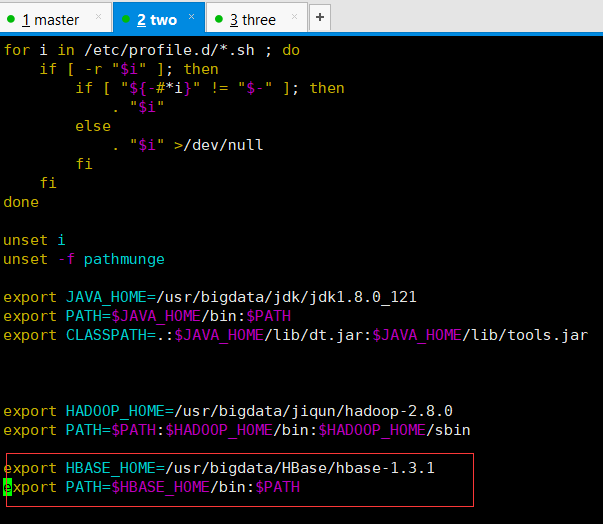

配置HBase的环境变量

export HBASE_HOME=/usr/bigdata/HBase/hbase-1.3.1

export PATH=$HBASE_HOME/bin:$PATH

将配置好的hbase复制到子机器当中

scp -r /usr/bigdata/HBase/hbase-1.3.1 root@slave2:/usr/bigdata/HBase/

master

slave1

slave2

配置子机器的HBase环境变量

3个都要配

每个陪完之后都需 source /etc/profile

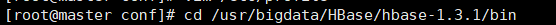

切换到master机器侠HBase安装目录下的bin文件夹启动HBase(保证Hadoop集群先启动)

这里集群启动中......跳过

开启中......

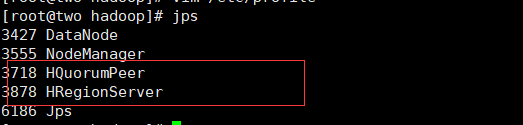

启动完成后......每个机子上-------------jps下

成功了........

在master主机上运行hbase shell

启动成功查看界面(ip地址:16010)

谷歌:master的ip地址 如:ip:16010

完。