大数据 hadoop 环境搭建:

-----------------------------------------------------------------

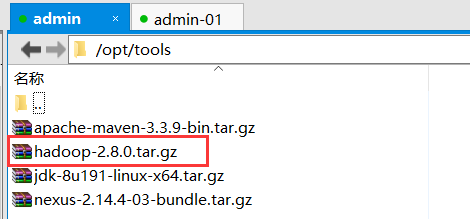

1):下载安装 hadoop(这里使用2.8版本:点我下载)

2):通过 (xftp 或 rz 命令)上传到指定目录下并解压到指定目录(根据自行要求进行选择存放位置):以下为小编存放目录

//解压到指定目录

tar -zxvf hadoop-2.8.0.tar.gz -C ../bigData/

3):配置 hadoop 环境变量

vim /etc/profile

export HADOOP_HOME=/opt/bigData/hadoop-2.8.0

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

之后让文件生效:

source /etc/profile

4):hadoop 集群搭建:

1):进入 hadoop 的配置文件位置:

cd /opt/bigData/hadoop-2.8.0/etc/hadoop/

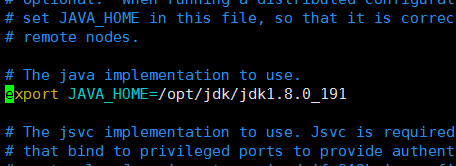

2):配置hadoop-env.sh文件

vim hadoop-env.sh

//在文件中加入[首先查看是否存在此节点,如果有可以直接修改](指定jdk绝对路径)

export JAVA_HOME=/opt/jdk/jdk1.8.0_191

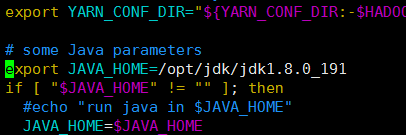

3):配置yarn-env.sh文件

vim yarn-env.sh

//在文件中加入[首先查看是否存在此节点,如果有可以直接修改](指定jdk绝对路径)

export JAVA_HOME=/opt/jdk/jdk1.8.0_191

4):配置slaves文件,增加slave主机名或者IP地址:

vim slaves

//在文件中加入(删除原有的localhost)

192.168.31.207

192.168.31.208

5):配置core-site.xml文件:

vim core-site.xml

//在文件中的configuration节点里加入

<property>

<name>fs.defaultFS</name>

<value>hdfs://admin:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/bigData/hadoop-2.8.0/tmp</value>

</property>

6):配置hdfs-site.xml文件

vim hdfs-site.xml

//在文件中的configuration节点里加入

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>admin:50090</value>

</property>

<property>

<name>dfs.replication</name>

<value>2</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/opt/bigData/hadoop-2.8.0/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/opt/bigData/hadoop-2.8.0/hdfs/data</value>

</property>

7):配置yarn-site.xml文件

vim yarn-site.xml

//在文件中的configuration节点里加入

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.address</name>

<value>admin:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>admin:8030</value>

</property>

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>admin:8031</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>admin:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>admin:8088</value>

</property>

8):配置mapred-site.xml文件

mapred-site.xml.template 是存在的。

mapred-site.xml 不存在。

注意:先要copy一份。

cp mapred-site.xml.template mapred-site.xml

然后编辑:

vim mapred-site.xml

//新增以下内容

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>admin:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>admin:19888</value>

</property>

9):把配置好的hadoop文件复制到其他的子机器中

scp -r /opt/bigData/hadoop-2.8.0 root@admin-01:/opt/bigData/hadoop-2.8.0

scp -r /opt/bigData/hadoop-2.8.0 root@admin-02:/opt/bigData/hadoop-2.8.0

10):把配置好的/etc/profile复制到其他两个子机器中

scp /etc/profile root@admin-01:/etc/profile

scp /etc/profile root@admin-02:/etc/profile

之后在每个子机器中使用 source /etc/profile 使文件生效

11):在master 主机器中运行

hdfs namenode -format

//注意:格式化NameNode,会产生新的集群id,导致NameNode和DataNode的集群id不一致,集群找不到已往数据。

//所以,格式NameNode时,一定要先删除生成的 name 和 data数据 和log日志,然后再格式化NameNode。

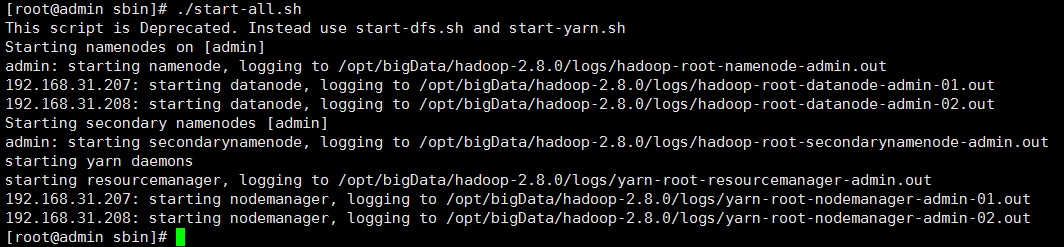

12):在master 主机器中启动hadoop环境:进入/opt/bigData/hadoop-2.8.0/sbin

./start-all.sh 启动hadoop集群

./stop-all.sh 关闭hadoop集群

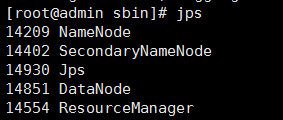

jps 查看当前已启动的服务