周二的主题提取使用LDA模型进行了简单的测试,效果还可以。主要是提取的分词的结果,LDA:随机生成文章各个主题比例,再根据各个主题随机生成词,词与词之间的顺序关系被彻底忽略了,这就是LDA眼中世间所有文章的生成过程!

参考博客:https://blog.csdn.net/aws3217150/article/details/53840029

这篇博客介绍的很详细了。

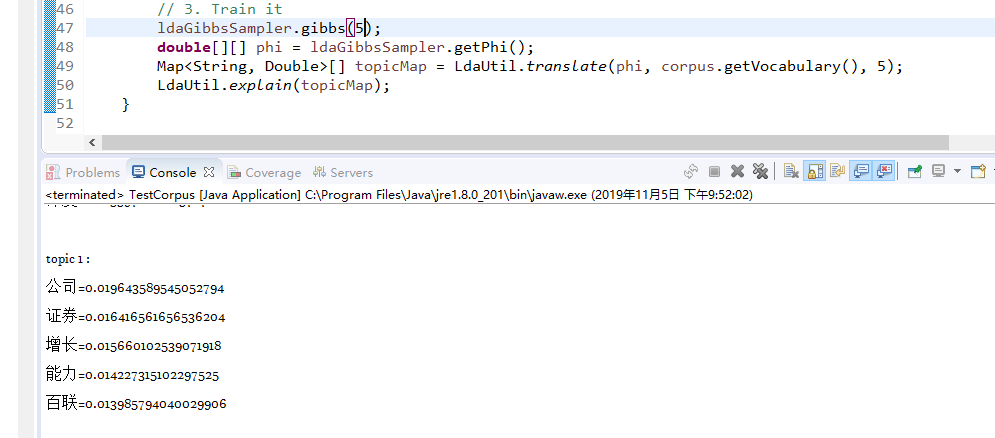

对于一篇新闻先进行标准一点的分词,然后进行训练,这里我生成了5*5的主题分布,最后每个词都会有一个概率,每个主题展示出现概率最高5个词。

今天只是试验了一下这个模型的使用进行了提取。github上有很多LDA的使用源码,感兴趣的可以去康康。

明天计划:考虑全网关联以及主题追踪

我的思路是:爬取清洗入库-》关键字、摘要、分类、情感等基础信息-》主题提取(细化关键字)-》多线程触发爬虫-》全网信息关联(关联这里目前考虑的是不同网站的类似新闻去重以及内容合并,打算明天问一下老师这里的具体内容)-》主题追踪(目前考虑的是上面提取的主题词和其他新闻的主题词循环相似度判比,判比算法这里考虑simhash+汉明距离,因为时间上要快,对比相对来说比较准确)

上面这个思路可能问题很多,希望看到这篇博客的大牛指导一下。(网络舆情监控系统)