工具环境

语言:python3.6

数据库:MongoDB (安装及运行命令如下)

1 python3 -m pip install pymongo 2 brew install mongodb 3 mongod --config /usr/local/etc/mongod.conf

框架:scrapy1.5.1 (安装命令如下)

1 python3 -m pip install Scrapy

用 scrapy 框架创建一个爬虫项目

在终端执行如下命令,创建一个名为 myspider 的爬虫项目

1 scrapy startproject myspider

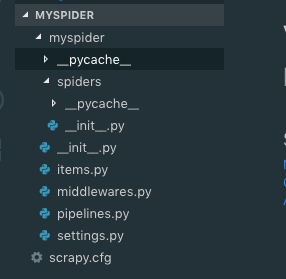

即可得到一个如下结构的文件目录

创建 crawl 样式的爬虫

针对不同的用途, scrapy 提供了不同种类的爬虫类型,分别是

Spider:所有爬虫的祖宗

CrawlSpider:比较常用的爬取整站数据的爬虫(下面的例子就是用这种)

XMLFeedSpider

CSVFeedSpider

SitemapSpider

先在命令行进入到 spiders 目录下

1 cd myspider/myspider/spiders

然后创建 crawl 类型的爬虫模板

1 scrapy genspider -t crawl zgmlxc www.zgmlxc.com.cn

参数说明:

-t crawl指明爬虫的类型

zgmlxc是我给这个爬虫取的名字

www.zgmlxc.com.cn是我要爬取的站点

完善小爬虫 zgmlxc

打开 zgmlxc.py 文件,可以看到一个基本的爬虫模板,现在就开始对其进行一系列的配置工作,让这个小爬虫根据我的指令去爬取信息。

配置跟踪页面规则

1 rules = ( 2 // 定位到 www.zgmlxc.com.cn/node/72.jspx 这个页面 3 Rule(LinkExtractor(allow=r'.72.jspx')), 4 // 在上面规定的页面中,寻找符合下面规则的 url, 爬取里面的内容,并把获取的信息返回给 parse_item()函数 5 Rule(LinkExtractor(allow=r'./info/d+.jspx'), callback='parse_item'), 6 )

这里有个小坑,就是最后一个 Rule 后面必须有逗号,否则报错

rules = ( Rule(LinkExtractor(allow=r'./info/d+.jspx'), callback='parse_item', follow=True), )

在 items.py 内定义我们需要提取的字段

1 import scrapy 2 3 class CrawlspiderItem(scrapy.Item): 4 # define the fields for your item here like: 5 # name = scrapy.Field() 6 title = scrapy.Field() 7 content = scrapy.Field() 8 piclist = scrapy.Field() 9 shortname = scrapy.Field()

完善 parse_item 函数

这里就是把上一步返回的内容,配置规则,提取我们想要的信息。这里必须用 join 方法,是为了方便后面顺利导入数据库。

1 def parse_item(self, response): 2 yield { 3 'title' : ' '.join(response.xpath("//div[@class='head']/h3/text()").get()).strip(), 4 'shortname' : ' '.join(response.xpath("//div[@class='body']/p/strong/text()").get()).strip(), 5 'piclist' : ' '.join(response.xpath("//div[@class='body']/p/img/@src").getall()).strip(), 6 'content' : ' '.join(response.css("div.body").extract()).strip(), 7 }

PS: 下面是提取内容的常用规则,直接总结在这里了:

1). 获取 img 标签中的 src:

//img[@class='photo-large']/@src2). 获取文章主题内容及排版:

response.css("div.body").extract()

将信息存入 MogoDB 数据库

设置数据库信息

打开 settings.py 添加如下信息:

1 # 建立爬虫与数据库之间的连接关系 2 ITEM_PIPELINES = { 3 'crawlspider.pipelines.MongoDBPipeline': 300, 4 } 5 6 # 设置数据库信息 7 MONGODB_SERVER = "localhost" 8 MONGODB_PORT = 27017 9 MONGODB_DB = 'spider_world' 10 MONGODB_COLLECTION = 'zgmlxc' 11 12 # 设置文明爬虫, 意思是每个请求之间间歇 5 秒, 对站点友好, 也防止被黑名单 13 ```py 14 DOWNLOAD_DELAY = 5

在 piplines.py 中

1 import pymongo 2 3 from scrapy.conf import settings 4 from scrapy.exceptions import DropItem 5 from scrapy import log 6 7 class MongoDBPipeline(object): 8 def __init__(self): 9 connection = pymongo.MongoClient( 10 settings['MONGODB_SERVER'], 11 settings['MONGODB_PORT'] 12 ) 13 db = connection[settings['MONGODB_DB']] 14 self.collection = db[settings['MONGODB_COLLECTION']] 15 16 def process_item(self, item, spider): 17 valid = True 18 for data in item: 19 if not data: 20 valid = False 21 raise DropItem("Missing {0}!".format(data)) 22 if valid: 23 self.collection.insert(dict(item)) 24 log.msg("Question added to MongoDB database!", 25 level=log.DEBUG, spider=spider) 26 return item

在终端运行这个小爬虫

1 scrapy crawl myspider

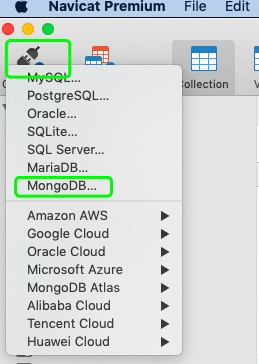

在 navicat 中查看信息入库情况

如下图新建一个 MogoDB 的数据库连接,填入上面配置的信息,如果一切顺利, 就可以看到我们想要的信息都已经入库了。

以上就完成了自定义爬虫到数据入库的全过程

更多技术素材视频可加交流群下载:1029344413