2017-08-18

备注:1-5节课看的是2016年冬季的课程,6开始看的是2017春季的课程。因为按照2016的内容安排,第六节课在2017就是第七节课了。所以这里是从第七节课开始。

上次内容: 神经网络训练的第一部分内容,主要是激活函数的优缺点介绍,数据的预处理,包括PCA数据降维,数据的规范化;以及权重的初始化等等。

这次的主要内容是训练的第二个部分。

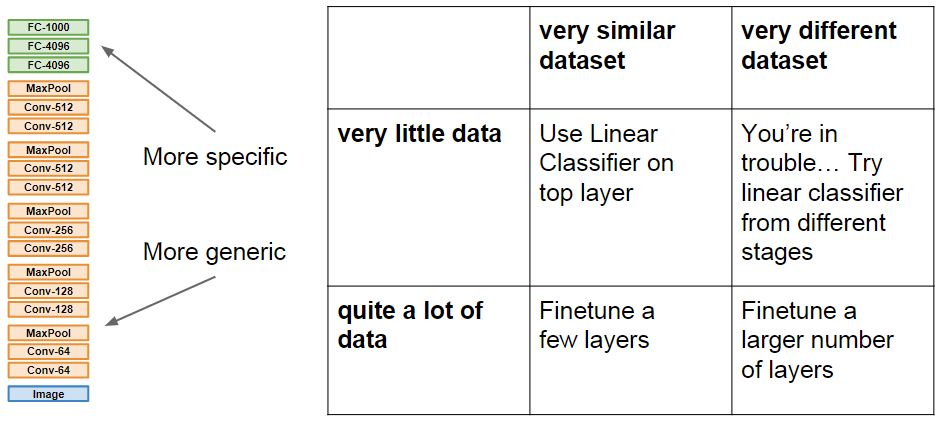

在有了初始化的模型之后,我们要做的就是参数的更新方法,也就是最优化算法,然后是数据正则化的集中策略,最后介绍了在数据量很小的时候,利用迁移学习来利用训练好的模型为己用。

一、优化算法

SGD:

主要的缺点一个是零梯度的问题,另一个是不同维度上的参数之间差别太大,更新的时候导致容易跑偏;

SGD + momentum

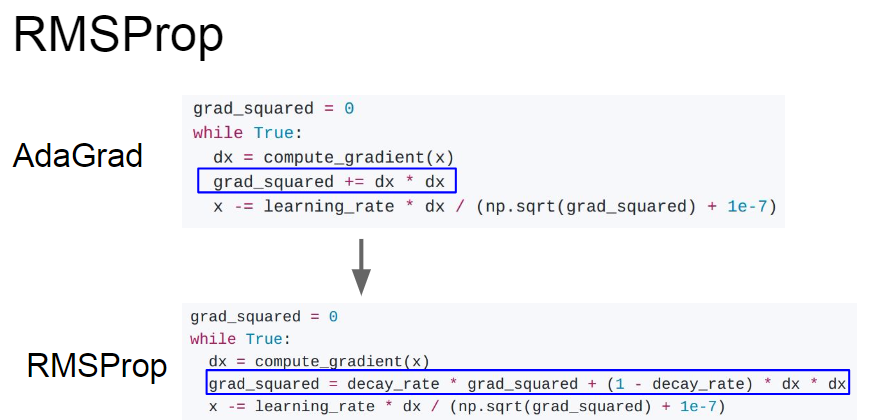

AdaGrad and RMSProp:

最后是效果最好的Adam方法:

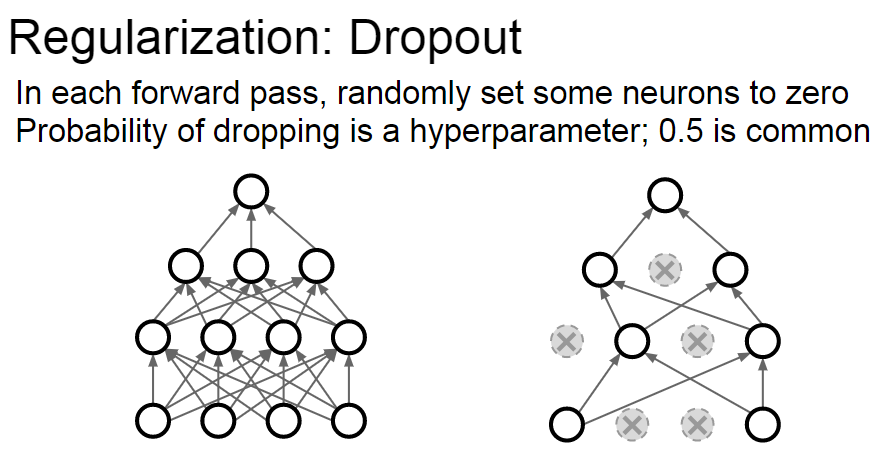

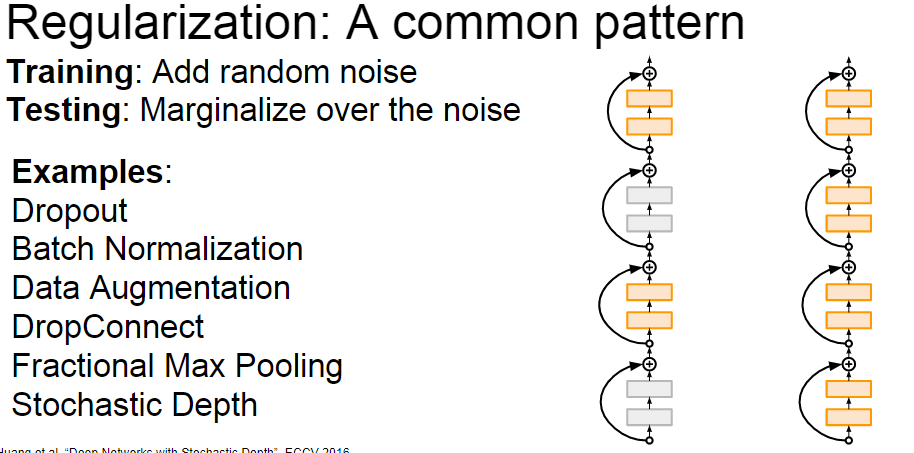

二、正则化方法:

三、迁移学习