前提环境是之前搭建的4台Linux虚拟机,详情参见 Linux集群搭建

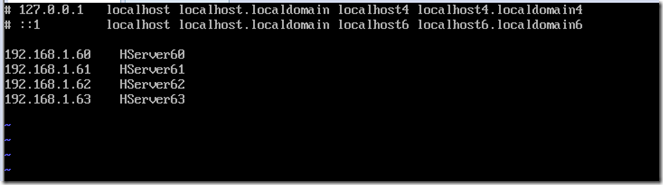

该环境对应4台服务器,192.168.1.60、61、62、63,其中60为主机,其余为从机

软件版本选择:

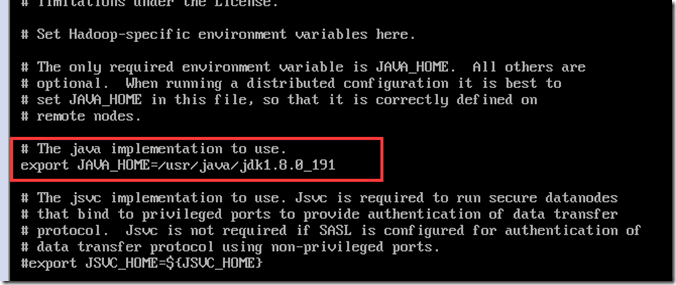

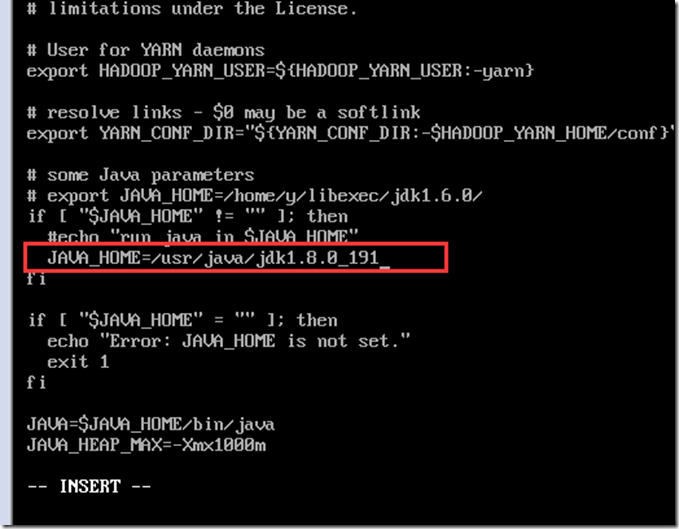

Java:JDK1.8.0_191(jdk-8u191-linux-x64.tar.gz)

Hadoop:Hadoop-2.9.2(hadoop-2.9.2.tar.gz)

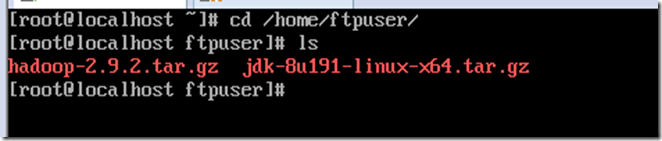

上传hadoop与java到服务器并查看

cd /home/ftpuser/

ls安装Java

解压Java

mkdir /usr/java

tar -zxvf jdk-8u191-linux-x64.tar.gz -C /usr/java/

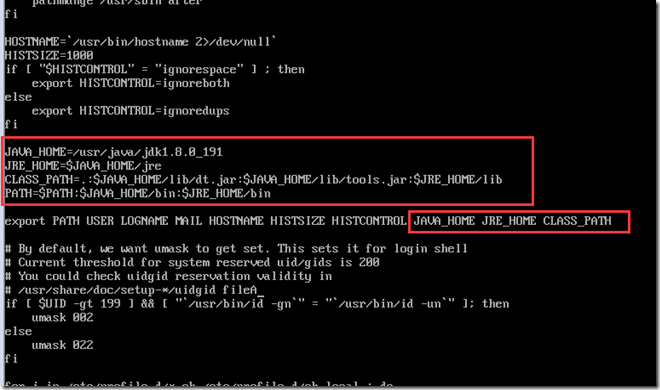

配置Java环境变量

vi /etc/profile

添加Java配置

启用配置

source /etc/profile

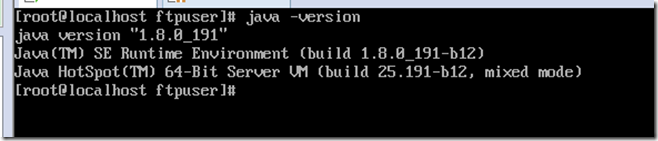

查看是否配置成功

java -version

配置Hadoop主体环境

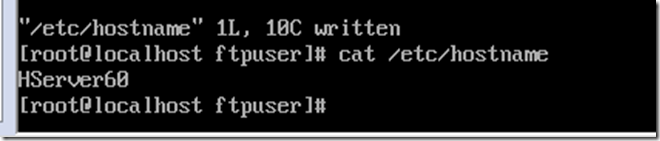

修改hostname,方便认识,这里设置为对应IP的4台服务器HServer60,HServer61,HServer62,HServer63,配置后重启(reboot)生效

vi /etc/hostname

配置hosts文件,对应IP于主机名

vi /etc/hosts

解压hadoop

mkdir /cloud cd /home/ftpuser/ tar -zxvf hadoop-2.9.2.tar.gz -C /cloud/

一共有5个文件需要配置

hadoop-env.sh

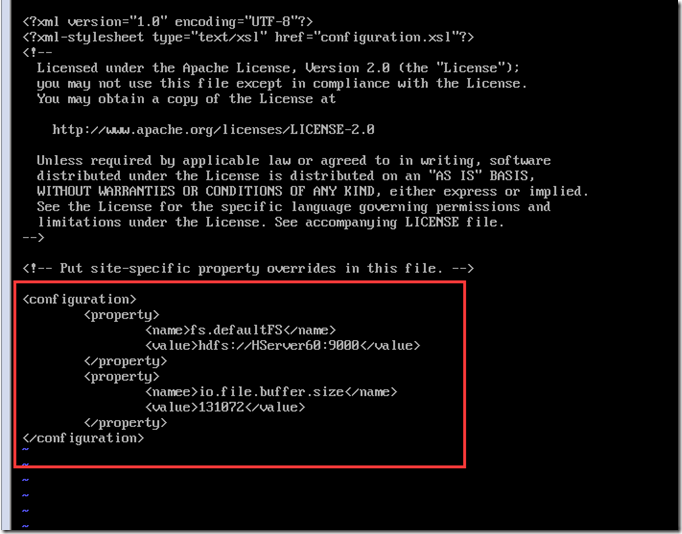

core-site.xml

hdfs-site.xml

yarn-site.xml

yarn-env.sh

mapred-site.xml

slaves

cd /cloud/hadoop-2.9.2/etc/hadoop/

配置hadoop-env.sh

vi hadoop-env.sh

配置yarn-env.sh

vi yarn-env.sh

配置core-site.xml

vi core-site.xml

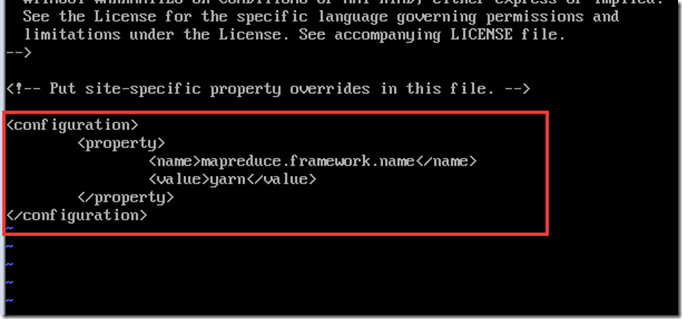

配置mapred-site.xml,先从模板复制一份配置出来,并修改

cp mapred-site.xml.template mapred-site.xml

vi mapred-site.xml

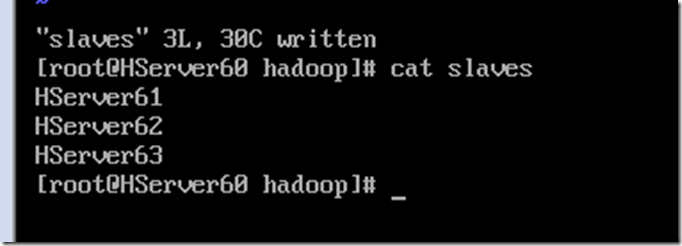

配置slaves,写入从机名称

vi slaves

剩下的2个文件hdfs-site.xml与yarn-site.xml需要区分主机NameNode与从机DataNode的配置

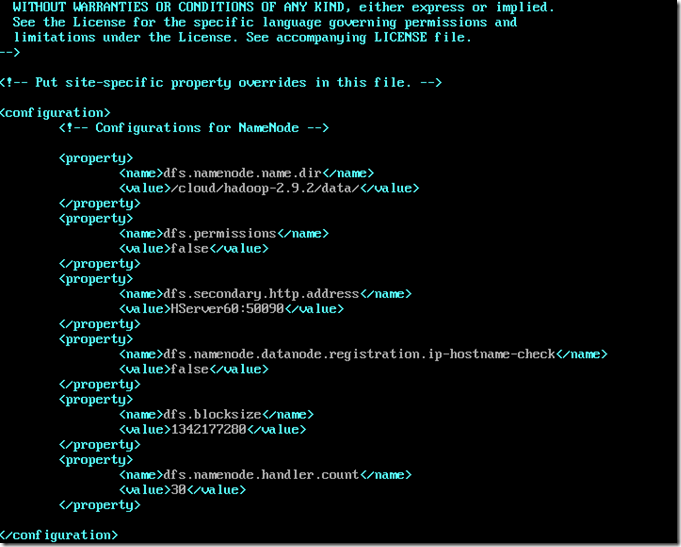

主机NameNode的hdfs-site.xml配置

vi hdfs-site.xml

其中blocksize可以根据情况自行调整,是数据块的大小,handler.cout一般几台小集群10都足够了

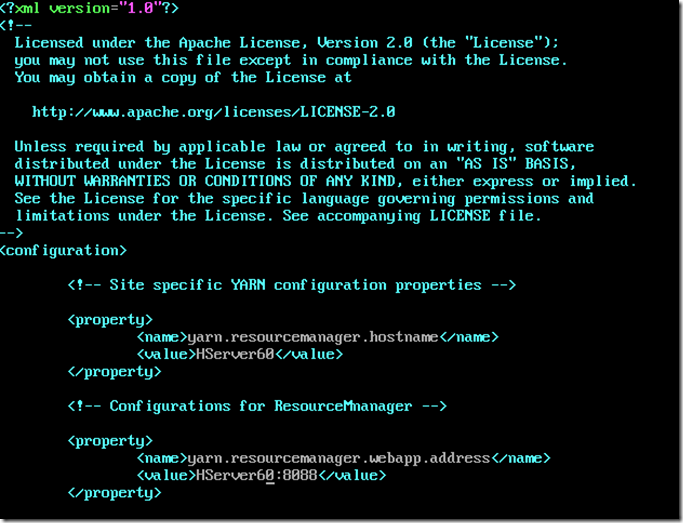

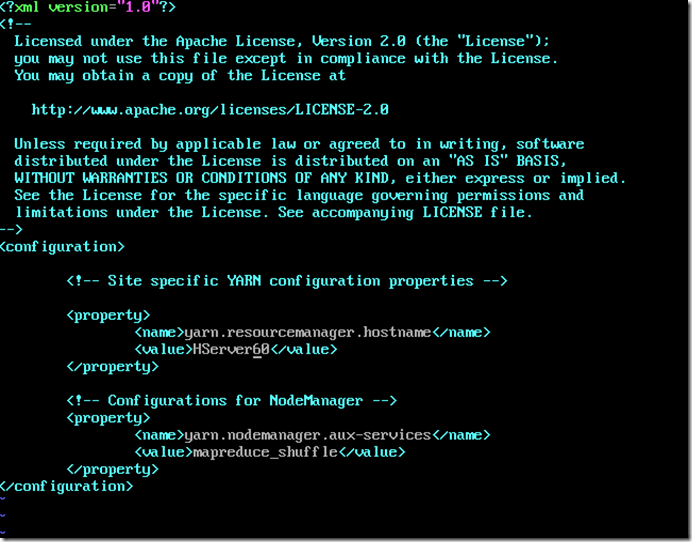

主机NameNode的yarn-site.xml配置

vi yarn-site.xml

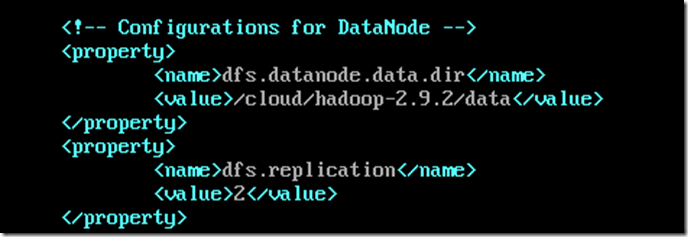

从机DataNode的hdfs-site.xml配置

vi hdfs-site.xml

其中replication为备份数

从机DataNode的yarn-site.xml配置

vi yarn-site.xml

设置NameNode免密登录,在主机上操作

ssh-copy-id -i ~/.ssh/id_rsa.pub root@192.168.1.61 ssh-copy-id -i ~/.ssh/id_rsa.pub root@192.168.1.62 ssh-copy-id -i ~/.ssh/id_rsa.pub root@192.168.1.63

可以将配置好的东西通过scp命令复制到远程服务器上

scp -rp /cloud/hadoop-2.9.2 root@192.168.1.62:/cloud/

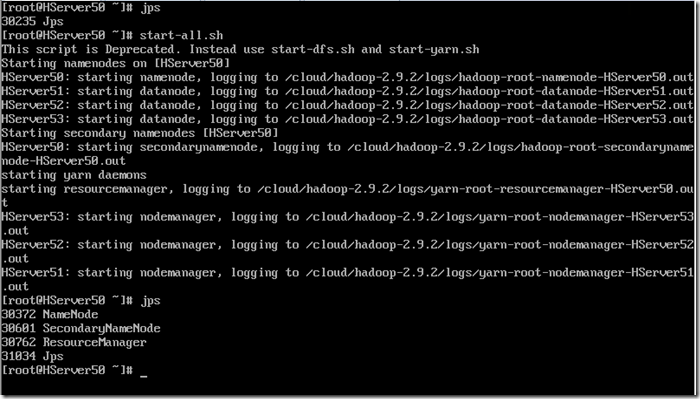

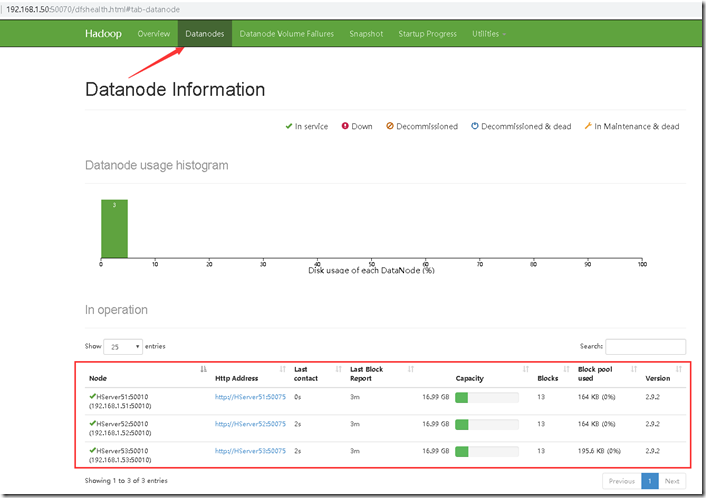

整个Hadoop集群配置完毕,可以启动试试看,这里换到我已经搭建好的4台服务器,50、51、52、53

启动命令在hadoop目录的sbin文件夹中,也可以在/etc/profile文件中配置环境变量,类似java配置,将该目录加入path路径

启动hadoop集群,通过jps查看是否启动了

start-all.sh

主机jps上会有NameNode,ResourceManager,SecondaryNameNode

从机jps上会有NodeManager,DataNode

这样就成功的启动了,访问主机IP:50070的URL访问