一. cloudera manager的概念

简单来说,Cloudera Manager是一个拥有集群自动化安装、中心化管理、集群监控、报警功能的一个工具(软件),使得安装集群从几天的时间缩短在几个小时内,运维人员从数十人降低到几人以内,极大的提高集群管理的效率。

功能:

1) 管理:对集群进行管理,如添加、删除节点等操作。

2) 监控:监控集群的健康情况,对设置的各种指标和系统运行情况进行全面监控。

3) 诊断:对集群出现的问题进行诊断,对出现的问题给出建议解决方案。

4) 集成:多组件进行整合。

架构:

1) Server:负责软件安装、配置,启动和停止服务,管理服务运行的群集。核心

2) Agent:安装在每台主机上。负责启动和停止进程,配置,监控主机。

3) Management Service:由一组执行各种监控,警报和报告功能角色的服务。图表的生成和管理

4) Database:存储配置和监视信息。

5) Cloudera Repository:软件由Cloudera 管理分布存储库。(有点类似Maven的中心仓库);在线安装(从中心仓库拉取)和离线安装(离线库)

6) Clients:是用于与服务器进行交互的接口(API和Admin Console)

二. 准备安装环境

主节点10g /16G 其他节点2G /4G 其他节点2G /4G 硬盘情况: [root@hadoop101 ~]# df -h

1. SSH免密登录

配置hadoop101对hadoop101、hadoop102、hadoop103三台服务器免密登录。CDH服务开启与关闭是通过server和agent来完成的,所以这里不需要配置SSH免密登录,但是为了我们分发文件方便,在这里我们也配置SSH。

1)生成公钥和私钥:

[root@hadoop101 .ssh]$ ssh-keygen -t rsa

然后敲(三个回车),就会生成两个文件id_rsa(私钥)、id_rsa.pub(公钥)

2)将公钥拷贝到要免密登录的目标机器上

[root@hadoop101 .ssh]$ ssh-copy-id hadoop101 [root@hadoop101 .ssh]$ ssh-copy-id hadoop102 [root@hadoop101 .ssh]$ ssh-copy-id hadoop103

3)重复1和2的操作,配置hadoop102对hadoop101、hadoop102、hadoop103三台服务器免密登录。

2. 集群同步脚本

1)在/root目录下创建bin目录,并在bin目录下创建文件xsync,文件内容如下:

[root@hadoop101 ~]$ mkdir bin [root@hadoop101 ~]$ cd bin/ [root@hadoop101 bin]$ vi xsync

#!/bin/bash #1 获取输入参数个数,如果没有参数,直接退出 pcount=$# if((pcount==0)); then echo no args; exit; fi #2 获取文件名称 p1=$1 fname=`basename $p1` echo fname=$fname #3 获取上级目录到绝对路径 pdir=`cd -P $(dirname $p1); pwd` echo pdir=$pdir #4 获取当前用户名称 user=`whoami` #5 循环 for((host=103; host<105; host++)); do echo ------------------- hadoop$host -------------- rsync -av $pdir/$fname $user@hadoop$host:$pdir done

2)修改脚本 xsync 具有执行权限

[root@hadoop101 bin]$ chmod 777 xsync

3. 安装JDK(三台)

1)解压JDK到/opt/module目录下,并修改文件的所有者和所有者组为root

[root@hadoop101 software]$ tar -zxvf jdk-8u144-linux-x64.tar.gz -C /opt/module/ [root@hadoop101 module]# chown root:root jdk1.8.0_144/ -R

2)配置JDK环境变量

(1)打开/etc/profile文件

[root@hadoop101 software]$ vi /etc/profile 在profile文件末尾添加JDK路径 #JAVA_HOME export JAVA_HOME=/opt/module/jdk1.8.0_144 export PATH=$PATH:$JAVA_HOME/bin

(2)让修改后的文件生效

[root@hadoop101 jdk1.8.0_144]$ source /etc/profile

3)测试JDK是否安装成功

[root@hadoop101 jdk1.8.0_144]# java -version java version "1.8.0_144"

4)将hadoop101中的JDK和环境变量分发到hadoop102、hadoop103两台主机

[root@hadoop101 opt]# xsync /opt/module/

[root@hadoop101 opt]# xsync /etc/profile

分别在hadoop102、hadoop103上source一下

[root@hadoop102 ~]$ source /etc/profile

[root@hadoop103 ~]# source /etc/profile

4. 集群整体操作脚本

1)在/root/bin目录下创建脚本xcall.sh

[root@hadoop101 bin]$ vim xcall.sh

#! /bin/bash for i in hadoop101 hadoop102 hadoop103 do echo --------- $i ---------- ssh $i "$*" done

2)修改脚本执行权限

[root@hadoop101 bin]$ chmod 777 xcall.sh

3)将/etc/profile文件追加到~/.bashrc后面

[root@hadoop101 module]# cat /etc/profile >> ~/.bashrc [root@hadoop102 module]# cat /etc/profile >> ~/.bashrc [root@hadoop103 module]# cat /etc/profile >> ~/.bashrc

4)测试

[root@hadoop101 bin]# xcall.sh jps

5. 安装MySQL

注意:一定要用root用户操作如下步骤;先卸载MySQL再安装

[root@hadoop101 software]# ll 总用量 2387020 -rw-r--r--. 1 root root 1620405492 4月 5 14:52 CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel -rw-r--r--. 1 root root 41 4月 5 14:51 CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.sha1 -rw-r--r--. 1 root root 742029734 4月 5 14:52 cloudera-manager-el6-cm5.12.1_x86_64.tar.gz -rw-r--r--. 1 root root 72312 4月 5 14:52 manifest.json -rw-r--r--. 1 root root 77807942 4月 5 14:54 mysql-libs.zip -rw-r--r--. 1 root root 3969752 4月 5 14:52 MySQL-shared-compat-5.6.41-1.el6.x86_64.rpm [root@hadoop101 software]# unzip mysql-libs.zip Archive: mysql-libs.zip creating: mysql-libs/ inflating: mysql-libs/MySQL-client-5.6.24-1.el6.x86_64.rpm inflating: mysql-libs/mysql-connector-java-5.1.27.tar.gz inflating: mysql-libs/MySQL-server-5.6.24-1.el6.x86_64.rpm [root@hadoop101 mysql-libs]# rpm -ivh MySQL-server-5.6.24-1.el6.x86_64.rpm [root@hadoop101 mysql-libs]# cat /root/.mysql_secret # The random password set for the root user at Sun Apr 5 14:55:45 2020 (local time): SEACIwdkL2dPI8_g [root@hadoop101 mysql-libs]# service mysql start Starting MySQL.... [确定] [root@hadoop101 mysql-libs]# rpm -ivh MySQL-client-5.6.24-1.el6.x86_64.rpm [root@hadoop101 mysql-libs]# mysql -uroot -pSEACIwdkL2dPI8_g mysql> SET PASSWORD=PASSWORD('123456'); Query OK, 0 rows affected (0.00 sec) [root@hadoop101 mysql-libs]# mysql -uroot -p123456 mysql> select User, Host, Password from mysql.user; +------+-----------+-------------------------------------------+ | User | Host | Password | +------+-----------+-------------------------------------------+ | root | localhost | *6BB4837EB74329105EE4568DDA7DC67ED2CA2AD9 | | root | hadoop101 | *5750A2405D7ED53B669267E80F41E095C3BABC0E | | root | 127.0.0.1 | *5750A2405D7ED53B669267E80F41E095C3BABC0E | | root | ::1 | *5750A2405D7ED53B669267E80F41E095C3BABC0E | +------+-----------+-------------------------------------------+ 4 rows in set (0.00 sec) mysql> update user set host='%' where host='localhost'; Query OK, 1 row affected (0.00 sec) Rows matched: 1 Changed: 1 Warnings: 0 mysql> delete from user where Host='hadoop101'; Query OK, 1 row affected (0.00 sec) mysql> delete from user where Host='127.0.0.1'; Query OK, 1 row affected (0.00 sec) mysql> delete from user where Host='::1'; Query OK, 1 row affected (0.00 sec) mysql> flush privileges; Query OK, 0 rows affected (0.00 sec) mysql> select User, Host, Password from user; +------+------+-------------------------------------------+ | User | Host | Password | +------+------+-------------------------------------------+ | root | % | *6BB4837EB74329105EE4568DDA7DC67ED2CA2AD9 | +------+------+-------------------------------------------+ 1 row in set (0.00 sec)

6. 创建CM用的数据库:

[root@hadoop101 ~]# mysql -uroot -p123456 (1)集群监控数据库 create database amon DEFAULT CHARSET utf8 COLLATE utf8_general_ci; (2)hive数据库 create database hive DEFAULT CHARSET utf8 COLLATE utf8_general_ci; ##安装Hive时需要创建hive数据库;如果安装失败要把它删除重写创建 (3)oozie数据库 create database oozie DEFAULT CHARSET utf8 COLLATE utf8_general_ci; (4)hue数据库 create database hue DEFAULT CHARSET utf8 COLLATE utf8_general_ci;

7. 下载第三方依赖

依次在三台节点(所有Agent的节点)上执行下载第三方依赖(注意:需要联网)

[root@hadoop101 ~]# yum -y install chkconfig python bind-utils psmisc libxslt zlib sqlite cyrus-sasl-plain cyrus-sasl-gssapi fuse fuse-libs redhat-lsb [root@hadoop102 ~]# yum -y install chkconfig python bind-utils psmisc libxslt zlib sqlite cyrus-sasl-plain cyrus-sasl-gssapi fuse fuse-libs redhat-lsb [root@hadoop103 ~]# yum -y install chkconfig python bind-utils psmisc libxslt zlib sqlite cyrus-sasl-plain cyrus-sasl-gssapi fuse fuse-libs redhat-lsb

关闭SELINUX

安全增强型Linux(Security-Enhanced Linux)简称SELinux,它是一个 Linux 内核模块,也是Linux的一个安全子系统。为了避免安装过程出现各种错误,建议关闭,有如下两种关闭方法:

1)临时关闭(不建议使用)

[root@hadoop101 ~]# setenforce 0 但是这种方式只对当次启动有效,重启机器后会失效。

2)永久关闭(建议使用)

修改配置文件/etc/selinux/config [root@hadoop101 ~]# vim /etc/selinux/config 将SELINUX=enforcing 改为SELINUX=disabled SELINUX=disabled

3)同步/etc/selinux/config配置文件

[root@hadoop101 ~]# xsync /etc/selinux/config

4)重启hadoop101、hadoop102、hadoop103主机

[root@hadoop101 ~]# reboot [root@hadoop102 ~]# reboot [root@hadoop103 ~]# reboot

1.2.10 配置NTP时钟同步

1)NTP服务器配置

[root@hadoop101 ~]# vi /etc/ntp.conf ①注释掉所有的restrict开头的配置 ②修改#restrict 192.168.1.0 mask 255.255.255.0 nomodify notrap 为restrict 192.168.1.101 mask 255.255.255.0 nomodify notrap ③将所有server配置进行注释 ④添加下面两行内容 server 127.127.1.0 fudge 127.127.1.0 stratum 10

2)启动NTP服务 service ntpd start

[root@hadoop101 ~]# service ntpd start

3)NTP客户端配置(在agent主机上进行配置hadoop102,hadoop103)

[root@hadoop102 ~]# vi /etc/ntp.conf ①注释所有restrict和server配置 ②添加server 192.168.1.101

4)手动测试

[root@hadoop102 ~]# ntpdate 192.168.1.101 显示如下内容为成功: 17 Jun 15:34:38 ntpdate[9247]: step time server 192.168.1.101 offset 77556618.173854 sec 如果显示如下内容需要先关闭ntpd: 17 Jun 15:25:42 ntpdate[8885]: the NTP socket is in use, exiting

5)启动ntpd并设置为开机自启(每个节点hadoop101,hadoop102,hadoop103)

[root@hadoop102 ~]# chkconfig ntpd on [root@hadoop102 ~]# service ntpd start

6)使用群发date命令查看结果

3. CM安装部署

1)CM下载地址:http://archive.cloudera.com/cm5/cm/5/

2)离线库下载地址:http://archive.cloudera.com/cdh5/parcels

注:以下所有操作均使用root用户

1)创建/opt/module/cm目录

[root@hadoop101 module]# mkdir –p /opt/module/cm

2)上传cloudera-manager-el6-cm5.12.1_x86_64.tar.gz到hadoop101的/opt/software目录,并解压到/opt/module/cm目录

[root@hadoop101 software]# tar -zxvf cloudera-manager-el6-cm5.12.1_x86_64.tar.gz -C /opt/module/cm

3)分别在hadoop101、hadoop102、hadoop103创建用户cloudera-scm

[root@hadoop101 module]# useradd --system --home=/opt/module/cm/cm-5.12.1/run/cloudera-scm-server --no-create-home --shell=/bin/false --comment "Cloudera SCM User" cloudera-scm [root@hadoop102 module]# useradd --system --home=/opt/module/cm/cm-5.12.1/run/cloudera-scm-server --no-create-home --shell=/bin/false --comment "Cloudera SCM User" cloudera-scm [root@hadoop103 module]# useradd --system --home=/opt/module/cm/cm-5.12.1/run/cloudera-scm-server --no-create-home --shell=/bin/false --comment "Cloudera SCM User" cloudera-scm

参数说明:

--system 创建一个系统账户

--home 指定用户登入时的主目录,替换系统默认值/home/<用户名>

--no-create-home 不要创建用户的主目录

--shell 用户的登录 shell 名

--comment 用户的描述信息

注意:Cloudera Manager默认去找用户cloudera-scm,创建完该用户后,将自动使用此用户。

4)修改CM Agent配置

修改文件/opt/module/cm/cm-5.12.1/etc/cloudera-scm-agent/ config.ini的主机名称 [root@hadoop101 cloudera-scm-agent]# vim /opt/module/cm/cm-5.12.1/etc/cloudera-scm-agent/config.ini 修改主机名称 server_host=hadoop101

5)配置CM的数据库 ,在主节点创建即可。

拷贝mysql-connector-java-5.1.27-bin.jar文件到目录 /usr/share/java/

[root@hadoop101 cm]# mkdir –p /usr/share/java/ [root@hadoop101 mysql-libs]# tar -zxvf mysql-connector-java-5.1.27.tar.gz [root@hadoop101 mysql-libs]# cp /opt/software/mysql-libs/mysql-connector-java-5.1.27/mysql-connector-java-5.1.27-bin.jar /usr/share/java/ [root@hadoop101 mysql-libs]# mv /usr/share/java/mysql-connector-java-5.1.27-bin.jar /usr/share/java/mysql-connector-java.jar

注意:jar包名称要修改为mysql-connector-java.jar

6)使用CM自带的脚本,在MySQL中创建CM库

[root@hadoop101 cm-5.12.1]# /opt/module/cm/cm-5.12.1/share/cmf/schema/scm_prepare_database.sh mysql cm -hhadoop101 -uroot -p123456 --scm-host hadoop101 scm scm scm

参数说明

-h:Database host

-u:Database username

-p:Database Password

--scm-host:SCM server's hostname

7)分发cm

[root@hadoop101 module]# xsync /opt/module/cm

8)创建Parcel-repo目录

Servre 节点创建目录/opt/cloudera/parcel-repo

[root@hadoop101 module]# mkdir -p /opt/cloudera/parcel-repo [root@hadoop101 module]# chown cloudera-scm:cloudera-scm /opt/cloudera/parcel-repo

9)拷贝下载文件manifest.json 、CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.sha1 、CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel到hadoop102的/opt/cloudera/parcel-repo/目录下

[root@hadoop101 parcel-repo]# ls

CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.sha1 manifest.json

10)将CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.sha1:需改名为

CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.sha

[root@hadoop101 parcel-repo]# mv CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.sha1 CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.sha

11)在hadoop101上创建目录/opt/cloudera/parcels,并修改该目录的所属用户及用户组为cloudera-scm

[root@hadoop101 module]# mkdir -p /opt/cloudera/parcels [root@hadoop101 module]# chown cloudera-scm:cloudera-scm /opt/cloudera/parcels

启动CM服务

1)启动服务节点:hadoop101

[root@hadoop101 cm]# /opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-server start Starting cloudera-scm-server: [确定]

2)启动工作节点:hadoop101、hadoop102、hadoop103

[root@hadoop101 cm]# /opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-agent start [root@hadoop102 cm]# /opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-agent start [root@hadoop103 cm]# /opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-agent start

注意:启动过程非常慢,Manager启动成功需要等待5分钟左右,过程中会在数据库中创建对应的表需要耗费一些时间。

3)查看被占用则表示安装成功了!!!

[root@hadoop101 cm]# netstat -anp | grep 7180 tcp 0 0 0.0.0.0:7180 0.0.0.0:* LISTEN 5498/java

4)访问http://hadoop101:7180,(用户名、密码:admin)

关闭CM服务

1)关闭工作节点:hadoop101、hadoop102、hadoop103

[root@hadoop101 cm]# /opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-agent stop Stopping cloudera-scm-agent: [确定] [root@hadoop102 cm]# /opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-agent stop Stopping cloudera-scm-agent: [确定] [root@hadoop103 cm]# /opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-agent stop Stopping cloudera-scm-agent: [确定]

2)关闭服务节点:hadoop101

[root@hadoop101 cm]# /opt/module/cm/cm-5.12.1/etc/init.d/cloudera-scm-server stop 停止 cloudera-scm-server: [确定]

按装CM

1. 解压cloudera-manager-el6-cm5.12.1_x86_64.tar.gz

[root@hadoop104 module]# mkdir /opt/module/cloudera-manager

[root@hadoop104 module]# tar -zxvf /opt/software/cloudera-manager-el6-cm5.12.1_x86_64.tar.gz -C /opt/module/cloudera-manager/

2. 创建用户cloudera-scm(所有节点,三个节点都创建)

[root@hadoop104 cloudera-manager]# useradd --system --home=/opt/module/cloudera-manager/cm-5.12.1/run/cloudera-scm-server --no-create-home --shell=/bin/false --comment "Cloudera SCM User" cloudera-scm

[root@hadoop104 cloudera-manager]# id cloudera-scm

uid=495(cloudera-scm) gid=492(cloudera-scm) 组=492(cloudera-scm)

#####hadoop104、hadoop105、hadoop106都需要创建cloudera-scm用户,否则在Parcel分发状态下,没有创建用户的分发,激活不了;

3. 配置CM Agent

修改文件/opt/module/cloudera-manager/cm-5.12.1/etc/cloudera-scm-agent/config.ini

[root@hadoop104 cloudera-scm-agent]# vim config.ini

[General]

# Hostname of the CM server.

server_host=hadoop104

4. 配置CM的数据库;在主节点创建即可;

拷贝mysql jar文件到目录 /usr/share/java/

[root@hadoop104 share]# mkdir /usr/share/java/

[root@hadoop104 cm-5.12.1]# cp /opt/software/mysql-libs/mysql-connector-java-5.1.27/mysql-connector-java-5.1.27-bin.jar /usr/share/java/

[root@hadoop104 share]# mv /usr/share/java/mysql-connector-java-5.1.27-bin.jar /usr/share/java/mysql-connector-java.jar

• 注意jar包名称要修改为mysql-connector-java.jar

在mysql中创建cm库

[root@hadoop104 cm-5.12.1]# /opt/module/cloudera-manager/cm-5.12.1/share/cmf/schema/scm_prepare_database.sh mysql cm -hhadoop104 -uroot -p123456 --scm-host hadoop104 scm scm scm

5. 分发到其他机器中

xsync cloudera-manager/

创建Parcel-repo目录

创建Parcel-repo 目录

1. Servre 节点创建目录/opt/cloudera/parcel-repo

[root@hadoop104 module]# mkdir -p /opt/cloudera/parcel-repo

[root@hadoop104 module]# chown cloudera-scm:cloudera-scm /opt/cloudera/parcel-repo

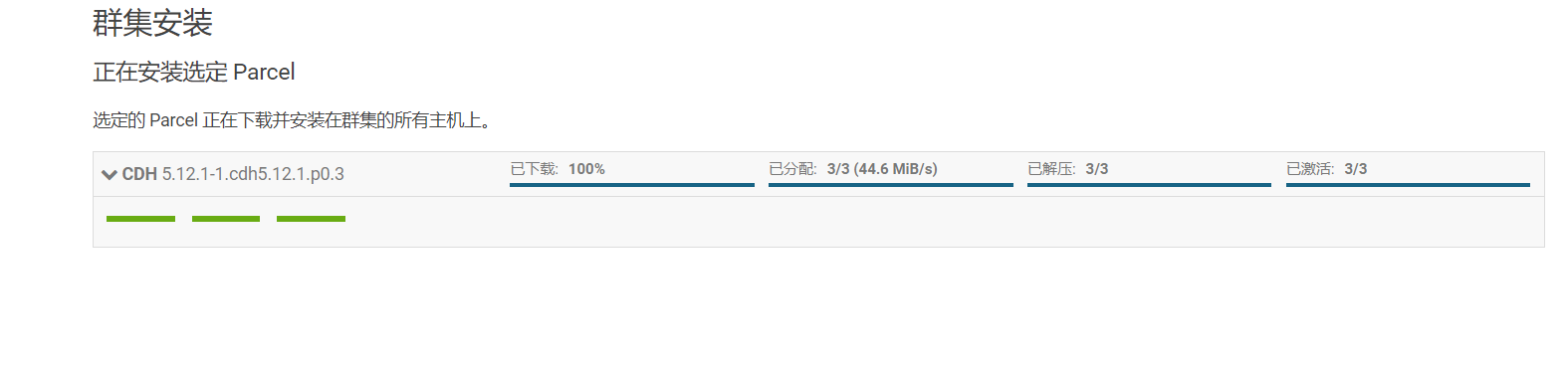

2.拷贝下载文件到/opt/cloudera/parcel-repo

(1)CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel

(2)CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.sha1:需改名为CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.sha

(3)manifest.json

[root@hadoop104 cm-5.12.1]# mv /opt/software/CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.sha1 /opt/software/CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.sha

[root@hadoop104 module]# cp /opt/software/CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel.sha /opt/cloudera/parcel-repo/

[root@hadoop104 module]# cp /opt/software/CDH-5.12.1-1.cdh5.12.1.p0.3-el6.parcel /opt/cloudera/parcel-repo/

[root@hadoop104 module]# cp /opt/software/manifest.json /opt/cloudera/parcel-repo/

3.在Agent 节点(hadoop102,hadoop103,hadoop104)创建目录/opt/cloudera/parcels

[root@hadoop104 module]# mkdir -p /opt/cloudera/parcels

[root@hadoop104 module]# chown cloudera-scm:cloudera-scm /opt/cloudera/parcels

[root@hadoop105 module]# mkdir -p /opt/cloudera/parcels

[root@hadoop105 module]# chown cloudera-scm:cloudera-scm /opt/cloudera/parcels

[root@hadoop106 module]# mkdir -p /opt/cloudera/parcels

[root@hadoop106 module]# chown cloudera-scm:cloudera-scm /opt/cloudera/parcels

4. 分发Parcel-repo

[root@hadoop104 cloudera]# xsync /opt/cloudera/

启动和关闭CM Server&Agent 服务

服务节点:hadoop104

[root@hadoop104 init.d]# /opt/module/cloudera-manager/cm-5.12.1/etc/init.d/cloudera-scm-server start

Starting cloudera-scm-server: [确定]

工作节点:hadoop104hadoop105hadoop106

[root@hadoop104 init.d]# /opt/module/cloudera-manager/cm-5.12.1/etc/init.d/cloudera-scm-agent start

正在启动 cloudera-scm-agent: [确定]

[root@hadoop105 module]# /opt/module/cloudera-manager/cm-5.12.1/etc/init.d/cloudera-scm-agent start

正在启动 cloudera-scm-agent: [确定]

[root@hadoop106 module]# /opt/module/cloudera-manager/cm-5.12.1/etc/init.d/cloudera-scm-agent start

正在启动 cloudera-scm-agent: [确定]

注意:启动过程非常慢,Manager 启动成功需要等待一段时间,过程中会在数据库中创建对应的表需要耗费一些时间。

[root@hadoop102 init.d]# netstat -anp | grep 7180

tcp 0 0 0.0.0.0:7180 0.0.0.0:* LISTEN 5498/java

查看被占用则表示安装成功了!!!

访问http://hadoop104:7180,(用户名、密码:admin)

关闭:

服务节点:hadoop104

[root@hadoop104 init.d]# /opt/module/cloudera-manager/cm-5.12.1/etc/init.d/cloudera-scm-server stop

停止 cloudera-scm-server: [确定]

工作节点:hadoop104hadoop105hadoop106

[root@hadoop104 init.d]# /opt/module/cloudera-manager/cm-5.12.1/etc/init.d/cloudera-scm-agent stop

Stopping cloudera-scm-agent:

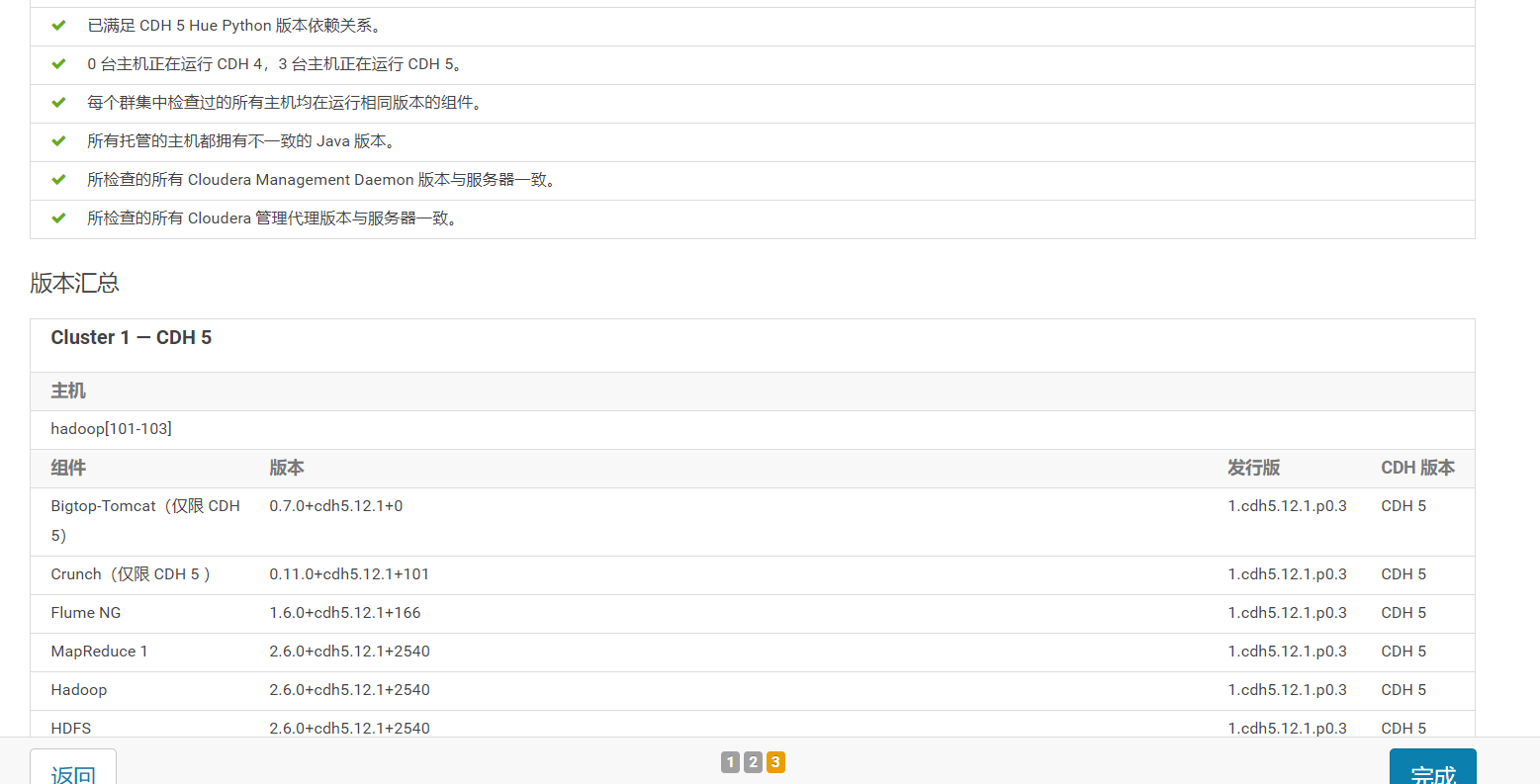

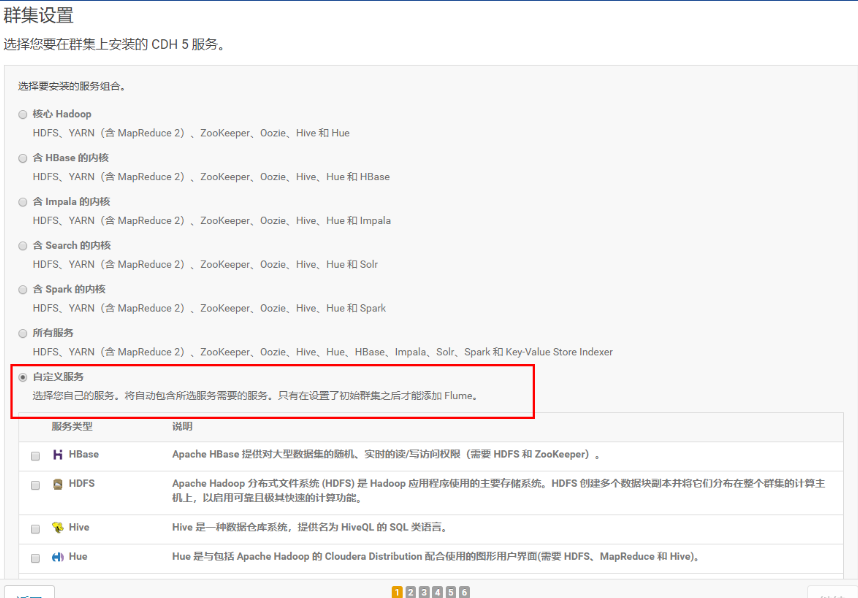

集群设置自定义安装

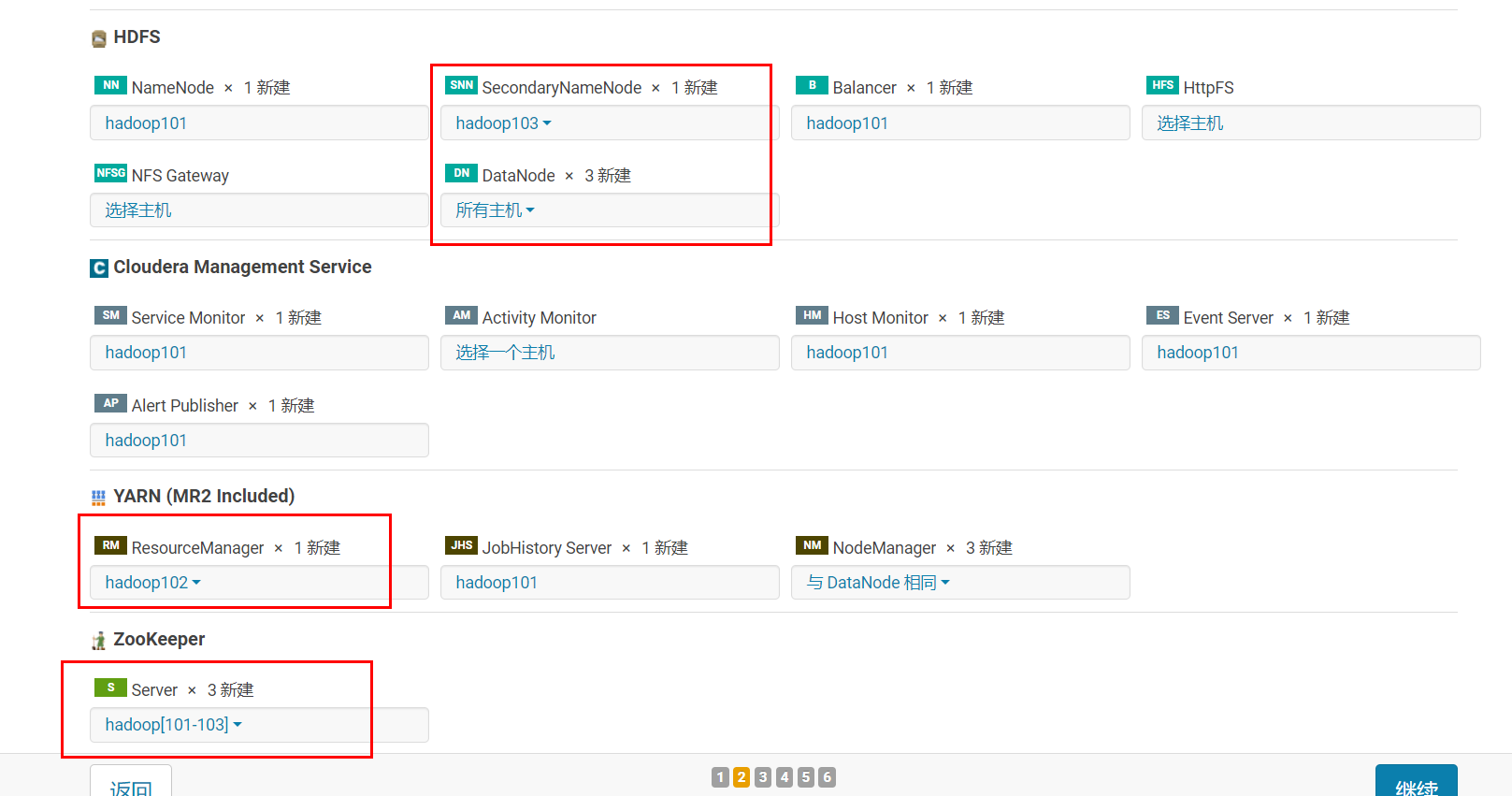

选择安装服务:

分配节点:

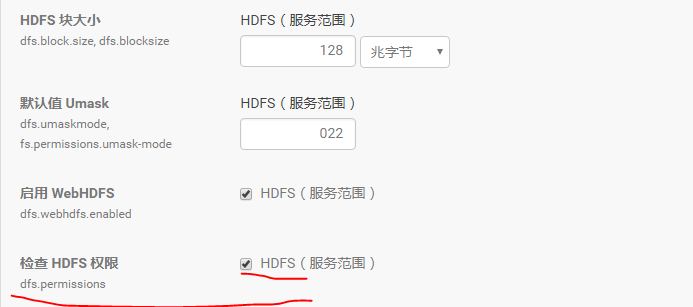

集群设置全部选默认即可,自动启动进程

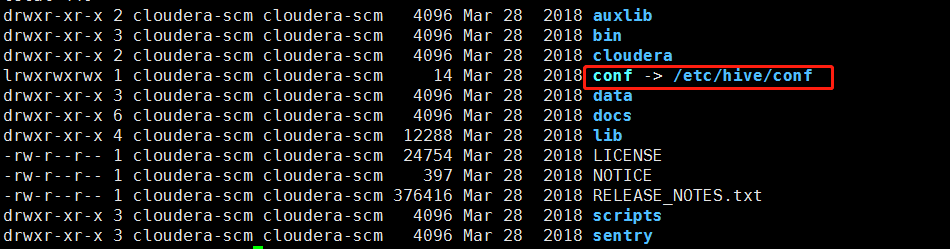

[root@hadoop104 conf]# pwd //Hive的配置文件位置

/etc/hive/conf

HDFS重新安装的时候要把它的df文件夹给删掉

hive重新安装要把mysql里的hive库删掉;

修改权限问题两种方法:

第一种:

#第二种方式

[hdfs@hadoop104 init.d]$ su - hdfs ##su用户切换时 加 - 是会把环境也切换过来;建议用这种形式;

[hdfs@hadoop104 init.d]$ hadoop fs -chmod -R 777 /

[hdfs@hadoop104 init.d]$ exit ###不要直接su套用户,先exit结束掉

exit

[root@hadoop104 init.d]#

hive的启动

[root@hadoop104 ~]# hive ##启动hive时直接启动; Java HotSpot(TM) 64-Bit [root@hadoop104 ~]# beeline ##直接启动beeline,不用启动hiveserver2,因为在CDH上hive已经给我们启动了 Java HotSpot(TM) 64-Bit Server VM warning: ignoring option MaxPermSize=512M; support was removed in 8.0 beeline> !connect jdbc:hive2://hadoop104:10000 scan complete in 13ms Connecting to jdbc:hive2://hadoop104:10000 Enter username for jdbc:hive2://hadoop104:10000: hive ####用户是启动hiveserver2的用户,而不是root Enter password for jdbc:hive2://hadoop104:10000:

Hive配置文件所在目录:

cloudera/parcels/CDH/lib/hive/conf