1. Azkaban安装部署

https://azkaban.github.io/azkaban/docs/2.5/

安装Azkaban

1) 在/opt/module/目录下创建azkaban目录

[kris@hadoop101 module]$ mkdir azkaban

2) 解压azkaban-web-server-2.5.0.tar.gz、azkaban-executor-server-2.5.0.tar.gz、azkaban-sql-script-2.5.0.tar.gz到/opt/module/azkaban目录下

[kris@hadoop101 software]$ tar -zxvf azkaban-web-server-2.5.0.tar.gz -C /opt/module/azkaban/

[kris@hadoop101 software]$ tar -zxvf azkaban-executor-server-2.5.0.tar.gz -C /opt/module/azkaban/

[kris@hadoop101 software]$ tar -zxvf azkaban-sql-script-2.5.0.tar.gz -C /opt/module/azkaban/

3) 对解压后的文件重新命名

[kris@hadoop101 azkaban]$ mv azkaban-web-2.5.0/ server

[kris@hadoop101 azkaban]$ mv azkaban-executor-2.5.0/ executor

4) azkaban脚本导入

进入mysql,创建azkaban数据库,并将解压的脚本导入到azkaban数据库。

[kris@hadoop101 azkaban]$ mysql -uroot -p000000

mysql> create database azkaban;

mysql> use azkaban;

mysql> source /opt/module/azkaban/azkaban-2.5.0/create-all-sql-2.5.0.sql

注:source后跟.sql文件,用于批量处理.sql文件中的sql语句。

生成密钥对和证书

Keytool是java数据证书的管理工具,使用户能够管理自己的公/私钥对及相关证书。

-keystore 指定密钥库的名称及位置(产生的各类信息将存在.keystore文件中)

-genkey(或者-genkeypair) 生成密钥对

-alias 为生成的密钥对指定别名,如果没有默认是mykey

-keyalg 指定密钥的算法 RSA/DSA 默认是DSA

1)生成 keystore的密码及相应信息的密钥库

[kris@hadoop101 server]$ keytool -keystore keystore -alias jetty -genkey -keyalg RSA

输入密钥库口令:

再次输入新口令:

您的名字与姓氏是什么?

[Unknown]:

您的组织单位名称是什么?

[Unknown]:

您的组织名称是什么?

[Unknown]:

您所在的城市或区域名称是什么?

[Unknown]:

您所在的省/市/自治区名称是什么?

[Unknown]:

该单位的双字母国家/地区代码是什么?

[Unknown]:

CN=Unknown, OU=Unknown, O=Unknown, L=Unknown, ST=Unknown, C=Unknown是否正确?

[否]: y

输入 <jetty> 的密钥口令

(如果和密钥库口令相同, 按回车):

再次输入新口令:

注意:

密钥库的密码至少必须6个字符,可以是纯数字或者字母或者数字和字母的组合等等

密钥库的密码最好和<jetty> 的密钥相同,方便记忆

时间同步配置

先配置好服务器节点上的时区

1) 如果在/usr/share/zoneinfo/这个目录下不存在时区配置文件Asia/Shanghai,就要用 tzselect 生成。

1)如果在/usr/share/zoneinfo/这个目录下不存在时区配置文件Asia/Shanghai,就要用 tzselect 生成。[kris@hadoop101 azkaban]$ tzselect Please identify a location so that time zone rules can be set correctly. Please select a continent or ocean. 1) Africa 2) Americas 3) Antarctica 4) Arctic Ocean 5) Asia 6) Atlantic Ocean 7) Australia 8) Europe 9) Indian Ocean 10) Pacific Ocean 11) none - I want to specify the time zone using the Posix TZ format. #? 5 Please select a country. 1) Afghanistan 18) Israel 35) Palestine 2) Armenia 19) Japan 36) Philippines 3) Azerbaijan 20) Jordan 37) Qatar 4) Bahrain 21) Kazakhstan 38) Russia 5) Bangladesh 22) Korea (North) 39) Saudi Arabia 6) Bhutan 23) Korea (South) 40) Singapore 7) Brunei 24) Kuwait 41) Sri Lanka 8) Cambodia 25) Kyrgyzstan 42) Syria 9) China 26) Laos 43) Taiwan 10) Cyprus 27) Lebanon 44) Tajikistan 11) East Timor 28) Macau 45) Thailand 12) Georgia 29) Malaysia 46) Turkmenistan 13) Hong Kong 30) Mongolia 47) United Arab Emirates 14) India 31) Myanmar (Burma) 48) Uzbekistan 15) Indonesia 32) Nepal 49) Vietnam 16) Iran 33) Oman 50) Yemen 17) Iraq 34) Pakistan #? 9 Please select one of the following time zone regions. 1) Beijing Time 2) Xinjiang Time #? 1 The following information has been given: China Beijing Time Therefore TZ='Asia/Shanghai' will be used. Local time is now: Thu Oct 18 16:24:23 CST 2018. Universal Time is now: Thu Oct 18 08:24:23 UTC 2018. Is the above information OK? 1) Yes 2) No #? 1 You can make this change permanent for yourself by appending the line TZ='Asia/Shanghai'; export TZ to the file '.profile' in your home directory; then log out and log in again. Here is that TZ value again, this time on standard output so that you can use the /usr/bin/tzselect command in shell scripts: Asia/Shanghai 2)拷贝该时区文件,覆盖系统本地时区配置 [kris@hadoop101 azkaban]$ cp /usr/share/zoneinfo/Asia/Shanghai /etc/localtime 3)集群时间同步(同时发给三个窗口) [kris@hadoop101 azkaban]$ sudo date -s '2018-10-18 16:39:30'

配置文件

Web服务器配置

1)进入azkaban web服务器安装目录 conf目录,打开azkaban.properties文件

[kris@hadoop101 conf]$ pwd

/opt/module/azkaban/server/conf

[kris@hadoop101 conf]$ vim azkaban.properties

2)按照如下配置修改azkaban.properties文件。

#Azkaban Personalization Settings

#服务器UI名称,用于服务器上方显示的名字

azkaban.name=Test

#描述

azkaban.label=My Local Azkaban

#UI颜色

azkaban.color=#FF3601

azkaban.default.servlet.path=/index

#默认web server存放web文件的目录

web.resource.dir=/opt/module/azkaban/server/web/

#默认时区,已改为亚洲/上海 默认为美国

default.timezone.id=Asia/Shanghai

#Azkaban UserManager class

user.manager.class=azkaban.user.XmlUserManager

#用户权限管理默认类(绝对路径)

user.manager.xml.file=/opt/module/azkaban/server/conf/azkaban-users.xml

#Loader for projects

#global配置文件所在位置(绝对路径)

executor.global.properties=/opt/module/azkaban/executor/conf/global.properties

azkaban.project.dir=projects

#数据库类型

database.type=mysql

#端口号

mysql.port=3306

#数据库连接IP

mysql.host=hadoop101

#数据库实例名

mysql.database=azkaban

#数据库用户名

mysql.user=root

#数据库密码

mysql.password=000000

#最大连接数

mysql.numconnections=100

# Velocity dev mode

velocity.dev.mode=false

# Azkaban Jetty server properties.

# Jetty服务器属性.

#最大线程数

jetty.maxThreads=25

#Jetty SSL端口

jetty.ssl.port=8443

#Jetty端口

jetty.port=8081

#SSL文件名(绝对路径)

jetty.keystore=/opt/module/azkaban/server/keystore

#SSL文件密码

jetty.password=000000

#Jetty主密码与keystore文件相同

jetty.keypassword=000000

#SSL文件名(绝对路径)

jetty.truststore=/opt/module/azkaban/server/keystore

#SSL文件密码

jetty.trustpassword=000000

# Azkaban Executor settings

executor.port=12321

# mail settings

mail.sender=

mail.host=

job.failure.email=

job.success.email=

lockdown.create.projects=false

cache.directory=cache

3)web服务器用户配置

在azkaban web服务器安装目录 conf目录,按照如下配置修改azkaban-users.xml 文件,增加管理员用户。

[kris@hadoop101 conf]$ vim azkaban-users.xml

<azkaban-users>

<user username="azkaban" password="azkaban" roles="admin" groups="azkaban" />

<user username="metrics" password="metrics" roles="metrics"/>

<user username="admin" password="admin" roles="admin,metrics"/>

<role name="admin" permissions="ADMIN" />

<role name="metrics" permissions="METRICS"/>

</azkaban-users>

执行服务器配置

1)进入执行服务器安装目录conf,打开azkaban.properties

[kris@hadoop101 conf]$ pwd

/opt/module/azkaban/executor/conf

[kris@hadoop101 conf]$ vim azkaban.properties

2) 按照如下配置修改azkaban.properties文件。

#Azkaban

#时区

default.timezone.id=Asia/Shanghai

# Azkaban JobTypes Plugins

#jobtype 插件所在位置

azkaban.jobtype.plugin.dir=plugins/jobtypes

#Loader for projects

executor.global.properties=/opt/module/azkaban/executor/conf/global.properties

azkaban.project.dir=projects

database.type=mysql

mysql.port=3306

mysql.host=hadoop102

mysql.database=azkaban

mysql.user=root

mysql.password=000000

mysql.numconnections=100

# Azkaban Executor settings

#最大线程数

executor.maxThreads=50

#端口号(如修改,请与web服务中一致)

executor.port=12321

#线程数

executor.flow.threads=30

①启动executor服务器

在executor服务器目录下执行启动命令

[kris@hadoop101 executor]$ /opt/module/azkaban/executor/bin/azkaban-executor-start.sh

②启动web服务器

在azkaban web服务器目录下执行启动命令

[kris@hadoop101 server]$ /opt/module/azkaban/server/bin/azkaban-web-start.sh

注意:先执行executor,再执行web,避免Web Server会因为找不到执行器启动失败。

jps查看进程

[kris@hadoop101 server]$ jps

3601 AzkabanExecutorServer

5880 Jps

3661 AzkabanWebServer

启动完成后,在浏览器(建议使用谷歌浏览器)中输入https://服务器IP地址:8443,https://hadoop101:8443/即可访问azkaban服务了。

在登录中输入刚才在azkaban-users.xml文件中新添加的户用名及密码,点击 login。

2. azkaban的使用

原生的 Azkaban 支持的plugin类型有以下这些:

- command:Linux shell命令行任务

- gobblin:通用数据采集工具

- hadoopJava:运行hadoopMR任务

- java:原生java任务

- hive:支持执行hiveSQL

- pig:pig脚本任务

- spark:spark任务

- hdfsToTeradata:把数据从hdfs导入Teradata

- teradataToHdfs:把数据从Teradata导入hdfs

action类型:command、java; 每一个工作单元一个文件

${param}, 可以给它传参数

上传时会进行校验

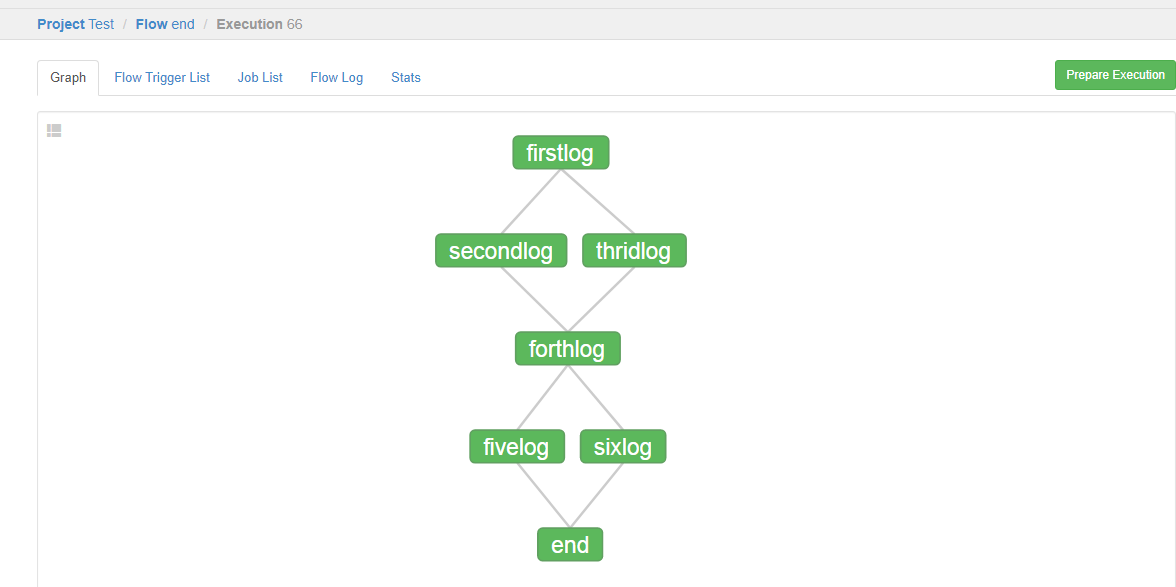

案例1:

第一个文件:firstlog.job

type=command

command=echo 'First'

user.to.proxy=hdfs

第二个文件:secondlog.job

type=command

command=echo 'second'

dependencies=firstlog

user.to.proxy=hdfs

第三个文件:thridlog.job

type=command

command=echo 'third'

dependencies=firstlog

user.to.proxy=hdfs

第四个文件:forthlog.job

type=command

command=echo 'forth'

dependencies=secondlog,thridlog

user.to.proxy=hdfs

第五个文件:fivelog.job

type=command

command=echo 'fifth'

dependencies=forthlog

user.to.proxy=hdfs

第六个文件:sixlog.job

type=command

command=echo 'sixth'

dependencies=forthlog

user.to.proxy=hdfs

end文件:

config:

nodes:

- name: end_job

type: noop

dependencies=fivelog,sixlog

user.to.proxy=hdfs

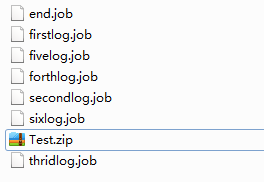

目前,Azkaban上传的工作流文件只支持xxx.zip文件。zip应包含xxx.job运行作业所需的文件和任何文件(文件名后缀必须以.job结尾,否则无法识别)。作业名称在项目中必须是唯一的。

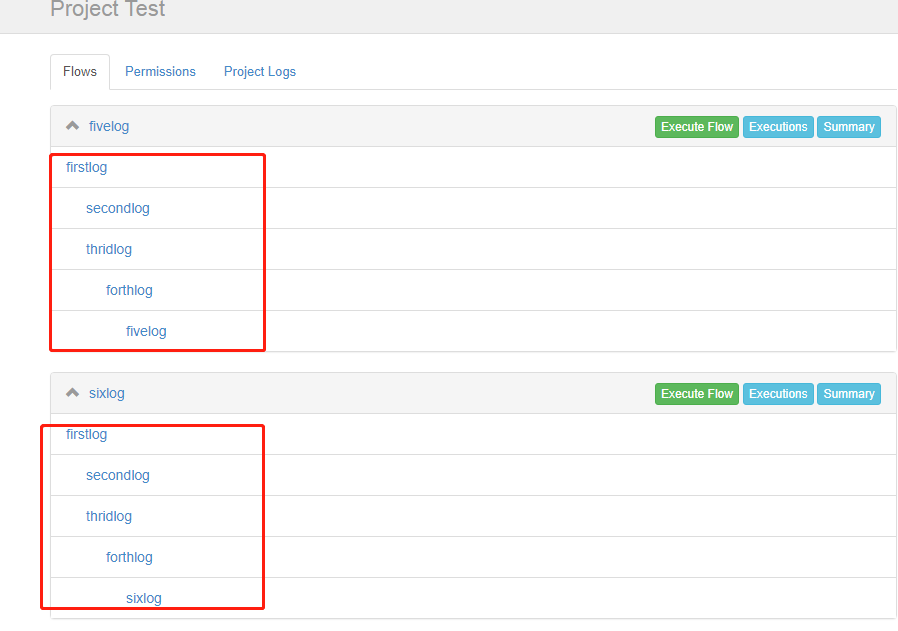

注: 需要添加end.job文件,否则会分成两个流如下图:

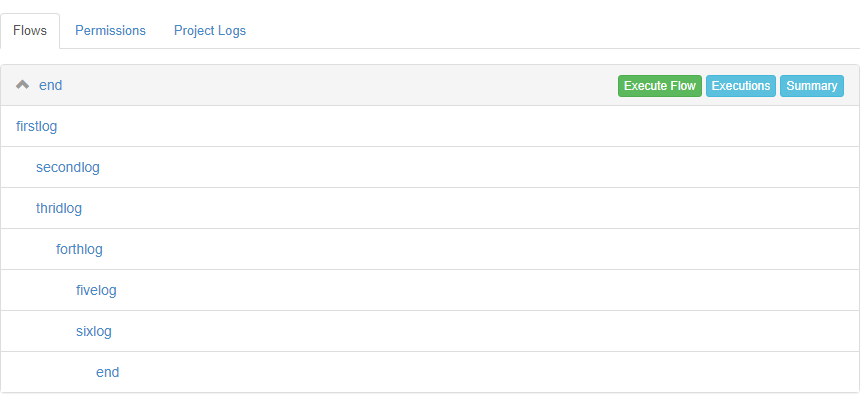

添加end.job后:

通过azkaban的web管理平台创建project并上传job的zip包

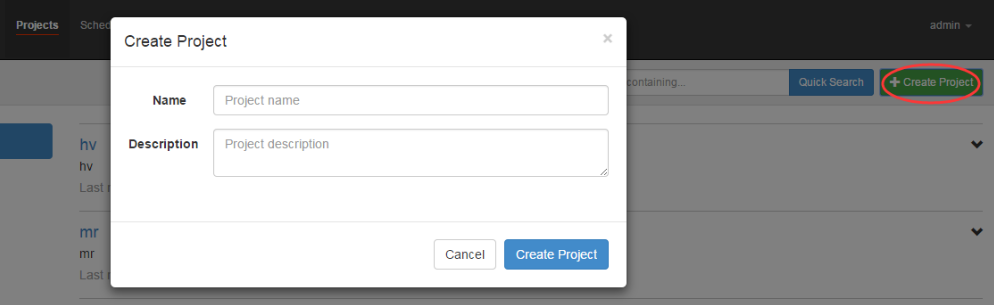

首先创建project

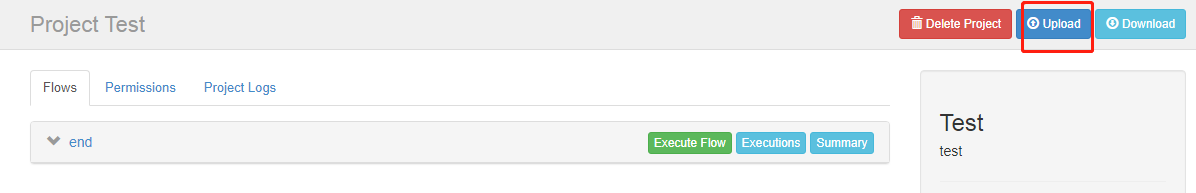

上传zip包

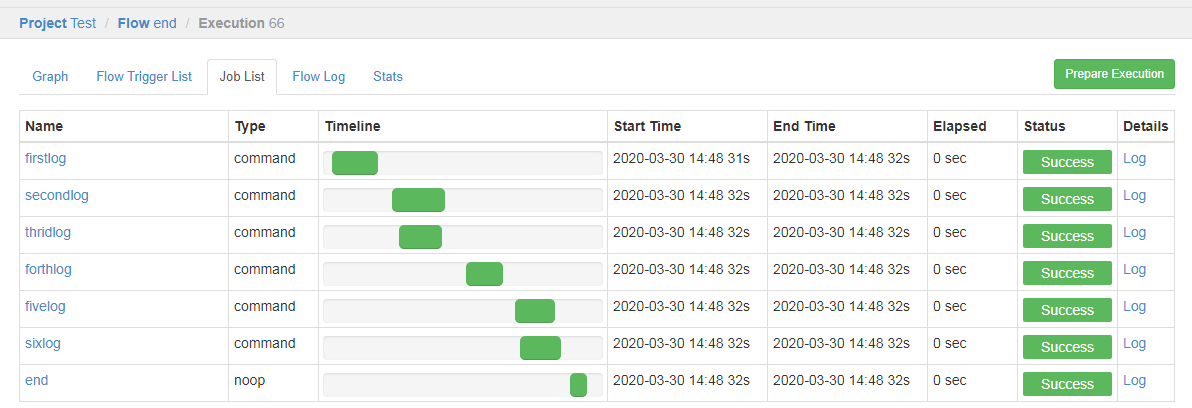

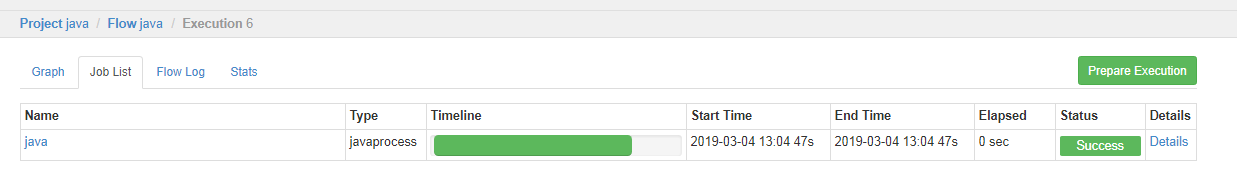

启动执行该job

点击执行工作流

执行成功,是绿色的

可点击查看job日志

直接再次upload会把之前的工程覆盖掉:

案例二:

public class AzkabanTest {

public static void main(String[] args) throws IOException {

FileOutputStream outputStream = null;

try {

outputStream = new FileOutputStream("/opt/module/azkaban/output.txt");

outputStream.write("this is a java progress".getBytes());

} catch (FileNotFoundException e) {

e.printStackTrace();

}finally {

outputStream.close();

}

}

}

将java程序打成jar包,创建lib目录,将jar放入lib内

[kris@hadoop101 lib]$ ll

总用量 4

-rw-r--r--. 1 kris kris 2441 3月 4 12:55 Azkaban-1.0-SNAPSHOT.jar

[kris@hadoop101 jobs]$ cat java.job

type=javaprocess

java.class=com.easylife.azkaban.AzkabanTest

classpath=/opt/module/azkaban/lib/*

classpath= #linux下的绝对路径

#也可以是相对路径(将jar包和java.job文件一块压缩)/相当于.job文件即: ./xx.job

type=javaprocess

classpath=./lib/* //先创建lib文件夹里边放jar包;

java.class=com.easylife.test.MyJavaJob

user.to.proxy=hdfs

打成ZIP包上传:

[kris@hadoop101 jobs]$ cat wordcount.txt

aaa aaa aaa

bb bb

cc cc

dd

把它上传到HDFS上,要先创建文件夹/wordcount/input

[kris@hadoop101 jobs]$ cat mapreduce.job

type=command

command=/opt/module/hadoop-2.7.2/bin/hadoop jar /opt/module/hadoop-2.7.2/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.2.jar wordcount /wordcount/input /wordcount/output

将所有job资源文件打到一个zip包中

[kris@hadoop101 jobs]$ zip mapreduce.zip mapreduce.job

adding: mapreduce.job (deflated 43%)

[kris@hadoop101 jobs]$ sz mapreduce.zip ##将它下载到windows中

[kris@hadoop101 jobs]$ cat student.sql

use default;

drop table student;

create table student(id int, name string)

row format delimited fields terminated by ' ';

load data local inpath '/opt/module/datas/student.txt' into table student;

insert overwrite local directory '/opt/module/datas/student'

row format delimited fields terminated by ' '

select * from student;

[kris@hadoop101 jobs]$ cat hive.job

#hive job

type=command

command=/opt/module/hive/bin/hive -f /opt/module/azkaban/jobs/student.sql

将所有job资源文件打到一个zip包中

[kris@hadoop101 jobs]$ zip hive.zip hive.job

adding: hive.job (deflated 21%)

在azkaban的web管理界面创建工程并上传zip包

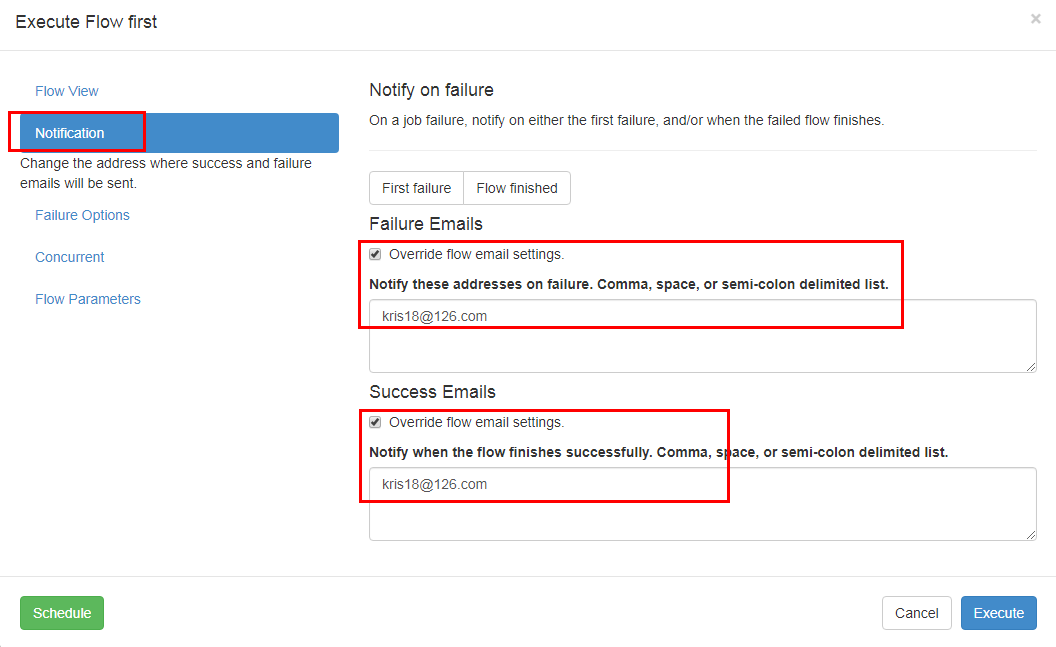

邮件通知配置案例

1)修改配置文件

修改server的conf下的azkaban.properties文件

[kris@hadoop101 conf]$ vim /opt/module/azkaban/server/conf/azkaban.properties # mail settings; 配置要使用哪个邮箱发送 mail.sender=kris18@126.com mail.host=smtp.126.com mail.user=kris18@126.com mail.password=kris18 # job.failure.email= job.success.email=

#重启下: [kris@hadoop101 azkaban]$ server/bin/azkaban-web-start.sh

在页面上配置要发送给谁: