本文原创,未经同意,谢绝转载!(转载请告知本人并且经过本人同意--By Pacific-hong)

本人小硕一枚,因为专业方向图像相关,所以用到opencv,然后网上MAC下Xcode配置opencv的教程比较少,要不然就是过时了。所以在一番倒腾之后,成功配置了OpenCV。写下本文供他人参考,少走弯路。

一.版本介绍

首先介绍macOS,Xcode,OpenCV版本:

macOS: macOS Sierra 10.12.4

Xcode: Xcode 8.3(8E162)

OpenCV:opencv 2.4.13.2

二.安装OpenCV

不要从官网下载opencv,因为官网没有macos版本(ios版本不能用在macbook下),本文中使用HomeBrew安装,方便快捷。

1) 打开终端:复制粘贴下面脚本:

ruby -e "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)"

如果已经安装过会有提示,就不会再安装了,关于HomeBrew的安装,可以参考 http://www.cnblogs.com/lzrabbit/p/4032515.html

出现Installation successful 就说明已经安装成功了,输入执行brew help能查看brew的具体用法.

2) 为了保证套件的完整,接着执行官网的建议脚本,安装wget.

brew install wget

3) 接着装cmake,这个是必须要装的.

brew install cmake

4) 重点:这里就是不同于网上大部分mac配置opencv方法之处,让brew帮我们下载OpenCV,而不是自己上OpenCV官网下载,切记,我从头到尾都不会让读者上官网去下载,因为我没有成功,这里感谢提出这种方法的大大mac下配置openCV(看看就行,毕竟文章很早了).

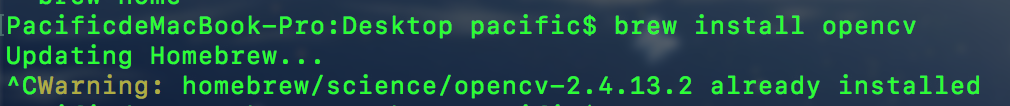

brew install opencv

这里直接执行这个命令可能会报一个小小的错,不过无关紧要,大概意思就是不能直接找到这个命令,终端会自己接着找,然后会告诉你正确的命令应该怎么写,由于当时没有截图,所以具体命令我不记得了,实在抱歉,大家只要稍微有点英语基础,大概看下终端弹出来的描述,就能够知道具体应该执行的命令行了,这里应该是会提示出两个命令,选择关键字是opencv的执行即可,执行后brew会自动下载opencv,上图(因为本人机器上已经安装,所以没有显示安装的过程,不过这个不重要了):

这就是我最后装的OpenCV的版本,这就是为什么我不用最新的版本(因为根本没得选??????),不过大家放心,brew既然选择了这个版本自然有他的理由,读者也不用纠结这个问题,旧一点的版本不一定就不好.

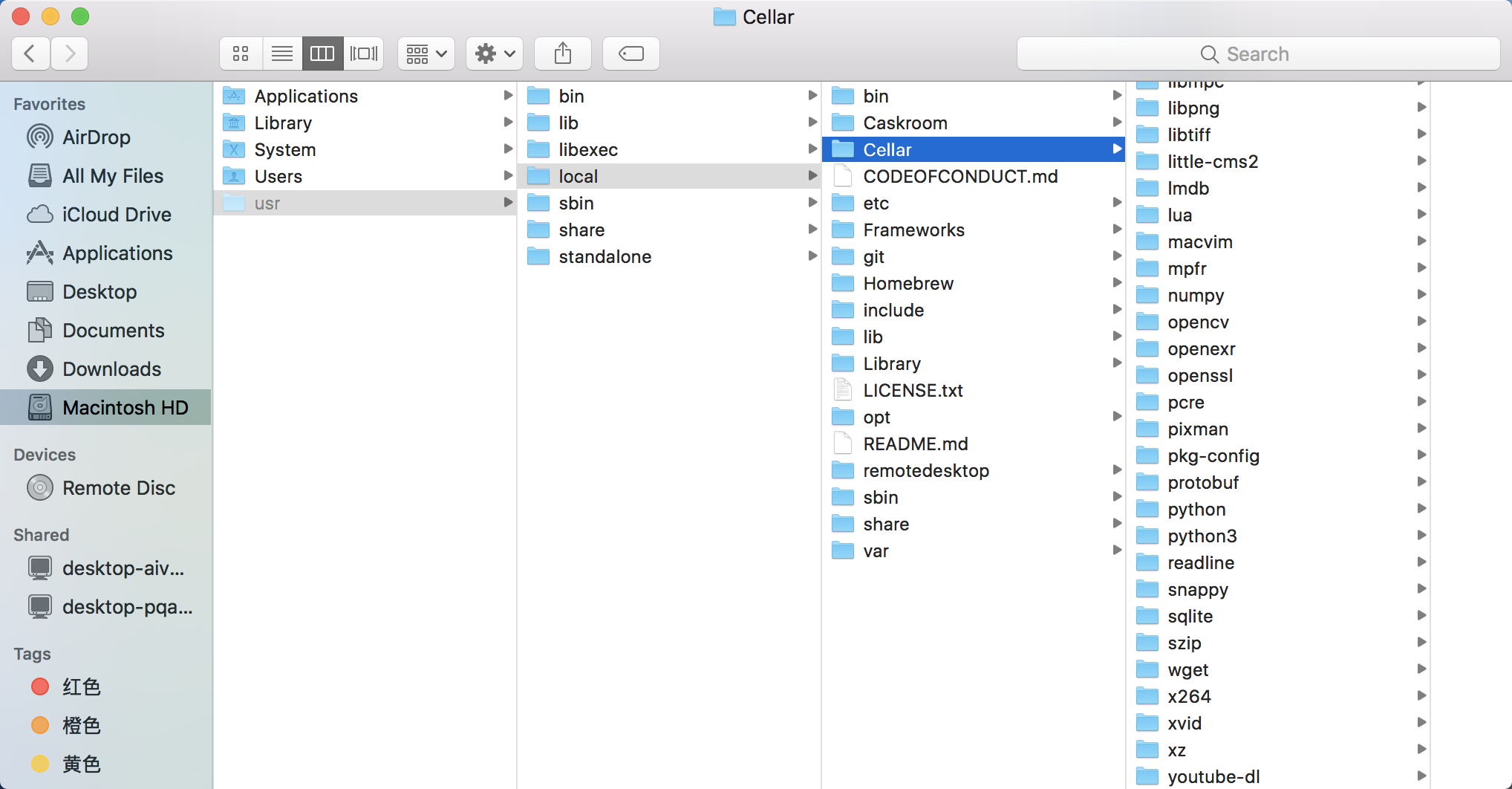

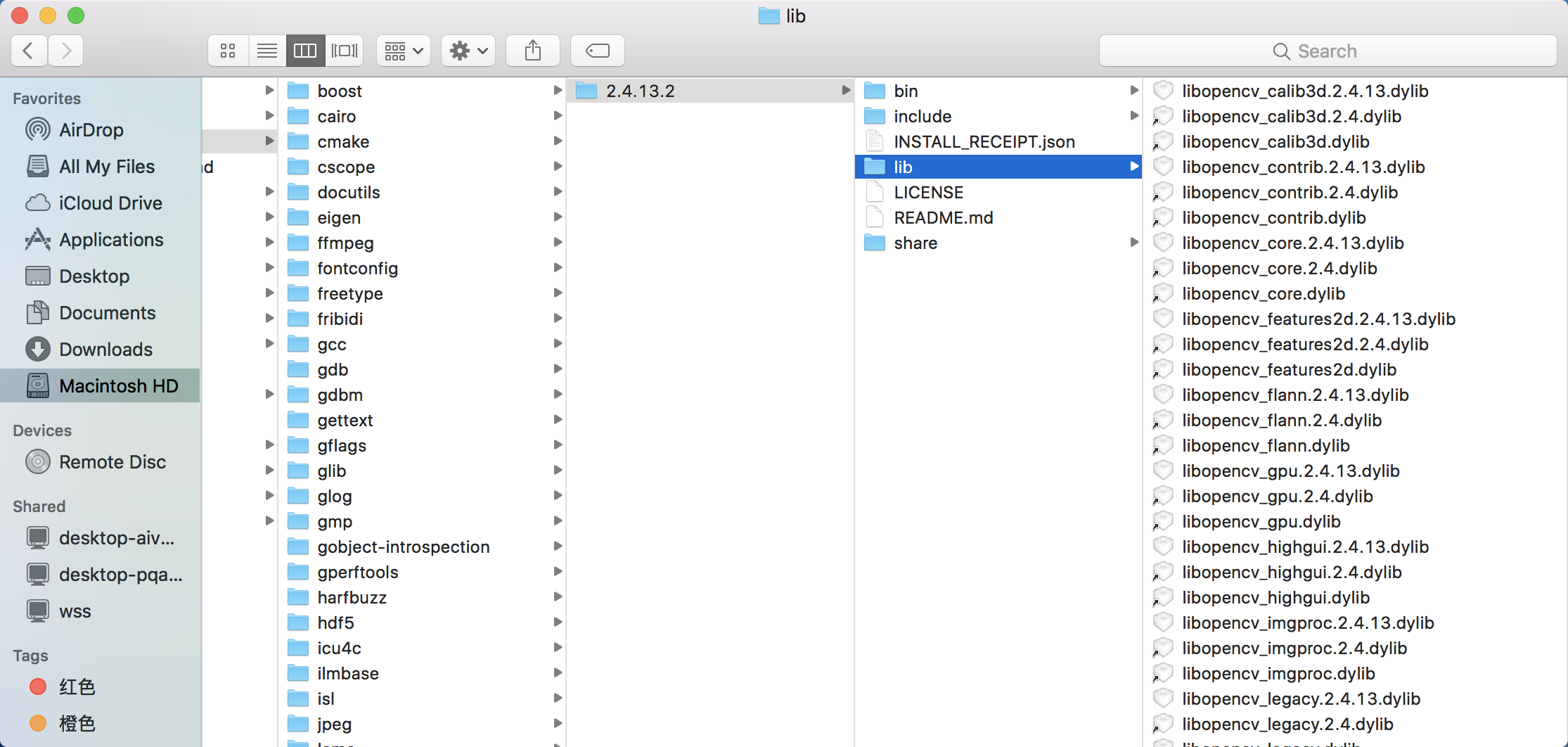

下面是本地的安装目录:

/usr/local/Cellar目录下的文件都是brew帮我们下载好的,里面的cmake,wget,opencv是我们自己下载的,其他的都是brew帮我们下的(应该都是有用的东西,什么都不要我们管,很方便有没有).

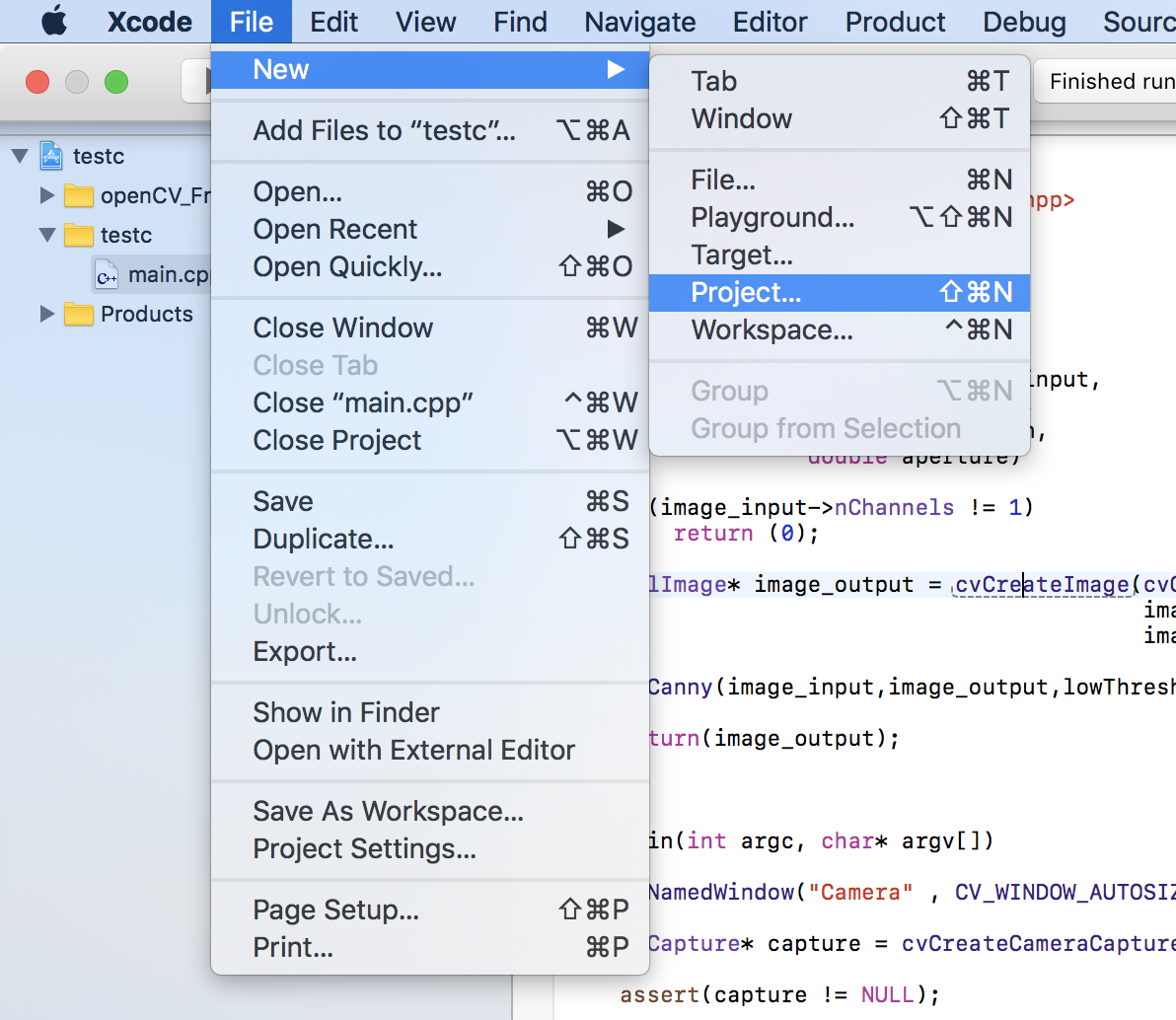

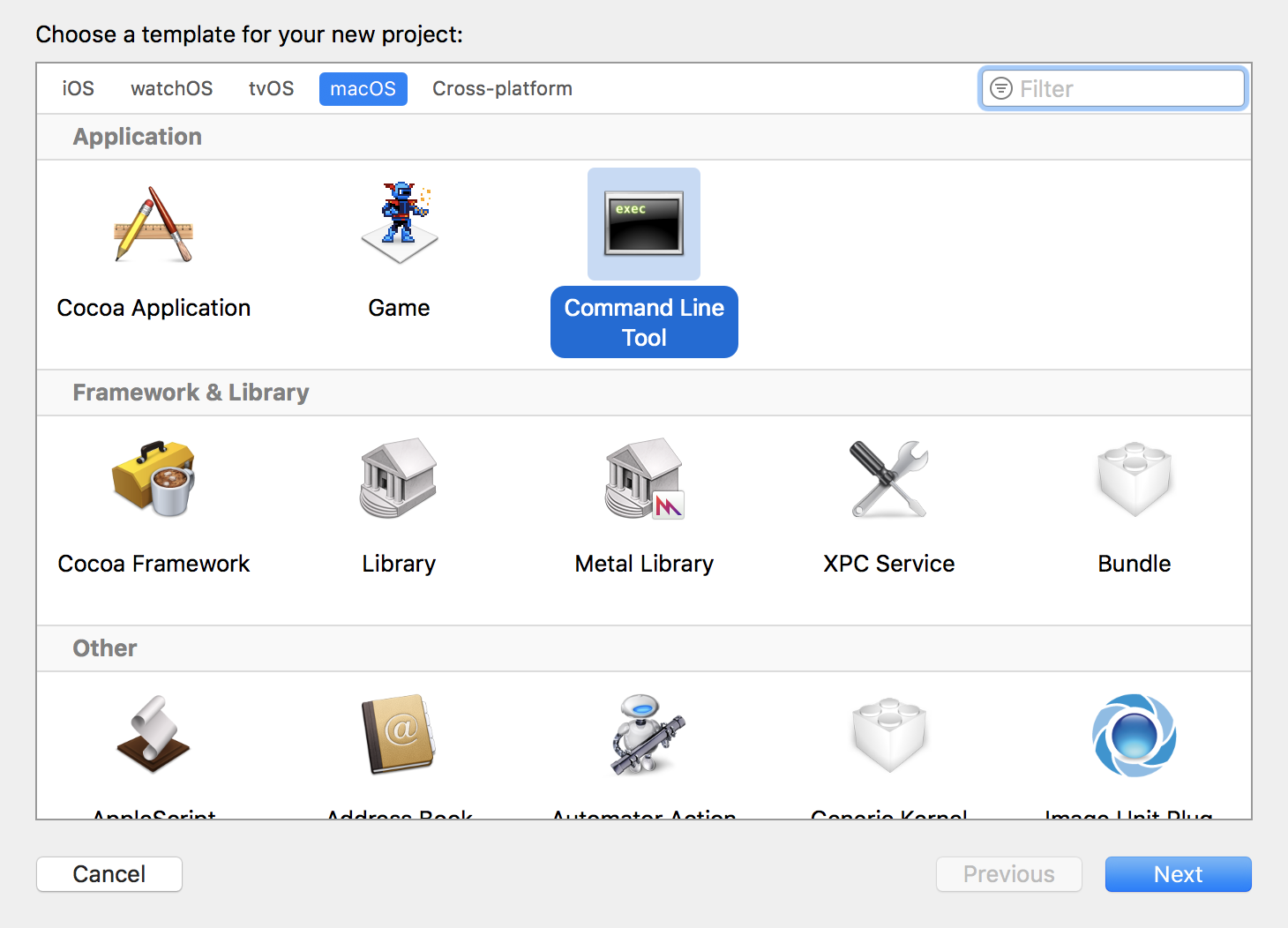

三.在Xcode上配置OpenCV

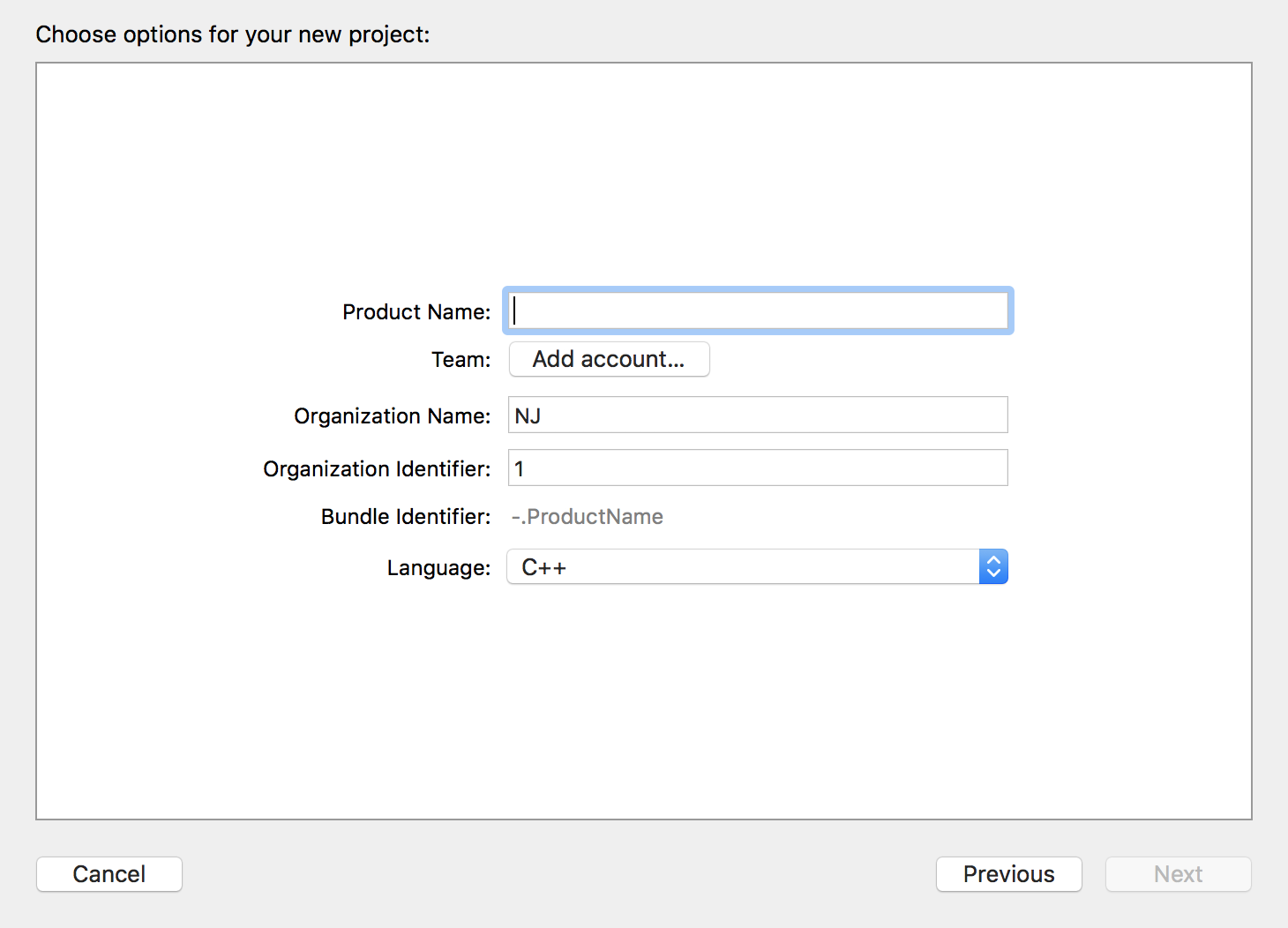

创建一个空的command line 工程:选择OS X -> Application -> Command Line Tool->Next;填写自己的product名,选择语言为C++,选择自己存放的目录。

然后就是opencv的配置了:

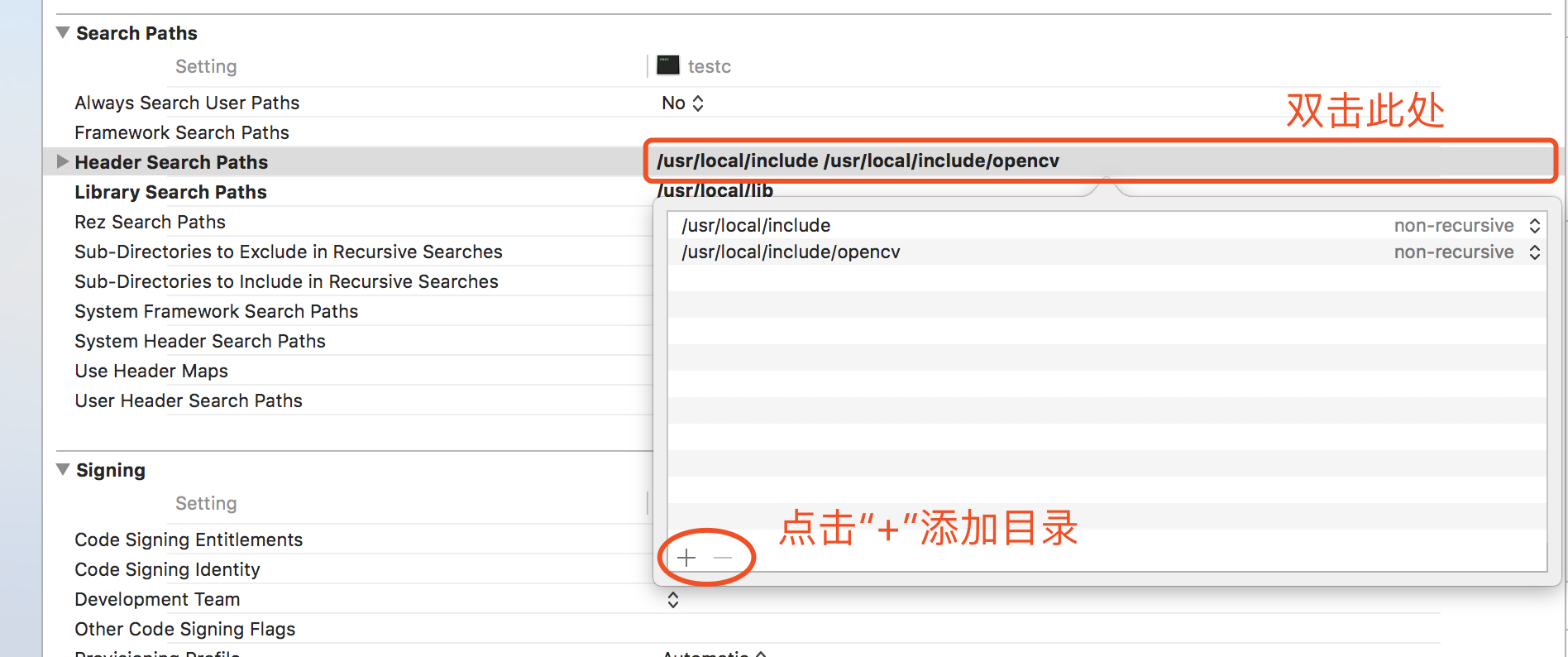

点击工程,选择TARGETS->右侧选择All->Build Settings -> 搜索框输入search paths ->选择search paths下面的Header Search Parhs ->双击后面的详细信息添加指定路径:/usr/local/include (大家可以点击空白桌面按shift+command+g前往该目录下查看,这里目录里有刚才下好的OpenCV库的头文件)

选择search paths下面的Library Search Parhs ->双击添加指定路径:/usr/local/lib (这里包含了所需要的库文件).

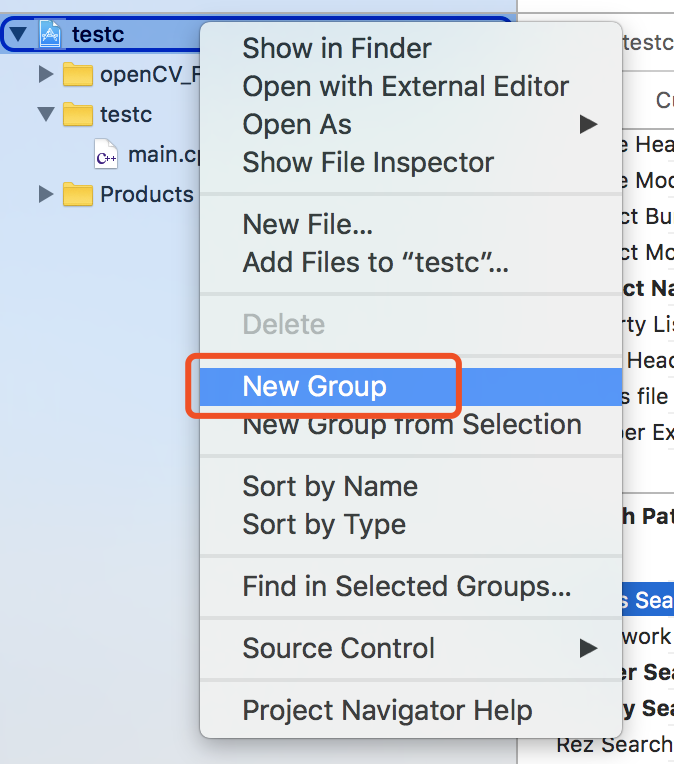

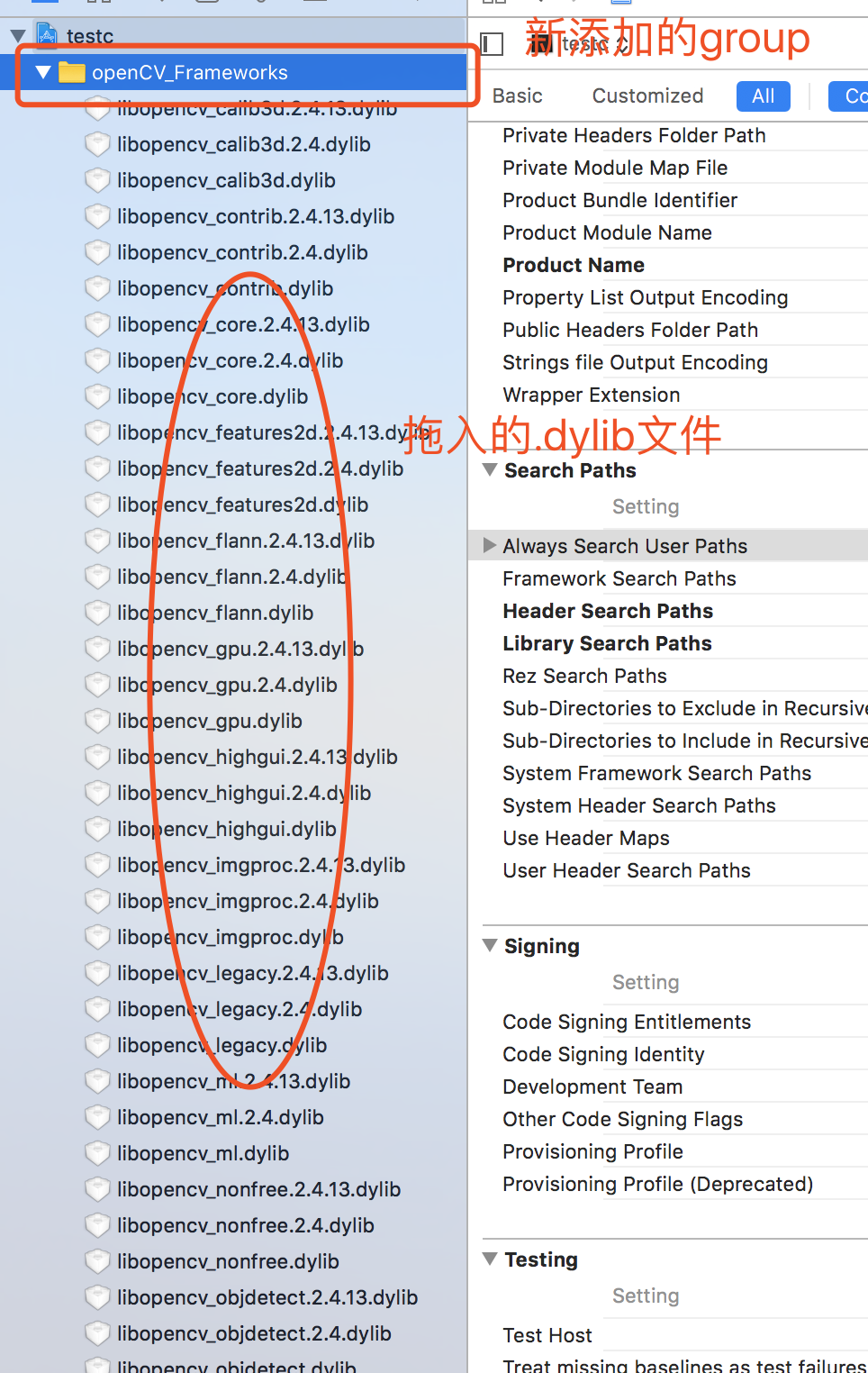

右击工程new一个group,然后打开/usr/local/Cellar/opencv/2.4.13.2/lib目录(同样点击下空白桌面,然后shift+command+g)这个目录之前带大家看过一次就是brew帮我们下载的opencv目录下的lib目录,然后大家按照文件种类排序可以看到一些.dylib文件,将这些.dylib文件拖入刚才新建的文件夹下.我这里是18个文件,网上有说要加所有后缀是dylib文件,其实左下角带箭头的那些不用管.

关于如何进入/usr目录,还有一种方法:双指点击(相当于windows下的右击)finder,然后点击“Go to Folder”,在弹出的搜索框输入/usr,就能进入/usr目录啦。

至此,OpenCV配置大功告成。

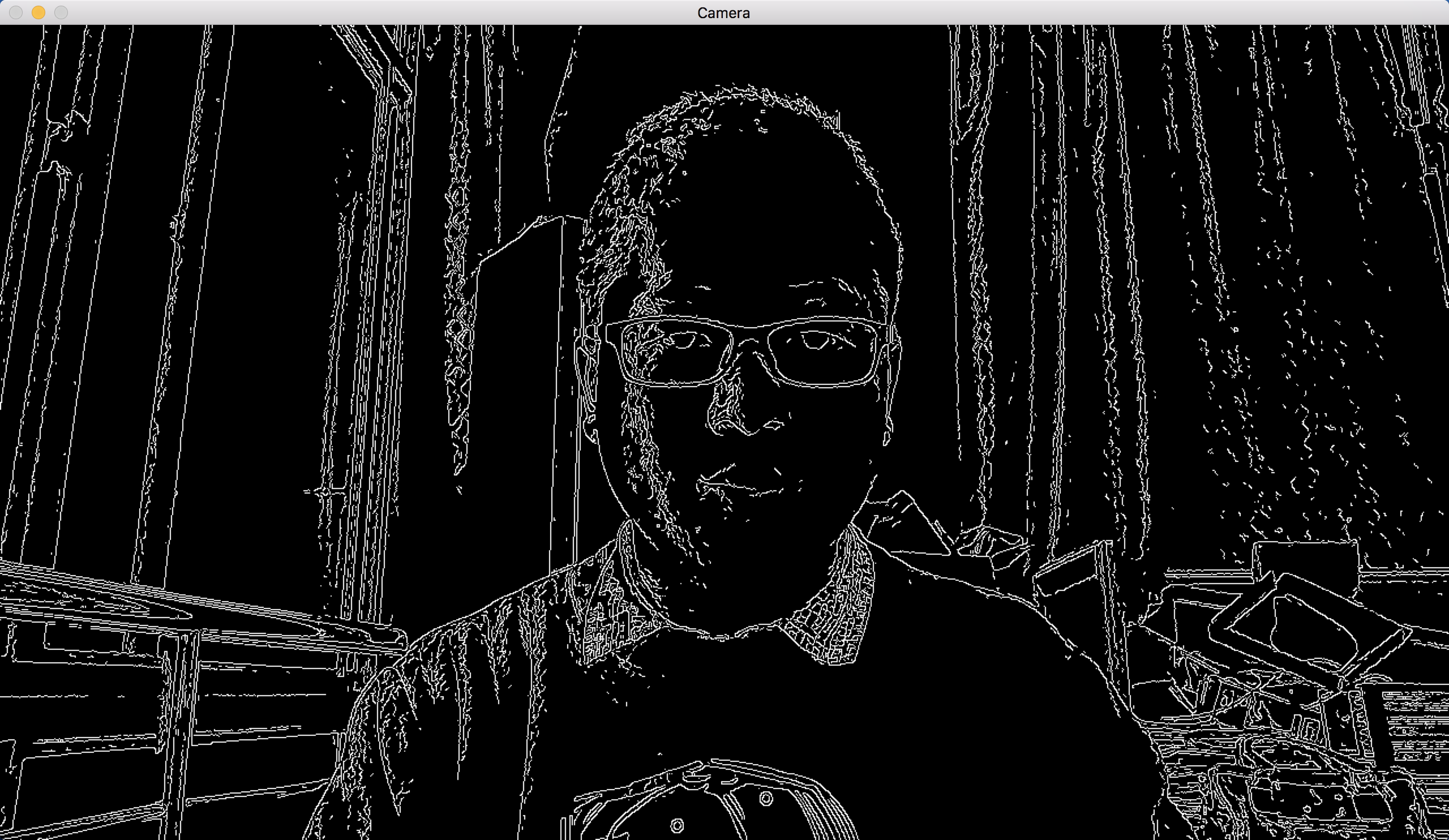

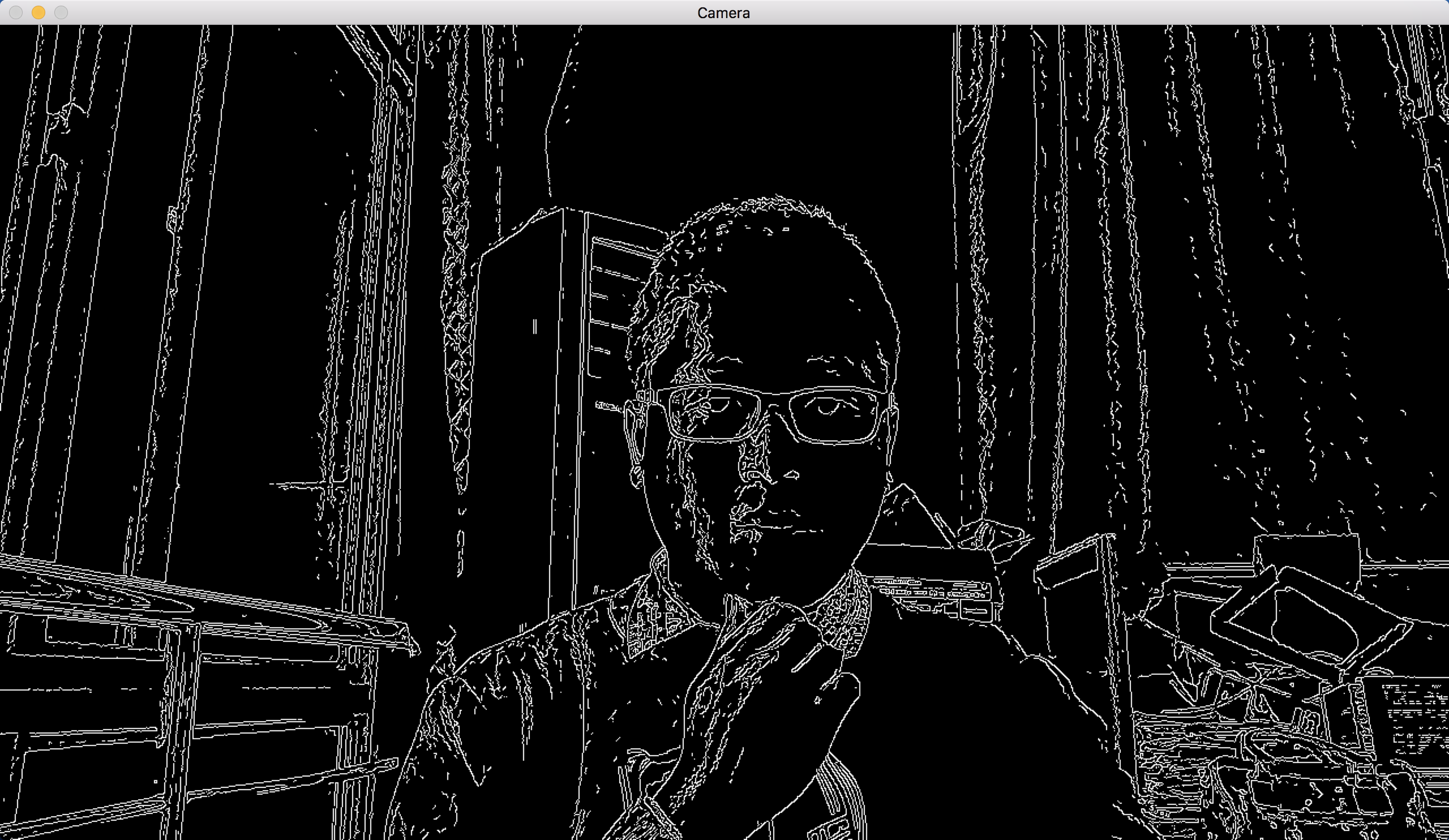

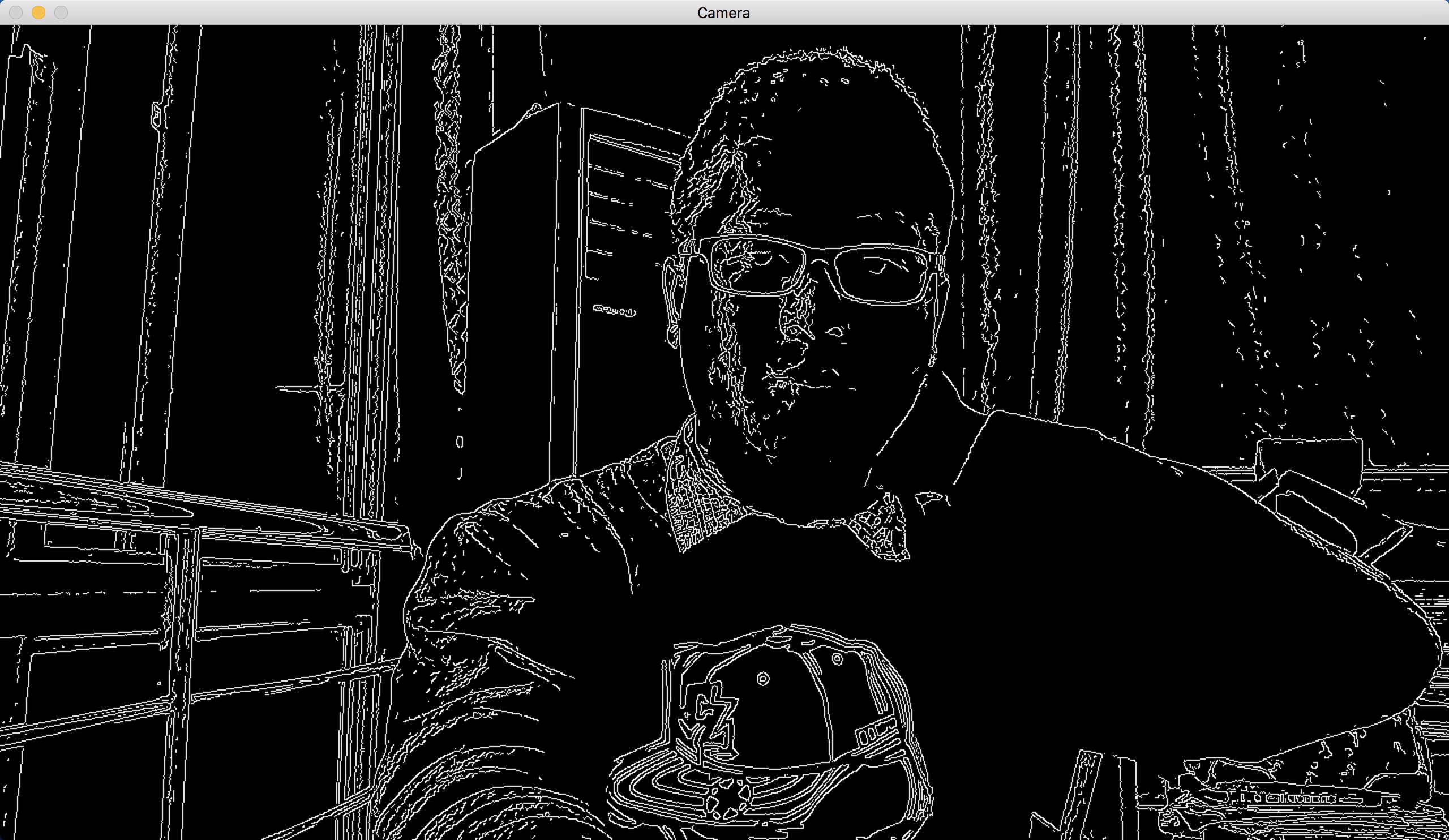

这里献上一段zhoufan大大的测试代码,测试用代码如下所示,从Mac自带的摄像头读入图像,然后canny提取了边缘然后显示。

#include <iostream> #include <opencv2/core/core.hpp> #include <opencv2/highgui/highgui.hpp> #include <opencv2/opencv.hpp> using namespace std; using namespace cv; IplImage* doCanny(IplImage* image_input, double lowThresh, double highThresh, double aperture) { if(image_input->nChannels != 1) return (0); IplImage* image_output = cvCreateImage(cvGetSize(image_input), image_input->depth, image_input->nChannels); cvCanny(image_input,image_output,lowThresh,highThresh,aperture); return(image_output); } int main(int argc, char* argv[]) { cvNamedWindow("Camera" , CV_WINDOW_AUTOSIZE ); CvCapture* capture = cvCreateCameraCapture(CV_CAP_ANY); assert(capture != NULL); IplImage *frame = 0; frame = cvQueryFrame(capture); IplImage *frame_edge = cvCreateImage(cvGetSize(frame), IPL_DEPTH_8U, 1); while(1) { frame = cvQueryFrame(capture); if(!frame) break; cvConvertImage(frame,frame_edge,0); frame = cvCloneImage(frame_edge); frame_edge = doCanny(frame_edge,70,90,3); cvShowImage("Camera",frame_edge); char c = cvWaitKey(15); if(c == 27) break; } cvReleaseCapture(&capture); cvReleaseImage( &frame_edge ); cvReleaseImage( &frame); return (int)0; }

贴几张自己跑出来的测试图:

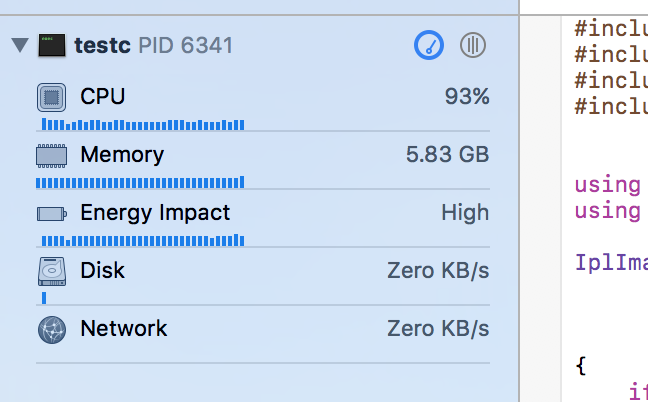

程序运行各项设备利用率:

转自:http://www.cnblogs.com/hongyang/p/6644775.html