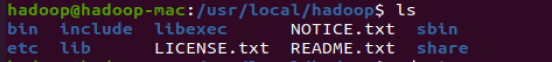

Hadoop的解压缩目录结构

bin: 可执行二进制脚本文件

etc/hadoop目录: hadoop系统配置文件所在目录

hadoop-env.sh 配置环境

core-site.xml 配置hdfs集群核心配置

hdfs-site.xml 用来对hdfs文件系统做配置

sbin 可执行二进制脚本文件

share Hadoop的文档 和运行核心包

========================================================================

承接上文,进行环境配置,

1.配置Hadoop的环境变量,把 JDK与Hadoop两个环境变量都要配置在 etc/profile ,之前配置了JDK ,此步骤补充Hadoop环境变量即可:

1 export JAVA_HOME=/usr/lib/jdk 2 export HADOOP_HOME=/usr/local/hadoop 3 export PATH=${JAVA_HOME}/bin:$PATH:$PATH:$HADOOP_HOME/bim:$HADOOP_HOME/sbin

6. source /etc/profile #重新加载配置

2.配置Hadoop-envenv.sh 配置环境变量即可,因为Hadoop基于Java环境需要配置JDK

1 vim /usr/loacal/hadoop/etc/hadoop/hadoop-env.sh

export JAVA_HOME=/usr/lib/jdk #修改为JDK的路径

3. 配置core-site.xml 配置 用于对hdfs集群的核心配置

1 vim /usr/local/hadoop/etc/hadoop/ 2 3 <!---配置Namenode全局入口----> 4 <configuration> 5 <property> 6 <name>fs.defaultFS</name> 7 <!-- 告诉 NN 在那个机器,NN 使用哪个端口号接收客户端和 DN 的RPC请求--> 8 <value>hdfs://hadoop:9000</value> 9 </property> 10 11 <property> 12 <name>hadoop.tmp.dir</name> 13 <value>/opt/zhw/module/hadoop/data/tmp</value> 14 <description>A base for other temporary directories.</description> 15 </property> 16 </configuration>

4.配置hdfs-site.xml 用来对hdfs文件系统做相关配置

1 <property> 2 <name>dfs.replication</name> 3 <value>1</value> 4 </property> 5 <!----配置block副本数----> 6 7 <property> 8 <name>dfs.namenode.name.dir</name> 9 <value>file:/usr/local/hadoop/tmp/dfs/name</value> 10 </property> 11 <property> 12 <name>dfs.datanode.data.dir</name> 13 <value>file:/usr/local/hadoop/tmp/dfs/data</value> 14 </property> 15 <property> 16 <name>dfs.http.address</name> 17 <value>0.0.0.0:50070</value> 18 </property>

5.配置slaves配置文件按 用来决定那些机器为DataNote节点

加入当前机器主机名:Hadoop

vim slaves

6.格式化NameNode 格式化Hadoop可以识别hdfs文件系统 仅仅第一次需要格式化

1 #在任意目录下执行 2 3 hdfs namenode -format 4 5 #出现这个信息 6 7 INFO common.Storage: Storage directory /usr/local/hadoop/tmp/dfs/name has been successfully formatted.

7.启动hdfs集群

在任意路径

start-dfs.sh

查看成功启动

Hadoop 可以在单节点上以伪分布式的方式运行,Hadoop 进程以分离的 Java 进程来运行,节点既作为 NameNode 也作为 DataNode。同时,读取的是 HDFS 中的文件。Hadoop 的配置文件位于 /usr/local/hadoop-3.2.1/etc/hadoop/ 中,伪分布式需要修改2个配置文件 core-site.xml 和 hdfs-site.xml 。Hadoop的配置文件是 xml 格式,每个配置以声明 property 的 name 和 value 的方式来实现。首先将jdk1.8的路径添(export JAVA_HOME=/usr/lib/jvm/java )加到hadoop-env.sh文件