写在前边:今天是1月11日,放假的第13天,图书馆已经没人了,学校里的人也越来越少,淅沥的小雨挡不住众学子回家的脚步。昨晚,异乡遇故知,聊了一通有的没的。看到彼此变了很多,庆幸也保留了很多。此去经年,愿故人前途坦荡。自从上了大学之后,慢慢脱离了交际,不想与人交流,仿佛一只自缚的茧。可这也给我留下独立思考的时间与空间,灯火辉煌的城市里,那些劳务工人在想什么;街边夜幕下,摆地摊的小商贩又在聊什么。我一直尝试了解一个普通人波涛汹涌的内心世界,以此填充我残缺的魂魄。

1、关于Hash的基本概念

Hash也称散列、哈希,基本 原理是把任意长度的输出,经过Hash算法变成固定长度的输出。这个映射的规则就是Hash算法,而原始数据映射之后的二进制就是哈希值。

Hash的特点:

- 输入域无穷,输出值有限;

- 从hash值不可以反向推出原始数据;

- 输入参数确定,经过hash函数映射出的返回值一样。

- 输入域上的值经过函数值映射后会几乎均等的分布在输出域上;

抽屉原理:桌上有10个苹果,需要把它们放到9个抽屉里,无论如何放,都会有一个抽屉里有不少于两个苹果。这一现象被称为抽屉原理。

由于hash的输入域是无限的,输出域是有限的,所以根据抽屉原理,一定会存在不同的输入被映射到相同输出的情况。

2、HashMap的体系结构

HashMap的基本概念:HashMap是基于哈希表(散列表),实现Map接口的双列集合,数据结构是“链表散列”,也就是数组+链表 ,key唯一的value可以重复,允许存储null 键null值,元素无序。

HashMap的UML图:

图看起来并不复杂,实现了Cloneable接口,实现Seriakizable接口,继承AbstractMap,实现Map接口。

我们已经知道了,HashMap的数据结构是数据存链表,链表的每一个节点称为一个Node,那我们看一下HashMap使用的Node长什么样子:

static class Node<K,V> implements Map.Entry<K,V> {

final int hash;

final K key;

V value;

Node<K,V> next;

解释一下:

-

实现了Entry,Entry实际上就是定义了一组操作hashMap方法的接口;

-

hash:经过哈希算法得到的Key的hash值,实际上还经过扰动;

-

k:就是你要存的数据的key值

-

v:你要存储的值的value

-

next:下一个节点,hash冲突之后链表增长。

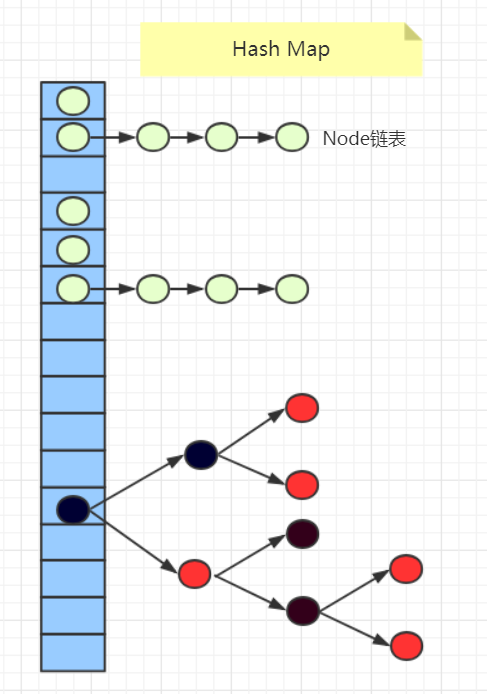

HashMap存储数据的时候就像这样子:

具体情况后边再说,有个稍微概念:<key,Value>中的key经过hash算法得到一个数值,即将该Node存储到数组的相应位置里。如果有多个Node的hashcode相同,那么就形成Node链表。链表过长且数组容量到达阈值后,链表变成红黑树。

3、HashMap的属性分析

查看HashMap的结构信息,找出它的属性值有哪些:

也不多,挑出来分析一下(其实就是翻译了一下官方注释~):

//默认初始大小:16

static final int DEFAULT_INITIAL_CAPACITY = 1 << 4; // aka 16

//最大的容量

static final int MAXIMUM_CAPACITY = 1 << 30;

//默认负载因子

static final float DEFAULT_LOAD_FACTOR = 0.75f;

//树化参数一:链表长度阈值

static final int TREEIFY_THRESHOLD = 8;

//树化参数二:数组此时容量

static final int MIN_TREEIFY_CAPACITY = 64;

//总的说来就是:某一条链长度超过8且数组容量超过64,即树化

//树降级成链表的阈值

static final int UNTREEIFY_THRESHOLD = 6;

//Node数组,它用来构建的散列表

transient Node<K,V>[] table;

//哈希表中的元素的个数

transient int size;

//哈希表的结构修改的次数

transient int modCount;

//负载因子,默认0.75

final float loadFactor;

//扩容阈值:当元素的个数超过此数值时,触发扩容

//计算方法:threshold=capacity * loadFactor

int threshold;

4、HashMap的构造方法分析

也还好,只有四个:

看起来很清晰啊,很容易猜出来各自的作用。

找一个长的分析它:

HashMap(initialCapacity,loadFactor)

这个参数比较多,先来搞它:

public HashMap(int initialCapacity, float loadFactor) {

/************就是一些安全性检验***************************/

if (initialCapacity < 0)

throw new IllegalArgumentException("Illegal initial capacity: " +

initialCapacity);

if (initialCapacity > MAXIMUM_CAPACITY)

initialCapacity = MAXIMUM_CAPACITY;

if (loadFactor <= 0 || Float.isNaN(loadFactor))

throw new IllegalArgumentException("Illegal load factor: " +

loadFactor);

/*****************************************************/

//设置负载因子

this.loadFactor = loadFactor;

//调用了tableSizeFor,点进去看它 :

this.threshold = tableSizeFor(initialCapacity);

}

分析tableSizeFor方法:

//这个方法的作用:

//返回一个大于等于当前cap的一个数字,且为2的次方数

static final int tableSizeFor(int cap) {

//先将传进来的初始值-1赋给n

int n = cap - 1;

//经过一些列计算,算出n的值

n |= n >>> 1;

n |= n >>> 2;

n |= n >>> 4;

n |= n >>> 8;

n |= n >>> 16;

//若不大于默认最大容量,返回n+1

return (n < 0) ? 1 : (n >= MAXIMUM_CAPACITY) ? MAXIMUM_CAPACITY : n + 1;

}

/*

*仔细分析一下它是怎么完成计算的

*假设 cap =10

* n = cap -1 = 9

* 9 = > 0b1001

* 0b1001 | 0b0100 => 0b1101

* 0b1101 | 0b0011 => 0b1111

* 0b1111 | 0b0000 => 0b1111

* 0b1111 | 0b0000 => 0b1111

* n = 0b1111 => 15

* return n+1 ;

*/

到这里,这个方法算是分析完了,主要的工作就是给负载因子赋值,计算数组的容量大小。

5、put<K,V>方法分析

套娃模式,看源代码:

public V put(K key, V value) {

return putVal(hash(key), key, value, false, true);

}

enmmmm,put方法里边调用了putVal方法,传入的参数里有一个hash(key),什么作用呢,找到对应的源码,分析它:

static final int hash(Object key) {

int h;

//key的哈希值 和 它的高16位做异或运算

//高16位的特性加入计算中,使得计算结果更加均匀分散,减少hash碰撞的几率

return (key == null) ? 0 : (h = key.hashCode()) ^ (h >>> 16);

}

ok,可以看到这里就是在计算一个key的经过扰动的hash值并且返回,接下来我们回到putVal()方法继续分析下去。

分析在注释中给出:

final V putVal(int hash, K key, V value, boolean onlyIfAbsent,

boolean evict) {

//tab:当前hashmap的散列表引用

//p:当前散列表的元素

//n: 表示散列数组的长度

//i:路由寻址的结果

Node<K,V>[] tab; Node<K,V> p; int n, i;

//初始化一个散列表:

//也就是说hashmap是在第一次调用put的时候被初始化的

if ((tab = table) == null || (n = tab.length) == 0)

//【resize方法将会详细解释】

n = (tab = resize()).length;

//key的hash值和数组长度-1做与运算,得出node应该存放的位置;

//若tab[i]为空,放入节点 ,此时p被赋值了

if ((p = tab[i = (n - 1) & hash]) == null)

tab[i] = newNode(hash, key, value, null);

//若该tab[i]不为空

else {

//e:临时的node

//k:临时的key

Node<K,V> e; K k;

//判断要存的node的hash 和 key 是否与数组中p的相等

if (p.hash == hash &&

((k = p.key) == key || (key != null && key.equals(k))))

//相同的话,则e指向当前p节点【旧值是要被覆盖的,在最后】

e = p;

//如果不相同,判断tab[i]是否为红黑树

else if (p instanceof TreeNode)

//若是红黑树,遍历此树,具体在putTreeVal中

//树中没有此节点,则加入;

//树中有此节点,则返回原值

e = ((TreeNode<K,V>)p).putTreeVal(this, tab, hash, key, value);

//如果tab[i]存的不是红黑树,那么就是链表

else {

//遍历链表

for (int binCount = 0; ; ++binCount) {

//如果已经遍历到链表的末尾节点,说明当前链表中没有待插入的node

if ((e = p.next) == null) {

//插入元素

p.next = newNode(hash, key, value, null);

//如果链表长度大于8,树化链表

if (binCount >= TREEIFY_THRESHOLD - 1) // -1 for 1st

treeifyBin(tab, hash);

break;

}

//如果链表里有此node,覆盖原值

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

break;

p = e;

}

}

//如果e指向的元素不为null

if (e != null) { // existing mapping for key

//取出此node的原值

V oldValue = e.value;

if (!onlyIfAbsent || oldValue == null)

//用新值替换原值

e.value = value;

afterNodeAccess(e);

//返回原值

return oldValue;

}

}

//表示散列表被修改的次数【增减元素才计数】

++modCount;

//判断是否需要扩容

if (++size > threshold)

resize(); //扩容方法,后续细说

afterNodeInsertion(evict);

return null;

}

至此,我们的put方法就分析结束了,整个流程还是比较清楚明了的。如果还不清楚,可以结合流程图阅读源代码:

6、resize()方法分析

为什么需要扩容呢?上边画了hashmap的存储结构示意图,当我们存储很多元素的时候,容易发生hash冲突。这时候,会形成很长的链表或者很高的红黑树,导致查找元素的效率很低。所以,此时需要对hashmap进行扩容,解决此问题。

分析源代码,分析在注释中给出:

final Node<K,V>[] resize() {

//oldTab:引用扩容之前的数组

Node<K,V>[] oldTab = table;

//oldcap:扩容之前的数组容量

int oldCap = (oldTab == null) ? 0 : oldTab.length;

//oldThr:扩容之前的阈值

int oldThr = threshold;

//扩容之后的数组容量和扩容阈值

int newCap, newThr = 0;

//扩容前数组的长度大于0, 正常扩容

if (oldCap > 0) {

//扩容前的数组长度达到了最大值

if (oldCap >= MAXIMUM_CAPACITY) {

threshold = Integer.MAX_VALUE;

//无法扩容,直接返回

return oldTab;

}

//oldCap左移一位实现容量翻倍,并且赋值给newCap,若newCap的值小于最大值的限制

//且扩容前的容量>=16

else if ((newCap = oldCap << 1) < MAXIMUM_CAPACITY &&

oldCap >= DEFAULT_INITIAL_CAPACITY)

//扩容后的阈值翻倍

newThr = oldThr << 1; // double threshold

}

//扩容前数组为空,且阈值大于0

//什么时候出现这种情况:

//1.new HashMap(initialCapacity,loadFactor)

//2.new HashMap(initialCapacity)

//3.new HashMap(map)

else if (oldThr > 0) // initial capacity was placed in threshold

newCap = oldThr;

//此时oldCap = 0 ,oldThr = 0

else { // zero initial threshold signifies using defaults

//新数组的容量 = 16

newCap = DEFAULT_INITIAL_CAPACITY;

//新数组的阈值 = 负载因子 * 数组容量

newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);

}

//如果新数组的阈值为0:

if (newThr == 0) {

//新的数组的阈值

float ft = (float)newCap * loadFactor;

newThr = (newCap < MAXIMUM_CAPACITY && ft < (float)MAXIMUM_CAPACITY ?

(int)ft : Integer.MAX_VALUE);

}

//将新的扩容阈值,赋值给扩容阈值,下次扩容按照这个计算

threshold = newThr;

//创建一个新的更大的数组

Node<K,V>[] newTab = (Node<K,V>[])new Node[newCap];

//将新的数组赋值给table

table = newTab;

//如果原有的数组不为null

if (oldTab != null) {

//遍历该数组

for (int j = 0; j < oldCap; ++j) {

//e:代表当前数组中的node

Node<K,V> e;

//如果oldTab[j]中有数据,赋值给e

if ((e = oldTab[j]) != null) {

//oldTab[j]置空,方便JVM回收

oldTab[j] = null;

//如果当前节点的没有下一个节点,既不是链表也不是树

if (e.next == null)

//将当前节点加入到新的数组中对应的位置

newTab[e.hash & (newCap - 1)] = e;

//如果当前节点为红黑树

else if (e instanceof TreeNode)

//该操作本篇笔记先不解释

((TreeNode<K,V>)e).split(this, newTab, j, oldCap);

//如果当前节点已经形成链表

else {

//以下完成对一个链表的拆分插入到新数组中的操作

//低位链表:存在新数组的位置与当前位置一致

Node<K,V> loHead = null, loTail = null;

//高位链表:存在新数组的位置= 当前位置 + 扩容后的长度

Node<K,V> hiHead = null, hiTail = null;

Node<K,V> next;

//循环遍历链表

do {

next = e.next;

//当前元素的hash值和oldcap想与运算为0

//也就是当前元素的hash值高一位 为0

if ((e.hash & oldCap) == 0) {

//当前低位链表为空

if (loTail == null)

//放入低位链表中

loHead = e;

//当前低位链表不为空

else

//插入到低位链表末尾

loTail.next = e;

//无论如何,当前元素都是末尾的元素

loTail = e;

}

//当前元素的hash值和oldcap想与运算不为0

//也就是当前元素的hash值高一位为1

else {

//如果此时高位链表为空

if (hiTail == null)

//放入到高位链表中

hiHead = e;

//当前高位链表不为空

else

//插入到高位链表的末尾

hiTail.next = e;

//无论如何,当前元素都是末尾的元素

hiTail = e;

}

} while ((e = next) != null);

//如果低位链表不为空

if (loTail != null) {

//尾元素下一元素置空

loTail.next = null;

//将头元素插入到newTab[j]

newTab[j] = loHead;

}

//如果高位链表不为空

if (hiTail != null) {

//尾元素下一元素置空

hiTail.next = null;

//将头元素插入到newTab[j+oldCap]

newTab[j + oldCap] = hiHead;

}

}

}

}

}

return newTab;

}

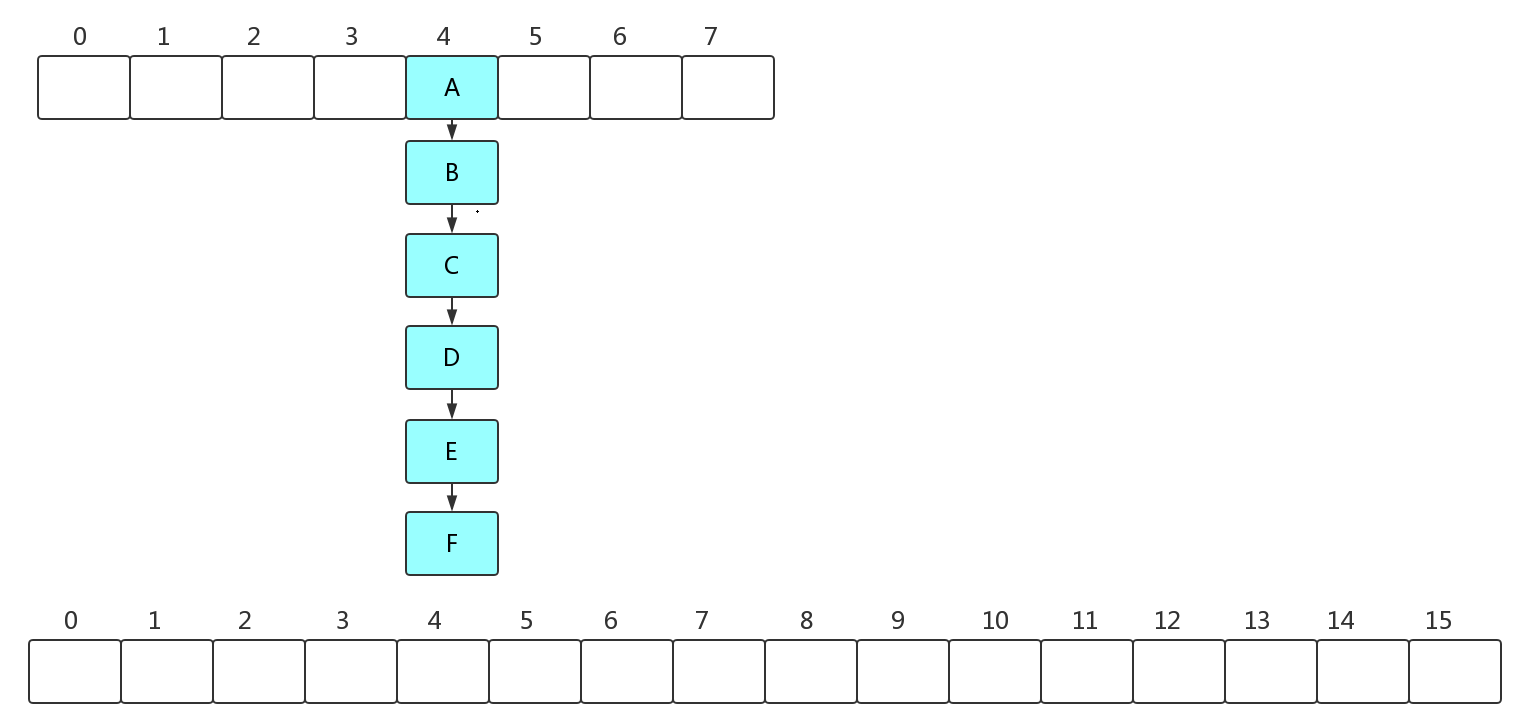

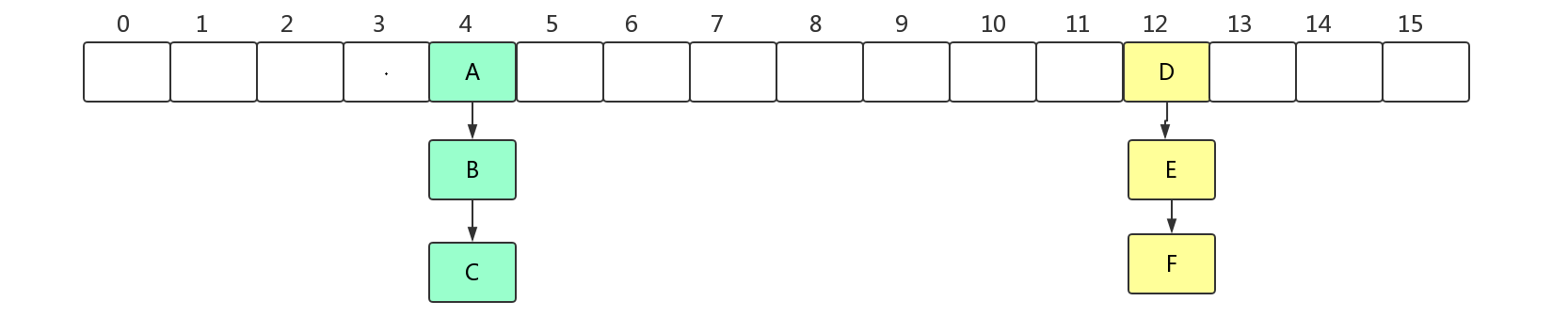

链表怎么拆?为什么要拆?您看图~:

还不明白,我还有图:

7、get(Objectkey)方法分析

根据key获取到元素的值,这一方法我们也经常使用。看源码:

public V get(Object key) {

Node<K,V> e;

return (e = getNode(hash(key), key)) == null ? null : e.value;

}

又是开启了套娃模式,点进去看getNode(hash(key), key)):

final Node<K,V> getNode(int hash, Object key) {

//tab:在下边被赋值,表示当前hashmap的数组

Node<K,V>[] tab;

//first:当前桶位的第一个元素

//e:临时node

//n : 下边被赋值,表示数组的长度

Node<K,V> first, e; int n; K k;

//判断当前数组不为空,并且存储的元素不为null

if ((tab = table) != null && (n = tab.length) > 0 &&

(first = tab[(n - 1) & hash]) != null) {

//查找元素的规则为:先比较key的hash值,再比较key

//当前桶位存储的第一个元素即为要找的元素

if (first.hash == hash && // always check first node

((k = first.key) == key || (key != null && key.equals(k))))

//直接返回

return first;

//如何当前桶位存储的不是单个元素

if ((e = first.next) != null) {

//如果是红黑树

if (first instanceof TreeNode)

//遍历红黑树查找该元素

return ((TreeNode<K,V>)first).getTreeNode(hash, key);

//如果是链表,则遍历链表找到这个元素并返回

do {

if (e.hash == hash &&

((k = e.key) == key || (key != null && key.equals(k))))

return e;

} while ((e = e.next) != null);

}

}

return null;

}

总结起来就是:先比较key的hashcode,如果定位到一个node,就直接返回;如果定位到一串node,

就挨个比较key的值,可以锁定唯一node.