一、准备虚拟环境

1. 虚拟环境网络设置

A、安装VMware软件并安装linux环境,本人安装的是CentOS

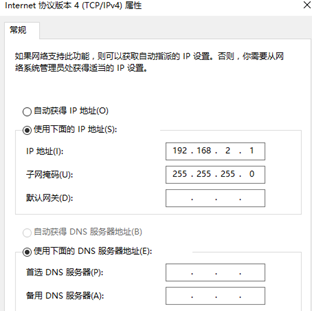

B、安装好虚拟机后,打开网络和共享中心 -> 更改适配器设置 -> 右键VMnet8 -> 属性。设置IPv4,设置如下:

C、在创建好的虚拟机上点击网络设置,选择自定义并设置成“VMnet8(NAT)”如下图所示:

D、修改VMware软件网络设置,设置方式如下所示:

2. 修改主机名

命令:vi /etc/sysconfig/network

将内容修改为

NETWORKING=yes HOSTNAME=hadoop1-2#hostname为主机名,可根据情况修改

3. 修改IP地址

修改配置文件:

vi /etc/sysconfig/network-scripts/ifcfg-eth0

修改其中

IPADDR=192.168.2.110(具体IP地址根据情况修改)

4.防火墙

将防火墙关闭或者将需要对外的端口加到防火墙中,常用的防火墙命令:

#查看防火墙状态 service iptables status #关闭防火墙 service iptables stop #查看防火墙开机启动状态 chkconfig iptables --list #关闭防火墙开机启动 chkconfig iptables off

设置完成后需要重启linux,命令:reboot

5.linux设置无密钥登录

之前对无密钥登录专门做过讲解,有兴趣的同学可以参考:Linux配置SSH免登陆

二、安装JDK

1.上传jdk软件包并解压

创建文件夹:mkdir /home/hadoop/app

解压:tar xf jdk-7u55-linux-i586.tar.gz -C /home/hadoop/app

2.将java添加到环境变量中

vim /etc/profile #在文件最后添加 export JAVA_HOME=/home/hadoop/app/jdk-7u_65-i585 export PATH=$PATH:$JAVA_HOME/bin

3.刷新环境变量配置

source /etc/profile

三、 安装hadoop2.4.1

1、上传安装包并解压

上传hadoop的安装包到服务器上去/home/hadoop/并解压,

解压命令:tar xf hadoop-2.4.1.tar.gz -C /home/hadoop/app/

2、配置hadoop配置文件,伪分布式需要修改5个配置文件

A、hadoop-env.sh,修改JAVA_HOME路径

vim hadoop-env.sh export JAVA_HOME=/usr/java/jdk1.7.0_65

B、core-site.xml

<!-- 指定HADOOP所使用的文件系统URI,NameNode的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.2.170:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/home/hadoop/hadoop-2.4.1/tmp</value>

</property>

C、hdfs-site.xml

<configuration>

<!-- 指定HDFS副本的数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

D、mapred-site.xml

hadoop安装路径中配置文件叫mapred-site.xml.template,需要将其修改成mapred-site.xml。

修改文件名命令:

mv mapred-site.xml.template mapred-site.xml

将配置文件内容修改如下:

<configuration>

<!-- 指定mr框架为yarn方式 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

E、yarn-site.xml

<configuration>

<!-- 指定YARN的ResourceManager地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>192.168.2.170</value>

</property>

<!-- reducer获取数据的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

</configuration>

3、将hadoop添加到环境变量

vim /etc/proflie export JAVA_HOME=/usr/java/jdk1.7.0_65 export HADOOP_HOME=/itcast/hadoop-2.4.1 export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

修改完成之后刷新环境变量配置文件:source /etc/profile

4、初始化namenode

初始化命令:

hdfs namenode -format

5、启动hadoop

#先启动HDFS start-dfs.sh #再启动YARN start-yarn.sh

6、验证是否启动成功

a、使用jps命令验证

5983 Jps 2833 NameNode 3226 ResourceManager 2949 DataNode 3323 NodeManager 3094 SecondaryNameNode

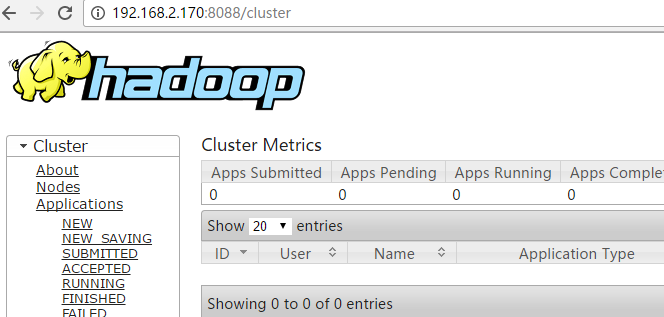

b、登陆管理

HDFS管理界面:http://192.168.2.170:50070

MR管理界面:http://192.168.2.170:8088

c、简单hadoop命令测试

[hadoop@hadoop1-8 hadoop]$ hadoop fs -mkdir /test [hadoop@hadoop1-8 hadoop]$ hadoop fs -ls / Found 1 items drwxr-xr-x - hadoop supergroup 0 2017-04-25 05:52 /test