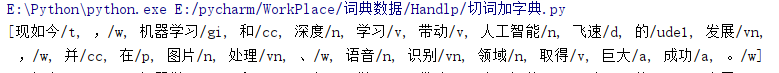

简单分词:

1 from pyhanlp import * 2 content = "现如今,机器学习和深度学习带动人工智能飞速的发展,并在图片处理、语音识别领域取得巨大成功。" 3 Get_value=HanLP.segment(content) 4 print(Get_value)

输出:

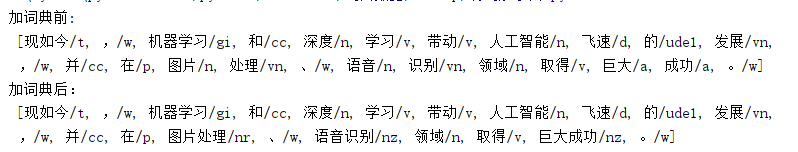

加词典:

1 from pyhanlp import * 2 content = "现如今,机器学习和深度学习带动人工智能飞速的发展,并在图片处理、语音识别领域取得巨大成功。" 3 # insert会覆盖字典中已经存在的词,add会跳过已经存在的词 4 CustomDictionary.add("图片处理", "nr 300") 5 CustomDictionary.insert("语音识别", "nz 1024") 6 CustomDictionary.add("巨大成功", "nz 1024 n 1") 7 8 Get_value=HanLP.segment(content)

输出:

关键字提取:

1 from pyhanlp import * 2 document = "水利部水资源司司长陈明忠9月29日在国务院新闻办举行的新闻发布会上透露," 3 "根据刚刚完成了水资源管理制度的考核,有部分省接近了红线的指标," 4 "有部分省超过红线的指标,对一些超过红线的地方,陈明忠表示,对一些取用水项目进行区域的限批," 5 "严格地进行水资源论证和取水许可的批准。" 6 #关键字 7 print(HanLP.extractKeyword(document, 2))

输出:

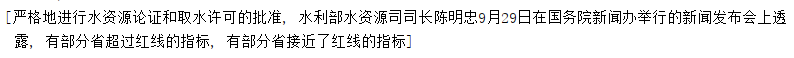

摘要:

1 #摘要 2 print(HanLP.extractSummary(document, 4))

输出:

短语:

1 #短语 2 phrases = HanLP.extractPhrase(document,10) 3 print(phrases)

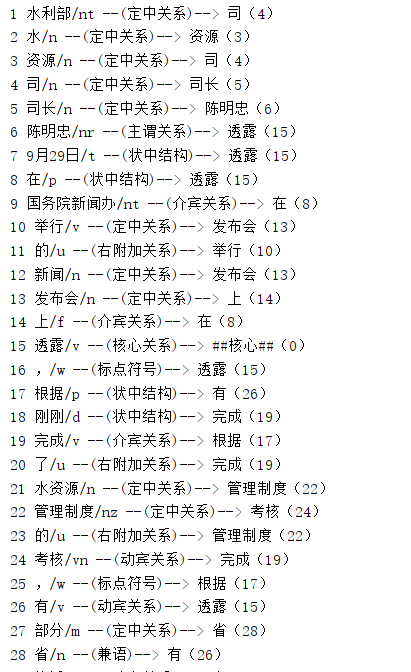

依法依词分析

1 #依法依据分析 2 sentence = HanLP.parseDependency(document) 3 for word in sentence.iterator(): # 通过dir()可以查看sentence的方法 4 print("%d %s/%s --(%s)--> %s(%s)" % (word.ID, word.LEMMA, word.POSTAG, word.DEPREL, word.HEAD.LEMMA, word.HEAD.ID))