网络请求

urlib库

urllib库是python种一个最基本的网络请求库。可以模拟浏览器的行为,向指定的服务器发送一个请求,并可以保存服务器返回的数据。

urlopen函数

在

python3的urlib库中,所有和网络请求相关的方法,都被集到urlib.request模块下面了,先看urlib函数的基本使用

from urllib import request

resp = request.urlopen('http://www.baidu.com')

print(resp.read())

实际上,使用浏览器访问百度,右键查看源代码。会发现跟跟我们刚才打印出来的数据是一摸一样的。也就是说上面三行代码就已经帮我们把百度首页的全部代码爬下来了。一个基本的url请求对应的python非常简单。

- 以下对

urlopen函数进行详细讲解:- url:请求的url

- data:请求的data,如果设置了这个值,那么将变成post请求。

- 返回值:返回值是一个

http.client.HTTPResponse对象,这个对象是一个类文件句柄对象。有read(size)、readline、readlines以及getcode等方法。

urlretrieve函数

这个函数可以方便的将网页上的一个文件保存到本地。以下代码可以将百度首页下载到本地:

from urllib import request

request.urlretrieve('http://www.baidu.com/','baidu.html')

urlencode函数

用浏览器发送请求的时候,如果url中包含了中文或者其他特殊字符,那么浏览器会自动地给我们进行编码。而如果使用代码发送请求,那么就必须手动地进行编码,这时候就应该用

urlencode函数来实现。urlencode可以把字典数据转换为URL编码地数据。示例代码如下:

from urllib import parse

data = {'name':'爬虫基础','greet':'hello world','age':100}

qs = parse.urlencode(data)

print(qs)

parse_qs函数

可以将经过编码后地url参数进行解码

from urllib import parse

qs = "name=%E7%88%AC%E8%99%AB%E5%9F%BA%E7%A1%80&greet=hello+world&age=100"

print(parse.parse_qs(qs))

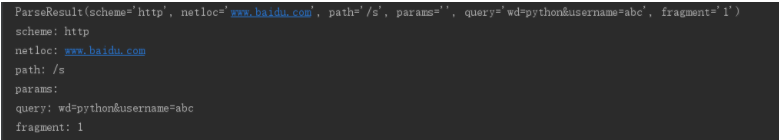

urlparse和urlsplit

有时候拿到一个url,想要对这个url中地各个组成部分进行分割,那么这时候就可以使用

urlparse或者是urlsplit来进行分割。

from urllib import request,parse

url = 'http://www.baidu.com/s?username=zhiliao'

result = parse.urlsplit(url)

# result = parse.urlparse(url)

print('scheme:',result.scheme)

print('netloc:',result.netloc)

print('path:',result.path)

print('query:',result.query)

urlparse 和urlsplit基本上是一摸一样地。唯一不一样的地方是,urlsprse里面多了一个params属性,而urlsplit没有这个params属性 。比如有一个url为url="http://www.baidu.com/s;hello?wd=python&username=abc#1"那么urlparse可以获取到hello,而urlsplit不可以获取到。url中的parms也用得比较少。

request.Request类

如果想要在请求的时候增加一些请求头,那么就必须使用request.Request类来实现。比如要增加一个User-Agent

from urllib import request

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.94 Safari/537.36'

}

req = request.Request("http://www.baidu.com/",headers=headers)

resp = request.urlopen(req)

print(resp.read())

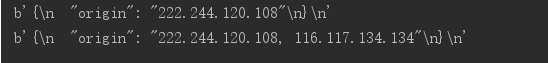

ProxyHandler处理器(代理设置)

很多网站会检测某一段时间某个IP访问次数(通过流量统计,系统日志等),如果访问次数多的不像正常人,它会禁止这个IP的访问。所以我们可以设置一些代理服务器,每隔一段时间换一个代理,就算IP被禁止,依然可以换个IP继续爬取。urlib中通过ProxyHandler来设置使用代理服务器,下面代码说明如何使用自定义opener来使用代理。

from urllib import request

# 没有使用代理 b'{

"origin": "222.244.120.108"

}

'

url = "http://httpbin.org/ip"

resp = request.urlopen(url)

print(resp.read())

# 使用代理的

# 1.使用ProxyHandler,传入代理构建一个handler

handler = request.ProxyHandler({"http":"116.117.134.134:8828"})

# 2.使用上面创建的handler构建一个opener

opener = request.build_opener(handler)

# 3.使用opener去发送一个请求

resp2 = opener.open(url)

print(resp2.read())

- 常用的代理有:

- 西刺免费代理IP:http://www.xicidaili.com/

- 快代理:http://www.kuaidaili.com/

- 代理云:http://www.dailiyun.com/

Cookie

在网站中,http请求是无状态的。也就是说及时第一次和服务器连接后并且登录成功后第二次请求服务器依然不能知道请求是哪个用户。cookie的出现就是为了解决这个问题,第一次登录后服务器返回一些数据(cookie)给浏览器,然后浏览器保存到本地,当该用户发送第二次请求的时候,就会自动的把上次请求存储的cookie数据自动的携带给服务器,服务器通过浏览器携带的数据就能判断当前用户是哪个了。cookie存储的数据量有限,不同浏览器有不同的存储大小,但一般不超过4KB。因此使用cookie只能存储一些小量的数据。

- cookie的格式:

Set-Cookie: NAME=VALUE;Expires/Max-age=DATE;Path=PATH;Domain=DOMAIN_NAME;SECURE

参数意义:

- NAME:cookie的名字

- VALUE: cookie的值

- Expries: cookie的过期时间

- Path:cookie作用的路径

- Domain:cookie作用的域名

- SECURE:是否只在https协议下起作用

cookielib库和HTTPCoolieProcessort模拟登录

Cookie是指网站服务器为了辨别用户身份和进行Session跟踪,而存储在用户浏览器上的文本文件,Cookie可以保持登录信息到下次与服务器的会话。

这里以人人网为例。人人网中,要访问某个人的主页,必须先登录才能访问,登录说白了就是要有cookie信息。那么如果我们想要用代码的方式访问,就必须要有正确的cookie信息才能访问。解决方案有两种,第一种是使用浏览器访问,然后将cookie信息赋值下来,放到headers中。

# 人人网主页:http://www.renren.com/PLogin.do

# 大鹏主页:http://www.renren.com/880151247/profile

from urllib import request

dapeng_rul = "http://www.renren.com/880151247/profile"

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.90 Safari/537.36 Edg/89.0.774.57",

"Cookie":"anonymid=kmjvor90-d7q0dw; depovince=HUN; _r01_=1; ick_login=5e5baa5a-22df-4989-9c29-ba48d1d64de0; taihe_bi_sdk_uid=647283d7a8821c3ae3d59b8ffb2b857d; taihe_bi_sdk_session=2a4f9ab973e8dd89e54ac9e469605d9c; jebecookies=caea16eb-a8c1-47f0-992e-a389d9ca151b|||||; _de=B8DB26BB44C501002048CD4C665EB8D1; p=44ec58044d52da6440e47f907c86e09a7; first_login_flag=1; ln_uact=13657325813; ln_hurl=http://head.xiaonei.com/photos/0/0/men_main.gif; t=48b4100094309965ae60e00279a8ba867; societyguester=48b4100094309965ae60e00279a8ba867; id=972850007; xnsid=a8903876; ver=7.0; loginfrom=null; wp_fold=0"

}

req = request.Request(url=dapeng_rul, headers=headers)

resp = request.urlopen(req)

with open("renren.html", "w",encoding="utf-8") as fp:

# write函数必须写一个str类型

# resp.read()读出来的是一个bytes数据类型

# bytes > decode >str

# str > encode> bytes

fp.write(resp.read().decode('utf-8'))

但是每次在访问需要cookie的页面都要从浏览器中赋值cookie比较麻烦。在Python处理Cookie,一般是通过http.cookiejar模块的HTTPCookieProcessor处理器类一起使用。http.cookiejar模块主要作用是提供用于存储cookie的对象。而HTTPCookieProcessor处理器主要作用是处理这些cookie对象,并构建hanlder对象。

http.cookiejar模块

该模块主要的类有CookieJar、FileCookieJar、MozillaCookieJar、LWPCookieJar。这四个类的作用分别如下:

-

CookieJar:管理HTTP cookie值、存储HTTP请求生成的cookie、向传出的HTTP请求添加cookie的对象。整个cookie都存储在内存中,对CookieJar实例进行垃圾回收后cookie也将丢失。

-

FileCookieJar(filename,delayload=None,policy=None):从CookieJar派生而来,用来创建FileCookieJar实例,检索cookie信息并将cookie存储到文件中。filename是存储cookie的文件名。delayload为True时支持延迟访问文件,即只有在需要时才读取文件或在文件中存储数据。

-

MozillaCookieJar(filename,delayload=None,policy=None):从FileCookieJar派生而来,创建与Mozilla浏览器cookies.txt兼容的FileCookieJar实例。

-

LWPCookieJar(filename,delayload=None,policy=None):从FileCookieJar派生而来,创建于libwww-perl标准的Set-Cookie3文件格式兼容的FileCookieJar实例。

登录人人网

# 人人网登录页:http://www.renren.com/PLogin.do

# 大鹏主页:http://www.renren.com/880151247/profile

from urllib import request

from http.cookiejar import CookieJar

from urllib import parse

headers = {

"User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/89.0.4389.90 Safari/537.36 Edg/89.0.774.57"

}

def get_opener():

# 1.登录

# 1.1 创建一个cookiejar对象

cookiejar = CookieJar()

# 1.2 使用cookiejar创建一个HTTPCookieProcess对象

handler = request.HTTPCookieProcessor(cookiejar)

# 1.3 使用上一步创建的handler创建一个opener

opener = request.build_opener(handler)

return opener

def login_renren(opener):

# 1.4 使用opener发送登录的请求(人人网的邮箱和密码)

data = {

'email': '1365732****',

'password': '158372****'

}

login_url = "http://www.renren.com/PLogin.do"

req = request.Request(login_url, data=parse.urlencode(data).encode('utf-8'), headers=headers)

opener.open(req)

def visit_profile(opener):

# 2.访问个人主页

dapeng_url = "http://www.renren.com/880151247/profile"

# 获取个人主页的页面的时候,不要新建一个opener

# 而因该使用之前的那个opener,因为之前那个opener已经包含了登录所需要的cookie信息

req = request.Request(dapeng_url,headers=headers)

resp = opener.open(req)

with open('renren-dapeng.html', 'w', encoding='utf-8') as fp:

fp.write(resp.read().decode('utf-8'))

if __name__ == '__main__':

opener = get_opener()

login_renren(opener)

visit_profile(opener)

保存cookie到本地

保存cookie到本地,可以使用cookiejar的save方法,并且需要指定一个文件名

from urllib import request

from http.cookiejar import MozillaCookieJar

cookiejar = MozillaCookieJar("cookie.txt")

handler = request.HTTPCookieProcessor(cookiejar)

opener = request.build_opener(handler)

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.94 Safari/537.36'

}

req = request.Request('http://httpbin.org/cookies',headers=headers)

resp = opener.open(req)

print(resp.read())

cookiejar.save(ignore_discard=True,ignore_expires=True)

从本地加载cookie

from urllib import request

from http.cookiejar import MozillaCookieJar

cookiejar = MozillaCookieJar("cookie.txt")

cookiejar.load(ignore_expires=True,ignore_discard=True)

handler = request.HTTPCookieProcessor(cookiejar)

opener = request.build_opener(handler)

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/62.0.3202.94 Safari/537.36'

}

req = request.Request('http://httpbin.org/cookies',headers=headers)

resp = opener.open(req)

print(resp.read())