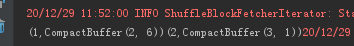

spark的groupByKey算子结果按key进行分组,生成了一组CompactBuffer结构的数据。CompactBuffer并不是scala里定义的数据结构,而是spark里的数据结构,它继承自一个迭代器和序列,所以它的返回值是一个很容易进行循环遍历的集合

val spark = SparkSession.builder().master("local").getOrCreate()

val data=spark.sparkContext.parallelize(List((1,2),(2,3),(1,6),(2,1)))

data.groupByKey().foreach(print)