1 算法的优缺点

1.1 优点

在DQN算法中,神经网络输出的是动作的q值,这对于一个agent拥有少数的离散的动作还是可以的。但是如果某个agent的动作是连续的,这无疑对DQN算法是一个巨大的挑战,为了解决这个问题,前辈们将基于值的方法改成了基于策略的方法,即输出动作的概率。

1.2 缺点

策略梯度算法应用未来损失的return作为更新迭代的依据,即在一个回合过后,在这一回合中,若执行的某一动作的动作价值R大,则会加在下一回合选择这一动作的概率,反之,若执行的某一动作的动作价值R小,则会在下一回合选择这一动作的概率减小。因此,要想用return做为预测动作概率的神经网络更新的依据,就必须先拥有一个决策链,才能将return计算出来,因此每一个更新是在一个回合结束后才能更新一个。更新的速率比较慢

2 算法的流程

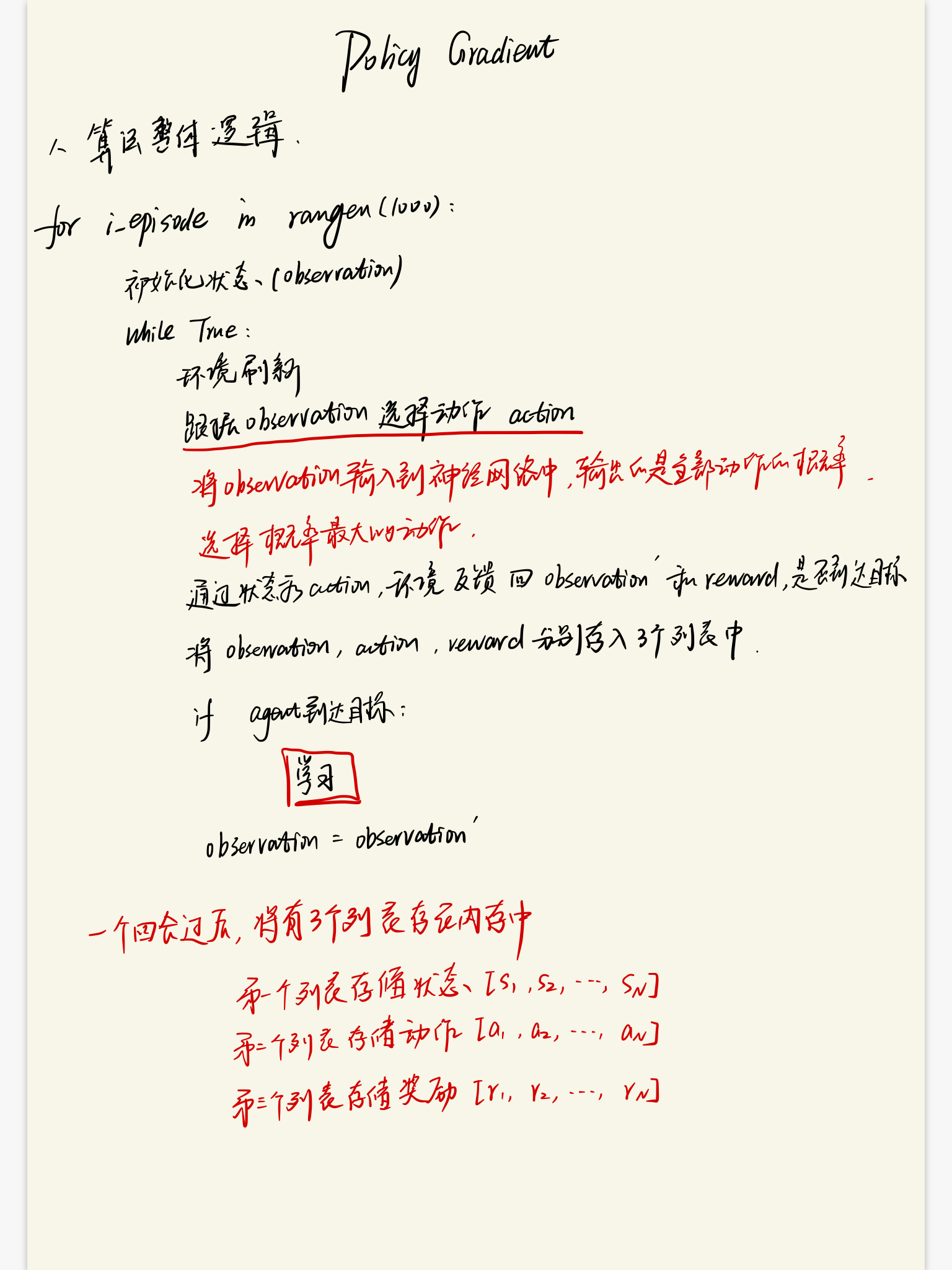

2.1 算法的整体逻辑

2.2 算法的更新逻辑