Hadoop综合大作业 要求:

1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

在网上下载一个哈利波特的英文小说,在虚拟机打开百度网盘的文件,然后下载到本地。

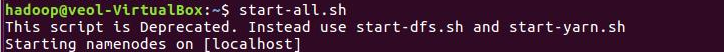

首先要启动dfs:

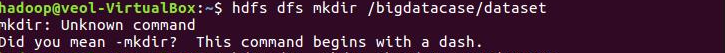

在hdfs上创建文件夹:

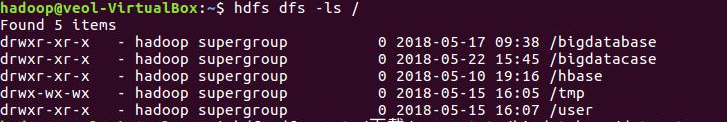

查看hdfs上的所有文件:

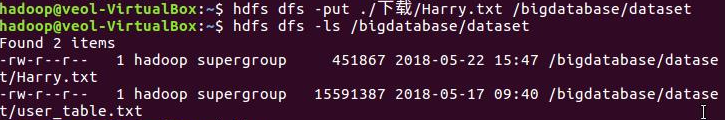

把下载的文件上传到hdfs:

启动hive:

创建表:

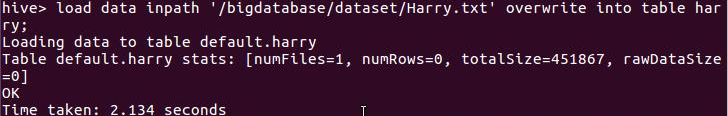

把hdsf上的文件内容添加进去表里:

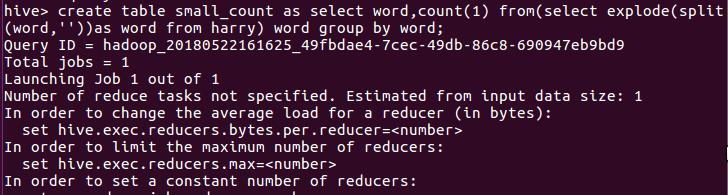

创建一个新的表存放词频统计:

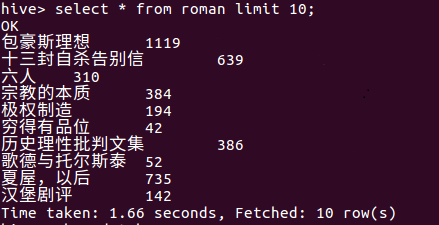

查找表的前十条记录:

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

将爬虫作业产生的文件转为txt格式的文件,上传至百度云盘,然后再虚拟机下载操作。

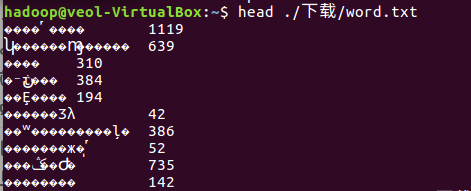

下载下来的txt文件显示前十条:

发现乱码:

出现这种情况的原因为两种操作系统的中文压缩方式不同,在windows环境中中文压缩一般为gbk,而在linux环境中为utf8,这就导致了在windows下能正常显示而在linux环境下打开呈现了乱码状态。

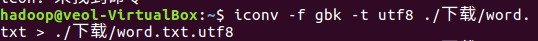

所以我们需要输入命令,转换格式:

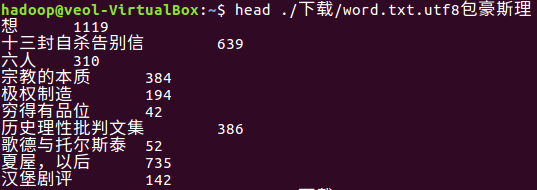

再输入命令查看:

正常显示中文后,把原文件删除,然后重命名文件为word.txt。

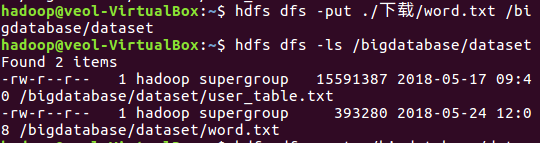

继续操作,把文件上传至hdfs,并查看:

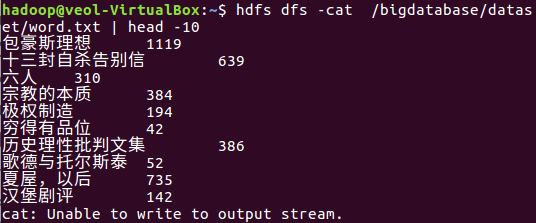

查看前十条:

启动hive:

创建数据库:

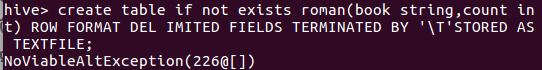

把数据加载进去:

查看前十条: