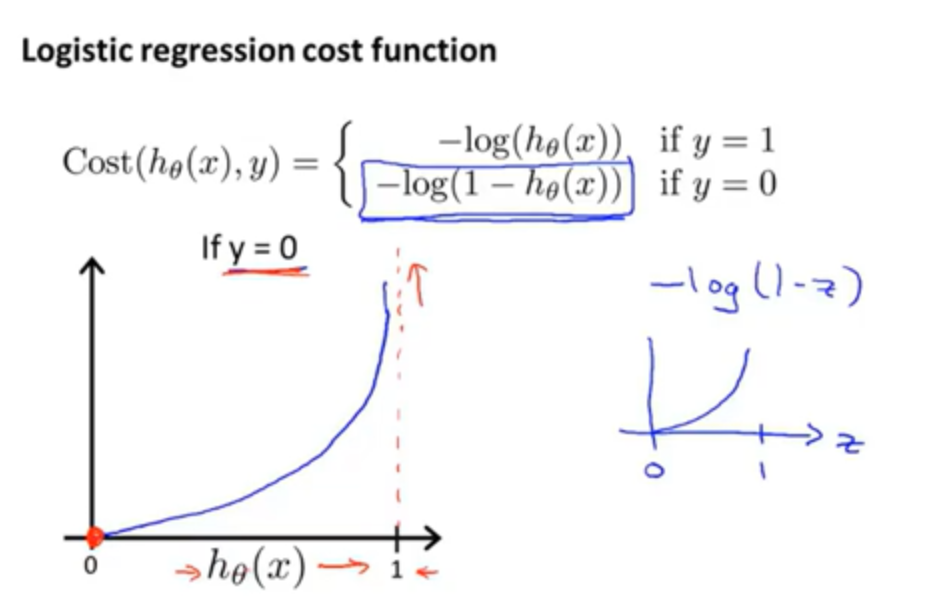

一、logistic 回归的代价函数:

1、y = 1

图像左侧无穷大的通俗解释:假设我们预测y = 1 的概率为0,但如果y确实等于1,那么我们会用非常大的代价值来惩罚这个学习函数。

2、y = 0

图像右侧无穷大的通俗解释:如果最后y = 0,而我们几乎非常肯定的预测y = 1的概率等于1,那么我们就要为此付出非常大的代价值

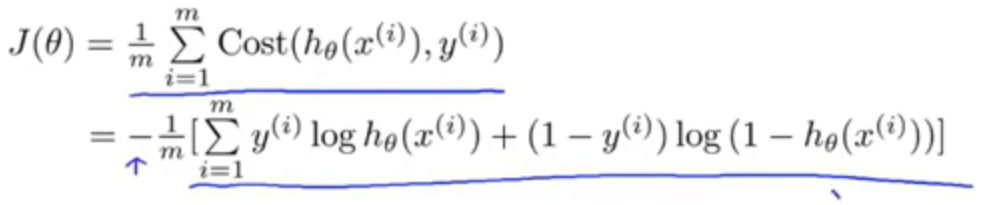

二、简化代价函数与梯度下降

logistic回归的代价函数:

代价函数J等于: 1/m乘以对应不同标签的yi的各个训练样本在预测时付出的代价之和

将代价函数简化为一个式子,我们可以得到:

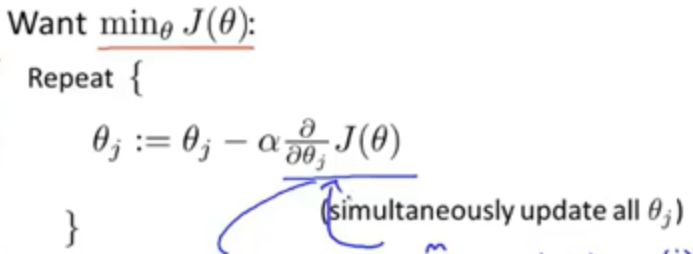

我们使用梯度下降法求使得J最小的参数θ,思路如下

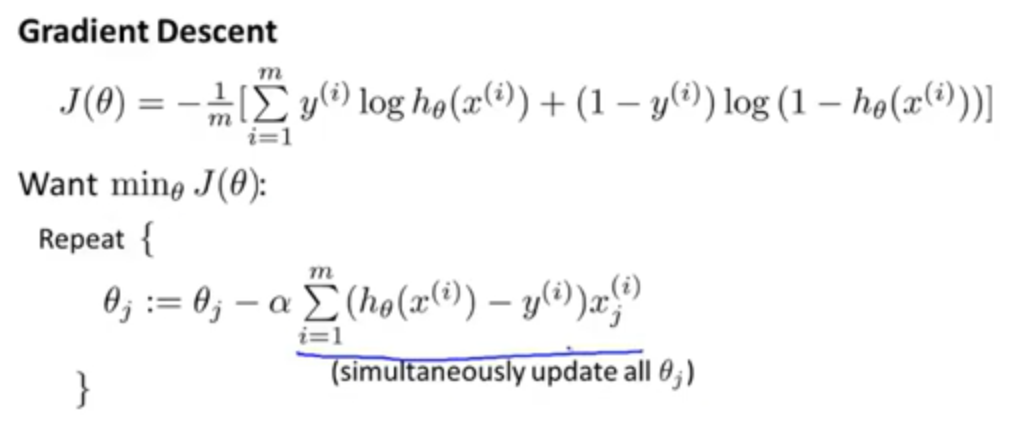

求得式中的偏导项为 ![]() ,回带到上述梯度下降法,得到

,回带到上述梯度下降法,得到

完整的梯度下降法如下:

注意:虽然logistic回归梯度下降算法和线性回归梯度下降算法的式子相同,但假设函数hθ(x)是不一样的