Multi-Context Attention for Human Pose Estimation

abstract

在本文中,我们提出将卷积神经网络与多上下文注意机制结合到一个端到端人体姿态估计框架中。我们采用堆叠的hourglass网络,以不同语义的多分辨率特征生成注意力maps。利用条件随机场(CRF)模型对注意图中相邻区域之间的相关性进行建模。我们进一步将注重整个人体全局一致性的整体注意模型和注重对不同身体部位的详细描述的身体部位注意模型相结合。因此,我们的模型能够关注从局部显著区域到全局语义一致空间的不同粒度。此外,我们设计了新的hourglass残差单元(Hourglass Residual Units, HRUs),以增加网络的接收域。这些单元是残差单元的扩展,带有带有更大接收域的滤波器的侧分支,因此具有不同尺度的特征在HRUs中被学习和组合。在两个广泛使用的人体姿态估计基准上,评估了所提出的多上下文注意机制和hourglass残差单元的有效性。在两个基准上,对于所有身体部位,我们的方法优于所有现有的方法。

1. Introduction

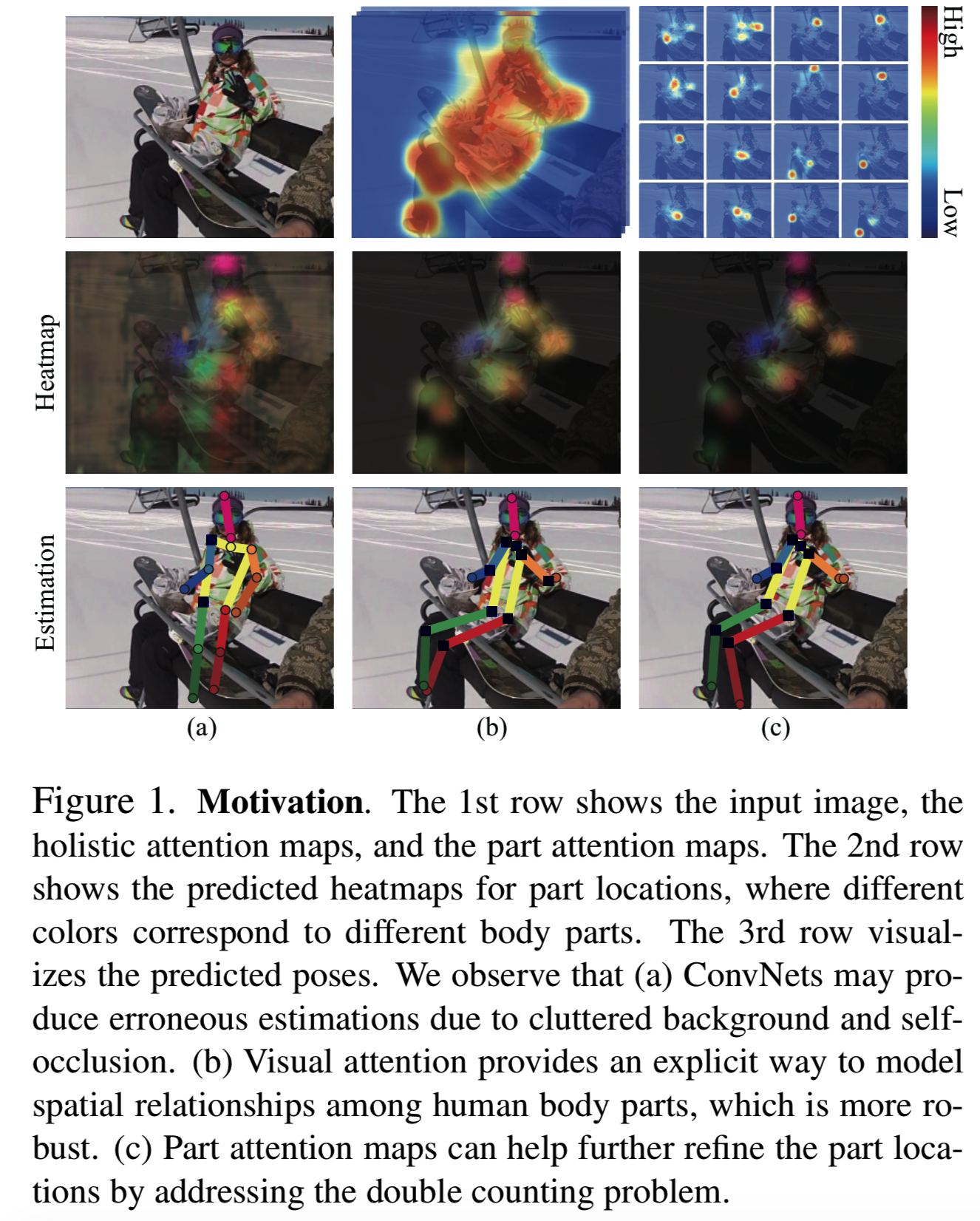

人体姿态估计在计算机视觉中是一项具有挑战性的任务,因为人体肢体的关节性、自遮挡性、各种服装和透视性。卷积神经网络(ConvNets)已经取得了显著的改进[38,39,9,40,37,29]。然而,对于有着类似于身体部位或四肢对象的杂乱背景,或身体部分被严重遮挡,ConvNets在正确定位每一个身体部位时会有困难,可见图1 (a)。在文献中,多个上下文信息的组合被证明在视觉任务中是必不可少的,如图像分类[26]、对象检测[16,15,50]和人体姿势估计[35,37]。直观上,较大的上下文区域捕捉物体的全局空间构造,而较小的上下文区域关注局部part外观。然而,以往的工作通常使用人工设计的多上下文表示,如多个bounding boxes[35]或多个图像裁剪[26],因此缺乏对多上下文表示建模的灵活性和多样性。

视觉注意力是人脑有效理解场景的重要机制。在这项工作中,我们提出用注意力方案产生上下文表示。与通过一组矩形bounding box手动定义感兴趣的区域不同,注意力maps是由注意力模型生成的,它依赖于图像特征,并提供了一种原则性的方法来关注具有可变形状的目标区域。例如,一个关注人体的注意力maps如图1 (b)所示,它有助于恢复缺失的身体部位(如腿),并区分模糊的背景。这样允许上下文多样性的增加,因此上下文区域可以更好地适应每张图像。此外,本文设计了一种新的基于条件随机场(CRF)的注意力模型,该模型能更好地模拟相邻区域间的空间相关性,从而取代了传统注意力方案中常用的空间Softmax标准化(spatial Softmax normalization)方法。

多个上下文信息的组合已被证明对各种视觉任务有效[49,16,35,14]。为了利用注意力机制来指导多上下文表示学习,我们采用了堆叠hourglass网络结构[29],它为构建多上下文注意力模型提供了一个理想的体系结构。在每个hourglass stack中,特征被池化到一个非常低的分辨率,然后上采样,并与高分辨率特征相结合。这个结构被重复多次,以逐渐捕获更多的全局表示。在每个hourglass stack中,我们首先从不同分辨率的特征生成多分辨率注意力maps。其次,我们为多个hourglass stack生成注意maps,从而产生具有不同语义层次的多语义注意力maps。因为这些注意力maps反映了整个人体的结构,所以它们被称为整体注意力模型。

整体注意模型对遮挡和杂乱的背景具有较强的鲁棒性,但缺乏对身体不同部位的精确描述。为了克服这一局限性,我们设计了一种分层视觉注意方案,该方案将整体注意模型放大到身体的各个部位,即局部注意模型。这有助于精确定位身体parts,如图1 (c)所示。

此外,我们引入了一个新的“hourglass残差单元”来代替我们网络中的残差单元[20]。它融合了多尺度特征的表达能力,同时保留了残差学习的好处。它还能使深度网络有一个更快的接受域增长,这对精确定位身体部位至关重要。当在“macro”hourglass网络中使用这些单元时,我们得到了一个nested hourglass体系结构。

我们展示了所提出的端到端可微框架在两个广泛使用的人体姿态估计基准上的有效性,即MPII Human Pose 数据集[1]和the Leeds Sports数据集[24]。我们的方法在这两个基准上的所有身体部位上的效果都优于所有以前的方法。这项工作的主要贡献有三个方面:

我们提出使用视觉注意力机制自动学习和推断上下文表征,驱动模型关注感兴趣的区域。与传统注意模型中使用spatial Softmax normalization不同,我们通过引入CRFs来建模邻域关节间的空间相关性,从而定制了人体姿态估计的注意力方案。据我们所知,这是第一次尝试利用注意力方案来估计人体姿态。

我们利用多上下文注意力,使模型更健壮、更准确。具体而言,设计了三种类型的注意,即每个hourglass内的多分辨率注意力、多个hourglass stack上的多语义注意力,和分层视觉注意力方案以放大局部区域以看得更清楚。

我们提出了一个通用的hourglass残差单元(HRU),并结合stacked hourglass结构构建了nested hourglass网络。在传统残差单元中,HRUs融合了不同尺度的特征。它们也使网络能够在早期阶段看到更大的上下文。

2. Related Work

Human Pose Estimation 人体姿态的表达通常通过一元项和图形模型的组合来建模,例如身体parts的混合[45,8,30]或图形结构[31]。最近,通过引入ConvNets去学习更好的特征表示来得到了重大进展[39,38,37,8,40,43,9,10,33,29]。例如,Chen和Yuille[8]引入了ConvNet来学习树形结构图形模型的一元项和pairwise项。Tompson等人[37]使用ConvNets的多个分支融合图像金字塔的特征,并使用马尔可夫随机场(MRF)进行后处理。Convolutional Pose Machine[40]融合了ConvNets中身体部位空间相关性的推理。stacked hourglass网络[29]和它的变体[5]实现了最先进的性能,它们使用重复的池化向下和向上采样过程来学习空间分布。我们的方法是对以往方法的补充,通过融合依靠多上下文表示的不同的图像来指导人体姿态估计。

Multiple Contextual Information 上下文信息通常指的是目标位置周围的区域[12,14,35]、对象-场景关系[21,19,13],以及对象-对象交互[44]。该算法在目标分类、检测等视觉任务中已被证明是有效的[49,12,13]。最近的研究通过串联多尺度特征[16,15],或通过门控函数来控制不同上下文[50]的相互影响,从而对上下文信息建模。然而,上下文区域被手动定义为矩形,而不考虑对象的外观。在本研究中,我们采用视觉注意力机制,将注意力集中在与图像相关、自适应的多环境建模区域上。我们的方法增加了上下文的多样性。

Visual Attention Mechanism 由于视觉注意模型计算效率高,理解图像效果好,在机器翻译[3]、物体识别[2,18,6,41]、图像字幕[48,42]、图像问题回答[47]、显著性检测[27]等任务中都取得了很大的成功。现有的方法通常采用递归神经网络在每一步生成图像区域的注意力maps,并将不同步骤的信息进行叠加,最终做出决策[3,2,27]。据我们所知,我们的工作是第一个研究使用注意力模型来估计人体姿态的工作。此外,本研究并没有研究学习注意力中层次顺序的整体注意力map和部分注意力map的设计,也没研究不同上下文和分辨率注意力的建模。

3. Framework

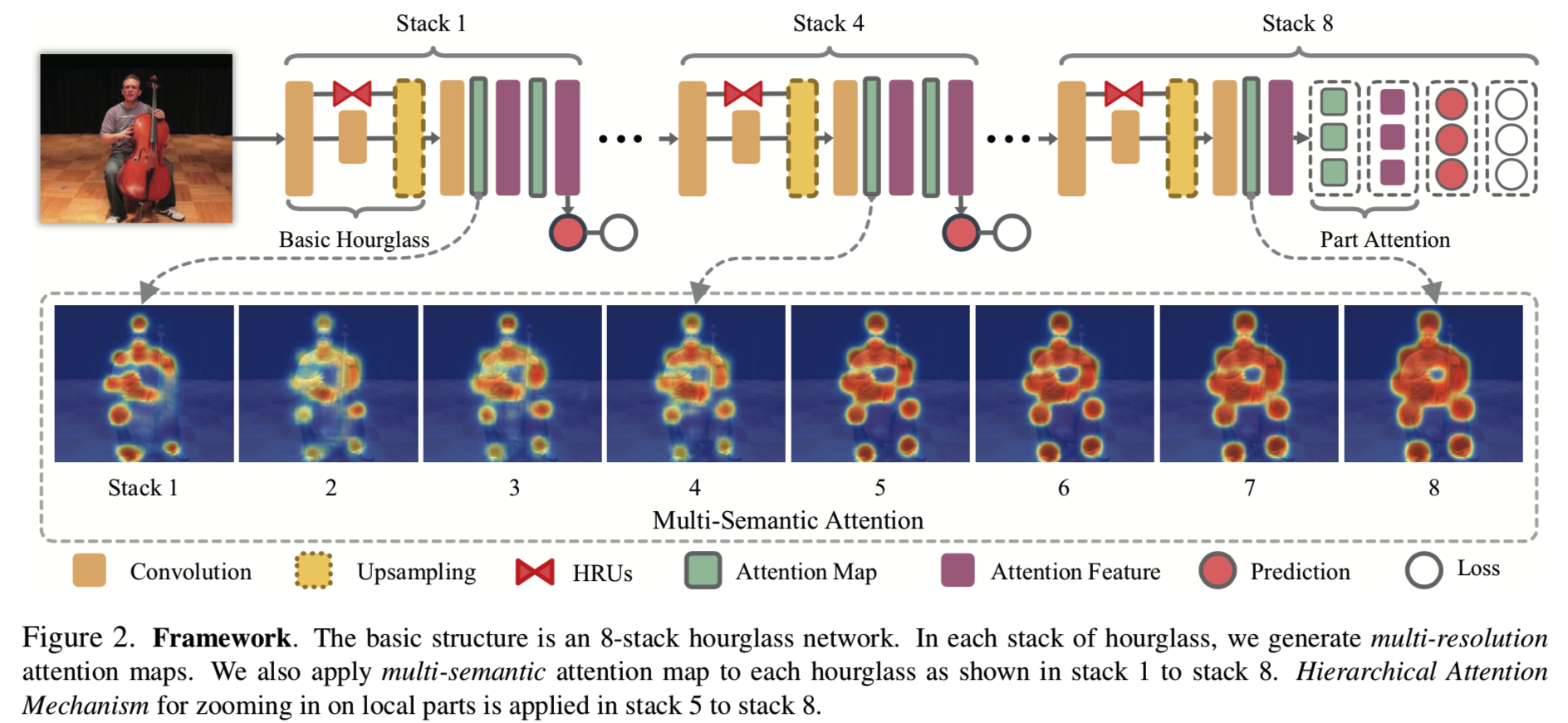

我们的框架的概述如图2所示。在本节中,我们将简要介绍nested hourglass体系结构,以及多上下文注意力模型的实现,包括多语义、多分辨率和层次化的整体部分注意力模型。然后使用生成的注意力maps重新加权特征,自动推断感兴趣的区域。

基线网络我们采用8层hourglass网络[29]作为基线网络。它允许跨尺度重复自底向上和自顶向下的推理,并在每个堆栈的末尾进行中间监督。实验中,输入图像为256×256,输出热图为p×64×64,其中K为人体parts的数量。我们遵循以前的工作[37,40,29],使用均方误差(Mean Squared Error)作为损失函数。

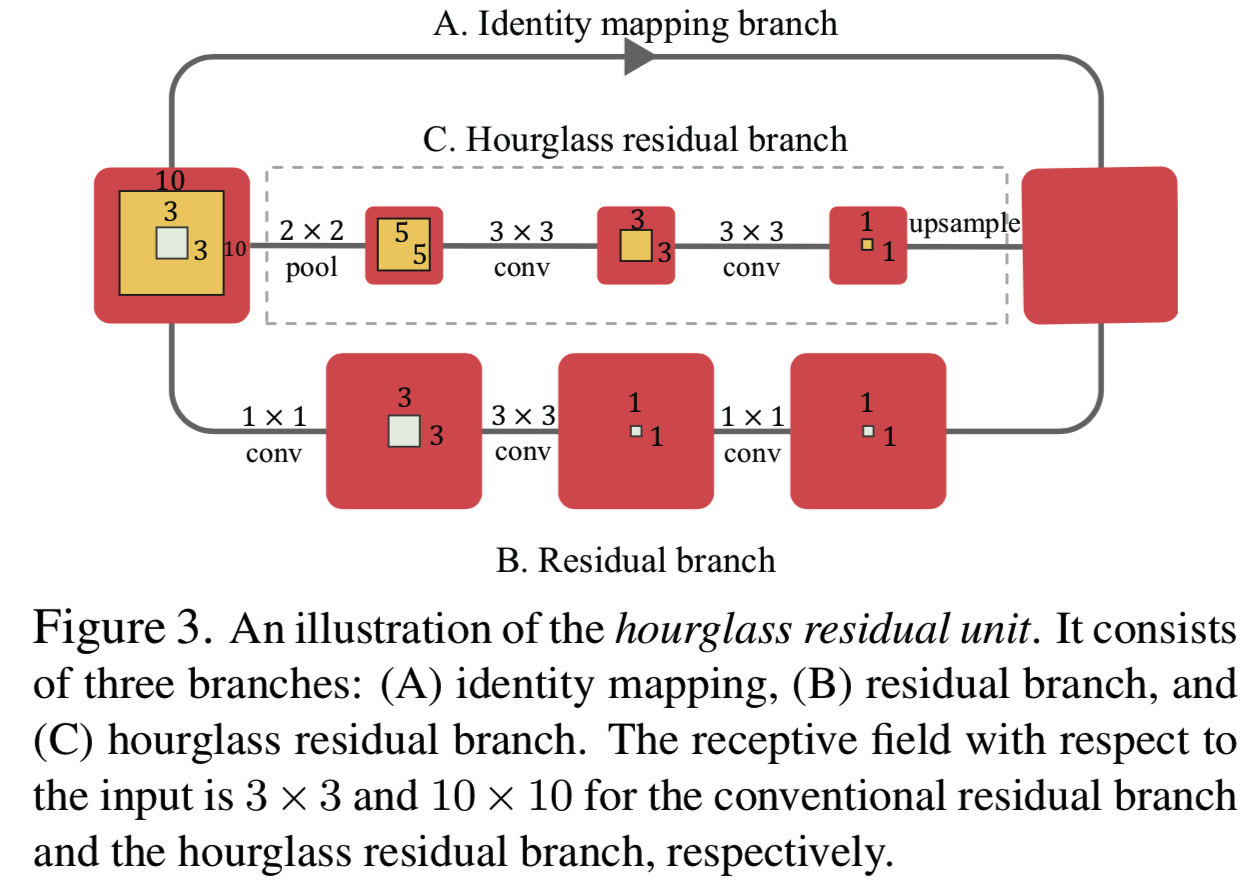

Nested Hourglass Networks 我们用所提出的micro hourglass 残差单元(HRUs)替换沿侧枝分布的用于合并多个分辨率特征的残差单元,得到一个nested hourglass网络,如图3所示。通过这种架构,我们丰富了每个构建块的输出所接收到的信息,使得整个框架对尺度变化更加健壮。HRUs的详细信息见第4节。

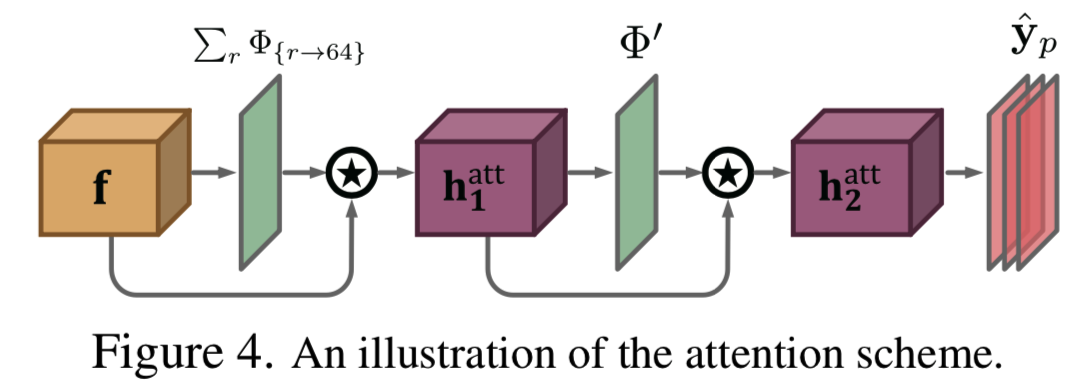

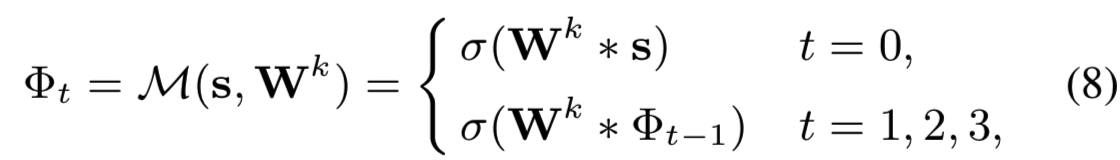

Multi-Resolution Attention 在每个hourglass内,由不同尺度的特征生成多分辨率注意力maps Φr,其中r为特征的大小,如图5所示。然后结合注意力maps Φr 生成细化的特征h1att,利用细化的特征h1att进一步生成细化的注意力maps Φ'和进一步得到细化的特征h2att,如图4所示。

Multi-Semantics Attention 不同的栈具有不同的语义:较低的栈关注局部外观,而较高的栈编码全局表示。因此,从不同堆栈生成的注意力maps也编码了不同的语义含义。如图2所示,对比栈1和栈8的左膝,我们可以看到,具有全局表征的更深栈能够恢复遮挡。

Hierarchical Attention Mechanism 在较低的堆栈中,即堆栈1到堆栈4,我们使用两个整体注意力maps h1att和h2att来对整个人体的配置进行编码。在更高的栈中,即第5到第8栈,我们设计了一个分层的由粗到细的注意力方案来放大局部部分。

4. Nested Hourglass Networks

在本节中,我们将对提出的hourglass残差单位(HRUs)进行详细描述。我们也提供接受域的全面分析。

4.1. Hourglass Residual Units

让我们先简单回顾一下残差网络[20]。深度残差网络通过一个极深的“残差单元”堆栈达到令人信服的精度,可以表示为:

![]()

其中xn和xn+1为第n个单元的输入和输出,![]() 为堆叠卷积、batch normalization和ReLU非线性函数。在[20]中,h(xn) = xn是恒等映射。

为堆叠卷积、batch normalization和ReLU非线性函数。在[20]中,h(xn) = xn是恒等映射。

在本文中,我们关注的是人体姿态估计,其中较大的上下文区域被证明对定位局部人体部位很重要[40,29]。神经元的周围区域是它相应的接受域。在这项工作中,我们建议使用micro hourglass分支扩展原始残差单位。所得到的hourglass残差单元(HRUs)在保留局部细节的同时具有更大的接收域,如图3所示。我们在堆叠的hourglass网络中使用这个模块。这种架构被称为“nested hourglass网络”,因为hourglass结构在宏观和微观层面都被使用。

我们提出的HRUs的数学公式如下:![]()

每个HRU包含三个分支。分支(A)即等式(2)中的xn,是一个恒等映射。因此ResNet处理消失梯度的特性也保存到了HRUs中。分支(B),即等式(2)中的![]() ,是一个类似等式(1)中的ResNet的残差块。分支(C),即等式(2)中的

,是一个类似等式(1)中的ResNet的残差块。分支(C),即等式(2)中的![]() ,是我们的新设计,是一个2x2 max-pooling、两个带着ReLU的3x3卷积层和一个上采样操作的堆叠。

,是我们的新设计,是一个2x2 max-pooling、两个带着ReLU的3x3卷积层和一个上采样操作的堆叠。

4.2. Analysis of Receptive Field of HRU

分支(A)中的恒等映射的接收域大小为1。branch (B)中的残差块是一个卷积(Conv1×1 + Conv3×3 + Conv1×1)的堆栈。因此,输出特征中的神经元对应于该HRU中输入的3×3区域。分支(C)是我们添加的分支。该分支的结构是Pool2×2 + Conv3×3 + Conv3×3 + Deconv2×2。由于max-pooling,卷积在这个分支的分辨率是分支(A)和(B)的一半,和输出特征map中的每个神经元对应于一个10×10的输入区域,大约是分支(B)残差块接受域大小的3倍。这三个分支,有着不同的接受域和分辨率,加在一起为HRU的输出。因此,HRU单元通过包括分支(C)来增加接收域的大小,同时通过使用分支(A)和(B)来保存高分辨率信息。

5. Attention Mechanism

我们首先简要介绍传统的软注意力机制,然后描述我们提出的多上下文框架。

5.1. Conventional Attention

用f表示卷积特征。获得软注意力的第一步是生成总结出来的特征图,如下所示:

![]()

其中* 表示卷积,![]() 表示卷积过滤器,g表示非线性激活函数。

表示卷积过滤器,g表示非线性激活函数。![]()

![]() 总结在f中所有channels的信息。

总结在f中所有channels的信息。

s(l)表示特征映射s中l处的特征,其中l = (x, y), x为水平位置,y为垂直位置。对s空间进行Softmax运算,如下:

其中![]() 。Φ是注意力map,其中

。Φ是注意力map,其中![]() 。然后注意力map被用在特征f上:

。然后注意力map被用在特征f上:

![]()

其中c为特征channel索引。我们使用![]() 来表示channel-wise的Hadamard矩阵内积操作。hatt是细化的特征map,它是由注意力map重新加权的特征,其大小与f相同。

来表示channel-wise的Hadamard矩阵内积操作。hatt是细化的特征map,它是由注意力map重新加权的特征,其大小与f相同。

5.2. Our Multi-Context Attention Model

我们的框架对注意力模型做了以下三处修改。首先,我们用CRF替换了4中的全局Softmax,以考虑局部模式相关性。Global spatial Softmax基于常量因子对整幅图像进行归一化处理,忽略了局部邻域空间相关性。但我们希望“注意力map”能够驱动网络,将注意力集中在复杂的人体构造上。更多细节见5.2.1节。其次,我们根据不同分辨率的特征生成注意力map,使模型更具鲁棒性,如5.2.2节所示。然后,如5.2.3节所述,为hourglass的每个堆栈生成注意力map,从而获得多重语义注意力。最后,使用了一个分层的由粗到细(即全身到部分)的注意力方案,去放大局部part区域,进行更精确的定位,在5.2.4节介绍。整个框架是可微的和使用随机初始化进行端到端的训练。我们的注意力方案如图4所示。

5.2.1 Spatial CRF Model

在本文中,我们使用条件随机场(CRFs)来建模空间相关性。为了使它们可微,我们使用平均场近似方法递归地学习空间相关核[51,25]。

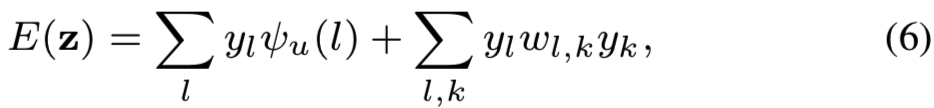

注意力map构建为two-class问题。![]() 表示在第i位置的注意力标签。在CRF模型,一个标签y=

表示在第i位置的注意力标签。在CRF模型,一个标签y=![]() 赋值的energy为:

赋值的energy为:

其中![]() 是测量注意力标签为

是测量注意力标签为![]() 的位置

的位置![]() 的 inverse likelihood的一元项。

的 inverse likelihood的一元项。![]() 是用于yl和yk之间兼容性的权重。给定图像

是用于yl和yk之间兼容性的权重。给定图像![]() ,标签赋值为y的可能性为

,标签赋值为y的可能性为![]()

![]() ,其中Z是分区函数。

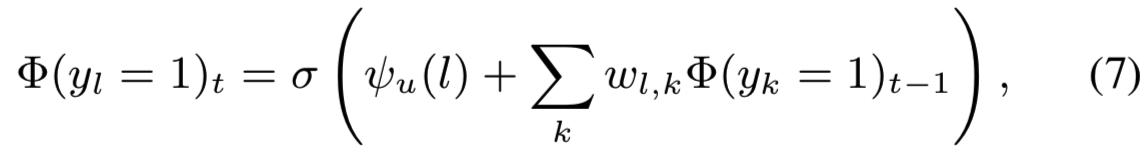

,其中Z是分区函数。![]() 的概率可以使用平均场近似方法(mean-field approximation)迭代得到:

的概率可以使用平均场近似方法(mean-field approximation)迭代得到:

其中![]() 是sigmoid函数。

是sigmoid函数。![]() 由特征h的卷积获得。

由特征h的卷积获得。![]() 通过使用过滤器对stage t-1 的预估注意力map

通过使用过滤器对stage t-1 的预估注意力map ![]() 卷积实现。初始化为

卷积实现。初始化为![]() 。

。

总结,stage t的注意力map ![]() 可以形式化为:

可以形式化为:

其中![]() 表示用于平均场近似的一个权重共享卷积序列,

表示用于平均场近似的一个权重共享卷积序列,![]() 表示空间相关核。

表示空间相关核。![]() 沿着不同时间steps被共享。在我们网络中,我们使用三步递归卷积。

沿着不同时间steps被共享。在我们网络中,我们使用三步递归卷积。

5.2.2 Multi-Resolution Attention

如图5所示,上采样过程产生了不同大小r的特征,即r = 8,16,32和64的fr。用(8)中的步骤,使用sr生成注意力图Φr,将注意力图Φr上采样至大小为64,上采样图记为Φ{r->64}。这些注意力maps与不同的分辨率相关。如图5(I)所示,Φ{8->64}有着最低的分辨率,但是highlight了人体的整个配置。Φ64,有着最高的分辨率,但是专注于局部人体parts。

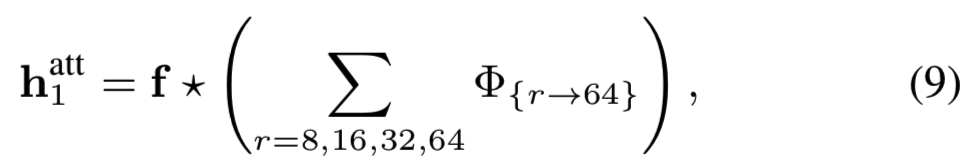

所有上采样的注意力map求和,然后应用于特征f:

其中特征f为hourglass最后一层的输出,如图5所示。操作![]() 在等式(5)中有说明。

在等式(5)中有说明。

使用注意力mao的传统方法是直接将它应用到生成它的特征上。然而,注意力map细化后的特征通常有大量接近于零的值,许多细化的特征叠加在一起使反向传播变得困难。为了在不牺牲训练效率的前提下利用来自多分辨率特征的信息,我们从不同分辨率的特征中生成注意力map,并将其应用到后面的特征中。

除了多分辨率注意力以外,一个细化的注意力map Φ' 和它关联的细化特征h2att都从h1att得到:

![]()

5.2.3 Multi-Semantics Attention

上面的过程在一堆hourglass上重复,以生成具有多种语义意义的注意力map。从第一堆到第八堆的Φ'样例如图2所示。在较浅的hourglass堆上的注意力map捕捉到更多的局部信息。对于更深层的hourglass堆栈,关于整个人的全局信息被捕获,这对遮挡来说更健壮。

5.2.4 Hierarchical Holistic-Part Attention

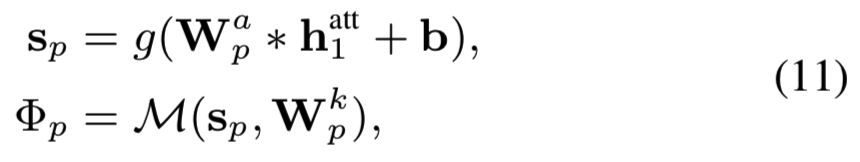

在第4到第8的hourglass堆结构中,我们使用等式(9)中的细化特征h1att去生成part注意力maps,如下:

其中![]() ,

,![]() 表示为了获得part p的总map sp的参数,

表示为了获得part p的总map sp的参数,![]() 表示part p的空间相关性建模。part注意力map Φp与细化特征map h1att相结合去获得part p的细化特征,如下:

表示part p的空间相关性建模。part注意力map Φp与细化特征map h1att相结合去获得part p的细化特征,如下:

第p个身体关节的热图预测是基于细化特征hpatt的:

其中![]() 是用于第p part的热图,

是用于第p part的热图,![]() 是分类器。这样,我们就保证了注意图Φp对于身体关节p是特殊的。图6给出了part注意li图的定性结果。

是分类器。这样,我们就保证了注意图Φp对于身体关节p是特殊的。图6给出了part注意li图的定性结果。

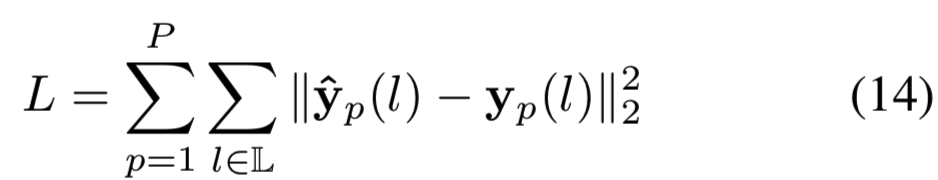

6. Training the model

hourglass中的每一层都会生成人体各关节的预估热图。我们采用[29]中的损失函数来学习模型。对于每个堆栈,计算平均平方误差(MSE)损失:

其中p为第p个body部分,![]() 为第

为第![]() 个位置n。

个位置n。![]() 表示part p预测的热图,yp对应由二维高斯生成的真实的热图。

表示part p预测的热图,yp对应由二维高斯生成的真实的热图。

注意力map有助于推动网络把注意力集中在hard negative样本上。经过几个阶段的训练后,注意力map集中在人体区域,那里的真positive样本被注意力map突出显示。细化后的特征用于学习人体区域的分类器,学习后的注意力map在特征层去除简单的背景区域。因此,对于局部注意力map,分类器侧重于根据定义良好的人体区域对每个人体关节进行分类,没有考虑背景。

7. Experiments

Dataset 我们在MPII Human Pose[1]和extended Leeds Sports Poses(LSP)[24]这两个广泛使用的基准上对该方法进行了评估。MPII Human Pose数据集包括大约25k的图像和40k个注释姿态。这些照片是从YouTube上的视频中收集的,这些视频涵盖了人类的日常活动以及高度连贯的人类姿势。LSP数据集由来自体育活动的11k张训练图像和1k张测试图像组成。

Data Augmentation 在训练中,使用粗糙地相同尺寸在图像中心裁剪目标任务,然后缩放该图像path到大小256*256.然后我们随机旋转(±30◦)和翻转图像。我们还执行随机的重新缩放(0.75到1.25)和颜色抖动,以使模型对尺寸变化和光照变化变现得更健壮。在测试过程中,我们对MPII数据集按照给定的粗糙位置和测试人的尺度对图像块进行裁剪。对于LSP数据集,我们简单地用图像大小作为粗糙尺度,用图像中心作为目标人的粗糙位置来裁剪图像patch。所有的实验结果都是根据原始的和翻转的6个尺度的图像金字塔产生的。

Experiment Settings 我们使用Torch7[11]对模型进行训练,初始学习率为2.5×10−4。采用RMSprop[36]算法对参数进行优化。我们在MPII数据集和LSP数据集上分别训练130个epoch和60个epoch的模型。我们对[37]中使用的MPII数据集采用验证分割来监视训练过程。

7.1. Results

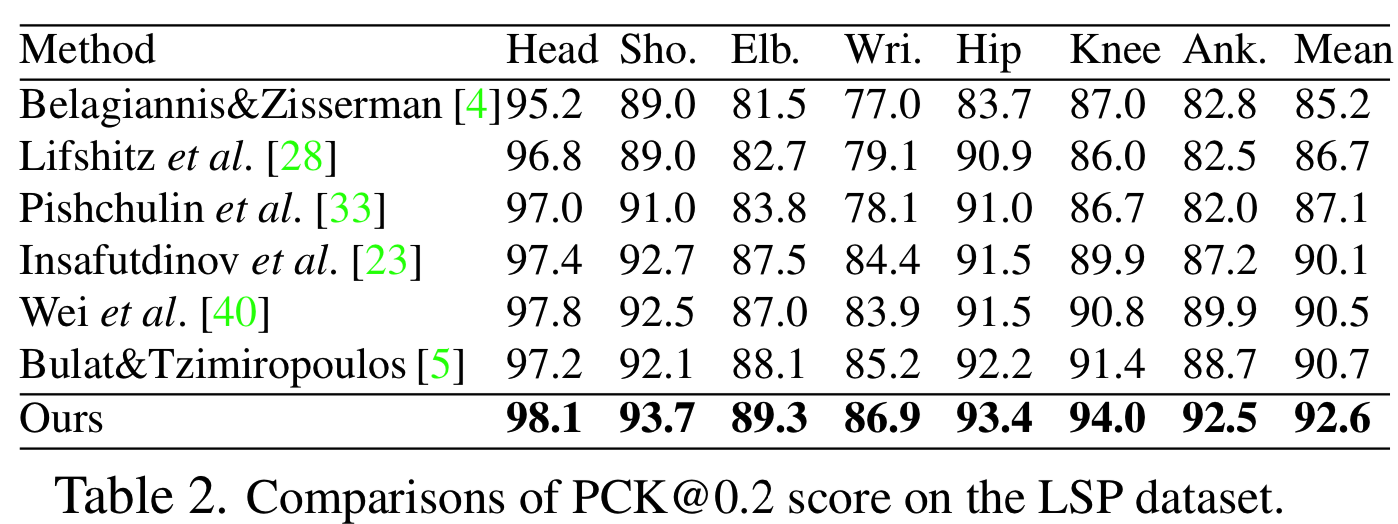

我们在LSP数据集上使用Percentage Correct Keypoints(PCK)[46]度量进行比较,PCKh度量[1],其中容错与头部尺寸标准化,在MPII人体姿态数据集上进行比较。

MPII Human Pose 表1报告了在归一化距离为0.5的情况下,我们的方法与以前的最先进水平的PCKh性能的比较。我们的方法达到了最新的91.5% PCKh分数。特别是对于最具挑战性的身体部位,如手腕和脚踝,我们的方法与最接近的竞争者相比分别提高了1.0%和1.4%,如图7所示。

Leeds Sports Pose 我们通过将MPII训练集添加到扩展的LSP训练集(带有以人为中心的注释)来训练我们的模型,这是一个标准例程[40,23,33,28,4]。表2报告了阈值为0.2时的PCK。我们的方法优于最先进的所有身体关节的结果,并获得1.9%的平均改善。

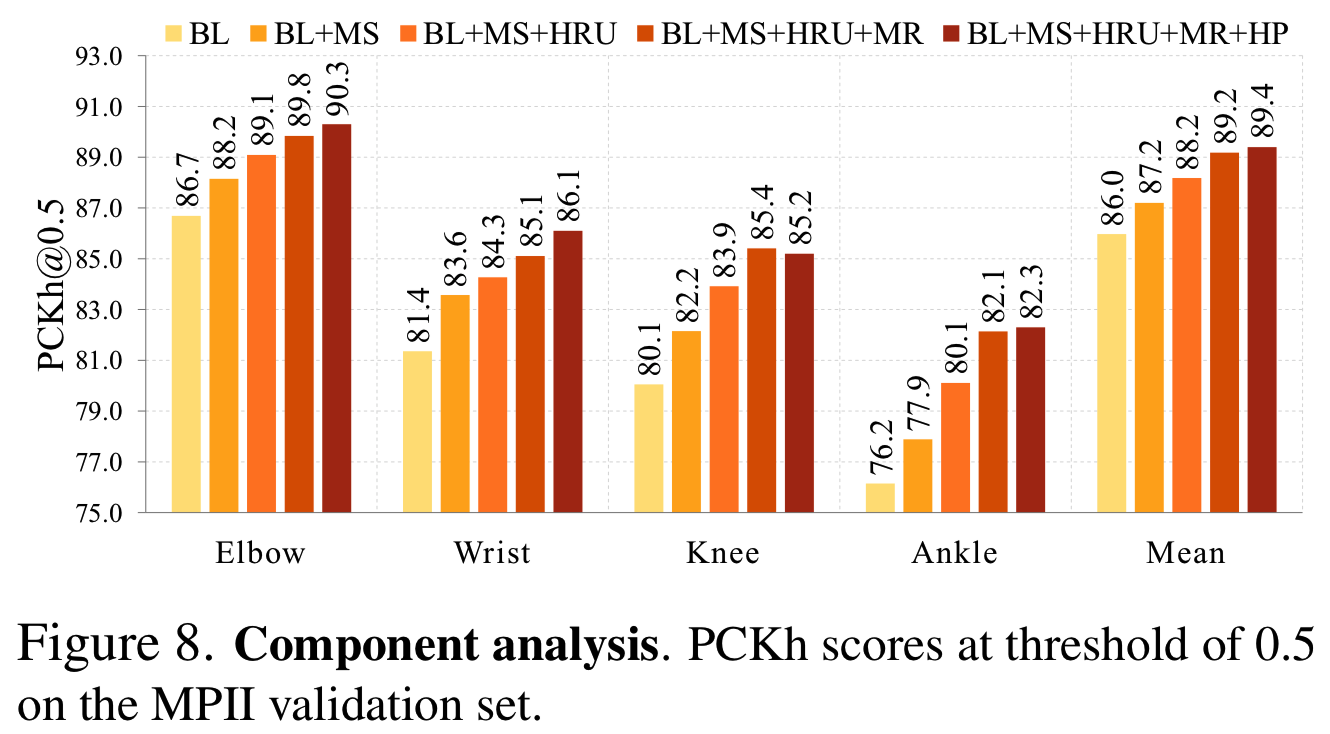

7.2. Component Analysis

为了研究多上下文注意力机制和hourglass残差单元的有效性,我们在MPII人体姿势数据集的验证集[37]上进行消融实验。如果没有指定,我们使用一个8层hourglass网络[29]作为基线模型。总体结果如图8所示。以基线网络(baseline network, BL)为基础,通过比较PCKh的评分,对提出的多语义注意力模型(MS)、hourglass残差单元(Hourglass Residual Units, HRUs)、多分辨率注意力模型(MR)和层次部分注意力模型(HP)进行分析。

Multi-Semantics Attention 首先对多语义注意力模型进行评价。通过在每个hourglass stack的末尾添加整体注意力模型(“BL+MS”),我们得到87.2%的PCKh评分,比基线模型提高了1.2%。

Hourglass Residual Unit 为了探究残差池化单元的效果,我们在合并不同分辨率的特征时,进一步使用HRUs替代原来的残差单元,(“BL+MS+HRU”),如图2所示。hourglass残差单元的增加导致了进一步1%的改善。正如在[29]中讨论的那样,简单地叠加超过8个hourglass模块是无法轻易获得改进的。提出了一种有效提高模型容量的方法。

Multi-Resolution Attention 通过多分辨率特征(“BL+MS+HRU+MR”)生成注意力map,我们的方法进一步提高了1%。

Hierarchical Attention 我们还展示了层次整体局部注意模型所带来的改进。我们用一组从stack 4到stack 8的part注意力图替换精制的整体注意图,得到最高的平均PCKh得分为89.4%。我们观察到改进主要是由人体部位的细化定位带来的。在某些情况下,part注意力模型甚至可以纠正重复计数问题,如图1 (c)所示。

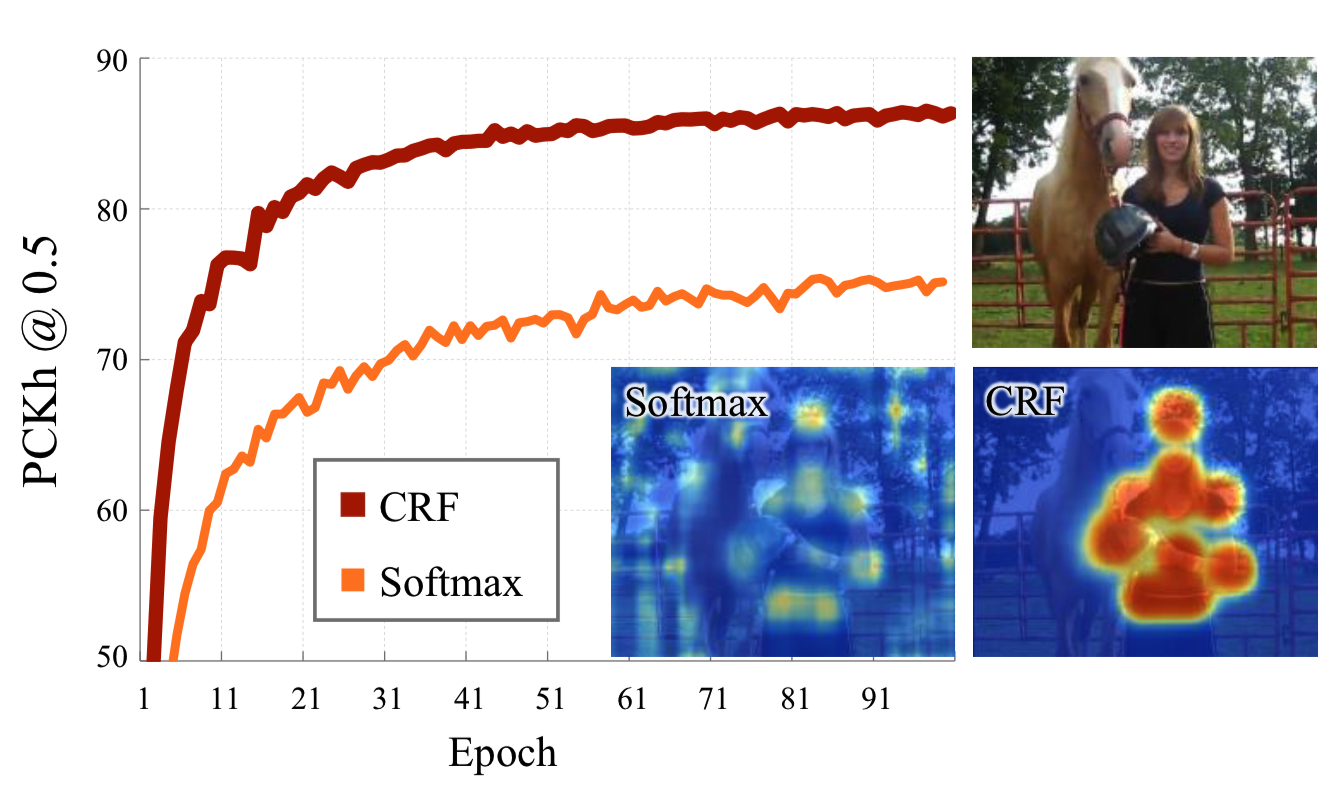

Softmax vs. CRF 最后,我们将本文提出的CRF空间注意力模型与传统的基于two-stack hourglass网络的Softmax注意力模型进行了比较。在图10中,随着训练的进展,我们比较验证集上的准确率,即PCKh为0.5。与Softmax注意力模型相比,CRF注意力模型收敛更快,验证精度更高。我们将这两种模型生成的注意力图可视化,观察到CRF模型生成的注意图比Softmax模型更加清晰,因为CRF模型对人体各部位的空间相关性建模能力更强。

7.3. Qualitative Results

为了深入了解注意力是如何工作的,我们通过可视化注意力maps、分数maps和估计姿态来比较基线模型和提出的模型,如图9 (a-b)所示。我们观察到,基线模型在区分四肢外观相似的物体(如图9 (a)中的马腿)和形状模糊的沉重阴影(图9 (b))时可能存在困难。因此,整体注意力maps对去除杂乱的背景和减少模糊性有很大的帮助。对于part注意力maps,除了为身体部位提供更精确的定位,它们甚至可以帮助减少重复计算问题。例如,通过合并part注意力maps,可以区分左脚踝和右脚踝。

图9 (c)显示了我们的方法在MPII测试集和LSP测试集上预测的位姿。我们的方法在极端困难的情况也是稳健的,例如,罕见的位姿,杂乱的背景,和透视。然而,如图11所示,我们的方法可能会在一些人眼也有困难的情况下失败,即(a)严重遮挡和模糊,(b)扭曲的四肢,(c)光照显著变化,(d)由服装/灯光引起的左右身体混淆。更直观的效果请参考补充资料。

8. Conclusion

本文提出将多上下文注意力和卷积神经网络整合到端到端框架中。我们使用视觉注意力来指导上下文建模。因此,我们的框架在上下文区域中具有很大的多样性。替代使用全局Softmax,我们引入CRF用于空间相关性建模。我们构建了包含三个成分的多上下文注意力模型,即多分辨率、多语义和层次整体-部分注意力方案。除此之外,提出一个hourglass残差单元去丰富传统残差单元的表达能力。提出的多上下文注意力和HRUs是通用的,可以用于其他视觉任务。