SiamFC++: Towards Robust and Accurate Visual Tracking with Target Estimation Guidelines

2020-06-18 16:37:32

Paper: https://arxiv.org/pdf/1911.06188v4.pdf

Code: https://github.com/MegviiDetection/video_analyst

1. Background and Motivation:

作者提出如下几个方面的引导,来设计新的孪生网络进行跟踪:

G1. Decomposition of classification and state estimation.

G2. Non-ambiguous scoring.

G3. Prior knowledge-free.

G4. Estimation quality assessment.

2. The Proposed Method:

2.1. Siamese-based Feature Extraction and Matching:

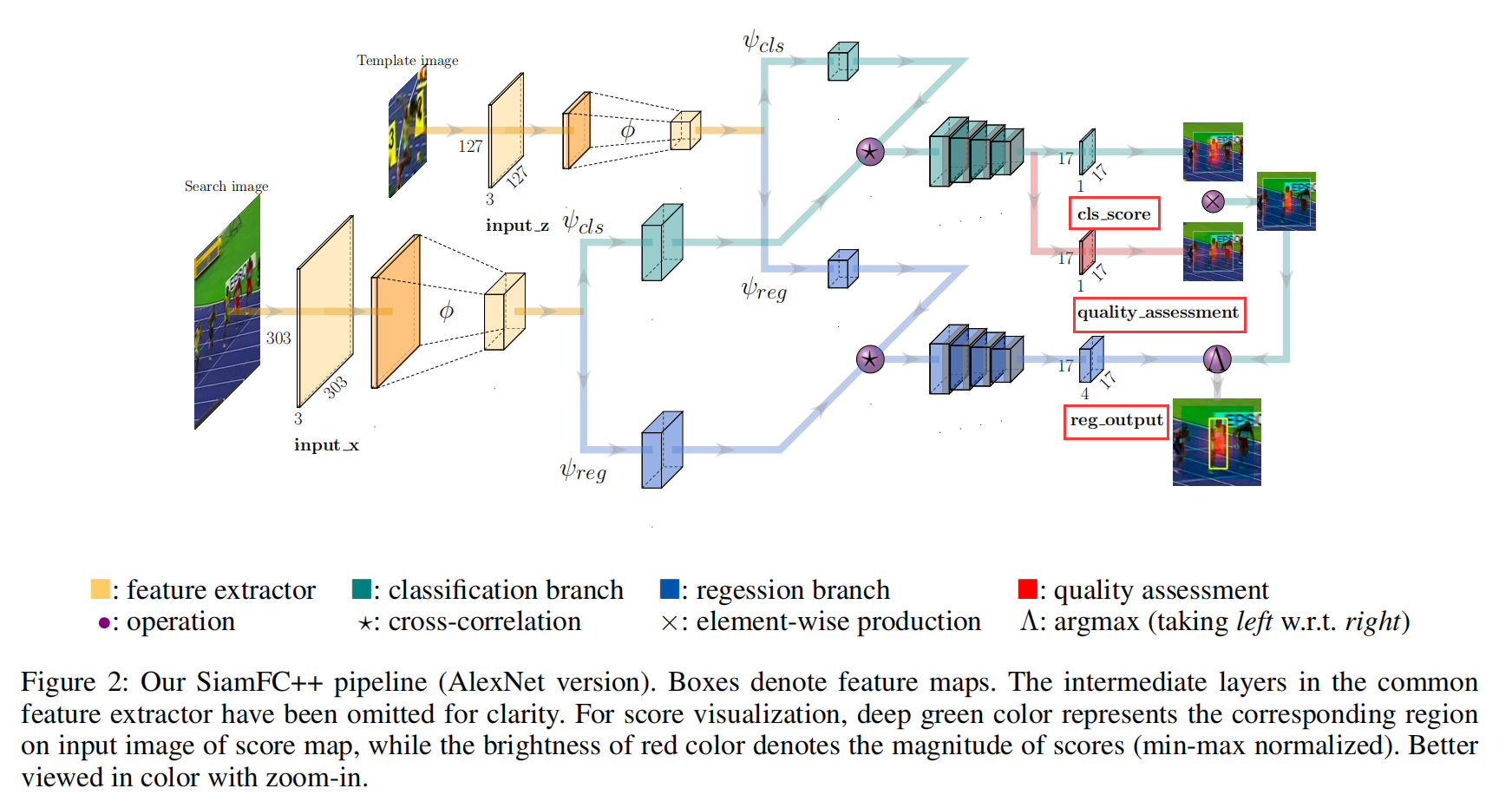

这里作者采用了 Siamese network 来分别提取 template 和 search image 的特征,并且计算其相似性。用两个分支,classification 和 regression branch 来得到两组特征。

2.2. Application of Design Guidelines in Head Network:

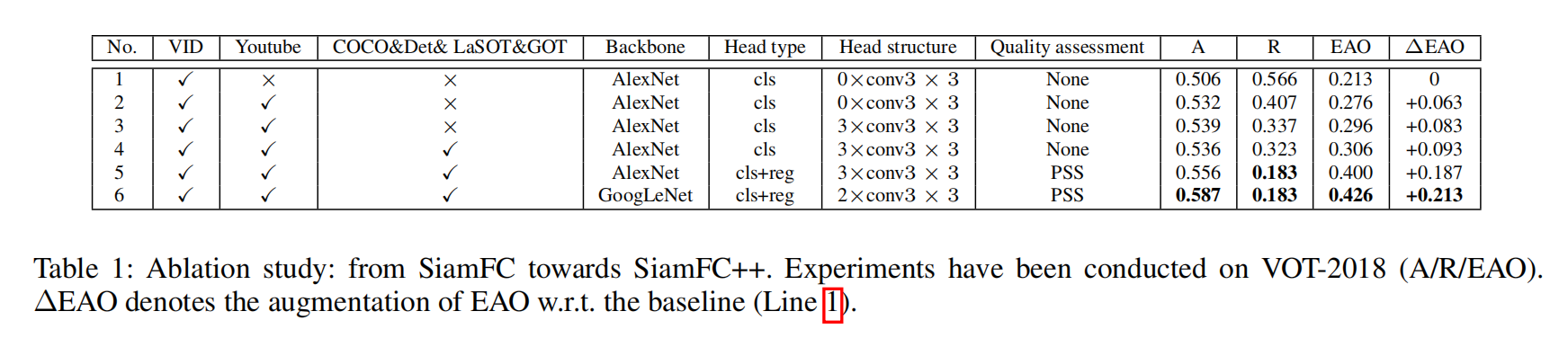

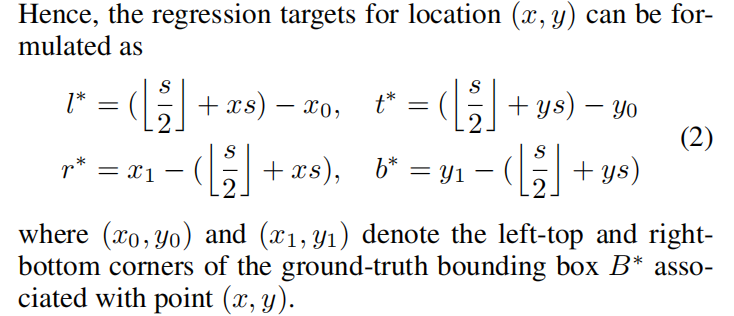

本文服从 G1,设计了两个分支,一个是 regression;一个是 classification。Classification 分支是用于大致定位,而 Regression 分支则是为了得到更加准确地 BBox 位置信息。这部分网络的设计有点借鉴 FCOS 物体检测方法。

特征图上每一个位置 (x, y) 都对应了一个图像区域。服从 G2,作者直接分类对应的 image patch 和 回归目标矩形框。换句话说,本文所提出的 SiamFC++ 可以直接将位置看做是训练样本。本文方法直接拓展了 anchor 的约束,属于 anchor-free 的方法。所以,本文的方法并没有利用目标数据分布的先验信息,例如 scale/ratio。这样就符合准则 G3了。

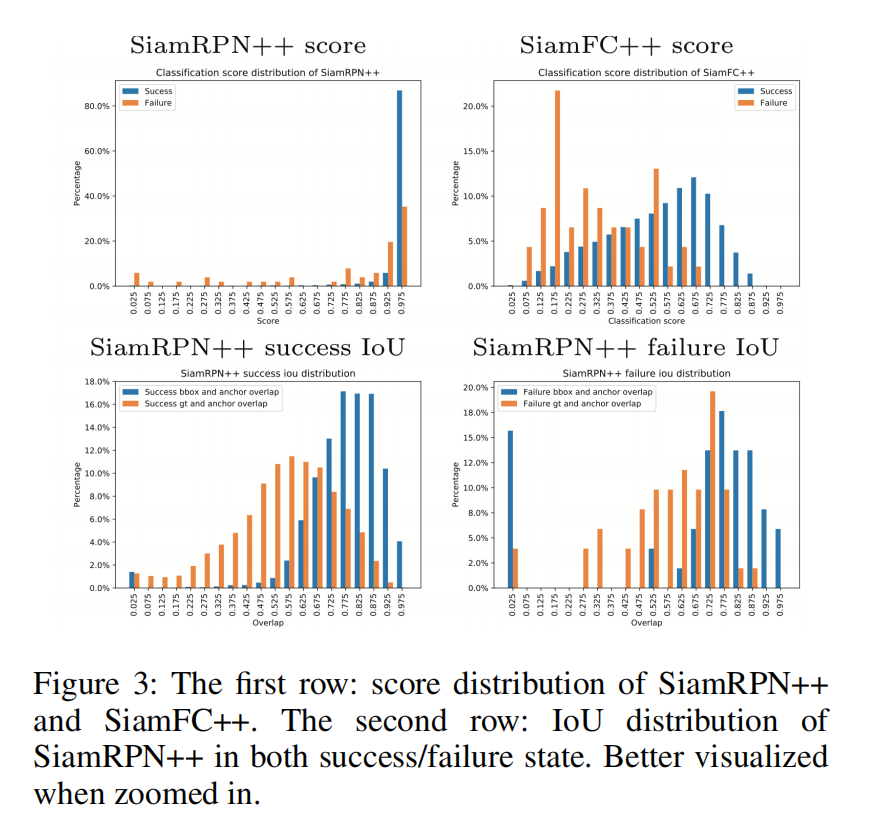

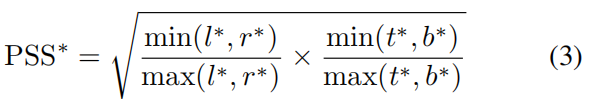

作者根据前人的工作得出如下的结论:分类的得分,并没有和定位的准确度很好地对应。作者采用了这种中心先验的做法,并且服从 G4,添加了一个简单但是有效的 quality assessment branch 来进行跟踪效果评估。该输出可以去预测先验空间得分(the Prior Spatial Score, PSS),定义如下:

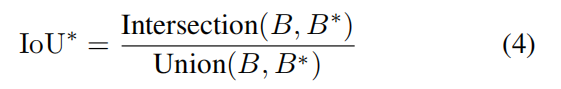

注意到,这里的 PSS 并不是质量估计唯一的选择。另外,作者也预测了得到的 BBox 和真值的 IoU:

2.3. Training Objective:

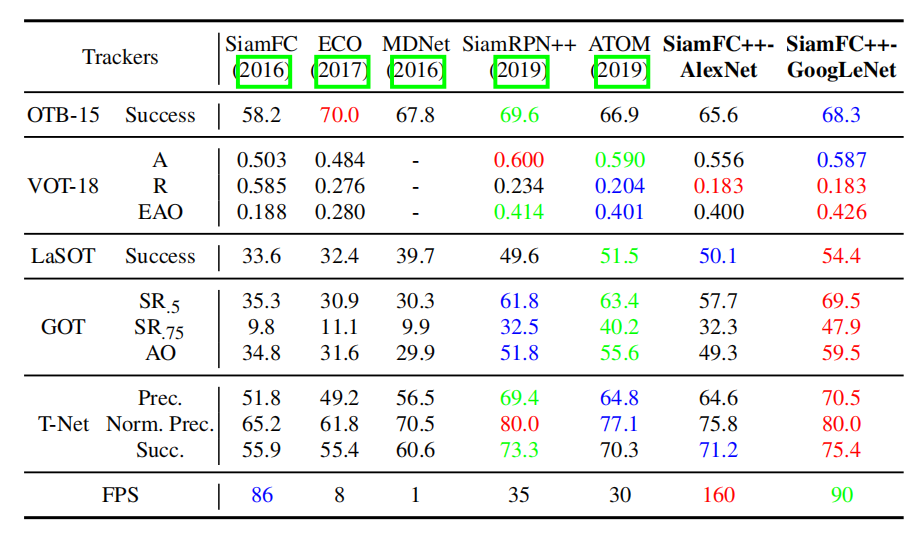

3. Experiments: