1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

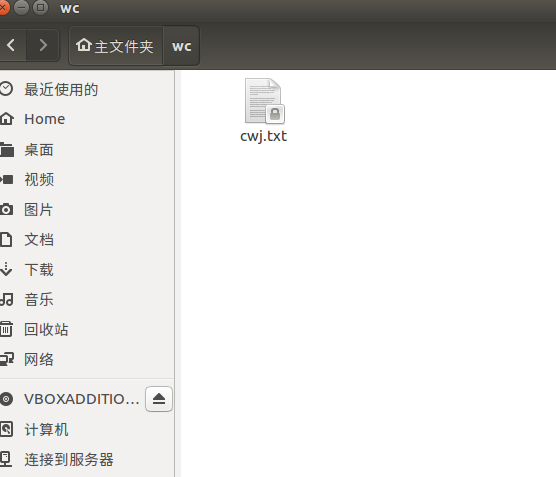

在网上下载英文小说,通过QQ邮箱下载到虚拟机的/home/hadoop/wc

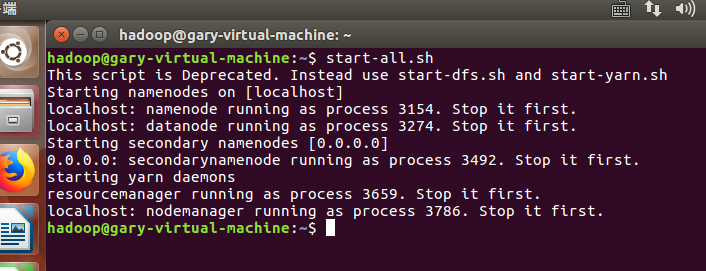

首先要启动dfs:

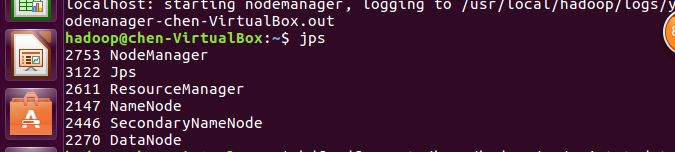

检查配置环境:

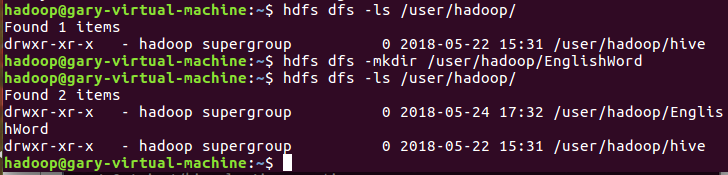

在user/hadoop/上创建文件夹word:

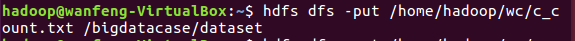

上传下载文档到user/hadoop/word文件中:

![]()

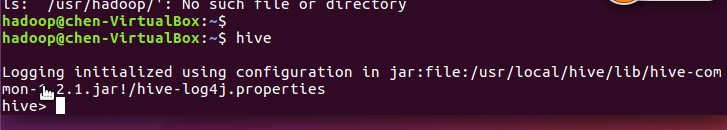

启动hive:

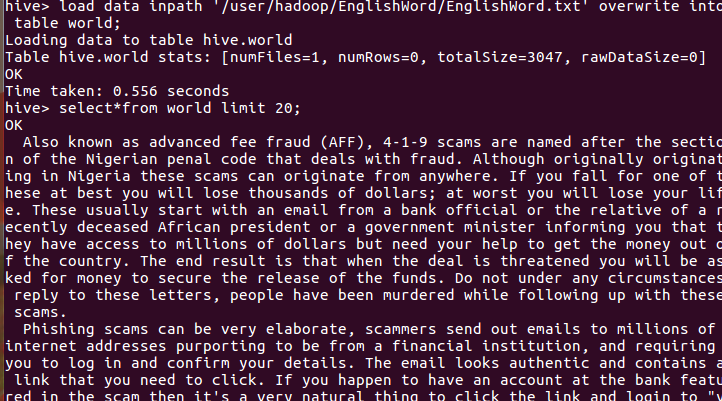

在hive数据库创建表 world:

导入文本cwj.txt并查看

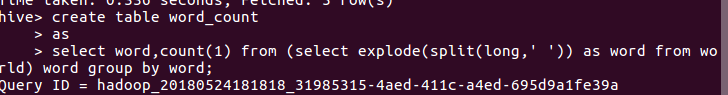

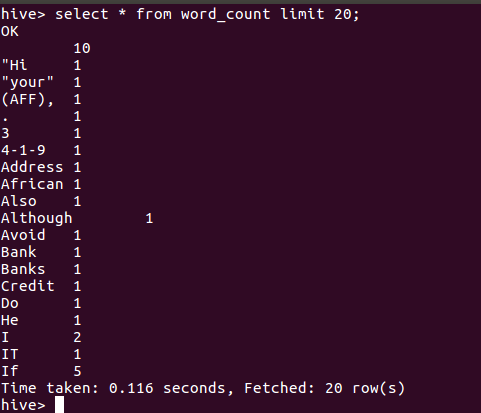

用HQL进行词频统计并保持到表 word_count:

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

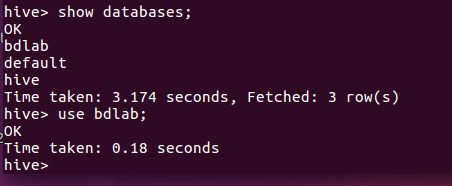

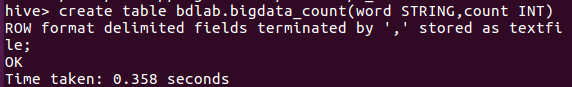

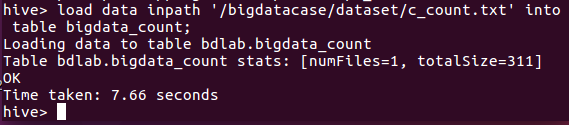

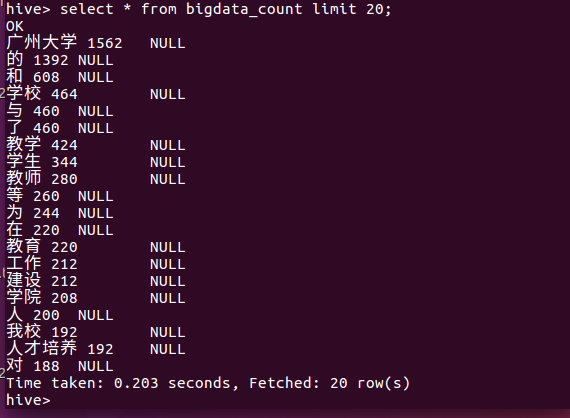

同上,将爬虫大作业产生的txt文件放入bdlab数据库表bigdata_count中:

通过QQ邮箱,将爬虫大作业文本文件下载并放于虚拟机 /home/hadoop/wc 目录下,爬虫一共爬取了广州商学院校园网的全部新闻,共4300多条。

创建用于存放csv数据目录:

![]()

把文件放入文件夹中

查看文件中的数据:

导入数据库表中

查看数据:

主要是爬取我们学院的校园网,让我们能更进一步地了解到我们学院的一些重大新闻或者活动,促使同学们之间的交流。