看知乎的时候发现了一个 “如何正确地吐槽” 收藏夹,里面的一些神回复实在很搞笑,但是一页一页地看又有点麻烦,而且每次都要打开网页,于是想如果全部爬下来到一个文件里面,是不是看起来很爽,并且随时可以看到全部的,于是就开始动手了。

工具

1.Python 2.7

2.BeautifulSoup

分析网页

我们先来看看知乎上该网页的情况:

网址:  ,容易看到,网址是有规律的,page慢慢递增,这样就能够实现全部爬取了。

,容易看到,网址是有规律的,page慢慢递增,这样就能够实现全部爬取了。

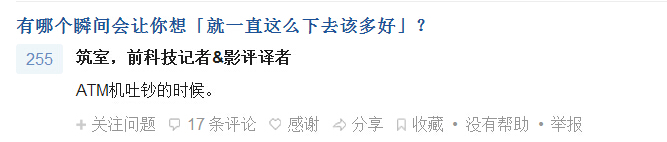

再来看一下我们要爬取的内容:

我们要爬取两个内容:问题和回答,回答仅限于显示了全部内容的回答,如下面这种就不能爬取,因为好像无法展开(反正我不会。。),再说答案不全的话爬来也没用,所以就不爬答案不全的了吧。

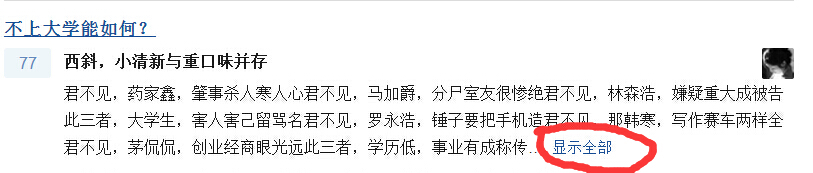

好,那么下面我们要找到他们在网页源代码中的位置:

即我们找到问题的内容包含在<h2 class = "zm-item-title"><a tar...>中,那么我们等会就可以在这个标签里面找问题。

然后是回复:

有两个地方都有回复的内容,因为上面那个的内容还包括了<span..>等一些内容,不方便处理,我们爬下面那个的内容,因为那个里面的内容纯正无污染。

修正前代码

好,这时候我们试着写出python代码:

# -*- coding: cp936 -*- import urllib2 from BeautifulSoup import BeautifulSoup f = open('howtoTucao.txt','w') #打开文件 for pagenum in range(1,21): #从第1页爬到第20页 strpagenum = str(pagenum) #页数的str表示 print "Getting data for Page " + strpagenum #shell里面显示的,表示已爬到多少页 url = "http://www.zhihu.com/collection/27109279?page="+strpagenum #网址 page = urllib2.urlopen(url) #打开网页 soup = BeautifulSoup(page) #用BeautifulSoup解析网页 #找到具有class属性为下面两个的所有Tag ALL = soup.findAll(attrs = {'class' : ['zm-item-title','zh-summary summary clearfix'] }) for each in ALL : #枚举所有的问题和回答 #print type(each.string) #print each.name if each.name == 'h2' : #如果Tag为h2类型,说明是问题 print each.a.string #问题中还有一个<a..>,所以要each.a.string取出内容 if each.a.string: #如果非空,才能写入 f.write(each.a.string) else : #否则写"No Answer" f.write("No Answer") else : #如果是回答,同样写入 print each.string if each.string: f.write(each.string) else : f.write("No Answer") f.close() #关闭文件

代码虽然不常,可是写了我半天,开始各种出问题。

运行

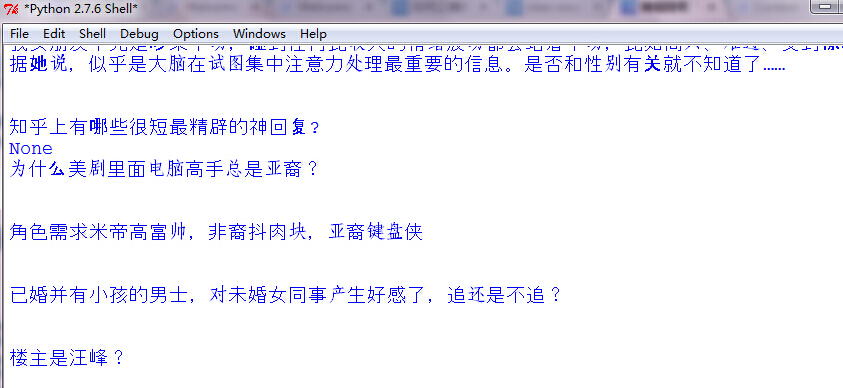

然后我们运行就可以爬了:

修正前结果

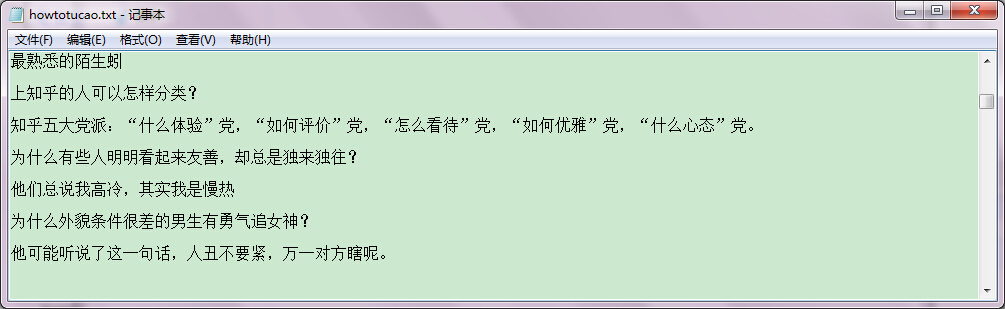

等运行完毕,我们打开文件howtoTucao.txt,可以看到,这样就爬取成功了。只是格式可能还是有点问题,原来是我No Answer没加换行,所以No Answer还会混到文本里面去,加两个换行就可以了。

结果在这 : 点我

说明

有朋友说好像这个内容有人写过 : http://www.cnblogs.com/fengfenggirl/p/zhihu_shenhuifu.html

他跟我写的不同,大家也可以看看,这里并无借鉴与抄袭。

优化及修正

文章发出后,收到了一些朋友,前辈的指导,进行了修正:

1.可以爬取全部内容

2.格式的修正

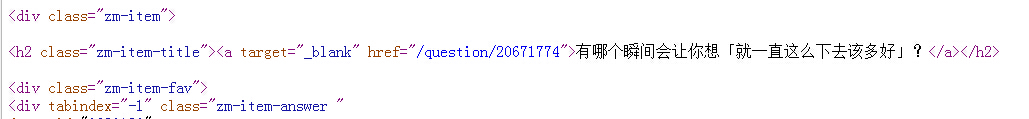

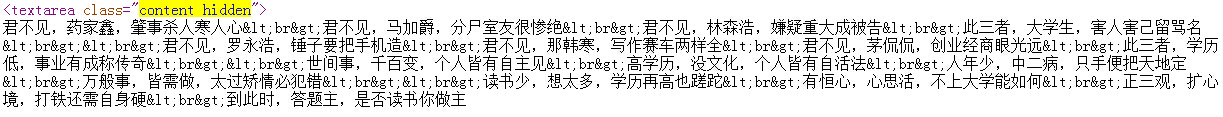

由上图我们知道,全部内容是在content hidden中的,之前我因为不知道如何处理<span..那一段,所以就没有爬全部内容,而是简略地爬取了部分内容。

其实去掉那一段并不难,用正则表达式匹配:

nowstring = re.sub('<s.+>

<a.+>

<.+>

','',each.a.string)

即可。

然后就是一些格式的整理,由下图我们看到,爬取出的内容会有很多<..> 这只有html才能够解析,放到txt文件中就不能解析,从而出现这些字符,影响阅读,所以我们也用正则将它们去掉。

除了<br>用换行符代替外,其余的我们都用''空串来代替,并且将图片等也换掉。

修正后代码

# -*- coding: cp936 -*- import urllib2 import re from BeautifulSoup import BeautifulSoup f = open('howtoTucao.txt','w') #open the file for pagenum in range(1,21): strpagenum = str(pagenum) print "Getting data for Page " + strpagenum #for we can see the process in shell url = "http://www.zhihu.com/collection/27109279?page="+strpagenum page = urllib2.urlopen(url) #get the web page soup = BeautifulSoup(page) #use BeautifulSoup to parsing the web page ALL = soup.findAll(attrs = {'class' : ['zm-item-title','content hidden'] }) for each in ALL : if each.name == 'h2' : nowstring = re.sub('<s.+> <a.+> <.+> ','',each.a.string) nowstring = re.sub('<br>',' ',nowstring) nowstring = re.sub('<w+>','',nowstring) nowstring = re.sub('</w+>','',nowstring) nowstring = re.sub('<.+>',' 图片 ',nowstring) nowstring = re.sub('"','"',nowstring) print nowstring if nowstring: f.write(nowstring) else : f.write(" No Answer ") else : nowstring = re.sub('<s.+> <a.+> <.+> ','',each.string) nowstring = re.sub('<br>',' ',nowstring) nowstring = re.sub('<w+>','',nowstring) nowstring = re.sub('</w+>','',nowstring) nowstring = re.sub('<.+>',' 图片 ',nowstring) nowstring = re.sub('"','"',nowstring) print nowstring if nowstring: f.write(nowstring) else : f.write(" No Answer ") f.close() #close the file

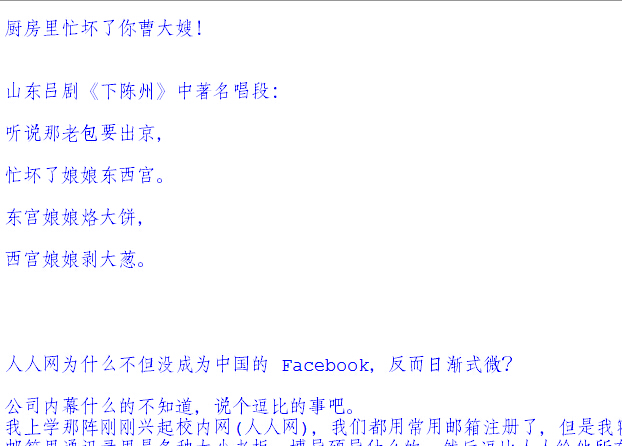

修正后结果

这样就可以了。

感谢网友 Anonymous Coward , 盛强 提供建议!

结果可在我的github中查看。