Graph Neural Networks:A Review of Methods and Applications论文研读

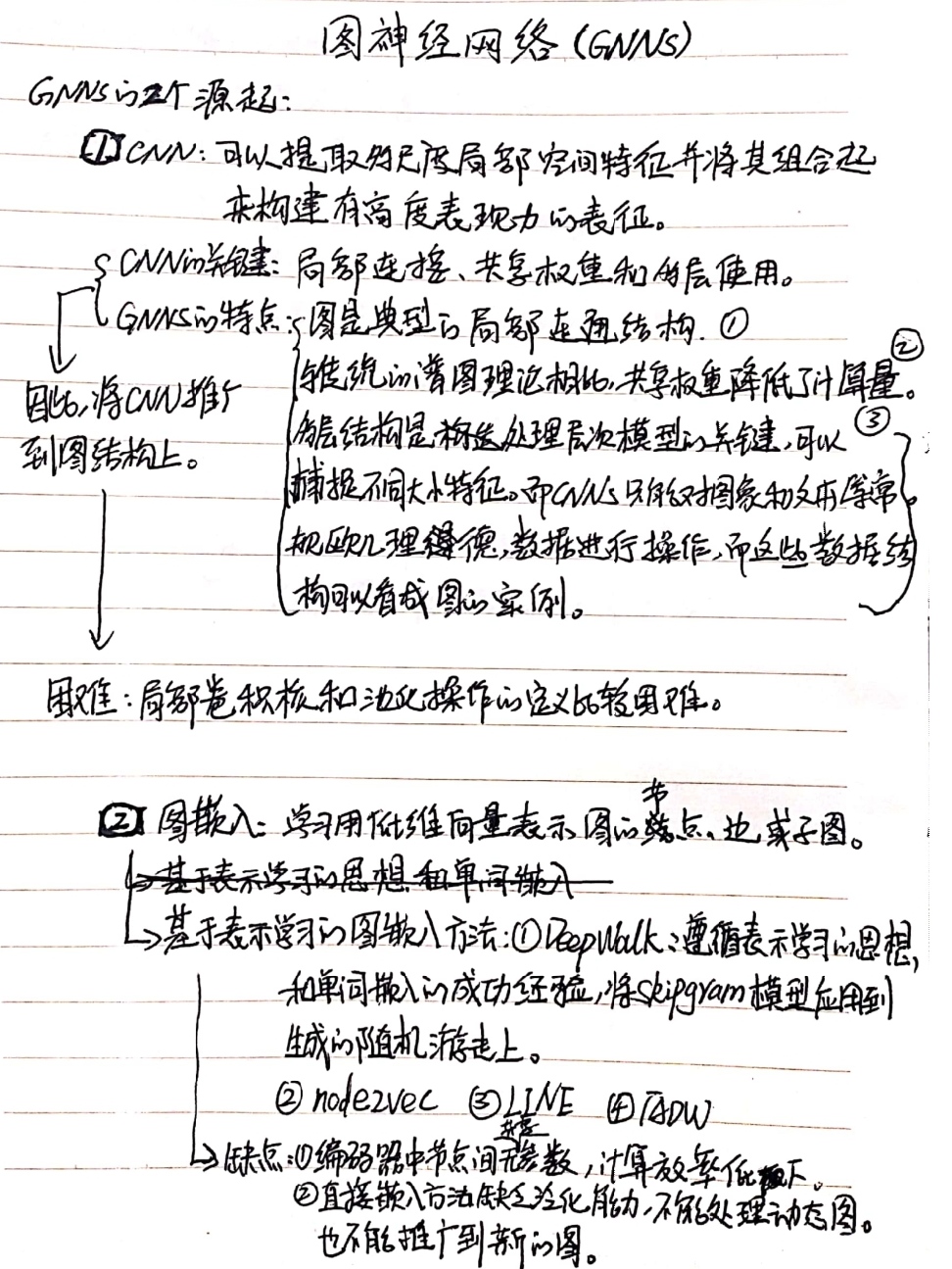

2.1 图神经网络源起

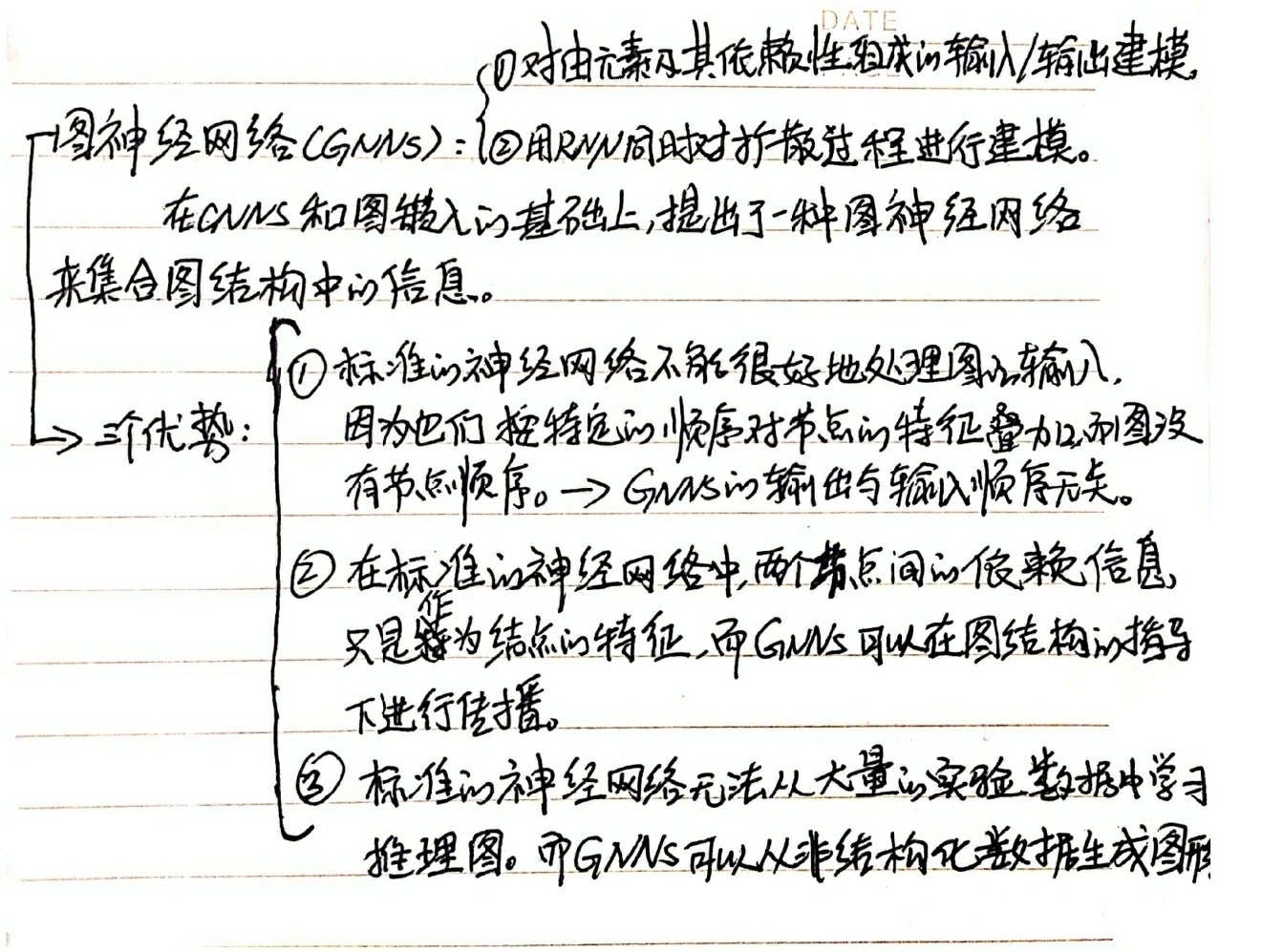

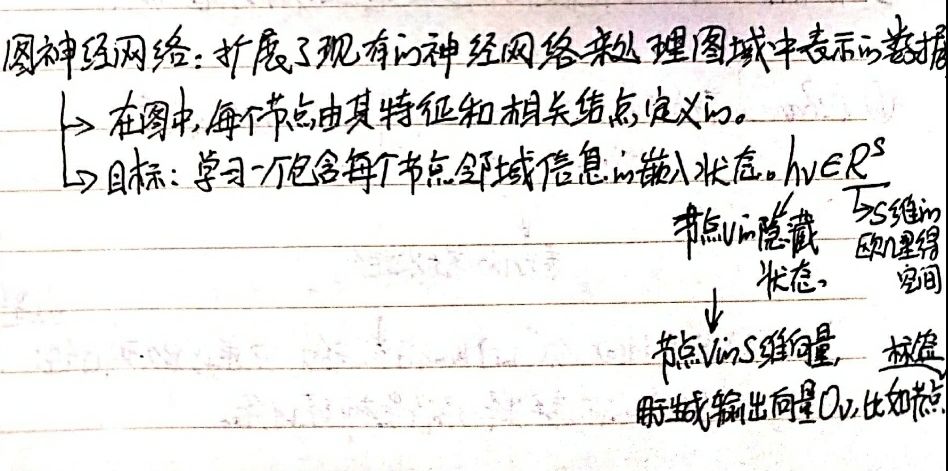

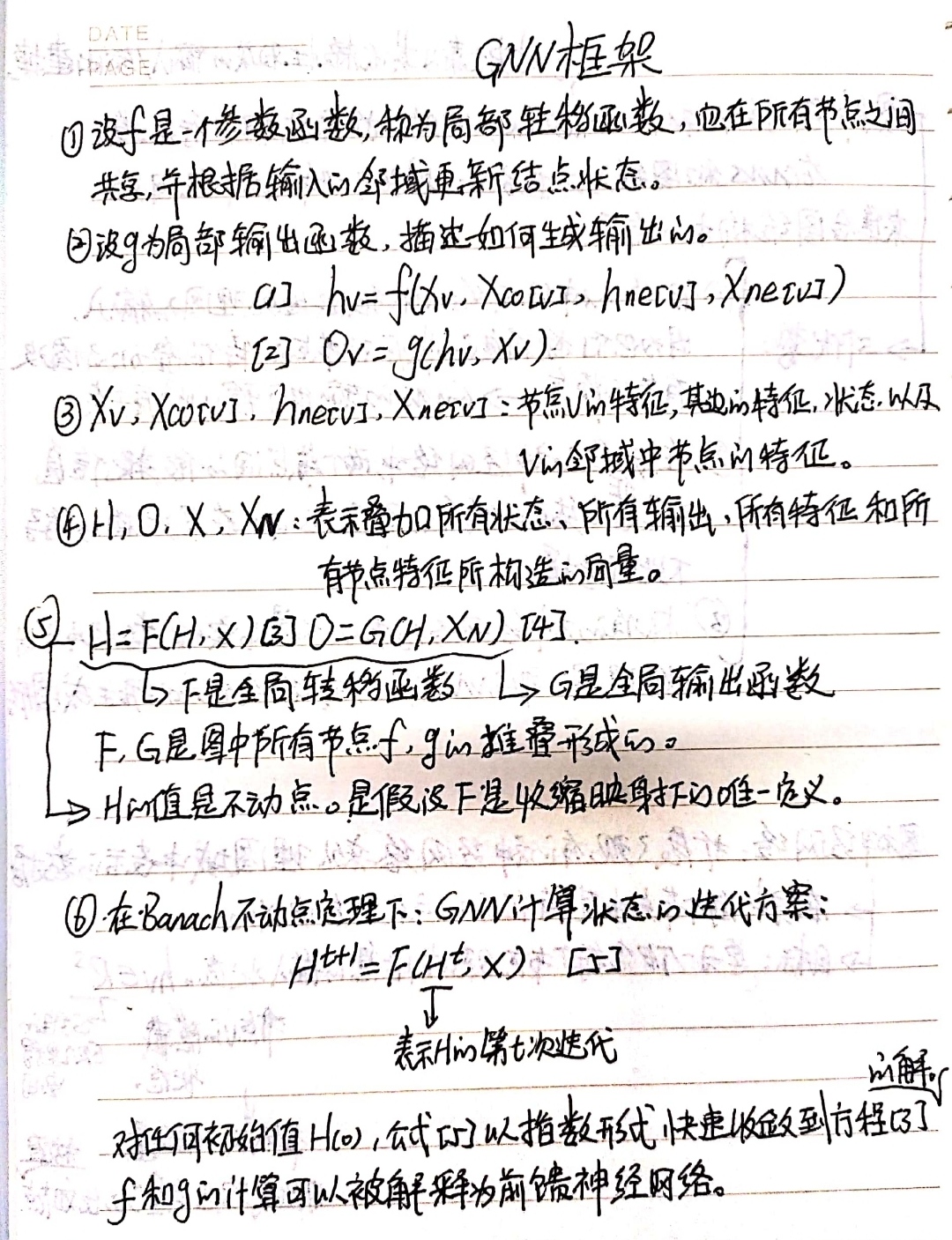

2.2 图神经网络基本参数定义:

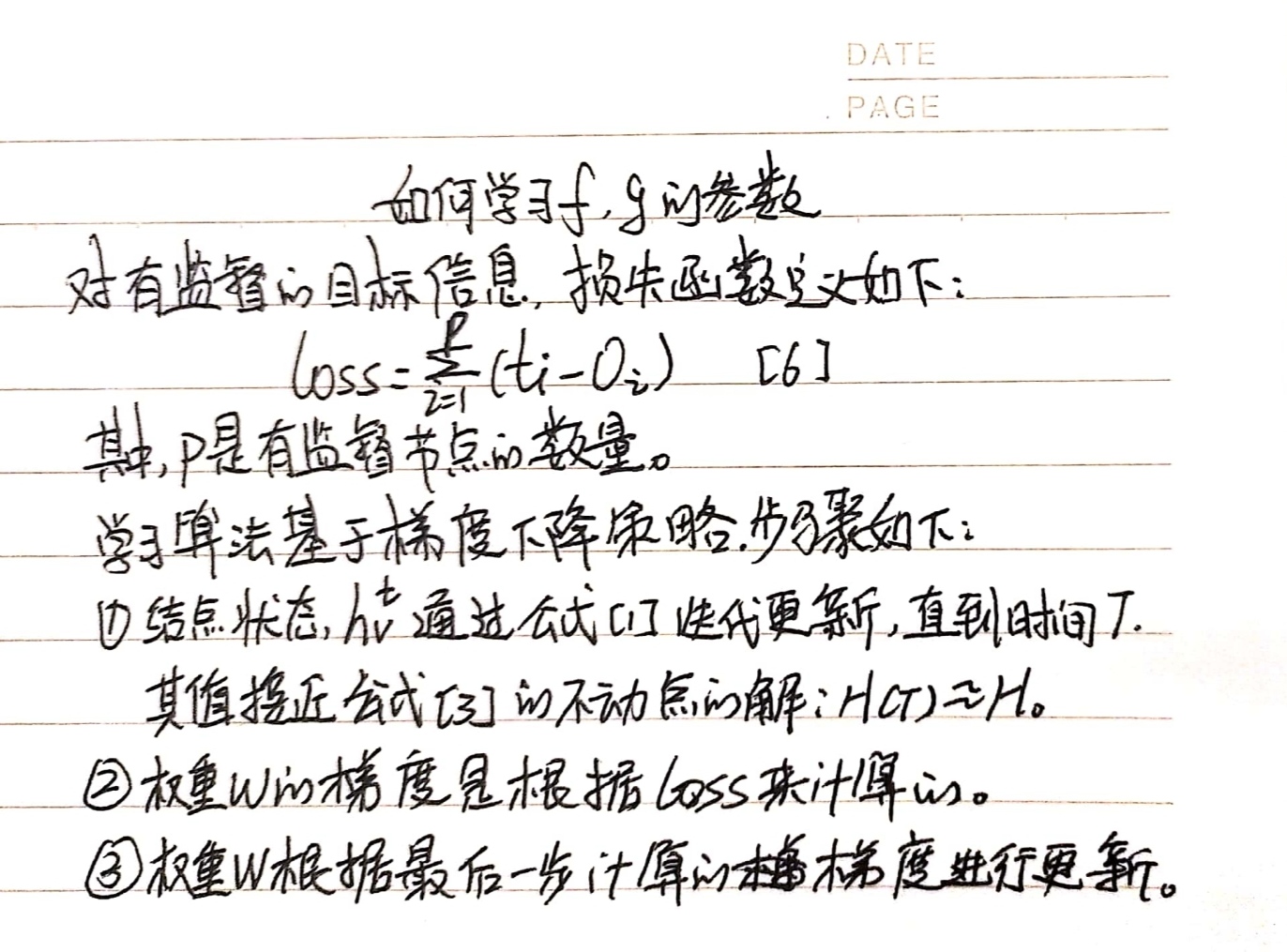

2.3 f、g参数的学习

2.4 GNN的局限性

首先,对于不动点,迭代更新节点的隐藏状态是低效的。如果放松不动点的假设,我们可以设计一个多层GNN来获得节点及其邻域的稳定表示。

其次,GNN在迭代过程中使用相同的参数,而大多数流行的神经网络在不同的层次上使用不同的参数,这是一种分层的特征提取方法。此外,节点隐藏状态的更新是一个连续的过程,可以借鉴GRU和LSTM等RNN内核。

第三,在原始GNN中,边缘也存在一些无法有效建模的信息特征。例如,知识图中的边具有关系类型,通过不同边的消息传播应根据其类型而不同。另外,如何学习边缘的隐藏状态也是一个重要的问题。最后,如果我们把注意力集中在节点的表示而不是图的表示上,则不适合使用不动点,因为表示在不动点上的分布在值上比较平滑,对于区分每个节点的信息量较少。

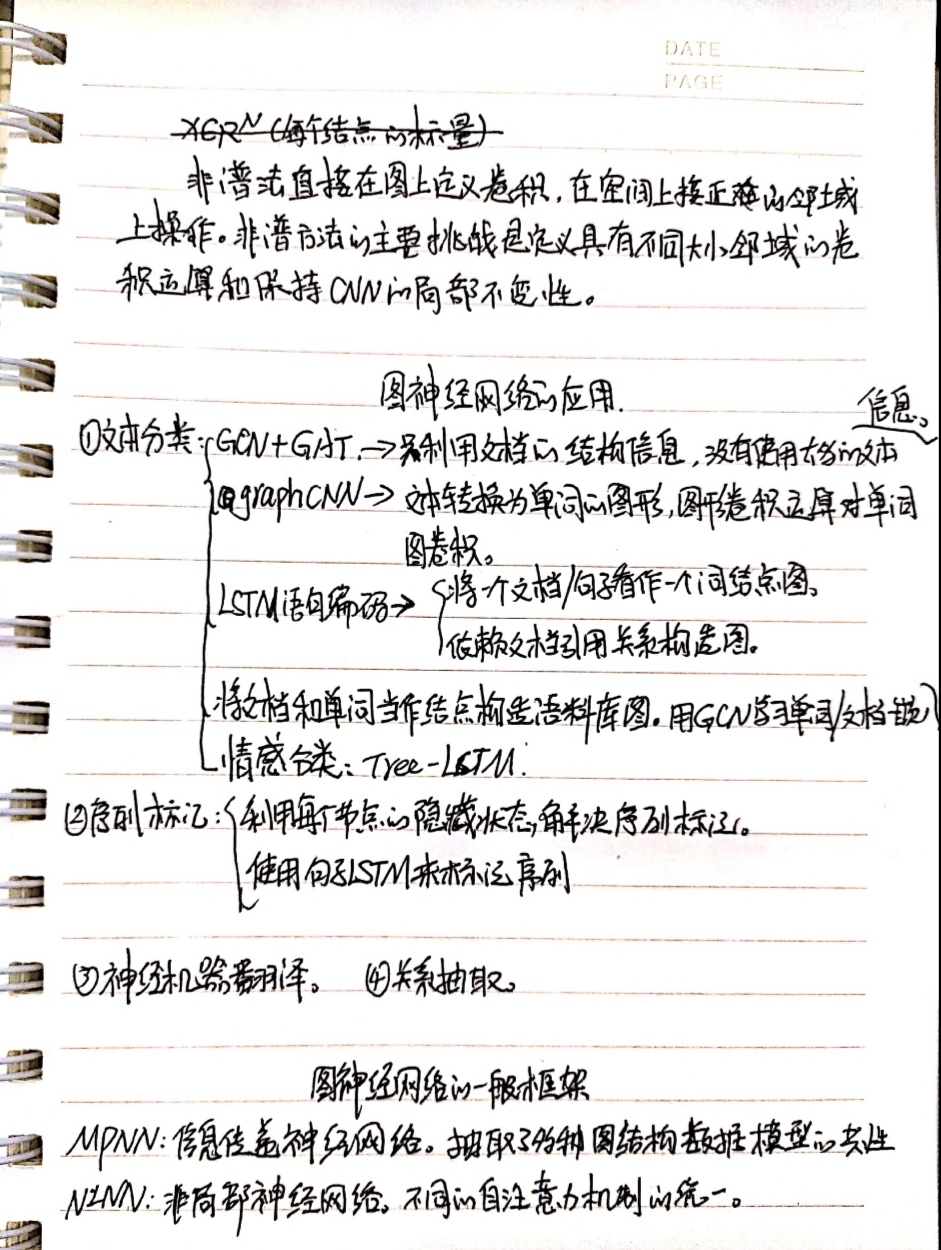

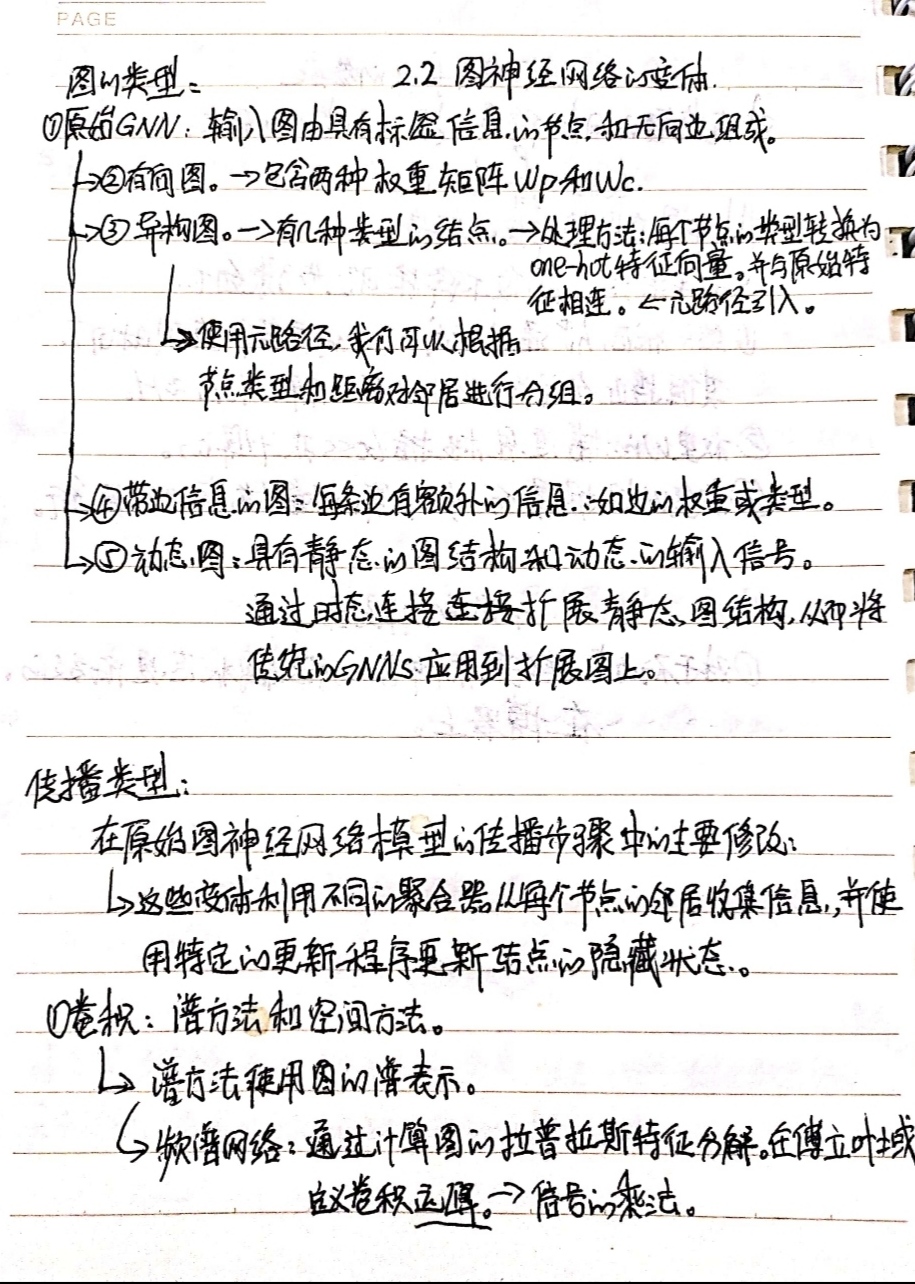

2.5 图神经网络的变体

2.6 图神经网络在自然语言处理领域的应用