ResNet

paper:Deep Residual Learning for Image Recognition

Highlight

引入残差映射,使网络的深度有了极大的提升。

Abstract

针对神经网络增加深度后会难以训练的问题,作者提出了残差学习框架。残差结构引入了输入,在ImageNet数据集上构建了一个152层的神经网络,但是复杂度却比16层的VGG更小。

Introduction

网络的深度很重要,可以提取更高层次的特征。

随着网络加深,出现梯度消失,梯度爆炸的问题。可以被初始归一化和中间归一化层解决。

网络退化问题:精度达到饱和,随后快速下降,贴一个解释陈默。

非线性的激活函数将数据映射到高维空间以便进行分类,随着网络的加深,数据被映射到了更加离散的状态,难以回到原始的状态。

作者使用残差映射代替原来的隐式映射,更容易学习。

(H(x)=F(x)+x),没有增加额外的计算量,更容易训练,随着网络深度增加,能得到更好的效果。

Deep Residual Learning

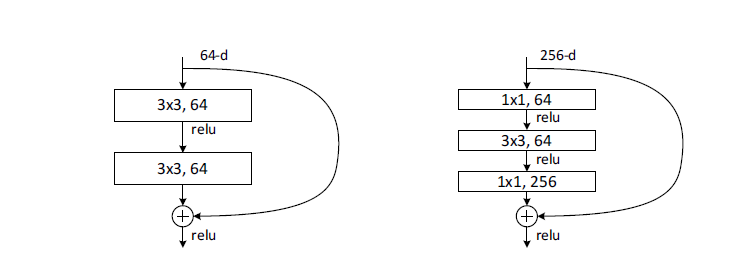

残差结构的输入和输出维度相同:(y=mathcal{F}(x,{W_i})+x)

对于维度不同的输入和输出使用一个1*1的卷积核改变channel:(y=mathcal{F}(x,{W_i})+W_sx),一般出现在channel发生变化处。

element-wise addition,输入和变换后的输出逐元素相加。

左图用在ResNet-53,右图用在ResNet-101上;右图相对于作图计算量更少,可以支持加深网络带来的计算量增大。