手写很累,复制的同学请点赞犒劳下在下哦 ^_^

一、对于.CSV类型的数据

它们的数据导入都很简单

且看下面一顿操作:

我平时一般是读取整个文件,直接这样就可以了:

1 import pandas as pd 2 data = pd.read_csv('test.csv',encoding = 'GBK', engine="python")

得到的,是一个DataFrame类型的data,不熟悉处理方法可以参考pandas十分钟入门

如有 OSError: Initializing from file failed 这样的错误,就是没有加 engine = "python"

还有一种方法就是用CSV库:

1 import csv 2 3 with open("test.csv","r") as csvfile: 4 data = csv.reader(csvfile) 5 #这里不需要readlines 6 for line in data: 7 print line

其次是写入,一般简单的写入只需要:

1 import pandas as pd 2 3 #这里只是范例,a,b可根据实际替换为你想写入的内容 4 #搞出来一个字典,然后转成dataframe类型 5 a = [1,2,3] 6 b = [4,5,6] 7 dataframe = pd.DataFrame({'a_name':a,'b_name':b}) 8 9 #将DataFrame存储为csv格式, index表示是否显示行名,default=True 10 dataframe.to_csv("test.csv",index=False,sep=',')

ok 完工

需求高一点的就是逐行写。

1 import csv 2 3 with open("test.csv","w") as csvfile: 4 data = csv.writer(csvfile) 5 6 #先写入columns_name 7 data.writerow(["index","a_name","b_name"]) 8 #写入多行用writerows 9 data.writerows([[0,1,3],[1,2,3],[2,3,4]])

二、.txt 就简单了

直接上去三板斧

1 f = open('/test.txt') 2 3 f.read() 4 5 f.close()

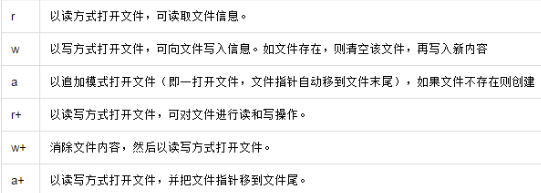

需要注意的是,f.write()有坑,要注意模式,

1 f1 = open('/test.txt','w') 2 f1.write('hello buddy!')

但此时数据只写到了缓存中,并未保存到文件,而且从下面的输出可以看到,原先里面的配置被清空了然后就囧了。

使用r+ 模式不会先清空,但是会替换掉原先的文件。

如果在写之前先读取一下文件,再进行写入,则写入的数据会添加到文件末尾而不会替换掉原先的文件。这是因为指针引起的,r+ 模式的指针默认是在文件的开头,如果直接写入,则会覆盖源文件,通过read() 读取文件后,指针会移到文件的末尾,再写入数据就不会有问题了。这里也可以使用a 模式。

三、.dat文件很方便,因为他既能转成.txt,他的格式也很方便,一般都是用”,“或者”::“分割开。

处理的话,我是用

users = pd.read_table(path+'users.dat',sep = '::',header=None, names = unames,engine='python')

这种方法的,path可以定义一个绝对路径,移植的时候也很方便。

四、.json文件的读写

pandas库还为我们提供了可以读取很多种类文件类型的函数。

我就不一一列举示例了,调用很简单,而且很多编辑器也会给你一些参数上的提示。

Json文件是相当常见一种文件类型。对于这类数据的读取,极其极其简单。

直接上个例子:

设Json文件

{

"fontFamily": "微软雅黑",

"fontSize": 12,

"BaseSettings":{

"font":1,

"size":2

}

}

只需要这样读取:

1 import json 2 3 def loadFont(): 4 f = open("Settings.json", encoding='utf-8') //设置以utf-8解码模式读取文件,encoding参数必须设置,否则默认以gbk模式读取文件,当文件中包含中文时,会报错 5 setting = json.load(f) //其实读取的核心就是这个函数 6 family = setting['BaseSettings']['size'] //注意多重结构的读取语法 7 size = setting['fontSize'] 8 return family, size 9 10 t,x = loadFont() 11 12 print(t) 13 #将会返回t值为2, x为12

how easy it is

.txt文件可以直接用pandas中的pd.read_csv('filename')直接傻瓜式读写。参见最上面csv文件的读写。

类型转换格式对应表:

| JSON | Python |

| Object | dict |

| array | list |

| String | unicode |

| number(int) | int, long |

| number(real) | float |

| true | True |

| false | False |

| null | None |

使用第三方库:Demjson

Demjson是python的第三方模块库,可用于编码和解码JSON数据,包括了JSONLint的格式化及校验功能。

linux安装:

环境配置

在使用 Demjson 编码或解码 JSON 数据前,我们需要先安装 Demjson 模块。本教程我们会下载 Demjson 并安装:

$ tar -xvzf demjson-2.2.3.tar.gz $ cd demjson-2.2.3 $ python setup.py install

更多安装介绍查看:http://deron.meranda.us/python/demjson/install

JSON函数

| 函数 | 描述 |

| encode | 将python对象编码成JSON字符串 |

| decode | 将一遍吗的JSON字符串解码为Python对象 |

Encode语法:

demjson.encode(self, obj, nest_level=0)

实例:

以下实例将数组编码为 JSON 格式数据:

#!/usr/bin/python

import demjson

data = [ { 'a' : 1, 'b' : 2, 'c' : 3, 'd' : 4, 'e' : 5 } ]

json = demjson.encode(data)

print json

执行结果为: [{"a":1,"b":2,"c":3,"d":4,"e":5}]

Decode:解码 JSON 数据。该函数返回 Python 字段的数据类型。

语法:

demjson.decode(self, txt)

示例:

import demjson

json = '{"a":1,"b":2,"c":3,"d":4,"e":5}';

text = demjson.decode(json)

print text

执行结果为: {u'a': 1, u'c': 3, u'b': 2, u'e': 5, u'd': 4}

导入数据

- pd.read_csv(filename):从CSV文件导入数据

- pd.read_table(filename):从限定分隔符的文本文件导入数据

- pd.read_excel(filename):从Excel文件导入数据

- pd.read_sql(query, connection_object):从SQL表/库导入数据

- pd.read_json(json_string):从JSON格式的字符串导入数据

- pd.read_html(url):解析URL、字符串或者HTML文件,抽取其中的tables表格

- pd.read_clipboard():从你的粘贴板获取内容,并传给read_table()

- pd.DataFrame(dict):从字典对象导入数据,Key是列名,Value是数据

导出数据

- df.to_csv(filename):导出数据到CSV文件

- df.to_excel(filename):导出数据到Excel文件

- df.to_sql(table_name, connection_object):导出数据到SQL表

- df.to_json(filename):以Json格式导出数据到文本文件

创建测试对象

- pd.DataFrame(np.random.rand(20,5)):创建20行5列的随机数组成的DataFrame对象

- pd.Series(my_list):从可迭代对象my_list创建一个Series对象

- df.index = pd.date_range('1900/1/30', periods=df.shape[0]):增加一个日期索引

查看、检查数据

- df.head(n):查看DataFrame对象的前n行

- df.tail(n):查看DataFrame对象的最后n行

- df.shape():查看行数和列数

- :查看索引、数据类型和内存信息

- df.describe():查看数值型列的汇总统计

- s.value_counts(dropna=False):查看Series对象的唯一值和计数

- df.apply(pd.Series.value_counts):查看DataFrame对象中每一列的唯一值和计数

数据选取

- df[col]:根据列名,并以Series的形式返回列

- df[[col1, col2]]:以DataFrame形式返回多列

- s.iloc[0]:按位置选取数据

- s.loc['index_one']:按索引选取数据

- df.iloc[0,:]:返回第一行

- df.iloc[0,0]:返回第一列的第一个元素

数据清理

- df.columns = ['a','b','c']:重命名列名

- pd.isnull():检查DataFrame对象中的空值,并返回一个Boolean数组

- pd.notnull():检查DataFrame对象中的非空值,并返回一个Boolean数组

- df.dropna():删除所有包含空值的行

- df.dropna(axis=1):删除所有包含空值的列

- df.dropna(axis=1,thresh=n):删除所有小于n个非空值的行

- df.fillna(x):用x替换DataFrame对象中所有的空值

- s.astype(float):将Series中的数据类型更改为float类型

- s.replace(1,'one'):用‘one’代替所有等于1的值

- s.replace([1,3],['one','three']):用'one'代替1,用'three'代替3

- df.rename(columns=lambda x: x + 1):批量更改列名

- df.rename(columns={'old_name': 'new_ name'}):选择性更改列名

- df.set_index('column_one'):更改索引列

- df.rename(index=lambda x: x + 1):批量重命名索引

数据处理:Filter、Sort和GroupBy

- df[df[col] > 0.5]:选择col列的值大于0.5的行

- df.sort_values(col1):按照列col1排序数据,默认升序排列

- df.sort_values(col2, ascending=False):按照列col1降序排列数据

- df.sort_values([col1,col2], ascending=[True,False]):先按列col1升序排列,后按col2降序排列数据

- df.groupby(col):返回一个按列col进行分组的Groupby对象

- df.groupby([col1,col2]):返回一个按多列进行分组的Groupby对象

- df.groupby(col1)[col2]:返回按列col1进行分组后,列col2的均值

- df.pivot_table(index=col1, values=[col2,col3], aggfunc=max):创建一个按列col1进行分组,并计算col2和col3的最大值的数据透视表

- df.groupby(col1).agg(np.mean):返回按列col1分组的所有列的均值

- data.apply(np.mean):对DataFrame中的每一列应用函数np.mean

- data.apply(np.max,axis=1):对DataFrame中的每一行应用函数np.max

数据合并

- df1.append(df2):将df2中的行添加到df1的尾部

- df.concat([df1, df2],axis=1):将df2中的列添加到df1的尾部

- df1.join(df2,on=col1,how='inner'):对df1的列和df2的列执行SQL形式的join

数据统计

- df.describe():查看数据值列的汇总统计

- df.mean():返回所有列的均值

- df.corr():返回列与列之间的相关系数

- df.count():返回每一列中的非空值的个数

- df.max():返回每一列的最大值

- df.min():返回每一列的最小值

- df.median():返回每一列的中位数

- df.std():返回每一列的标准差