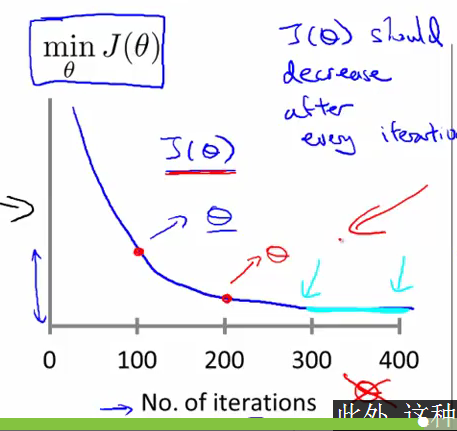

- degugging:make sure gradient descent is working correctly

- cost function(J(θ)) of Number of iteration :cost function随着迭代次数增加的变化函数

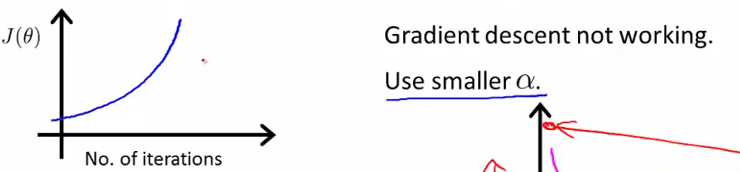

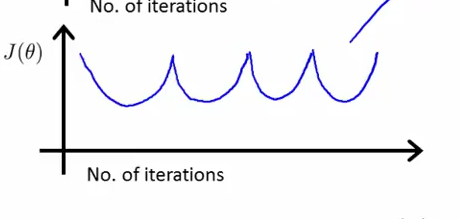

- 运行错误的图象是什么样子的:cost function(J(θ)) of Number of iteration随着迭代次数增加而上升(如以下两种图像的情况),应使用较小的learning rate

- 运行正确的图象是什么样子的:cost function(J(θ)) of Number of iteration应该是递减的并且随着迭代次数增加它趋于一条平缓的曲线(即收敛于一个固定的值)

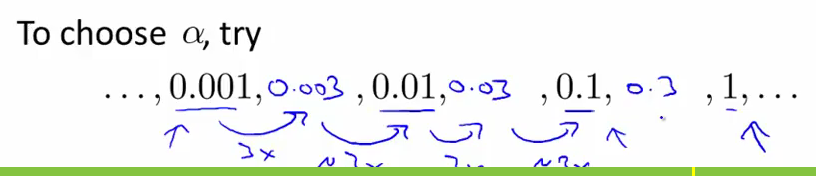

- how to choose learning rate(∂)

- 若learning rate太小: 收敛速度会很慢

- 若learning rate太大: gradient descent不会收敛,会出现随着迭代次数的增加,cost function反而变大的情况,这时我们要选择较小的learning rate去尝试。

- 可供选择的一些learning rate值: 0.3, 0.1, 0.03, 0.01 and so on(3倍)

- 在进行gradient drscent时,我们会尝试一些不同的learning rate,然后绘制出不同的ost function(J(θ)) of Number of iteration曲线,然后选择一个使cost function 快速下降的learning rate.

- 如何选择最佳的learning rate

尝试这些不同的learning rate找到一个最大的learning rate(若再大则不会收敛)或者比最大稍小一点的learning rate