开启一个软件: 1、hadoop-daemon.sh start namenode 2、hadoop-daemon.sh start datanode 3、hadoop-daemon.sh start secondarynamenode (hadoop-daemon.sh stop 关闭一个软件) 4、yarn-daemon.sh start resourcemanager 5、yarn-daemon.sh start nodemanager start-dfs.sh 一次性打开三个软件1、2、3 HDFS开启服务 stop-dfs.sh 一次性关闭三个软件1、2、3 start-yarn.sh 一次性打开两个软件4、5 MapReduce使用 stop-yarn.sh 一次性关闭两个软件4、5 start-all.sh 一次性打开5个软件1、2、3、4、5 stop-all.sh 一次性关闭5个软件1、2、3、4、5

vim /etc/hostname

主:hdp01

克隆:hdp02

修改主机映射(两台的主机名及ip)

vim /etc/hosts hdp01 192.168.0.32 hdp02 192.168.0.42

配置免密

ssh-keygen

ssh-copy-id 主机名

ssh 主机名(测试是否免密成功)

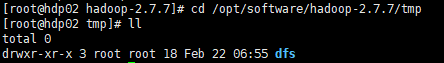

删除tmp下的目录文件(克隆的主机也要删除)

rm -rf * //删除tmp目录下的文件

配置hdfs-site.xml(克隆的也需要配置)

vim /opt/software/hadoop-2.7.7/etc/hadoop/hdfs-site.xml <configuration> <property> <name>dfs.replication</name> <value>3</value> </property> </configuration>

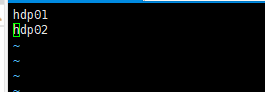

配置slaves

vim /opt/software/hadoop-2.7.7/etc/hadoop/slaves hdp01 hdp02

格式化hadoop

hadoop namenode -format

启动namenode以及datanode节点(目前只需要用到hdfs服务)

start-dfs.sh

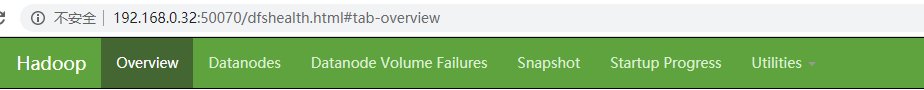

访问50070端口