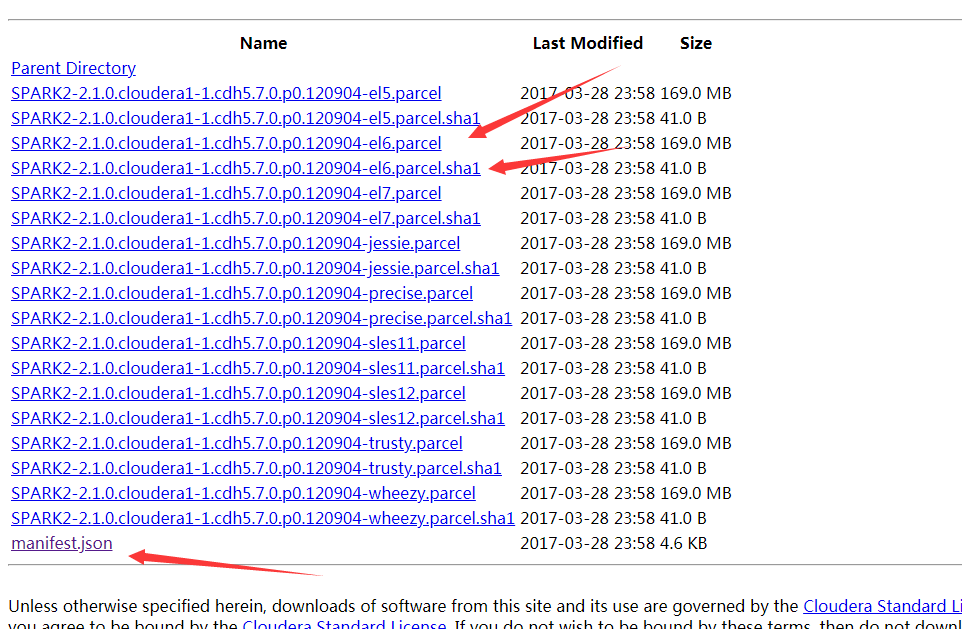

1.先到http://archive.cloudera.com/spark2/parcels/2.1.0.cloudera1/ 下载需要的文件比如我linux版本需要是6的 hadoop6需要下载这些文件

记得sha1改成sha

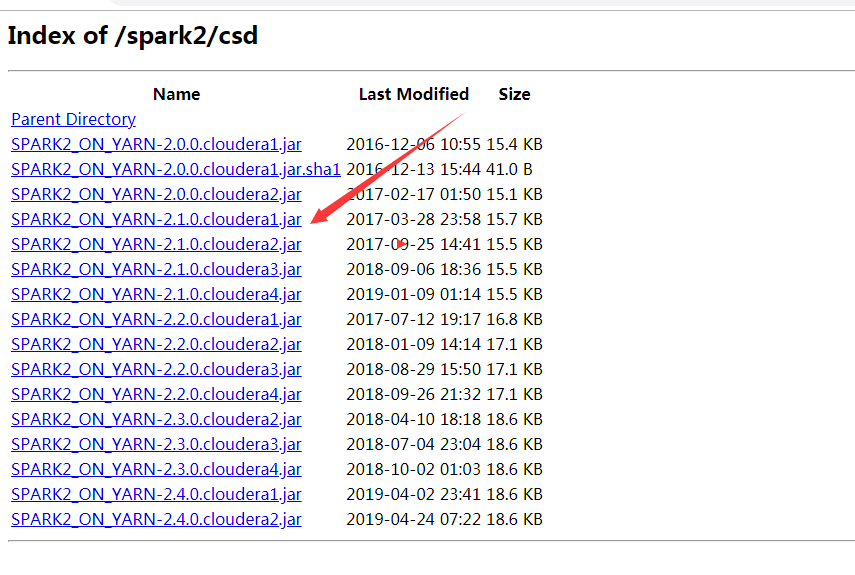

(上面这些是spark的组件文件),还需要CDH的监控文件,http://archive.cloudera.com/spark2/csd/ scd包,选择对应的版本

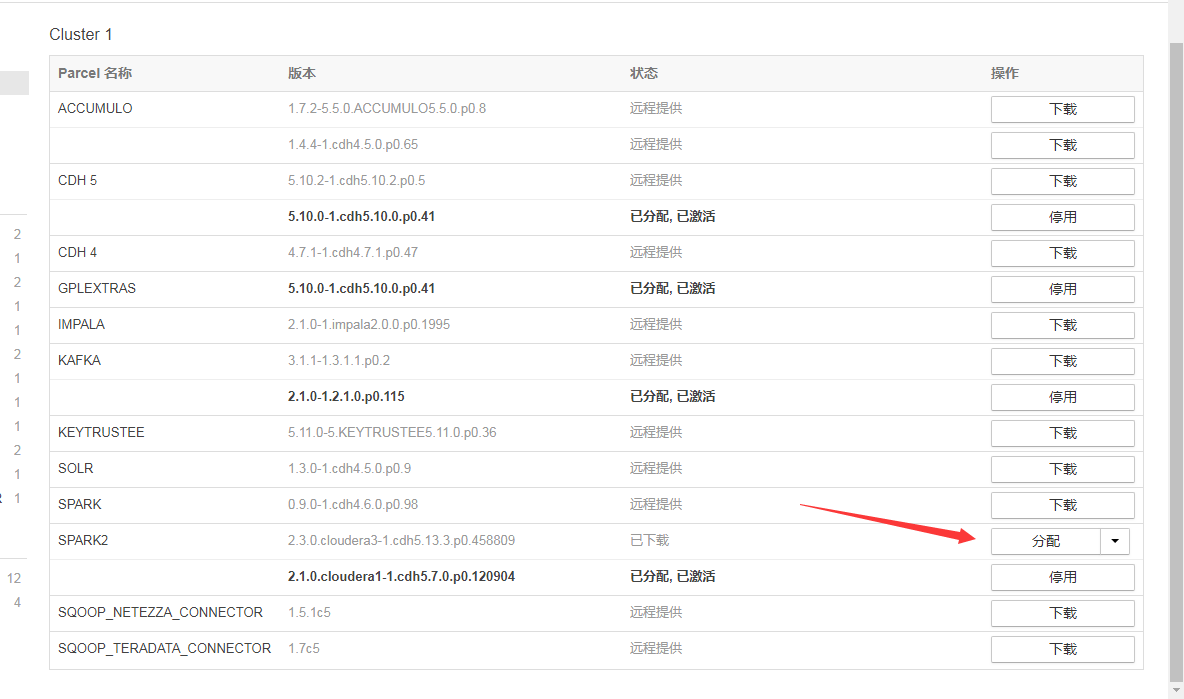

然后分别放到/opt/cloudera/parcel-repo 和 /opt/cloudera/csd 目录中。如果有相同名字文件记得把以前的备份下删了或者改下后缀名。

把以前老的不用的spark全部停止掉(我停止后也删除了避免影响)

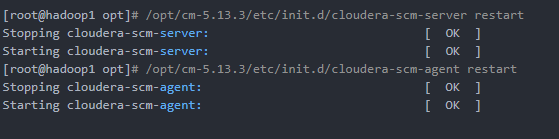

关闭CDH全部功能。重启服务

激活自己的spark并分配到节点,可以从添加服务中把spark添加到界面

记得这个管理工具也要重启,不然会监控不到新的spark。

期间启动spark服务雨大hdfs://nameservice1/user/spark/applicationHistory这个目录不存在的问题,自己在hdfs手动建立后重启成功。

mark:问了下运维的同事CDH5不能安装spark过新版本,我看我们环境安装过2.3,至于能支持到什么版本应该要提前看看再找对应的parcel