这里将讲解tensorflow是如何通过计算图来更新变量和最小化损失函数来反向传播误差的;这步将通过声明优化函数来实现。一旦声明好优化函数,tensorflow将通过它在所有的计算图中解决反向传播的项。当我们传入数据,最小化损失函数,tensorflow会在计算图中根据状态相应的调节变量。

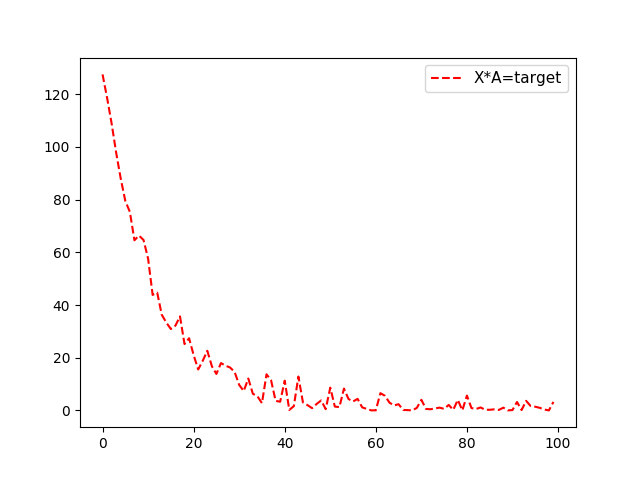

这里先举一个简单的例子,从均值1,标准差为0.1的正态分布中随机抽样100个数,然后乘以变量A,损失函数L2正则函数,也就是实现函数X*A=target,X为100个随机数,target为10,那么A的最优结果也为10。

实现如下:

import matplotlib.pyplot as plt import numpy as np import tensorflow as tf from tensorflow.python.framework import ops ops.reset_default_graph() # 创建计算图 sess = tf.Session() #生成数据,100个随机数x_vals以及100个目标数y_vals x_vals = np.random.normal(1, 0.1, 100) y_vals = np.repeat(10., 100) #声明x_data、target占位符 x_data = tf.placeholder(shape=[1], dtype=tf.float32) y_target = tf.placeholder(shape=[1], dtype=tf.float32) # 声明变量A A = tf.Variable(tf.random_normal(shape=[1])) #乘法操作,也就是例子中的X*A my_output = tf.multiply(x_data, A) #增加L2正则损失函数 loss = tf.square(my_output - y_target) # 初始化所有变量 init = tf.initialize_all_variables() sess.run(init) #声明变量的优化器;大部分优化器算法需要知道每步迭代的步长,这距离是由学习控制率。 my_opt = tf.train.GradientDescentOptimizer(0.02) train_step = my_opt.minimize(loss) #训练,将损失值加入数组loss_batch loss_batch = [] for i in range(100): rand_index = np.random.choice(100) rand_x = [x_vals[rand_index]] rand_y = [y_vals[rand_index]] sess.run(train_step, feed_dict={x_data: rand_x, y_target: rand_y}) print('Step #' + str(i + 1) + ' A = ' + str(sess.run(A))) print('Loss = ' + str(sess.run(loss, feed_dict={x_data: rand_x, y_target: rand_y}))) temp_loss = sess.run(loss, feed_dict={x_data: rand_x, y_target: rand_y}) loss_batch.append(temp_loss) plt.plot( loss_batch, 'r--', label='Batch Loss, size=20') plt.legend(loc='upper right', prop={'size': 11}) plt.show()

输出结果(输出A以及对应的损失函数):

Step #1 A = [ 0.08779037]

Loss = [ 98.3597641]

Step #2 A = [ 0.48817557]

Loss = [ 90.38272095]

Step #3 A = [ 0.85985768]

Loss = [ 83.92495728]

Step #4 A = [ 1.289047]

Loss = [ 71.54370117]

.........

Step #98 A = [ 10.10386372]

Loss = [ 0.00271681]

Step #99 A = [ 10.10850525]

Loss = [ 0.01301978]

Step #100 A = [ 10.07686806]

Loss = [ 0.5048126]

对于损失函数看这里:tensorflow进阶篇-4(损失函数1),tensorflow进阶篇-4(损失函数2),tensorflow进阶篇-4(损失函数3)