部署keepalived 和 haproxy

使用 keepalived 和 haproxy 实现 kube-apiserver 高可用:

-keepalived 提供 kube-apiserver 对外服务的 VIP;

haproxy 监听 VIP,后端连接所有 kube-apiserver 实例,提供健康检查和负载均衡功能;

-运行 keepalived 和 haproxy 的节点称为 LB 节点。由于 keepalived 是一主多备运行模式,故至少两个 LB 节点。

-本文档复用 master 节点的三台机器,haproxy 监听的端口(8443) 需要与 kube-apiserver 的端口 6443 不同,避免冲突。

-keepalived 在运行过程中周期检查本机的 haproxy 进程状态,如果检测到 haproxy 进程异常,则触发重新选主的过程,VIP 将飘移到新选出来的主节点,从而实现 VIP 的高可用。

-所有组件(如 kubeclt、kube-controller-manager、kube-scheduler、kube-proxy 等)都通过 VIP 和 haproxy 监听的 8443 端口访问 kube-apiserver 服务。

注意:如果基础网络不支持 VRRP 协议,或者节点有限制,则本方案可能不适用,可以参考另一种节点本地 Proxy 的方案

安装软件包

yum install -y keepalived haproxy

yum安装完后是如下版本:

keepalived-1.3.5-19.el7.x86_64

haproxy-1.5.18-9.el7.x86_64

部署haproxy

配置和下发 haproxy 配置文件

cat > /etc/haproxy/haproxy.cfg <<EOF

global

log /dev/log local0

log /dev/log local1 notice

chroot /var/lib/haproxy

stats socket /var/run/haproxy-admin.sock mode 660 level admin

stats timeout 30s

user haproxy

group haproxy

daemon

nbproc 1

defaults

log global

timeout connect 5000

timeout client 10m

timeout server 10m

listen admin_stats

bind 0.0.0.0:10080

mode http

log 127.0.0.1 local0 err

stats refresh 30s

stats uri /status

stats realm welcome login Haproxy

stats auth admin:123456

stats hide-version

stats admin if TRUE

listen kube-master

bind 0.0.0.0:8443

mode tcp

option tcplog

balance source

server 10.0.0.10 10.0.0.10:6443 check inter 2000 fall 2 rise 2 weight 1

server 10.0.0.11 10.0.0.11:6443 check inter 2000 fall 2 rise 2 weight 1

server 10.0.0.12 10.0.0.12:6443 check inter 2000 fall 2 rise 2 weight 1

EOF

haproxy 在 10080 端口输出 status 信息;

haproxy 监听所有接口的 8443 端口,该端口与环境变量 ${KUBE_APISERVER} 指定的端口必须一致;

server 字段列出所有 kube-apiserver 监听的 IP 和端口;

下发 haproxy.cfg 到所有 master 节点:

scp haproxy.cfg 10.0.0.11:/etc/haproxy/

scp haproxy.cfg 10.0.0.11:/etc/haproxy/

启动haproxy 服务

systemctl enable haproxy && systemctl start haproxy && systemctl status haproxy

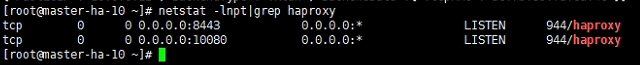

netstat -lnpt|grep haproxy

部署 keepalived

keepalived 是一主(master)多备(backup)运行模式,故有两种类型的配置文件。master 配置文件只有一份,backup 配置文件视节点数目而定,对于本文档而言,规划如下:

master: 10.0.0.10

backup: 10.0.0.11、 10.0.0.12

master配置文件:

1、router_id #主备不同

state MASTER #主备状态

priority 120 #三个优先级不同

interface ens33 #注意替换为自己的网卡名

虚拟ip地址 #注意替换为自己的。

cat > /etc/keepalived/keepalived.conf <<EOF

global_defs {

router_id lb-master

}

vrrp_script check-haproxy {

script "killall -0 haproxy"

interval 5

weight -30

}

vrrp_instance kube-master {

state MASTER

priority 120

dont_track_primary

interface ens33

virtual_router_id 90

advert_int 1

track_script {

check-haproxy

}

authentication {

auth_type PASS

auth_pass 123456

}

virtual_ipaddress {

10.0.0.252

}

}

EOF

VIP 所在的接口为ens33;

使用 killall -0 haproxy 命令检查所在节点的 haproxy 进程是否正常。如果异常则将权重减少(-30),从而触发重新选主过程;

router_id、virtual_router_id 用于标识属于该 HA 的 keepalived 实例,如果有多套 keepalived HA,则必须各不相同;

从master1

cat > /etc/keepalived/keepalived.conf <<EOF

global_defs {

router_id lb-backup

}

vrrp_script check-haproxy {

script "killall -0 haproxy"

interval 5

weight -30

}

vrrp_instance kube-master {

state BACKUP

priority 110

dont_track_primary

interface ens33

virtual_router_id 90

advert_int 1

track_script {

check-haproxy

}

authentication {

auth_type PASS

auth_pass 123456

}

virtual_ipaddress {

10.0.0.252

}

}

EOF

interface 指定 VIP 所在的接口;

使用 killall -0 haproxy 命令检查所在节点的 haproxy 进程是否正常。如果异常则将权重减少(-30),从而触发重新选主过程;

virtual_router_id 用于标识属于该 HA 的 keepalived 实例,如果有多套 keepalived HA,则必须各不相同,取值范围 [0, 255];

router_id 表示本机器,多台机器可以相同;

priority 的值必须小于 master 的值;

advert_int vip 通告的时间间隔;

authentication:使用密码认证,密码为上一步生成的随机密码,各实例的密码需要一致;

从master2

cat > /etc/keepalived/keepalived.conf <<EOF

global_defs {

router_id lb-backup

}

vrrp_script check-haproxy {

script "killall -0 haproxy"

interval 5

weight -30

}

vrrp_instance kube-master {

state BACKUP

priority 100

dont_track_primary

interface ens33

virtual_router_id 90

advert_int 1

track_script {

check-haproxy

}

authentication {

auth_type PASS

auth_pass 123456

}

virtual_ipaddress {

10.0.0.252

}

}

EOF

启动keepalived 服务

systemctl enable keepalived && systemctl start keepalived && systemctl status keepalived

systemctl restart keepalived && systemctl status keepalived

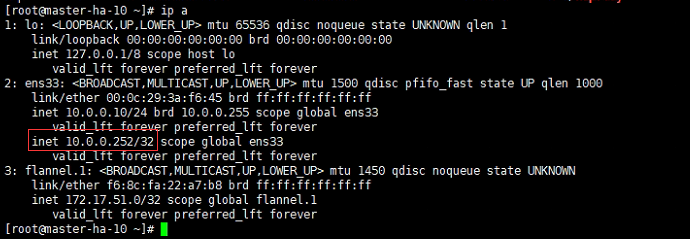

查看 VIP 所在的节点,确保可以 ping 通 VIP:

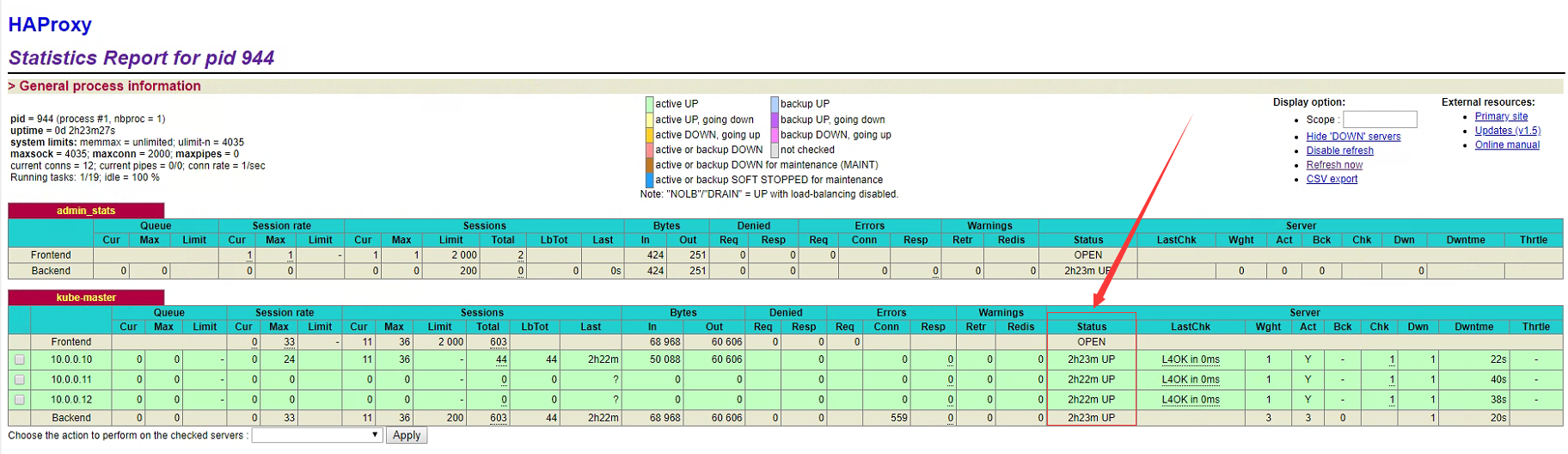

查看 haproxy 状态页面

浏览器访问vip http://10.0.0.252:10080/status 地址(账号/密码:admin:123456),查看 haproxy 状态页面:

由于还没有部署 kube-apiserver,所有后端状态都为 failed。

我这里的截图是整个部署完后的截图,所以状态都是ok的。

使用nginx替代上面的haproxy方案:

使用nginx方案的话,记得将keepalived配置文件里"killall -0 haproxy" 修改为"killall -0 nginx"

wget http://nginx.org/download/nginx-1.15.3.tar.gz

tar -xzvf nginx-1.15.3.tar.gz

cd nginx-1.15.3

yum install -y gcc make

mkdir /usr/local/nginx

./configure --with-stream --without-http --prefix=/usr/local/nginx/ --without-http_uwsgi_module --without-http_scgi_module --without-http_fastcgi_module

make && make install

/usr/local/nginx/sbin/nginx -v

cat > /usr/local/nginx/conf/kube-nginx.conf << EOF

worker_processes 1;

events {

worker_connections 1024;

}

stream {

upstream backend {

hash $remote_addr consistent;

server 10.0.0.10:6443 max_fails=3 fail_timeout=30s;

server 10.0.0.11:6443 max_fails=3 fail_timeout=30s;

server 10.0.0.12:6443 max_fails=3 fail_timeout=30s;

}

server {

listen 0.0.0.0:8443;

proxy_connect_timeout 1s;

proxy_pass backend;

}

}

EOF

cat > /usr/lib/systemd/system/nginx.service <<EOF

[Unit]

Description=kube-apiserver nginx proxy

After=network.target

After=network-online.target

Wants=network-online.target

[Service]

Type=forking

ExecStartPre=/usr/local/nginx/sbin/nginx -c /usr/local/nginx/conf/kube-nginx.conf

ExecStart=/usr/local/nginx/sbin/nginx -c /usr/local/nginx/conf/kube-nginx.conf

PrivateTmp=true

Restart=always

RestartSec=5

StartLimitInterval=0

LimitNOFILE=65536

[Install]

WantedBy=multi-user.target

EOF

systemctl daemon-reload && systemctl enable nginx

systemctl restart nginx && systemctl status nginx