本人也是初学者,学习过程中做的笔记。能力有限,有不足之处欢迎指教!!!!

一、环境配置

操作系统:Centos 7

jdk:1.8

Hadoop 2.7.6

三个节点主机名分别为 master node1 node2

二、安装前的准备

1、安装jdk

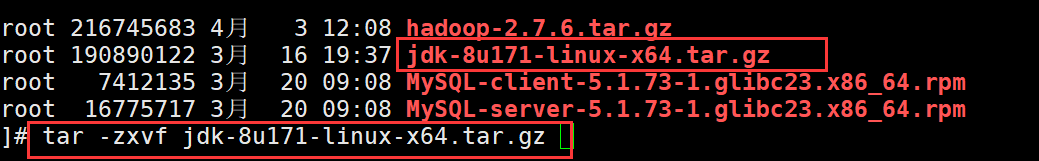

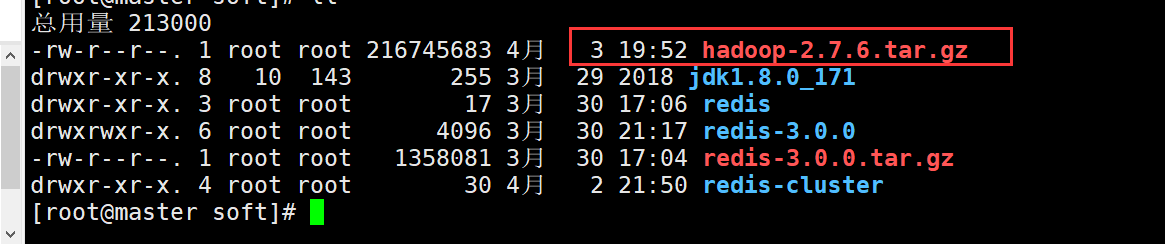

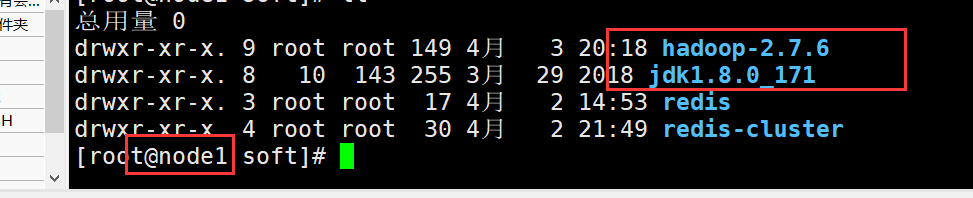

把jdk的jar包上传到/usr/local/soft目录下

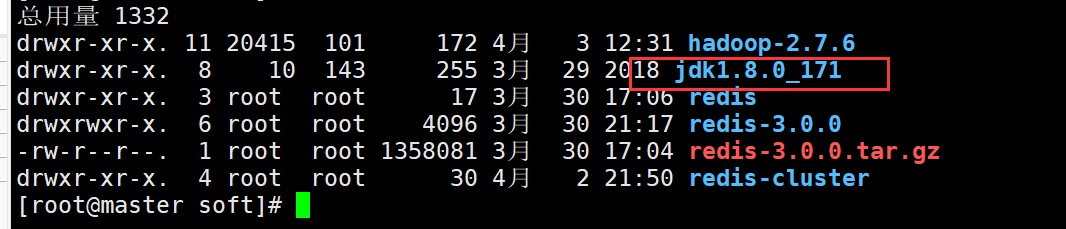

解压到当前目录 (我这里解压过了,就不演示了下图展现的是解压过的结果)

tar -zxvf jdk-8u171-linux-x64.tar.gz

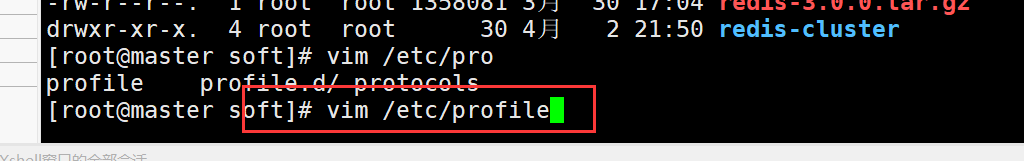

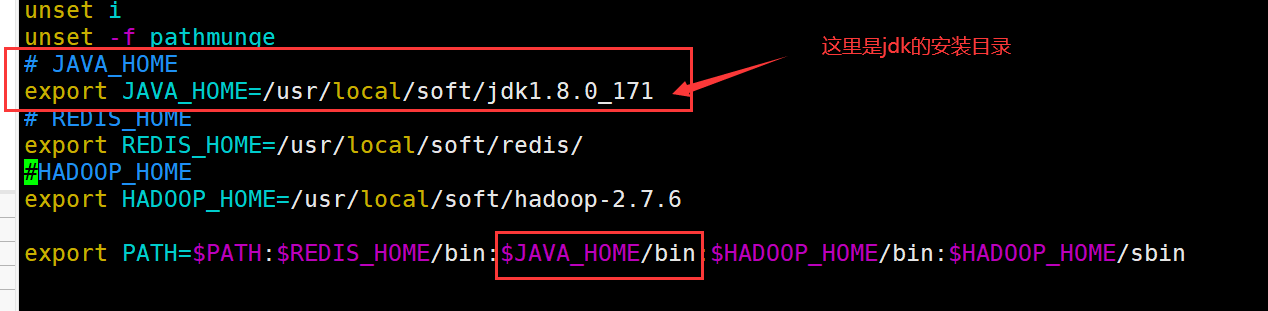

配置环境变量

vim /etc/profile

刷新一下

source /etc/profile

2、永久关闭防火墙

systemctl disable firewalld.service 这里是Centos 7 的命令

3、配置SSH免密

创建秘钥

ssh-keygen -t rsa 一直回车

秘钥分发

ssh-copy-id 主机名或ip地址

1 ssh-copy-id -i master 2 3 ssh-copy-id -i node1 4 5 ssh-copy-id -i node2

实现免密码登录到子节点

注意:如果执行出错,进入/root/.ssh删除里面所有内容,从新执行

三、下面开始今天的主题 集群的搭建

(以下操作在主机master上进行)

1、上传Hadoop jar包到/usr/local/soft

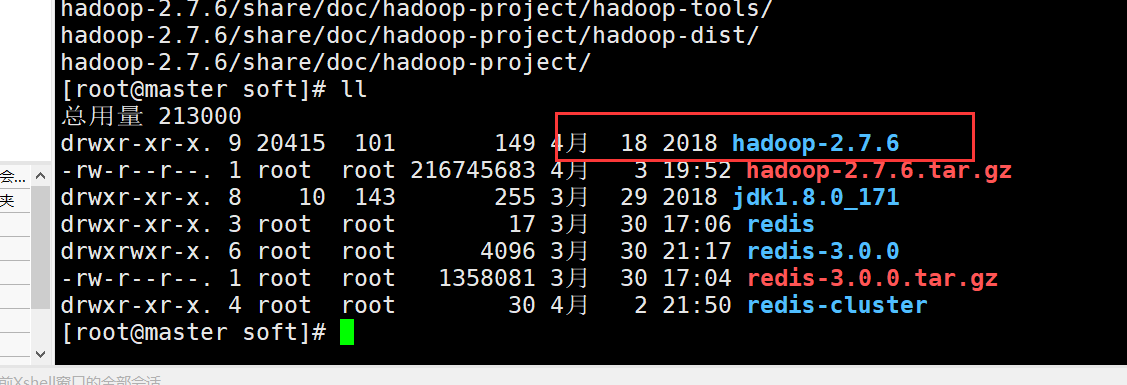

2、解压安装到当前文件夹

tar -zxvf hadoop-2.7.6.tar.gz

下面先配置Hadoop的环境变量

增加hadoop环境变量,将bin和sbin都配置到PATh中

1 export HADOOP_HOME=/usr/local/soft/hadoop-2.7.6 2 :$HADOOP_HOME/bin:$HADOOP_HOME/sbin #增加到文件末尾

刷新一下环境

source /etc/profile

下面开始修改文件

进入目录

cd /usr/local/soft/hadoop-2.7.6/etc/hadoop

![]()

1、修改slaves

vim slaves

删除原来的所有内容,修改为如下

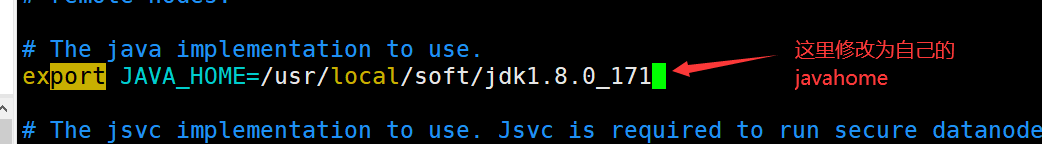

2、修改hadoop-env.sh文件

vim hadoop-env.sh

export JAVA_HOME=/usr/local/soft/jdk1.8.0_171

(这里推荐在notepad++安装下NppFTP插件,可以连接虚拟机在Windows平台直接操作修改文件,复制粘贴很方便

安装使用教程自行搜索,这里就不写了)

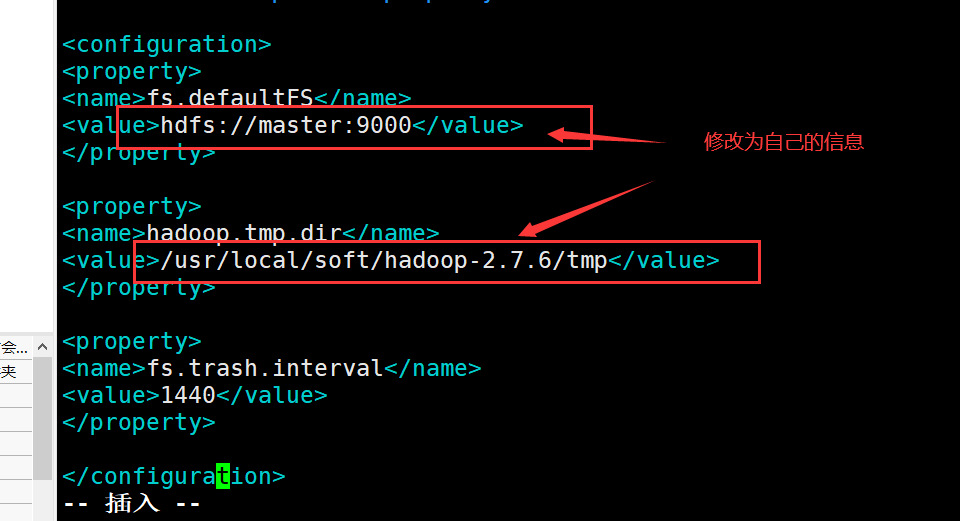

3、修改 core-site.xml

vim core-site.xml

1 <configuration> 2 <property> 3 <name>fs.defaultFS</name> 4 <value>hdfs://master:9000</value> 5 </property> 6 <property> 7 <name>hadoop.tmp.dir</name> 8 <value>/usr/local/soft/hadoop-2.7.6/tmp</value> 9 </property> 10 <property> 11 <name>fs.trash.interval</name> 12 <value>1440</value> 13 </property> 14 </configuration>

将下面的配置参数加入进去修改成对应自己的

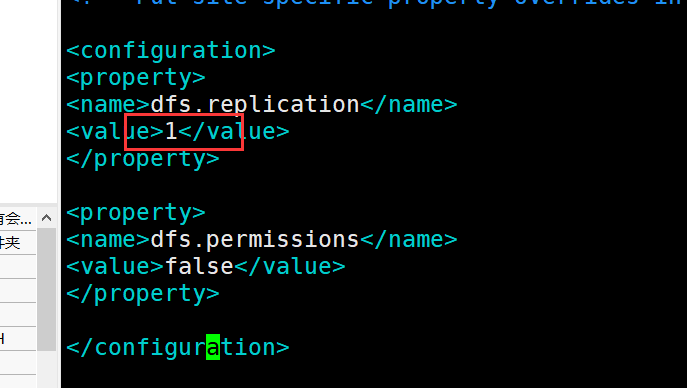

4、修改 hdfs-site.xml 将dfs.replication设置为1

vim hdfs-site.xml

1 <configuration> 2 <property> 3 <name>dfs.replication</name> 4 <value>1</value> 5 </property> 6 <property> 7 <name>dfs.permissions</name> 8 <value>false</value> 9 </property> 10 </configuration>

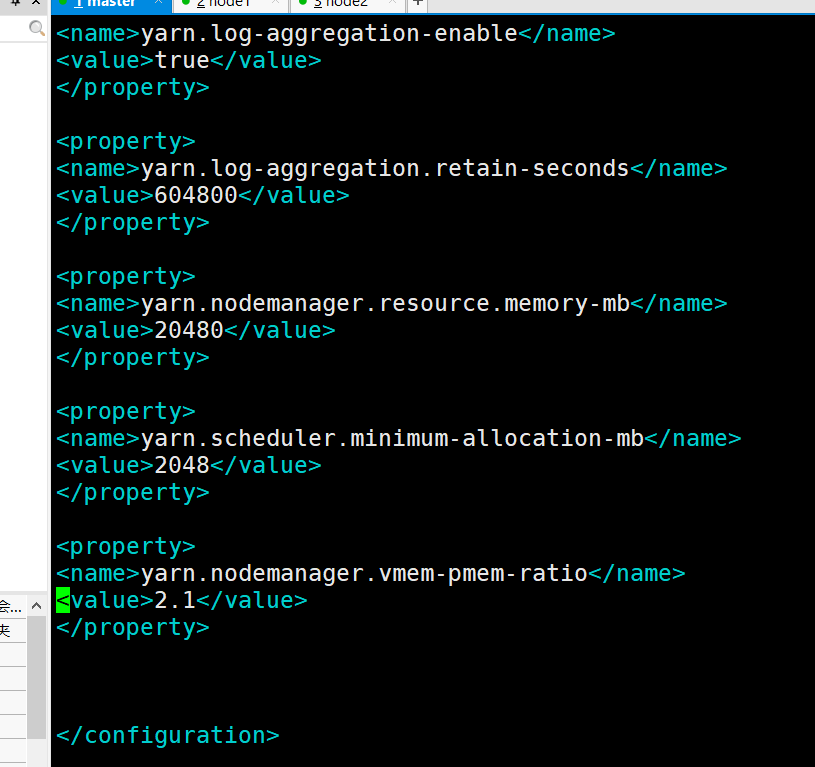

5、修改yarn-site.xml

vim yarn-site.xml

1 <configuration> 2 3 <property> 4 <name>yarn.resourcemanager.hostname</name> 5 <value>master</value> 6 </property> 7 <property> 8 <name>yarn.nodemanager.aux-services</name> 9 <value>mapreduce_shuffle</value> 10 </property> 11 <property> 12 <name>yarn.log-aggregation-enable</name> 13 <value>true</value> 14 </property> 15 <property> 16 <name>yarn.log-aggregation.retain-seconds</name> 17 <value>604800</value> 18 </property> 19 <property> 20 <name>yarn.nodemanager.resource.memory-mb</name> 21 <value>20480</value> 22 </property> 23 <property> 24 <name>yarn.scheduler.minimum-allocation-mb</name> 25 <value>2048</value> 26 </property> 27 <property> 28 <name>yarn.nodemanager.vmem-pmem-ratio</name> 29 <value>2.1</value> 30 </property> 31 32 </configuration>

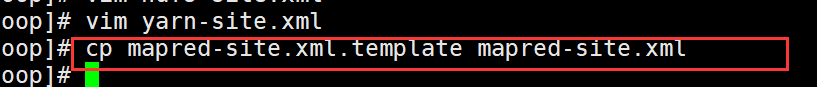

6、修改 mapred-site.xml(将mapred-site.xml.template 复制一份为 mapred-site.xml

命令:

cp mapred-site.xml.template mapred-site.xml

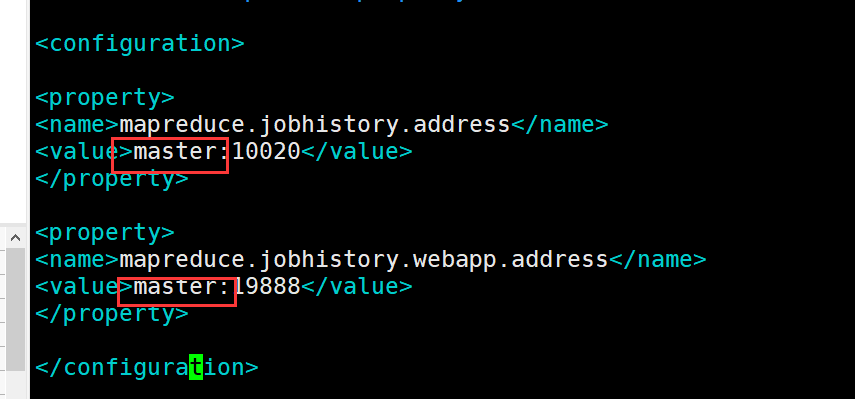

vim mapred-site.xml

1 <configuration> 2 3 <property> 4 <name>mapreduce.framework.name</name> 5 <value>yarn</value> 6 </property> 7 <property> 8 <name>mapreduce.jobhistory.address</name> 9 <value>master:10020</value> 10 </property> 11 <property> 12 <name>mapreduce.jobhistory.webapp.address</name> 13 <value>master:19888</value> 14 </property> 15 16 </configuration>

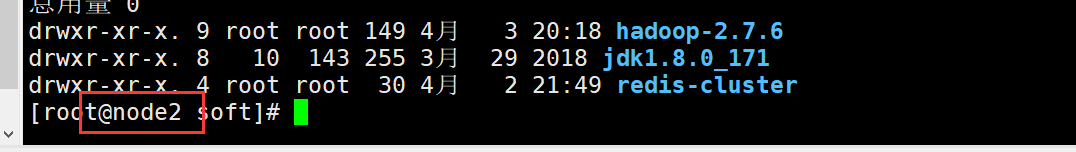

7、将hadoop的安装目录分别拷贝到其他子节点

scp -r /usr/local/soft/hadoop-2.7.6 node1:/usr/local/soft/

scp -r /usr/local/soft/hadoop-2.7.6 node2:/usr/local/soft/

8、格式化namenode(在master中运行)

hdfs namenode -format

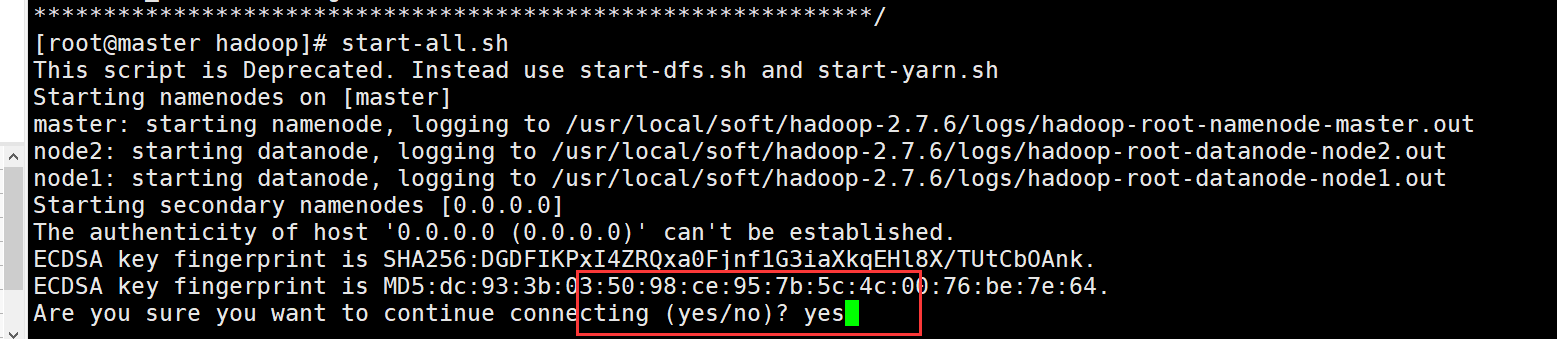

9、启动hadoop

start-all.sh

输入yes

10、验证 是否安装成功

启动完成后通过jps命令查看验证进程:jps

主节点进程为下面几个(下面是进程名称,不是命令):

Namenode

secondarnamenode

resourcemanager

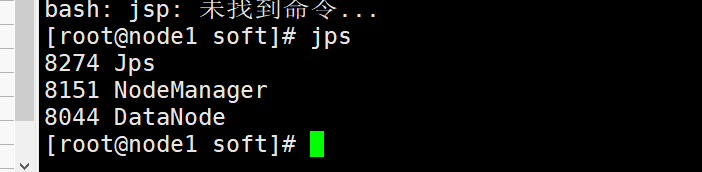

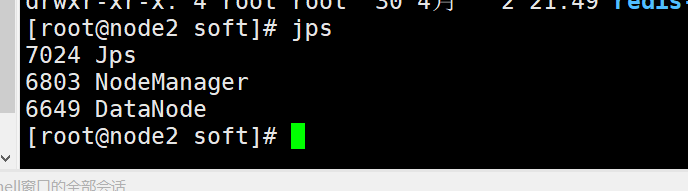

子节点进程 (在node1和node2上分别输入命令:jps)

datanode

nodenodemanager

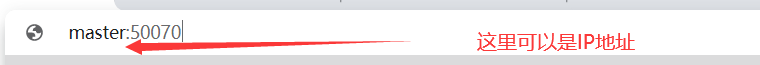

验证hdfs

windows电脑登录浏览器(强烈建议chrome浏览器)

master:50070

刚装好的hadoop应该是空的什么都没有

到这里我们就大功告成了,赶紧拍个快照保存一下把