SparkContext是编写Spark程序用到的第一个类,是Spark的主要入口点,用于连接

Spark集群、创建RDD、累加器和广播变量,是Spark程序的根本。

编写不同类型的Spark程序,使用的SparkContext是不同的

Scala 使用SparkContext

Java 使用JavaSparkContext

开发一个简单的Spark程序:

第一步:创建SparkConf对象,设置Spark应用的配置信息

第二步:创建Spark Context对象

第三步:针对输入源创建一个初始的RDD(数据集),输入源数据分配到不同的区,形成初始的分布式数据集

SparkContext中,用于根据文件类型的输入源常见RDD的方法叫textFile()方法

第一步:创建SparkConf对象,设置Spark应用的配置信息

第二步:创建Spark Context对象

第三步:针对输入源创建一个初始的RDD(数据集),输入源数据分配到不同的区,形成初始的分布式数据集

SparkContext中,用于根据文件类型的输入源常见RDD的方法叫textFile()方法

今天安装Scala,并学习了Scala语言一些基本的语法,

scala 方法声明格式:def functionName ([参数列表]) : [return type]

例:

object add{

def addInt( a:Int, b:Int ) : Int = {

var sum:Int = 0

sum = a + b

return sum

}

}

Scala的输入语句:val name = StdIn.readLine()

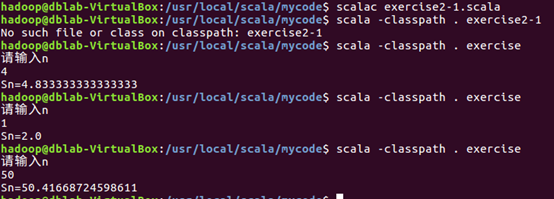

完成了实验二

import scala.io.StdIn

object exercise

{

def main(args:Array[String])

{

println("请输入n")

var n:Long=StdIn.readLine().toLong

var sum=0.0

var a=1.0

while(sum<n)

{

sum=sum+(a+1)/a

a=a+1

}

println("Sn="+sum)

}

}