1、生成inference,

示例:

paddlex --export_inference --model_dir=xxxxxxxxxxxxxxx/best_model --save_dir=./inference_model/mobilenetv3_large_ssld_class_13

2、Windows下没有paddle_lite_opt,需要使用python脚本

示例:

# 引用Paddlelite预测库

from paddlelite.lite import *

# 1. 创建opt实例

opt=Opt()

# 2. 指定输入模型地址

#opt.set_model_dir(r"xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxinference_model")

opt.set_model_file(r"xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxinference_model\__model__")

opt.set_param_file(r"xxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxxinference_model\__params__")

# 3. 指定转化类型: arm、x86、opencl、xpu、npu

opt.set_valid_places("arm")

# 4. 指定模型转化类型: naive_buffer、protobuf

opt.set_model_type("naive_buffer")

# 4. 输出模型地址

opt.set_optimize_out("mobilenetv1_opt")

# 5. 执行模型优化

opt.run()

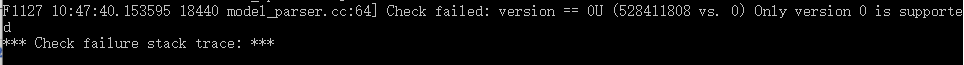

注意不能使用set_model_dir方式,不然会报