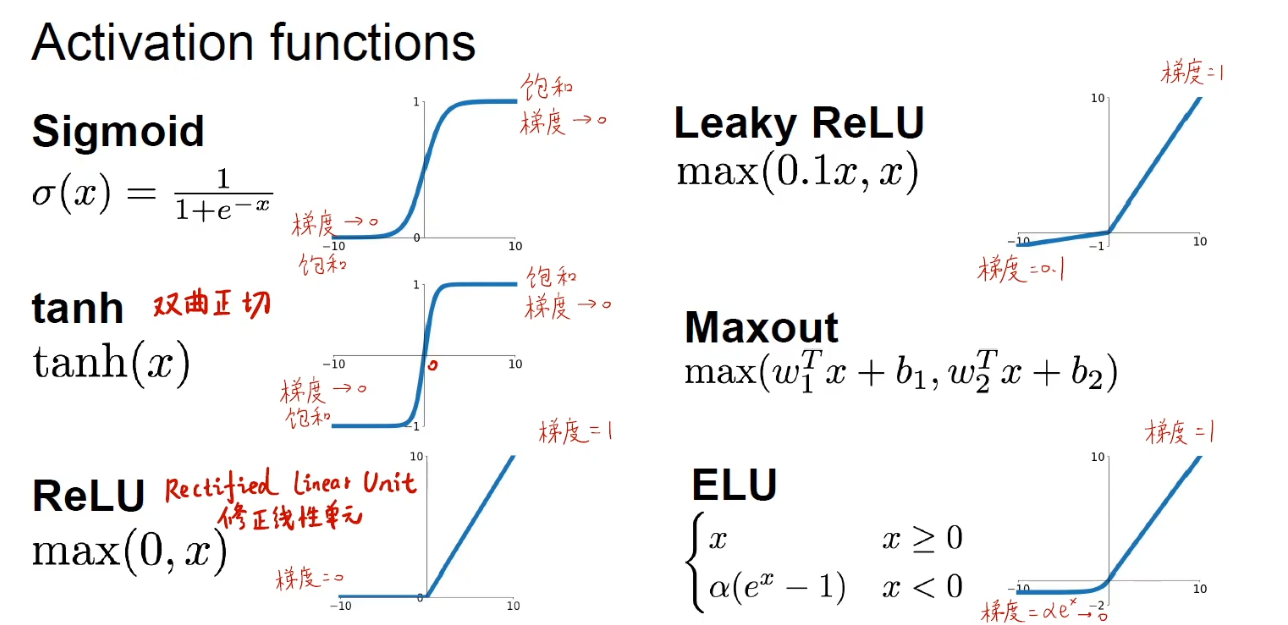

非线性的激活函数:

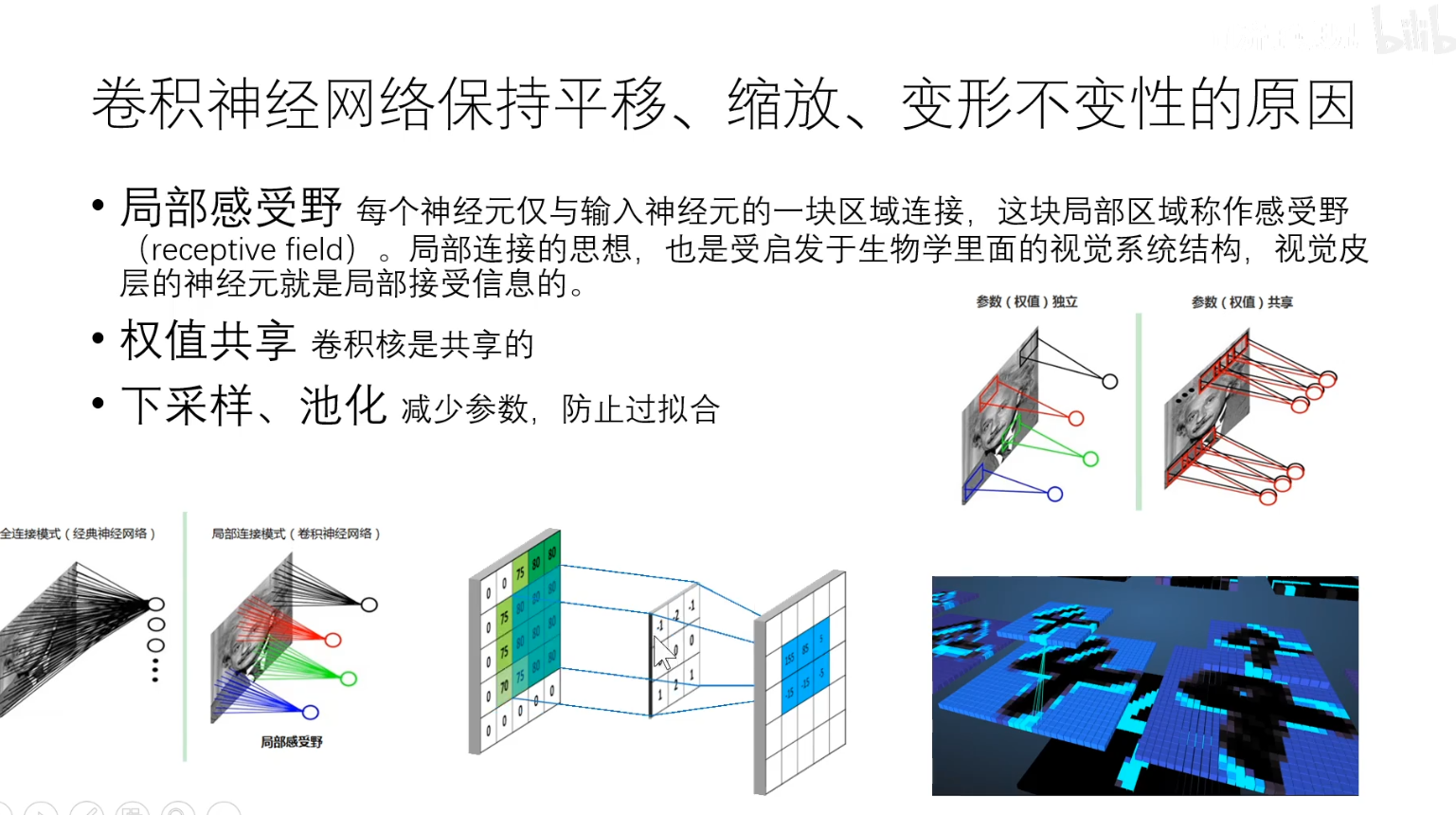

每次卷积操作都可以认为是一个神经元

深度学习包括四大基础设施:数据、算力、算法、框架

激活函数(把神经元的输入线性求和后用非线性函数激活,从而给神经网络带来非线性 )的选择:

sigmoid函数又称挤压函数,其可解释性好。但由于其饱和性(x趋于正无穷接近于1,趋于负无穷接近于0),导致梯度消失,也就是迭代的速度很慢;而且它的值都为整数,就导致每个神经元中L对w求导都是正值,从而每个神经元的参数只能一起增大或一起减小;且进行指数运算,比较消耗资源

tanh:和sigmoid函数很像,不过它有正有负,就避免了zig-zag问题(sigmoid函数的第二个缺点)

ReLU函数:不会饱和、非常容易计算、收敛速度很快;缺点:不关于0对称,且x小于0时梯度是0(这意味着有的神经元是死的,永远不会更新)

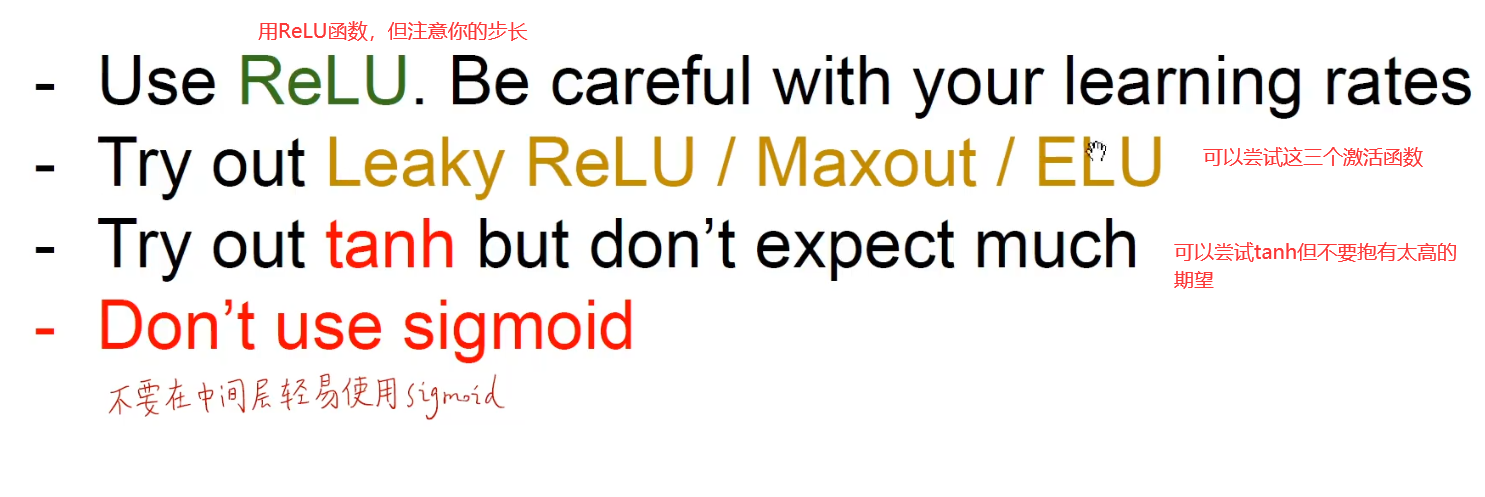

选激活函数的原则:

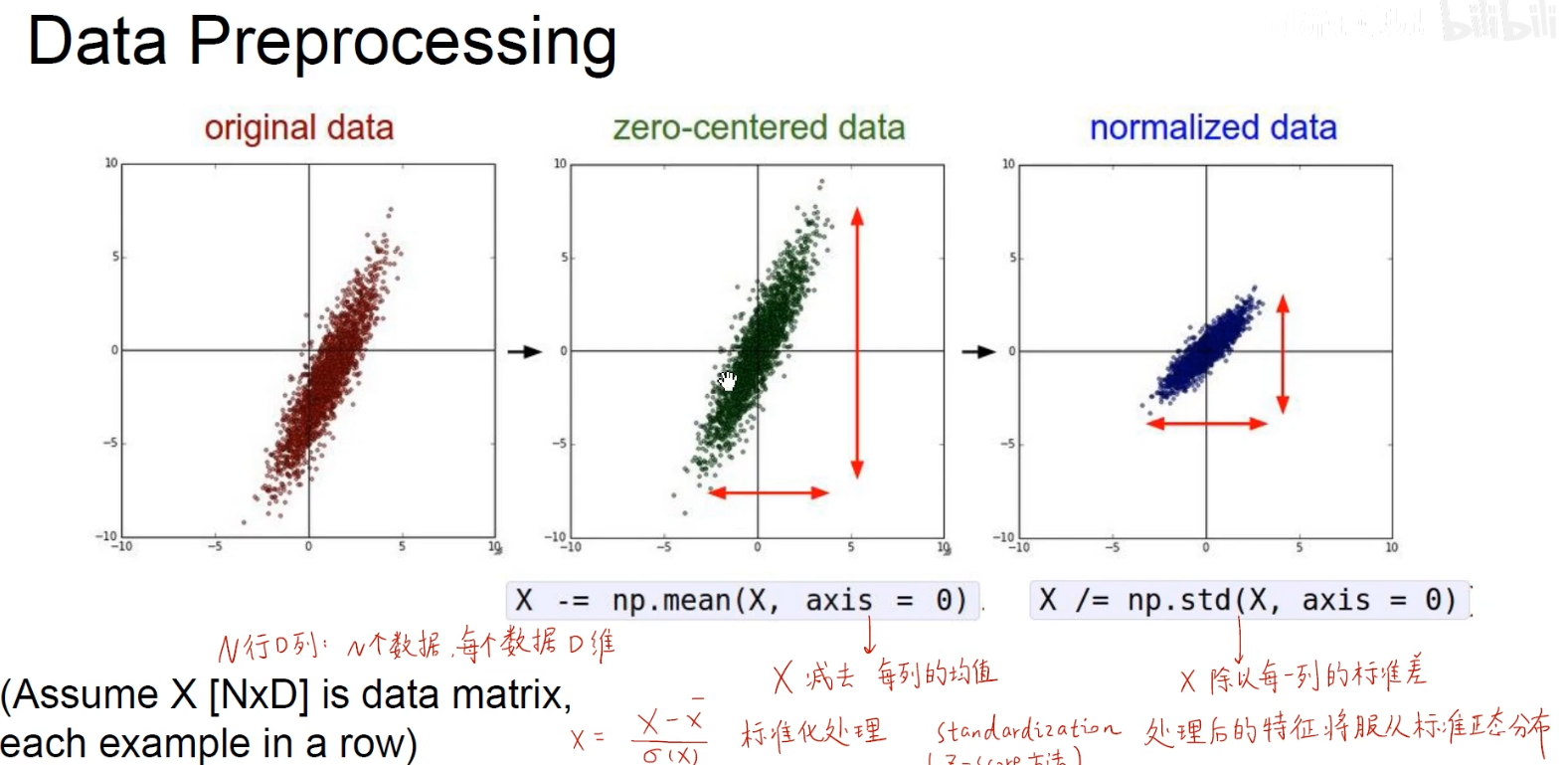

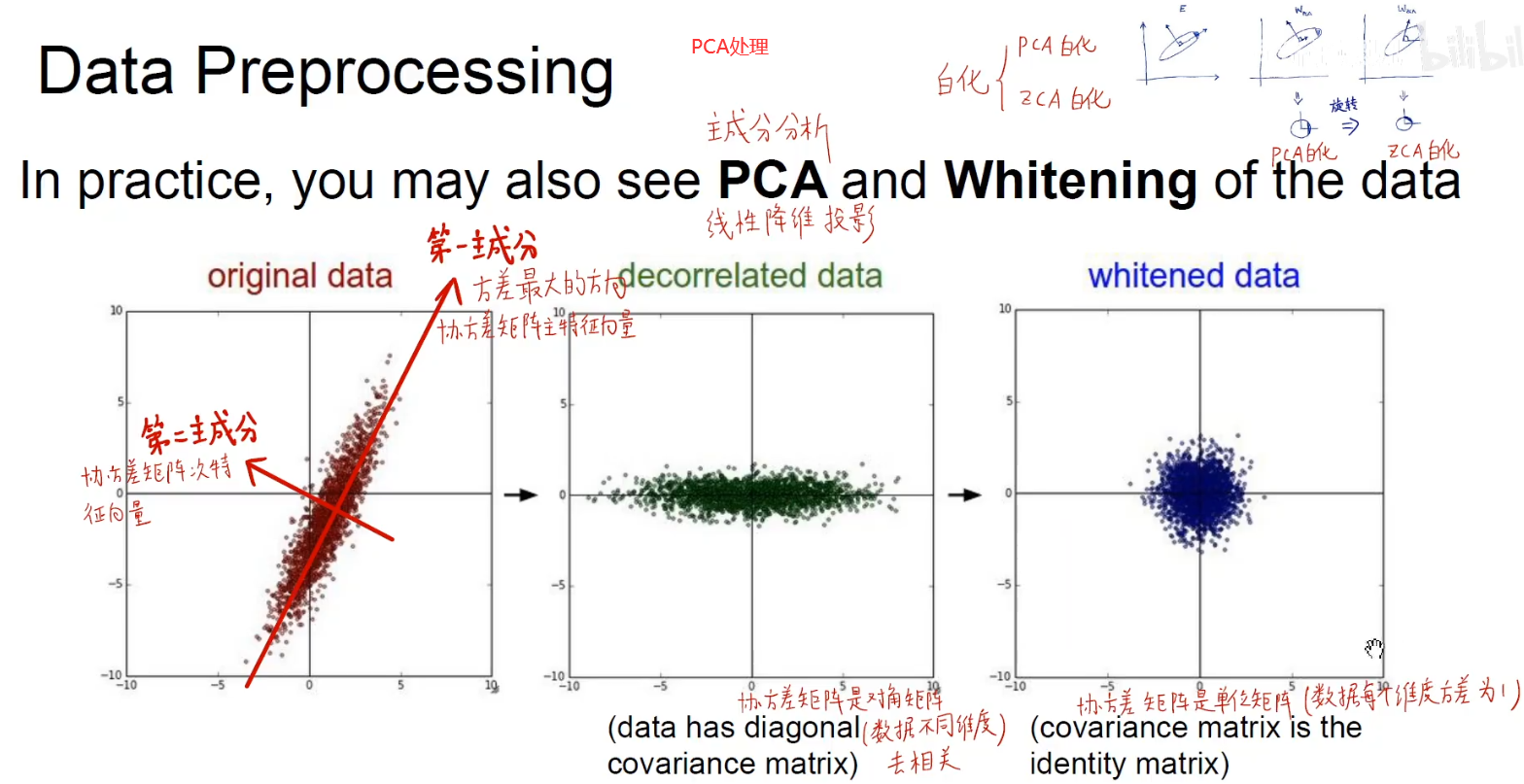

数据预处理:

第一种数据标准化

第二种数据标准化

数据标准化处理:使损失函数对w的变化不那么敏感,容易优化

W初始化: xavier初始化

何凯明初始化: