1.手写数字数据集

- from sklearn.datasets import load_digits

- digits = load_digits()

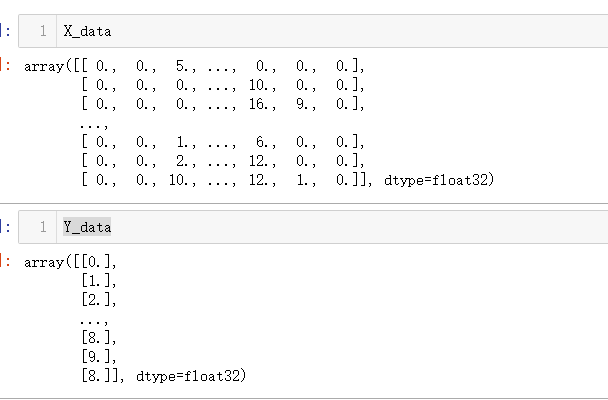

#1.手写数字数据集 from sklearn.datasets import load_digits import numpy as np import pandas as pd from sklearn.preprocessing import MinMaxScaler from sklearn.preprocessing import OneHotEncoder digits = load_digits() X_data = digits.data.astype(np.float32) #将Y_data数据扁平化 Y_data = digits.target.astype(np.float32).reshape(-1,1)

提取的数据:

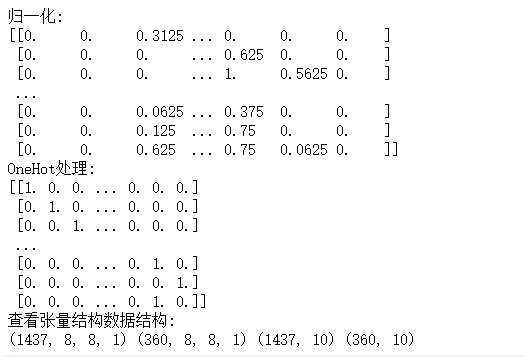

2.图片数据预处理

- x:归一化MinMaxScaler()

- y:独热编码OneHotEncoder()或to_categorical

- 训练集测试集划分

- 张量结构

scaler = MinMaxScaler()#归一化MinMaxScaler() X_data = scaler.fit_transform(X_data) print('归一化:') print(X_data) # OneHot处理 Y = OneHotEncoder().fit_transform(Y_data).todense() print('OneHot处理:') print(Y) #转换为图片的格式(batch,height,width,channels) X=X_data.reshape(-1,8,8,1) from sklearn.model_selection import train_test_split # 划分训练集、测试集 X_train,X_test,Y_train,Y_test = train_test_split(X,Y,test_size=0.2,random_state=0,stratify=Y) # 查看张量结构数据结构 print('查看张量结构数据结构:') print(X_train.shape,X_test.shape,Y_train.shape,Y_test.shape)

输出结果如下:

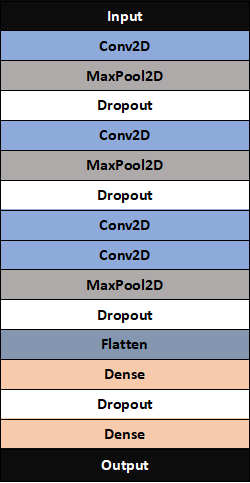

3.设计卷积神经网络结构

- 绘制模型结构图,并说明设计依据。

-

1)数据尺寸太小,特征较少,没必要使用过深的网络提取特征,三层就够了。

2)由于图像尺寸较小,故卷积核尺寸设置为2×2,三个卷积-池化层的卷积核数量分别设置为32、64、128。

3)该模型不使用Dropout,因为在使用小卷积核时Dropout丢弃过多特征会导致准确率变差。

4)在卷积层后使用BatchNormalization替代Dropout,BN同样可以起到防止过拟合的作用,还可以加速模型收敛。

5)池化前使用ReLu而不是sigmod作为激活函数,目的是避免“梯度消失”。

6)由于这是一个用于分类的神经网络,独热编码值介于0.0~1.0之间,故全连接之后使用Softmax激活函数进行分类。

-

设计依据代码如下:

from tensorflow.keras.models import Sequential from tensorflow.keras.layers import Dense, Dropout, Flatten, Conv2D, MaxPool2D model = Sequential()#建立模型 ks = (3, 3) # 卷积核的大小 input_shape = X_train.shape[1:]# 图片维数 # 一层卷积 model.add(Conv2D(filters=16, kernel_size=ks, padding='same', input_shape=input_shape, activation='relu')) # 池化层1 model.add(MaxPool2D(pool_size=(2, 2))) # 防止过拟合,随机丢掉连接 model.add(Dropout(0.25)) # 二层卷积 model.add(Conv2D(filters=32, kernel_size=ks, padding='same', activation='relu')) # 池化层2 model.add(MaxPool2D(pool_size=(2, 2))) model.add(Dropout(0.25)) # 三层卷积 model.add(Conv2D(filters=64, kernel_size=ks, padding='same', activation='relu')) # 四层卷积 model.add(Conv2D(filters=128, kernel_size=ks, padding='same', activation='relu')) # 池化层3 model.add(MaxPool2D(pool_size=(2, 2))) model.add(Dropout(0.25)) # 平坦层 model.add(Flatten()) # 全连接层 model.add(Dense(128, activation='relu')) model.add(Dropout(0.25)) # 激活函数softmax model.add(Dense(10, activation='softmax')) print(model.summary())

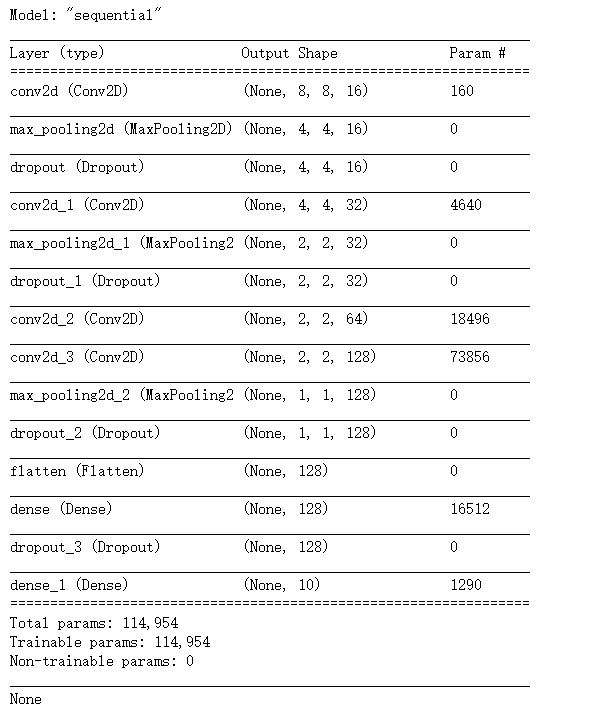

结构如下所示:

4.训练模型

#优化器optimizer='adam' model.compile(loss='categorical_crossentropy', optimizer='adam', metrics=['accuracy']) # 划分0.2作为验证数据,每次训练300个数据,训练迭代300轮 train_history = model.fit(x=X_train, y=Y_train, validation_split=0.2, batch_size=300, epochs=10, verbose=2) #构建模型评估 score = model.evaluate(X_test,Y_test) #预测模型 y_pred = model.predict_classes(X_test) print(y_pred)

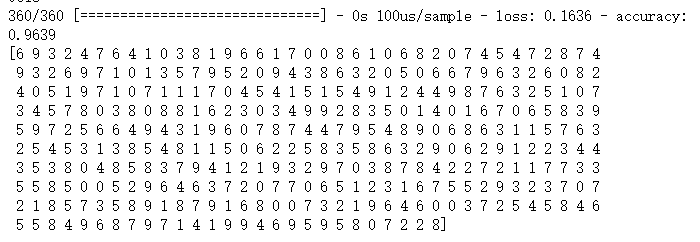

预测结果:

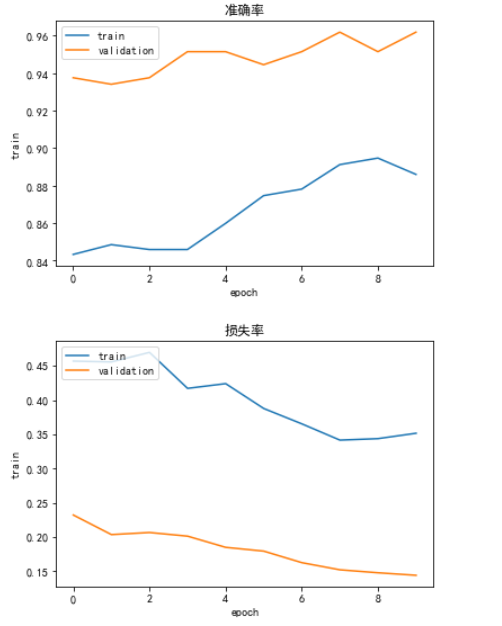

画Train History图

# 画Train History图 import matplotlib.pyplot as plt def show_train_history(train_histoty, train, validataion): plt.plot(train_history.history[train]) plt.plot(train_history.history[validataion]) # plt.title('Train History') plt.ylabel('train') plt.xlabel('epoch') plt.legend(['train', 'validation'], loc='upper left') plt.show() # #准确率 plt.title("准确率") show_train_history(train_history, 'accuracy', 'val_accuracy') # #损失率 plt.title("损失率") show_train_history(train_history, 'loss', 'val_loss')

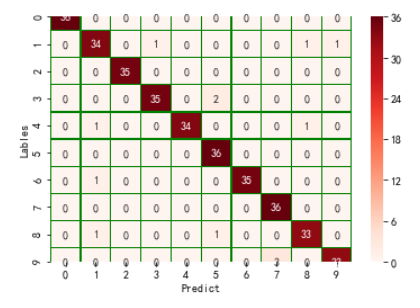

5.模型评价

- model.evaluate()

- 交叉表与交叉矩阵

- pandas.crosstab

- seaborn.heatmap

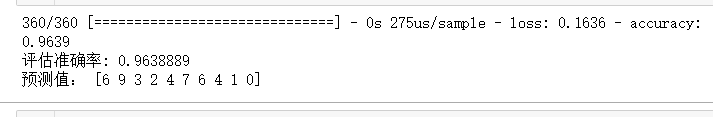

(1)模型评估

import seaborn as sns # 模型评估 score = model.evaluate(X_test, Y_test) print('评估准确率:', score[1]) # 预测值 y_pred = model.predict_classes(X_test) print('预测值:', y_pred[:10])

(2)交叉表与交叉矩阵

# 交叉表与交叉矩阵 y_test1 = np.argmax(Y_test, axis=1).reshape(-1) y_true = np.array(y_test1)[0] # 交叉表查看预测数据与原数据对比 pd.crosstab(y_true, y_pred, rownames=['true'], colnames=['predict']) # 交叉矩阵 y_test1 = y_test1.tolist()[0] a = pd.crosstab(np.array(y_test1), y_pred, rownames=['Lables'], colnames=['Predict']) df = pd.DataFrame(a) sns.heatmap(df, annot=True, cmap="Reds", linewidths=0.2, linecolor='G') plt.show()