不多说,直接上干货!

问题详情

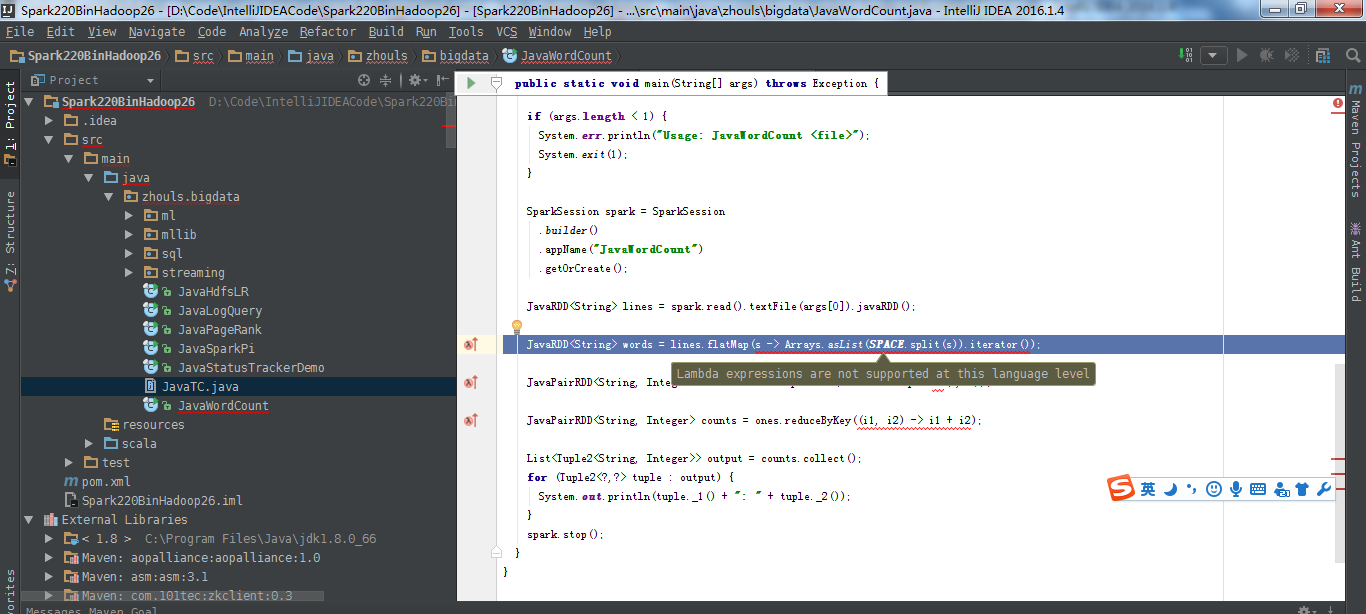

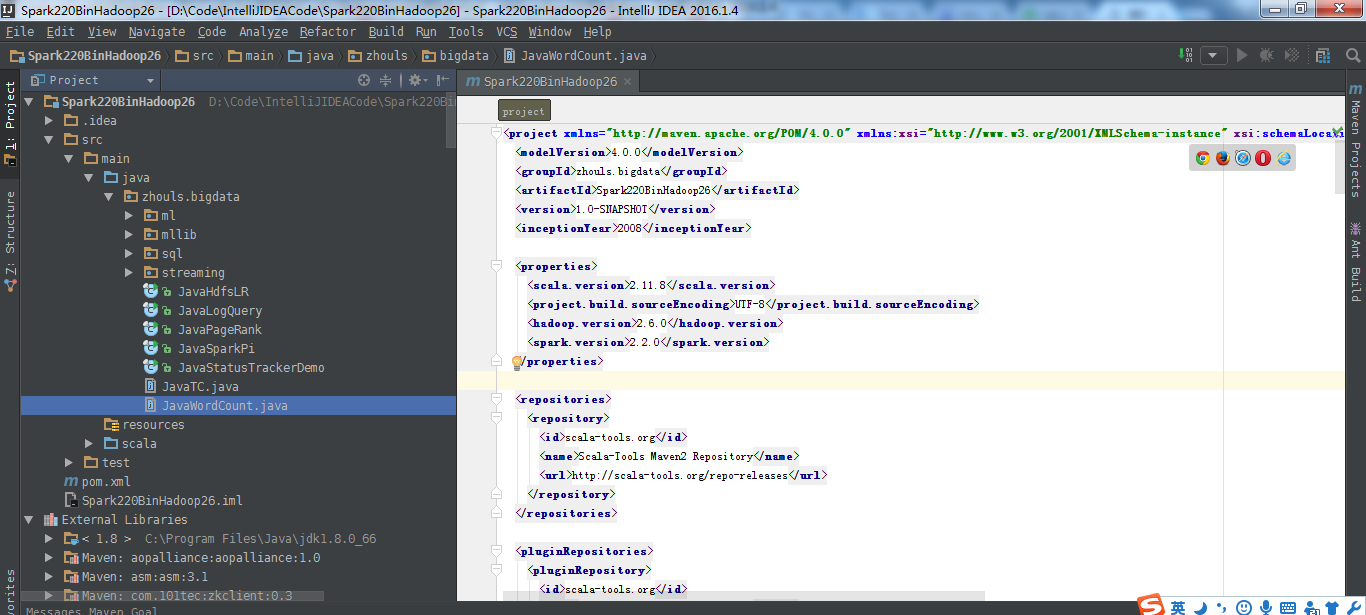

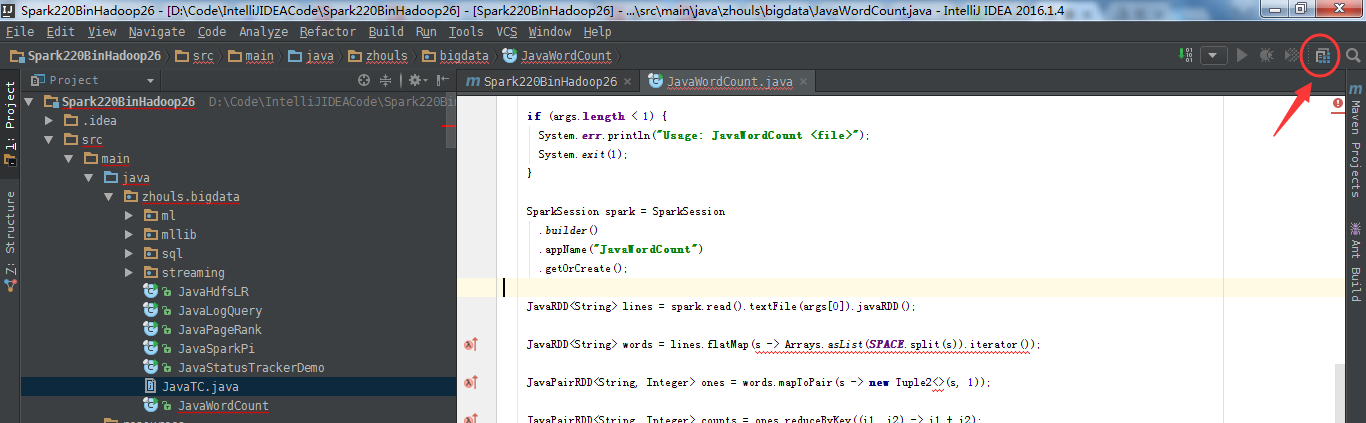

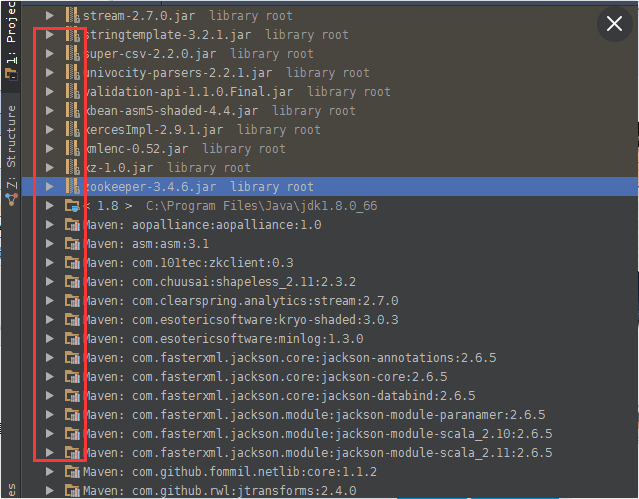

以下是我,maven构建出来的最新spark2.2.0-bin-hadoop2.6的项目。

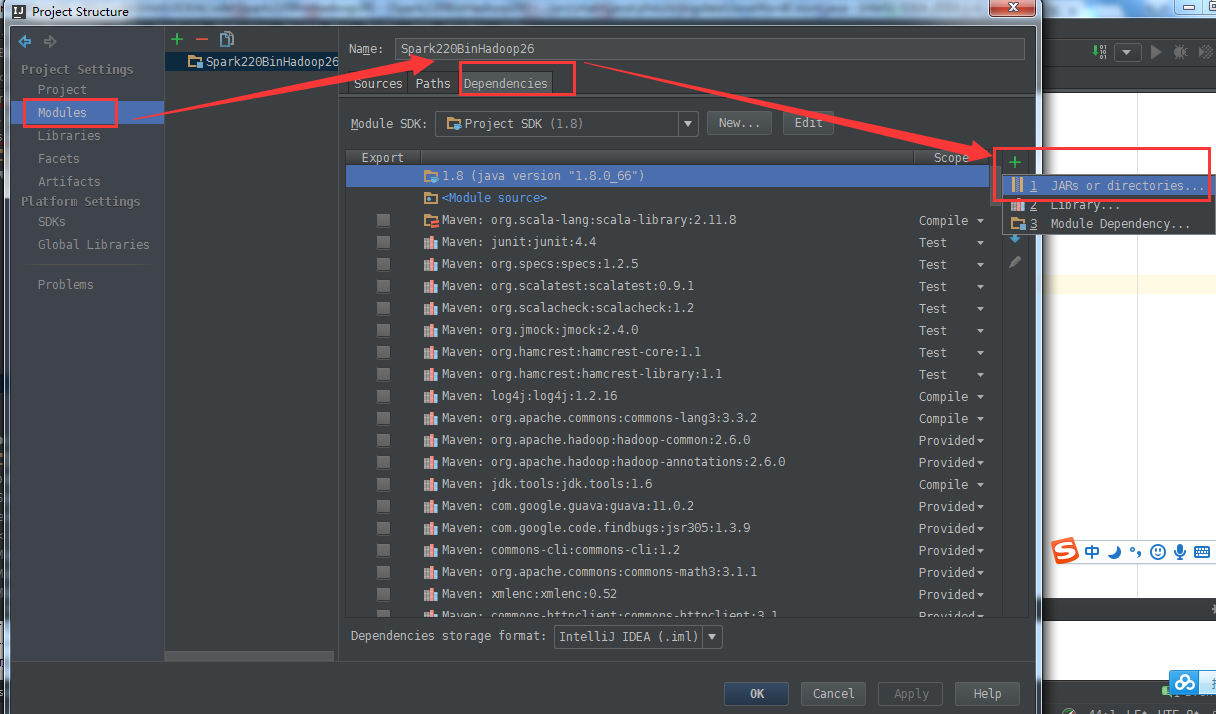

有些依赖包,maven还是无法一次性满足,所以,得手动加入lib的jar包。

其实,这原理很简单,跟hadoop项目是一样的。无非说maven构建项目方便下载jar包,但是也不是万能一次性全部到位和满足需要的。

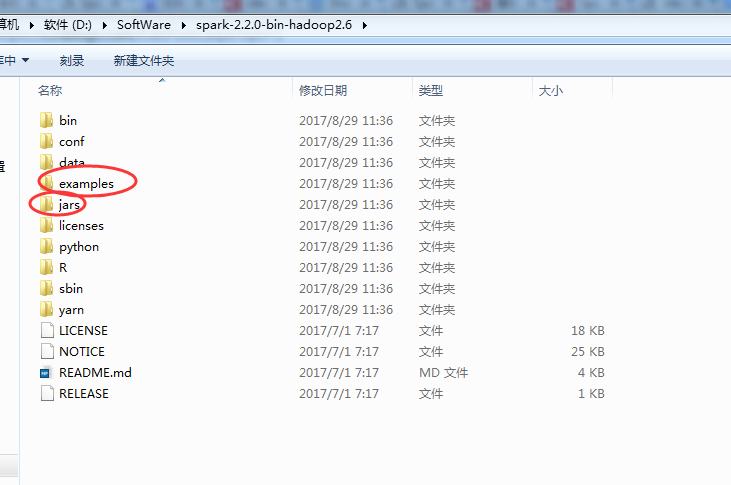

假设,大家,还需要导入

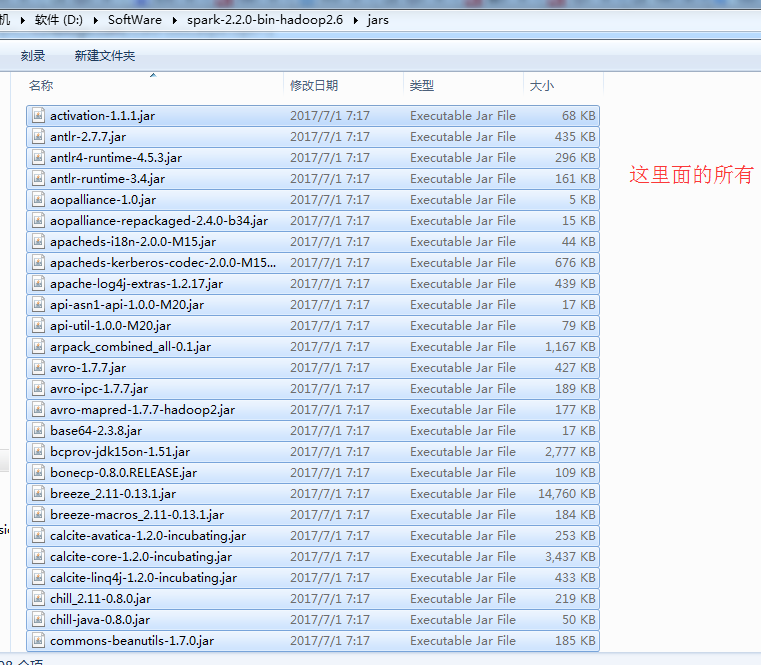

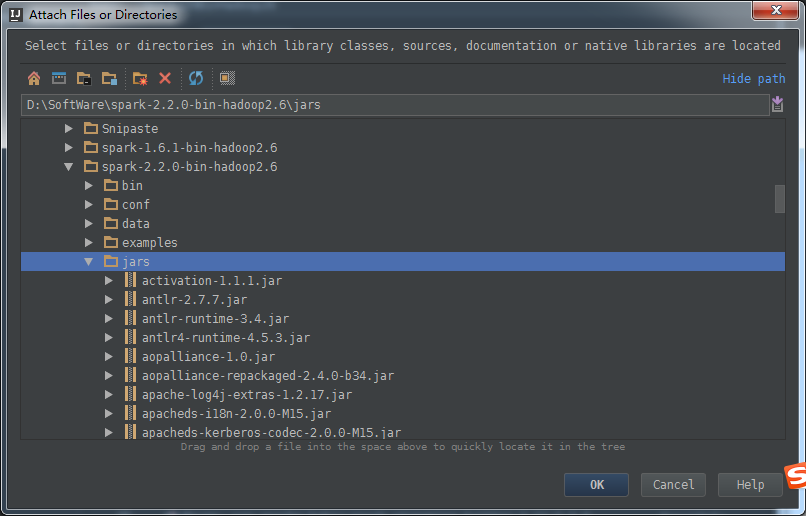

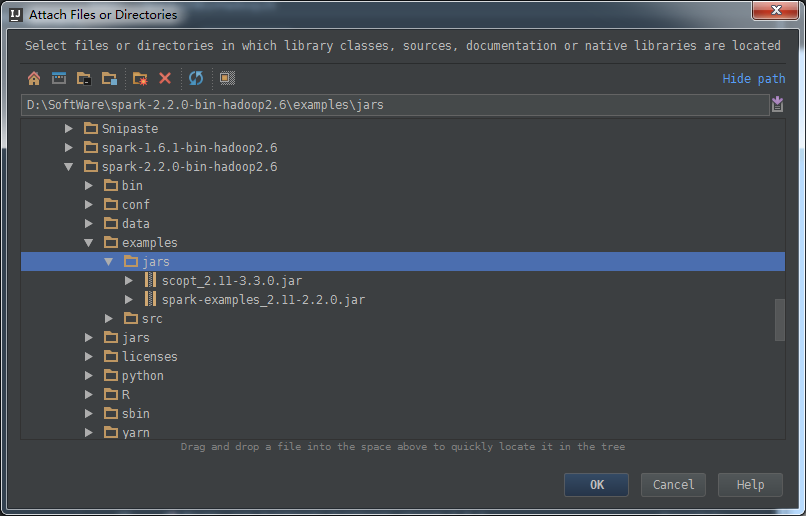

导入spark的jar包:是安装主目录下的jars所有jar包和examples/jars包。

点击project structure 按钮

以下是默认的

按照以下顺序来

注意:只需选中jars目录即可

得到

然后

得到

然后,apply即可

如果是下面的这样,会出现错误,IDEA里的jar包被导入被锁住,即没有生效。说明这样的导入方式是错误的。

但是,细心的博友们,知道,这导入进去,是被锁住的。其实,压根就没有被锁住之说,是只读而已啦。

成功!