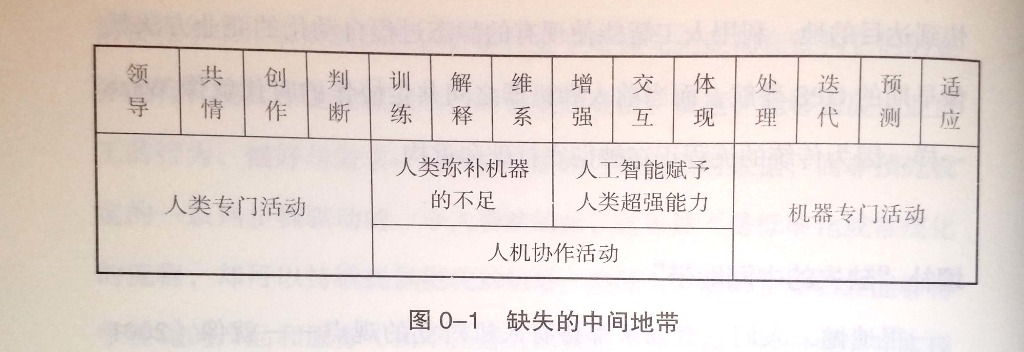

主题是未来人工智能与人的合作关系的讨论。作者认为人工智能与人各有优劣势,中间有一大片交叉地带是需要人工智能与人一起合作的,这些交叉地带目前还有很多空缺岗位找不到合适的人。

书中的人工智能相关的事实,大部分是新闻稿,其中有不少有宣传稿的味道,也引用了一些研究报告。在此基础上两位作者做了一些畅想和分析。这些畅想和分析的观点基本都见过,没看到有新意。

总体评价3星,有参考价值。

以下是书中一些内容的摘抄:

1:非常有意思的是,在这个通过人工智能重构流程的时代,一些自动化程度最高的场所——工厂和其他工业环境——正在经历一场人力的复兴。从装配线工人,到维护专家,再到机器人工程师和运营经理,人工智能正在重新定义工业环境中的工作。 P4

2:尽管今天的实验环境看起来基本上类似于几十年前的实验室——笼子里的老鼠、孵化器中的培养皿、滴定系统等——很多科学领域正在向更加全面的方向发展。也就是说,研究人员可以在电脑里模拟实验操作。P59

3:随着越来越多的公司在利用“沃森”,Siri,Cortana(微软小娜)和Alexa这样的人工智能平台提供解决方案,一种被称为品牌脱媒现象(brand disintermediation)的有趣效应随之出现。P79

4:物理机器人并不是唯一需要接受训练的人工智能系统,人工智能软件同样需要接受训练,我们要做的一项重要工作就是把机器训练得更像人类。 训练过程涉及方方面面的工作和人员。 P99

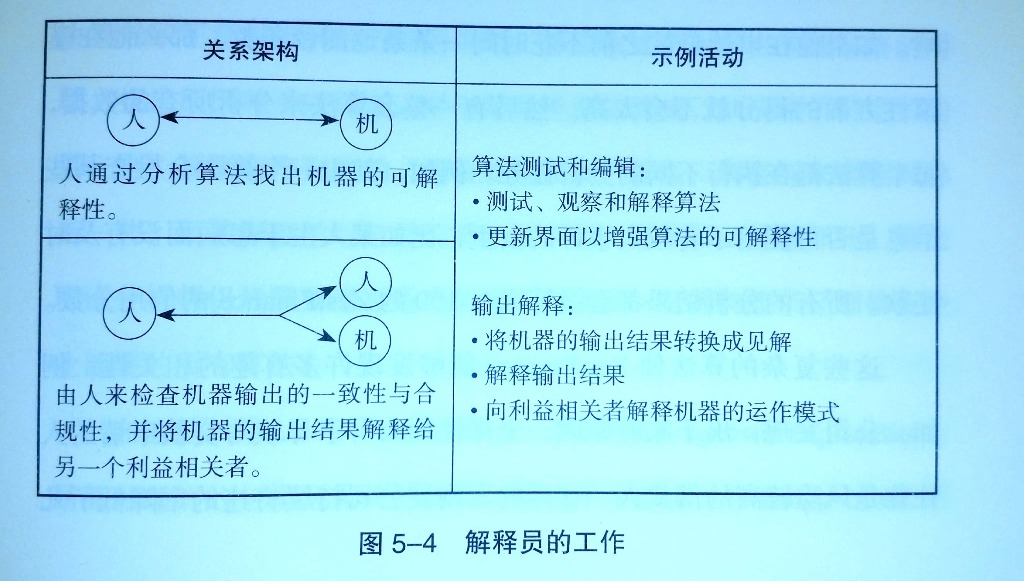

5:第二类新型工作岗位是解释员,其工作任务是弥合技术人员和企业领导者之间的距离。随着人工智能系统越来越不透明,解释员的角色将变得愈加重要。许多管理者已经对复杂的机器学习算法的黑箱属性感到不安,特别是当这些系统给出的建议可能会违背传统思维或引发争议的时候(见图5-4)。P105

6:应用高级人工智能系统的公司需要专业的员工来解释复杂算法的内部运作情况。与此相关的专业人员之一就是“算法取证分析师”,他们的职责是让所有算法对其结果负责。当系统出现错误或其决策导致了意想不到的负面后果时,算法取证分析师必须能够解剖问题,找出原因并予以纠正。P107

7:即使还不需要对结论进行解剖,公司也应该配备一名“透明度分析师”,负责解释某些黑箱运作的人工智能算法。例如,有些算法被故意设计为黑箱模式以保护自主知识产权,而另一些黑箱算法则源于复杂的代码属性或数据规模以及算法决策机制。P108

8:随着机器人越来越像真人,我们对它的亲切感和同情心会逐渐增强,并在某个点停住。然后,当机器人变得更像人类时,我们会突然变得挑剔起来,机器人拥有的任何微小的缺陷都会令我们不满。然而,当这些缺陷固定下来,而且机器人与人类的区别变得更小时,我们对机器人的好感会再次增强,最终接近于人与人之间的共情程度。P114

9:这样的工具确实已经存在,欧特克软件公司使用算法设计的Elbo椅子就是个很好的例子。Elbo椅子是一件引人注目的家具,P118

10:丰田研究院首席执行官吉尔·普拉特在2017年向美国国会议员表示,人们更容易宽恕人类犯下的错误,而不能容忍机器犯错。7研究证实了我们在信任机器方面的不一致性和不确定性。2009年的一篇论文指出,相比统计预测工具提供的信息,人们在估算股价时更信任人类专家做出的报告。P150

11:她相信金融行业会逐渐趋于自动化。同时,Systematica Investment公司的运营也遇到了阻力。她说,其中一项阻力就是人类更信赖人类做出的决策。“这个绊脚石就是“算法厌恶'情绪。”布拉加说。对许多应用而言,布拉加表示:“即使人类做得比算法更糟·····我们都更希望由人来做这项工作····我们要理性一些” P150

12:一般而言,当你允许员工修改人工智能系统的结果时——他们就会觉得自己是一个流程的执行者,而不仅仅是一个齿轮——他们会更容易信任人工智能。P156

13:管理者发现,在没有给出解释之前,人们更愿意相信自己的判断而不是算法的推荐。管理者同时发现,他们还必须给那些分配床位的人留有余地,并让他们拥有决策权。P157

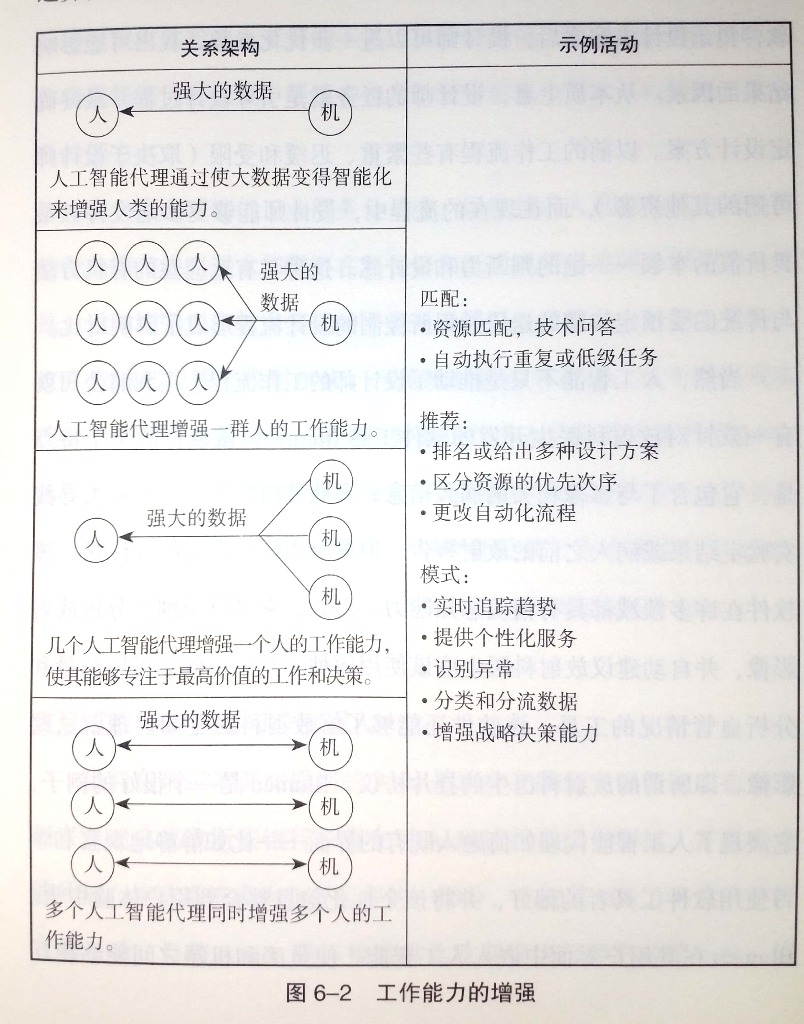

14:多年来,许多研究人员都梦想着创造出一种可以与人类匹敌的人工智能。然而,我们发现人工智能反而成了扩展人类自身能力的工具。反过来,我们正在引导人工智能系统发展成更好的工具,以进一步扩展我们的能力。 P197

更多良心书评参见我的公众号:左其盛经管新书点评