1.读文件

通过 sc.textFile(“file://") 方法来读取文件到rdd中。

val lines = sc.textFile("file://")//文件地址或者HDFS文件路径

本地地址

"file:///home/hadoop/spark-1.6.0-bin-hadoop2.6/examples/src/main/resources/people.json"HDFS文件地址

"hdfs://112.74.21.122:9000/user/hive/warehouse/hive_test"2.保存文件

通过 sc.saveAsTextFile("file://") 把 rdd 内容保存到文件

rdd.saveAsTextFile("file:///home/writeout.txt");//把rdd写入/home/writeout.txt

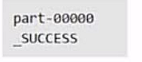

但是我们打开/home文件夹,发现writeout并不是txt文件而是一个文件夹,我们打开文件夹,结构如下

我们保存错了嘛?没有,这时正常的。part-00000代表的是分区,如果有多个分区,会有多个part-xxxxxx的文件。

如果我们要再次读取这个保存的文件并不需要一个一个分区读取,直接读取就可以了,spark会自动加载所有分区数据。

val rdd = sc.textFile("file:///home/writeout/part-00000");//我们并不用这样一个一个读取

val rdd = sc.textFile("file:///home/writeout.txt");//直接这样读取,就会自动把所有分区数据加载到rdd中

3.JSON数据解析

(1)读取JSON格式文件

直接用sc.textFile(“file://") 来读取.json文件即可

(2)JSON

Scala中有一个自带的JSON库 scala.util.parsing.json.JSON 可以实现对JSON数据解析。

通过调用 JSON.parseFull(jsonString:String) 函数对输入的JSON字符串进行解析。

如果解析成功则返回一个 Some( map:Map[String,Any] ) ,失败则返回None

示例:

文件内容

我们看到每个{...}中为一个json格式的数据,一个json文件包含若干个json格式的数据。

我们解析这个json文件的内容

1.编写程序

import org.apache.spark._

import scala.util.parsing.json.JSON

object JSONApp {

def main(args:Array[String]): Unit ={

//初始化配置:设置主机名和程序主类的名字

val conf = new SparkConf().setMaster("local").setAppName("JSONApp");

//通过conf来创建sparkcontext

val sc = new SparkContext(conf);

val inputFile = "file:///usr/local/spark/examples/src/main/resources/people.json"//读取json文件

val jsonStr = sc.textFile(inputFile);

val result = jsonStr.map(s => JSON.parseFull(s));//逐个JSON字符串解析

result.foreach(

{

r => r match {

case Some(map:Map[String,Any]) => println(map)

case None => println("parsing failed!")

case other => println("unknown data structure" + other)

}

}

);

}

}

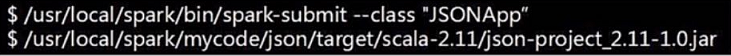

2.将整个程序打包成jar包

3.通过spark-submit运行程序

4.查看结果

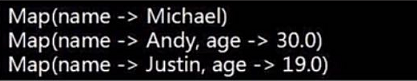

运行程序后,可以在屏幕上看到大量的输出信息,找到如下的信息,解析成功。