2018/5/9

关于textFile读取文件的问题

问题描述:

今天第一次使用spark-shell来读取文件,我在本地建立了一个text.txt文件,然后用textFile读取生成rdd。

但是执行的时候报错了,提示找不到文件。

解决方法:

1.

首先我们知道,通过文件建立rdd的textFile("file:///")的方法可以填入本地地址和HDFS地址。

我们这里想要用本地文件建立一个rdd,但是是通过spark-shell建立的。

spark-shell默认并不是使用本地模式,而是集群中任意一个节点,我们只有保证那个节点有这个文件才不会报找不到文件的错误。

但是当前spark-shell所有的机器你并不知道,只有你保证所有节点都有你的文件才可以。

这样的解决方法基本上就是无稽之谈。

那么我们如何解决呢?

我们把文件放到HDFS中就行了。

我们在使用HDFS的时候,可以在前边使用hadoop fs 或者 hdfs dfs 作为前缀

hadoop fs -ls / 查看HDFS中的文件目录,HDFS中并没有cd命令,我们只能通过 -ls 找到要使用的文件夹。

hadoop fs -mkdir /tmp/yuhang.zhang/ 在/tmp中建立一个文件夹

hadoop fs -put text.txt /tmp/yuhang.zhan 把本地的text.txt文件传入到HDFS:/tmp/yuhang.zhang 中

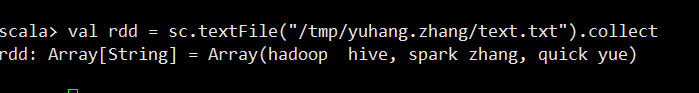

放置成功后,我们用spark-shell再次进行读取。

这样就不会报错了,我们这里并不用在加上什么 file:///hdfs:xxx.xxx.x.xx 地址了,默认就会在HDFS中去读取文件。

2.

我们可以在IDEA中编写的时候会设置参数,我们一般设置new SparkConf().setMaster(local[*])本地模式

这样我们打包完成后提交给spark的时候,任务运行的时候就会去本地读取文件啦。

注意,我们提交任务的时候如果不添加任何参数的时候一般会默认最大资源,会很占用资源。

下面是一般我们提交任务的时候采用的命令。

| 参数名 | 参数说明 |

| --master | master 的地址,提交任务到哪里执行,例如 spark://host:port, yarn, local |

| --deploy-mode | 在本地 (client) 启动 driver 或在 cluster 上启动,默认是 client |

| --class | 应用程序的主类,仅针对 java 或 scala 应用 |

| --name | 应用程序的名称 |

| --jars | 用逗号分隔的本地 jar 包,设置后,这些 jar 将包含在 driver 和 executor 的 classpath 下 |

| --packages | 包含在driver 和executor 的 classpath 中的 jar 的 maven 坐标 |

| --exclude-packages | 为了避免冲突 而指定不包含的 package |

| --repositories | 远程 repository |

| --conf PROP=VALUE |

指定 spark 配置属性的值, 例如 -conf spark.executor.extraJavaOptions="-XX:MaxPermSize=256m" |

| --properties-file | 加载的配置文件,默认为 conf/spark-defaults.conf |

| --driver-memory | Driver内存,默认 1G |

| --driver-java-options | 传给 driver 的额外的 Java 选项 |

| --driver-library-path | 传给 driver 的额外的库路径 |

| --driver-class-path | 传给 driver 的额外的类路径 |

| --driver-cores | Driver 的核数,默认是1。在 yarn 或者 standalone 下使用 |

| --executor-memory | 每个 executor 的内存,默认是1G |

| --total-executor-cores | 所有 executor 总共的核数。仅仅在 mesos 或者 standalone 下使用 |

| --num-executors | 启动的 executor 数量。默认为2。在 yarn 下使用 |

| --executor-core | 每个 executor 的核数。在yarn或者standalone下使用 |

| 参数 | 参考值 | 说明 |

|---|---|---|

| class | org.apache.spark.examples.SparkPi | 作业的主类。 |

| master | yarn | 因为 E-MapReduce 使用 Yarn 的模式,所以这里只能是 yarn 模式。 |

| yarn-client | 等同于 –-master yarn —deploy-mode client, 此时不需要指定deploy-mode。 | |

| yarn-cluster | 等同于 –-master yarn —deploy-mode cluster, 此时不需要指定deploy-mode。 | |

| deploy-mode | client | client 模式表示作业的 AM 会放在 Master 节点上运行。要注意的是,如果设置这个参数,那么需要同时指定上面 master 为 yarn。 |

| cluster | cluster 模式表示 AM 会随机的在 worker 节点中的任意一台上启动运行。要注意的是,如果设置这个参数,那么需要同时指定上面 master 为yarn。 | |

| driver-memory | 4g | driver 使用的内存,不可超过单机的 core 总数。 |

| num-executors | 2 | 创建多少个 executor。 |

| executor-memory | 2g | 各个 executor 使用的最大内存,不可超过单机的最大可使用内存。 |

| executor-cores | 2 | 各个 executor 使用的并发线程数目,也即每个 executor 最大可并发执行的 Task 数目。 |

1.spark2-submit --master yarn --deploy-mode cluster --driver-memory 1g --executor-memory 1g --num-executors 2

--executor-cores 1 --queue report_job

--class

2.--class org.apache.spark.examples.SparkPi --master yarn --deploy-mode client

--driver-memory 4g –num-executors 2 --executor-memory 2g --executor-cores 2

/opt/apps/spark-1.6.0-bin-hadoop2.6/lib/spark-examples*.jar 10

最后我们在贴一下hdfs的命令