今天主要是改了一些配置使spark可以在服务器外边运行以及安装了Scala

一、按照前面林子雨教程安装完以后 http://dblab.xmu.edu.cn/blog/804-2/

1.输入gedit /usr/local/spark/conf/spark-env.sh命令或者按照这个位置自行打开文件编辑即可

2.填入(注意IP和jdk需要根据自己版本进行相应更改)

export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath)

export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-1.8.0.232.b09-1.el6_10.x86_64/jre

#export SCALA_HOME=/usr/local/scala-2.11.12(先注释掉 等安装完Scala再根据实际Scala版本进行相应更改并取消注释)

export HADOOP_HOME=/usr/local/hadoop

export HADOOP_CONF_DIR=$HADOOP_HOME/etc/hadoop

export SPARK_MASTER_HOST=192.168.57.128

export SPARK_LOCAL_IP=192.168.57.128

3.然后输入命令

1.cp /usr/local/spark/conf/slaves.template /usr/local/spark/conf/slaves

2.gedit /usr/local/spark/conf/slaves

4.将localhost改为对应虚拟机ip的地址192.168.57.128(根据自己情况更改)

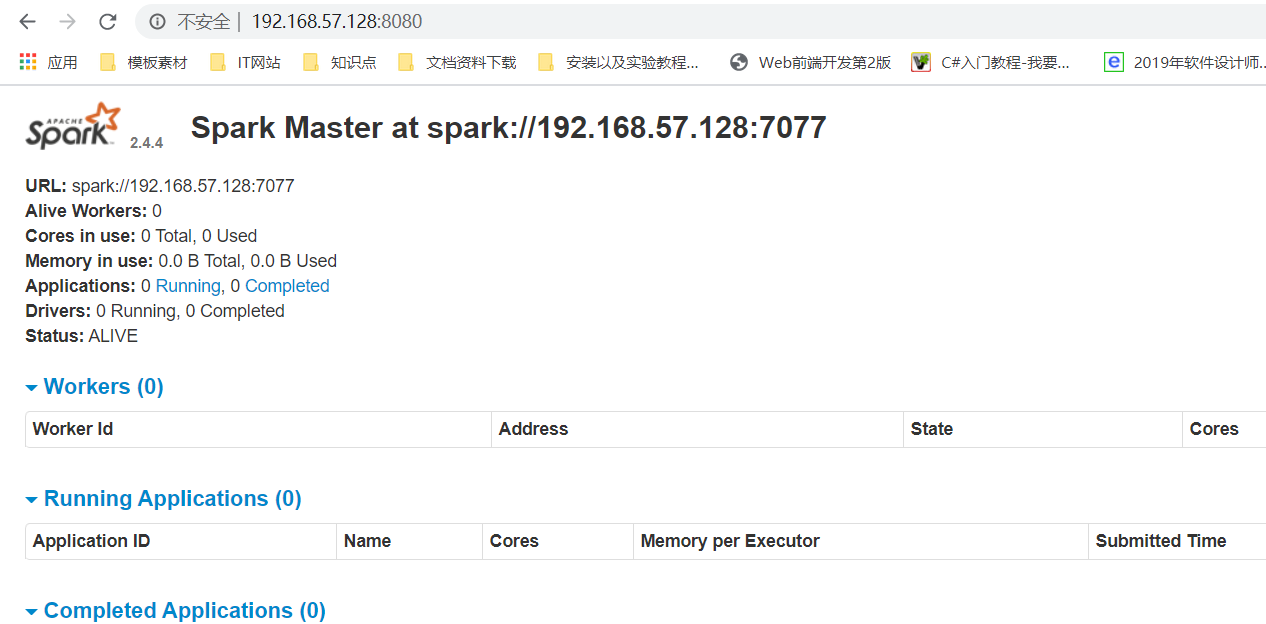

5.输入sbin/start-master.sh 验证spark安装 在服务器外边输入http://192.168.57.128:8080/

二、安装Scala

1.依次输入以下三条命令

1.wget http://downloads.lightbend.com/scala/2.11.12/scala-2.11.12.tgz(此过程时长因网速而异)

2.tar -zxvf scala-2.11.12.tgz

3.mv scala-2.11.12 /usr/local/

2.输入

gedit /etc/profile.d/scala.sh

3.添加这个后保存退出

export SCALA_HOME=/usr/local/scala-2.11.12

export PATH=$PATH:$SCALA_HOME/bin

4.输入source /etc/profile.d/scala.sh

scala -version(查看版本)出现版本信息即可

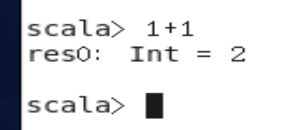

也可以直接输入Scala命令 然后运算1+1 得出2即可