作业要求来源:https://edu.cnblogs.com/campus/gzcc/GZCC-16SE2/homework/3319

1.用自己的话阐明Hadoop平台上HDFS和MapReduce的功能、工作原理和工作过程。

HDFS常用功能

1.元数据

2.检查点

3.DataNode功能

HDFS工作原理

1 分布式文件系统,它所管理的文件是被切块存储在若干台datanode服务器上.2 hdfs提供了一个统一的目录树来定位hdfs中的文件,客户端访问文件时只要指定目录树的路径即可,不用关心文件的具体物理位置.3 每一个文件的每一个切块,在hdfs集群中都可以保存多个备份(默认3份),在hdfs-site.xml中,dfs.replication的value的数量就是备份的数量.4 hdfs中有一个关键进程服务进程:namenode,它维护了一个hdfs的目录树及hdfs目录结构与文件真实存储位置的映射关系(元数据).而datanode服务进程专门负责接收和管理"文件块"-block.默认大小为128M(可配置)(dfs.blocksize).(老版本的hadoop的默认block是64M的)

HDFS工作过程

客户端要向HDFS写数据,首先要跟namenode通信以确认可以写文件并获得接收文件block的datanode,然后,客户端按顺序将文件逐个block传递给相应datanode,并由接收到block的datanode负责向其他datanode复制block的副本。

MapReduce功能实现系列:

MapReduce功能实现一---Hbase和Hdfs之间数据相互转换

MapReduce功能实现二---排序

MapReduce功能实现三---Top N

MapReduce功能实现四---小综合(从hbase中读取数据统计并在hdfs中降序输出Top 3)

MapReduce功能实现五---去重(Distinct)、计数(Count)

MapReduce功能实现六---最大值(Max)、求和(Sum)、平均值(Avg)

MapReduce功能实现七---小综合(多个job串行处理计算平均值)

MapReduce功能实现八---分区(Partition)

MapReduce功能实现九---Pv、Uv

MapReduce功能实现十---倒排索引(Inverted Index)

MapReduce功能实现十一---join

2.HDFS上运行MapReduce

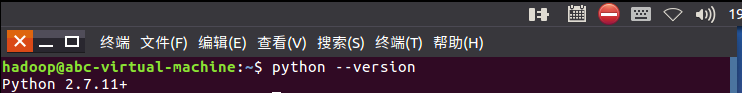

1)查看是否已经安装python:

2)在/home/hadoop/路径下建立wc文件夹,在文件夹内新建mapper.py、reducer.py、run.sh和文本文件HarryPotter.txt:

Python练手例子(2)

Python练手例子(1)

Python学习之旅(三十八)

《剑指offer》— JavaScript(24)二叉树中和为某一值的路径

《剑指offer》— JavaScript(23)二叉搜索树的后序遍历序列

《剑指offer》— JavaScript(22)从上往下打印二叉树

《剑指offer》— JavaScript(21)栈的压入、弹出序列

《剑指offer》— JavaScript(20)包含min函数的栈

《剑指offer》— JavaScript(19)顺时针打印矩阵

Copyright © 2011-2022 走看看