1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)进行词频统计。

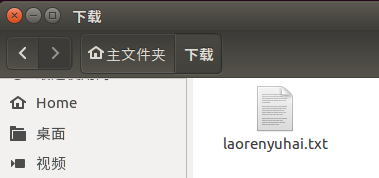

在网上下载一个老人与海的英文小说,在虚拟机打开百度网盘的文件,然后下载到本地。

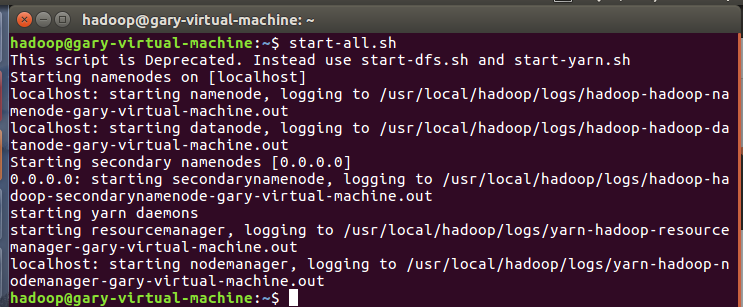

首先要启动dfs:

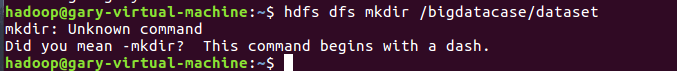

在hdfs上创建文件夹:

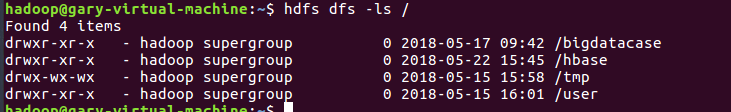

查看hdfs上的所有文件:

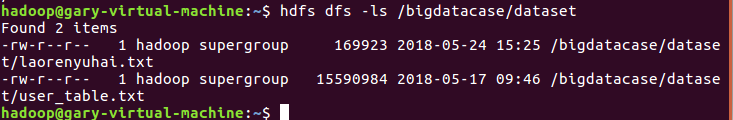

把下载的文件上传到hdfs:

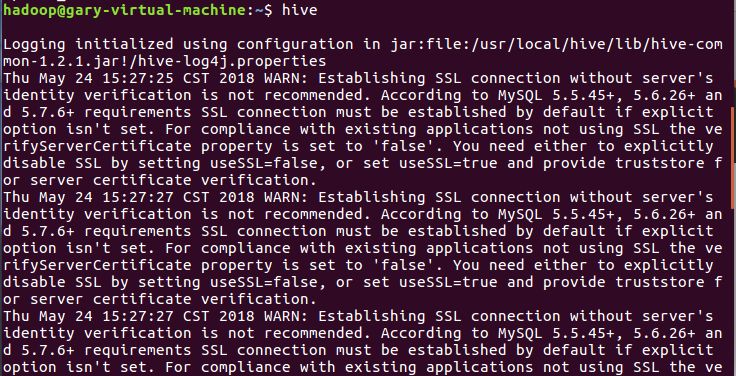

启动hive:

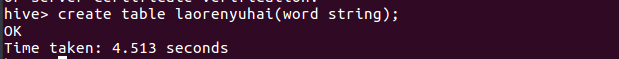

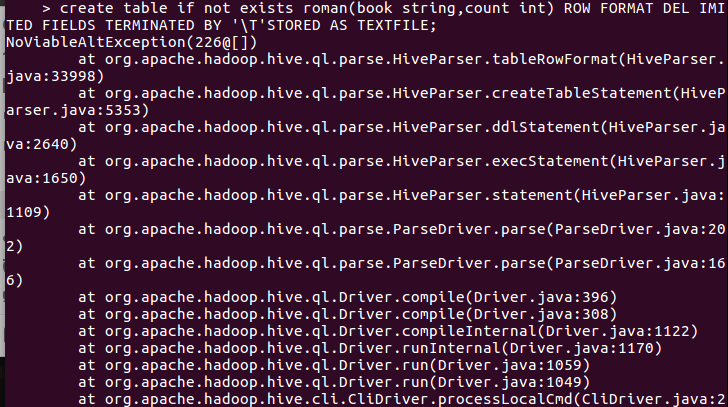

创建表:

把hdsf上的文件内容添加进去表里:

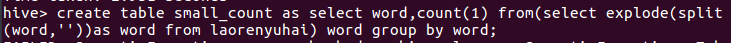

创建一个新的表存放词频统计:

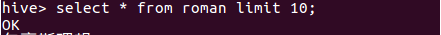

查找表的前十条记录:

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

将爬虫作业产生的文件转为txt格式的文件,发生至qq邮箱,然后再虚拟机下载操作。

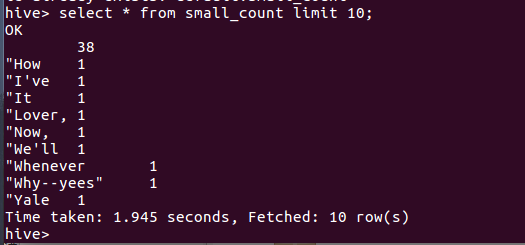

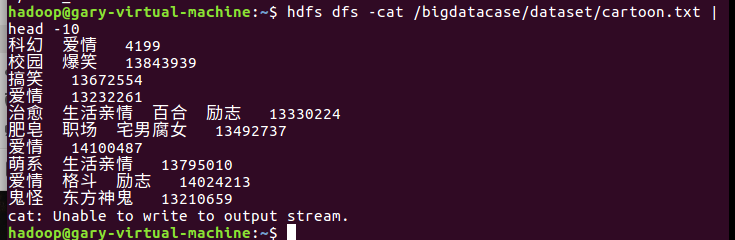

下载下来的txt文件显示前十条:

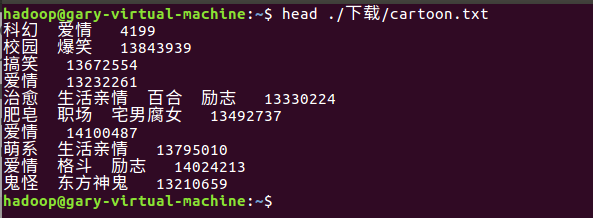

把文件上传至hdfs,并查看:

查看前十条:

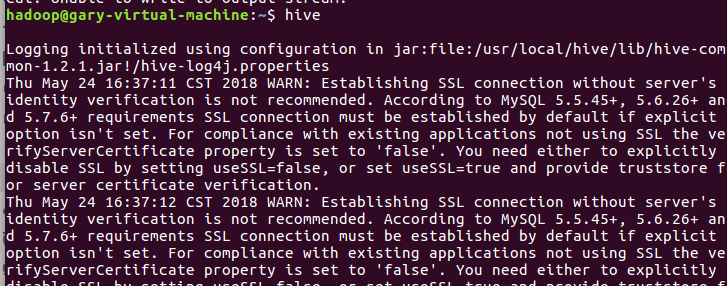

启动hive:

创建数据库:

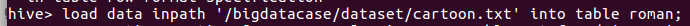

把数据加载进去:

查看前十条: