一.集群规划

| Name | Master | Slave1 | Slave2 |

| IP | 192.168.2.98 | 192.168.2.99 | 192.168.2.100 |

| Jdk版本 | 1.8.0.171 | 1.8.0.171 | 1.8.0.171 |

| Zookeeper版本 | 3.4.10 | 3.4.10 | 3.4.10 |

| Hadoop版本 | 2.7.3 | 2.7.3 | 2.7.3 |

| Scala版本 | 2.11.12 | 2.11.12 | 2.11.12 |

| Spark版本 | 2.4.0 | 2.4.0 | 2.4.0 |

| Master | Y | N | N |

| Worker | N | Y | Y |

二.搭建Spark

tar包链接: https://pan.baidu.com/s/1hwLPI0eUwkpGmP5ROqM6Lw 提取码: k7m3

启动Spark之前得先启动Hadoop,可移至Hadoop分布式搭建进行安装。

# mkdir /usr/scala 主结点建立目录1 # tar -zxvf scala-2.11.12.tgz -C /usr/scala/ 解压 # vim /etc/profile 环境变量添加 export SCALA_HOME=/usr/scala/scala-2.11.12 export PATH=$SCALA_HOME/bin:$PATH # source /etc/profile 主结点生效环境变量 # scala -version 验证主节点安装 # mkdir /usr/spark 主结点建立目录2 # tar -zxvf /opt/soft/spark-2.4.0-bin-hadoop2.7.tgz -C /usr/spark/ 解压 # vim /etc/profile 添加环境变量 export SPARK_HOME=/usr/spark/spark-2.4.0-bin-hadoop2.7 export PATH=$SPARK_HOME/bin:$PATH # cd /usr/spark/spark-2.4.0-bin-hadoop2.7/conf/ 进入 # cp spark-env.sh.template spark-env.sh & vim spark-env.sh 复制并进入配置1添加 # spark主结点IP export SPARK_MASTER_IP=master # Scala安装目录 export SCALA_HOME=/usr/scala/scala-2.11.12 # 运行内存 export SPARK_WORKER_MEMORY=8g # 运行核数 export SPARK_WORKER_CORES=1 # java安装目录 export JAVA_HOME=/usr/java/jdk1.8.0_171 # hadoop安装目录 export HADOOP_HOME=/usr/hadoop/hadoop-2.7.3 # hadoop配置文件所在路径 export HADOOP_CONF_DIR=/usr/hadoop/hadoop-2.7.3/etc/Hadoop # cp slaves.template slaves & vim slaves 添加 slave1 slave2 # scp -r /usr/scala root@slave1:/usr/ scala分发各子结点 # scp -r /usr/scala root@slave2:/usr/ # scp -r /usr/spark root@slave1:/usr/ spark分发各子结点 # scp -r /usr/spark root@slave2:/usr/ # scp -r /etc/profile root@slave1:/etc/ 环境分发各子结点 # scp -r /etc/profile root@slave2:/etc/ # source /etc/profile 各结点执行生效环境变量 # /usr/spark/spark-2.4.0-bin-hadoop2.7/sbin/start-all.sh 开启集群 stop为关闭hadoop得提前启动

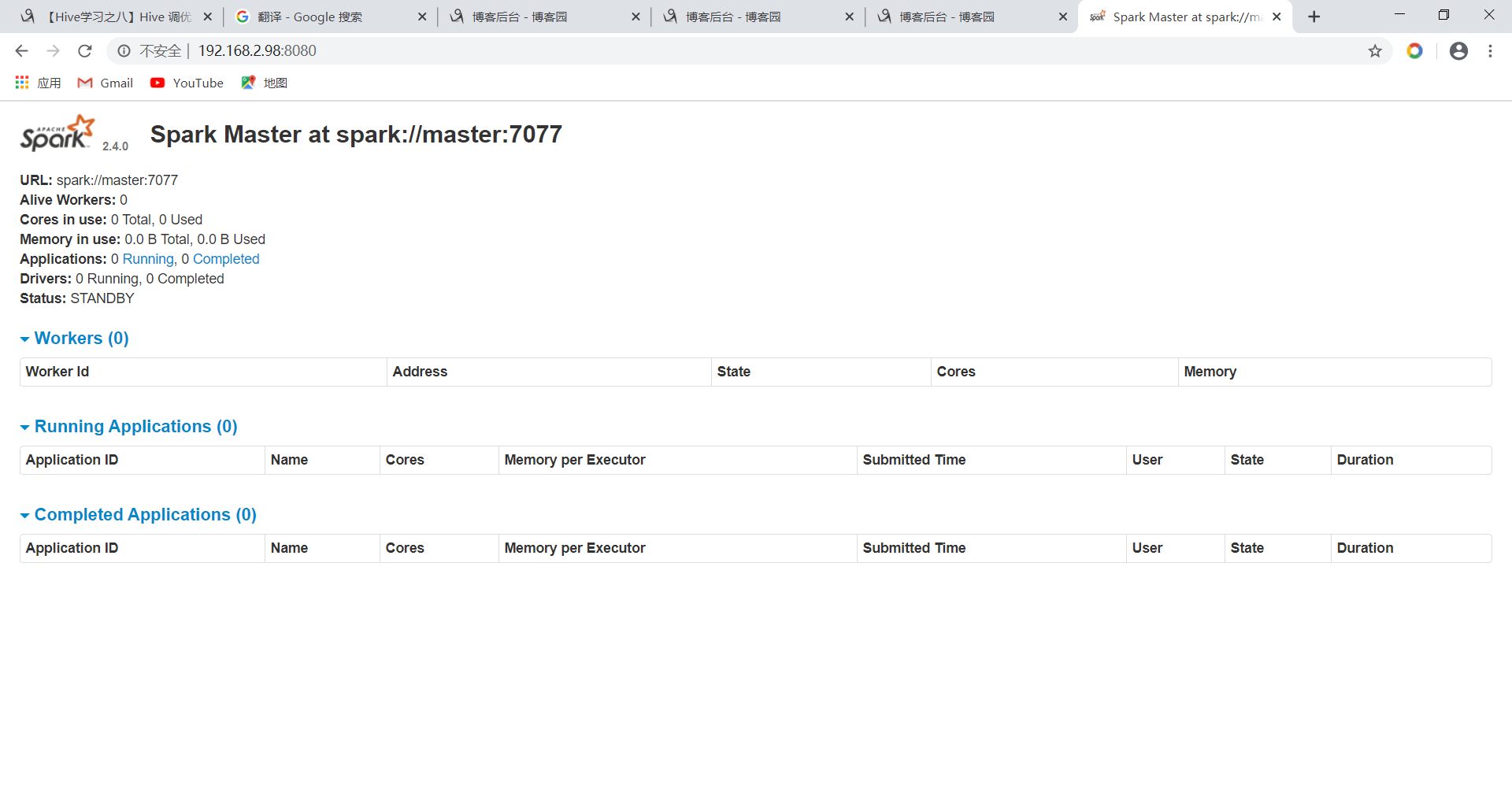

打开浏览器网址栏输: 192.168.2.98:8080访问Spark的web管理页面

访问WEB