HBase集群搭建

上传解压

(1) 上传hbase安装包,这里使用的是1.3.1

上传到/export/software文件夹下(没有文件夹,自己创建mkdir /export/software,之后的就不在赘述)

(2) 解压

tar -zxvf /export/software/hbase-1.3.1-bin.tar.gz -C /export/servers

配置hbase集群

把hadoop的hdfs-site.xml和core-site.xml 放到hbase/conf下

cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop cp hdfs-site.xml core-site.xml /export/servers/hbase-1.3.1/conf

进入hbase的conf目录下

cd /export/servers/hbase/conf

修改hbase-env.sh

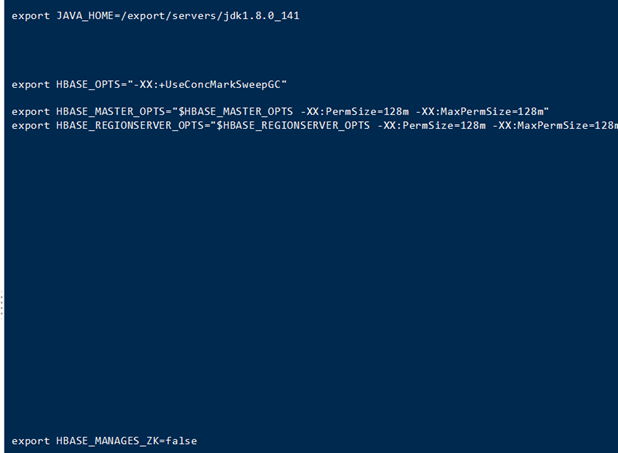

过滤查看cat hbase-env.sh |grep -v "#"(修改后的结果)

vi hbase-env.sh

在hbash-env.sh中修改这两条

export JAVA_HOME=/usr/java/jdk1.8.0

//告诉hbase能使用外部的zk集群(而不是仅仅使用自己的)

export HBASE_MANAGES_ZK=false

修改hbase-site.xml

vi hbase-site.xml

我这里使用的是node01(虚拟机的第一台主机)

<configuration>

<!-- 指定hbase在HDFS上存储的路径 -->

<property>

<name>hbase.rootdir</name>

<value>hdfs://node01:8020/hbase</value>

</property>

<!-- 指定hbase是分布式的 -->

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

</property>

<!-- 指定zk的地址,多个用“,”分割 -->

<property>

<name>hbase.zookeeper.quorum</name>

<value>node01:2181,node02:2181,node03:2181</value>

</property>

<property>

<name>hbase.zookeeper.property.clientPort</name>

<value>2181</value>

</property>

<!--指定hbase管理页面-->

<property>

<name>hbase.master.info.port</name>

<value>60010</value>

</property>

</configuration>

修改 vi regionservers(这里是我的3台虚拟机的主机名)

node01

node02

node03

分发安装文件并启动

scp -r /export/servers/ hbase-1.3.1/ node02:/export/servers scp -r /export/servers/ hbase-1.3.1/ node03:/export/servers

先启动zookeeper集群

然后在启动hadoop(hdfs集群)

因为hbase基于hdfs,hbase的元数据存储在zookeeper

最后启动:hbase

cd /export/servers/hbase-1.3.1/bin ./start-hbase.sh

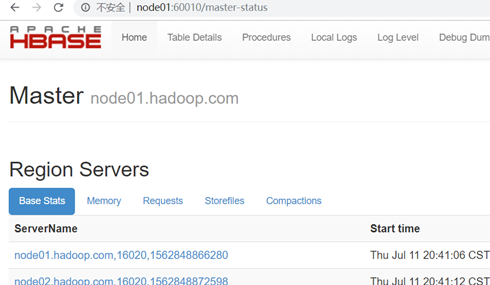

测试访问node01:60010

这是成功的信号。