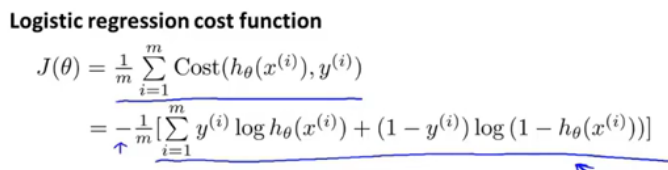

1.极大似然估计-逻辑回归代价函数的简化

Andrew Ng的ML视频上讲到:逻辑回归的代价函数可以用最大似然估计法进行简化成上图中第二个式子。

所以学习了一下极大似然估计原理:

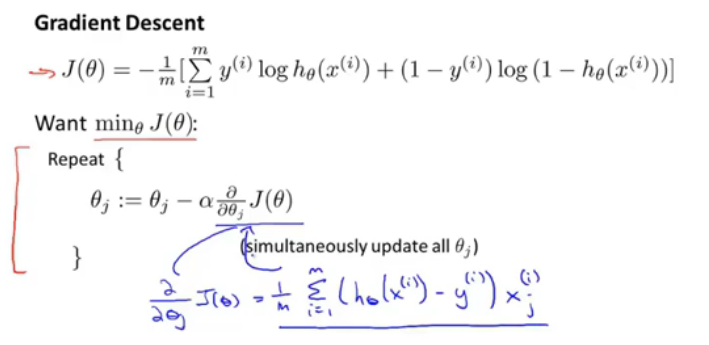

2.求偏导

逻辑回归代价函数对θj求偏导,得到手写的部分。手动求解偏导函数如下:

卡住了,还是不太会求,怎么求啊!怎么可能是这个结果?

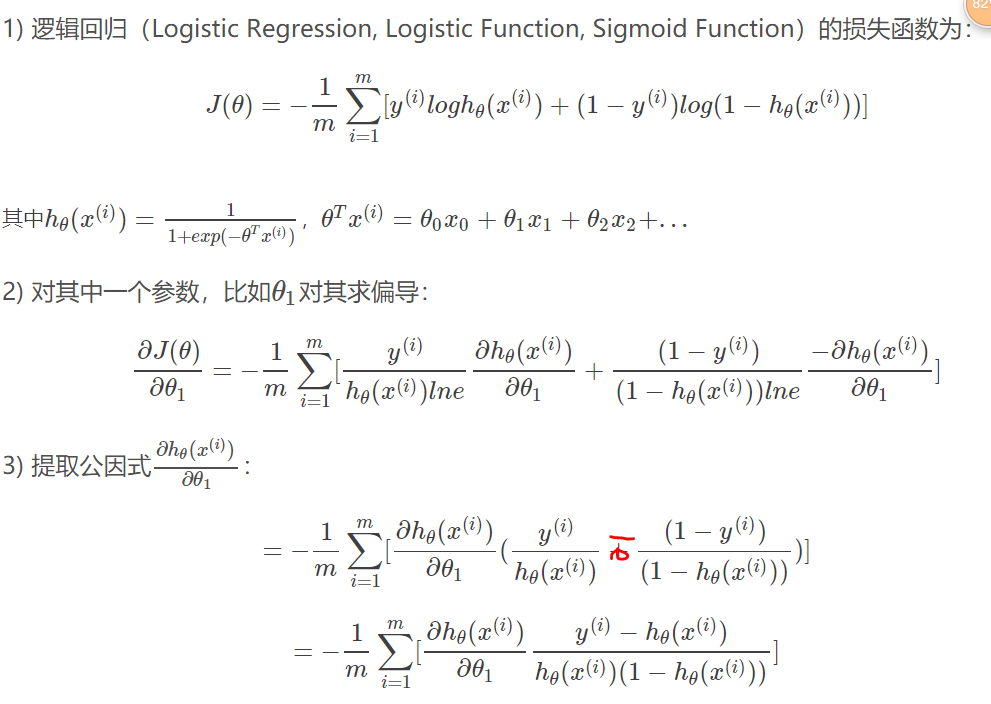

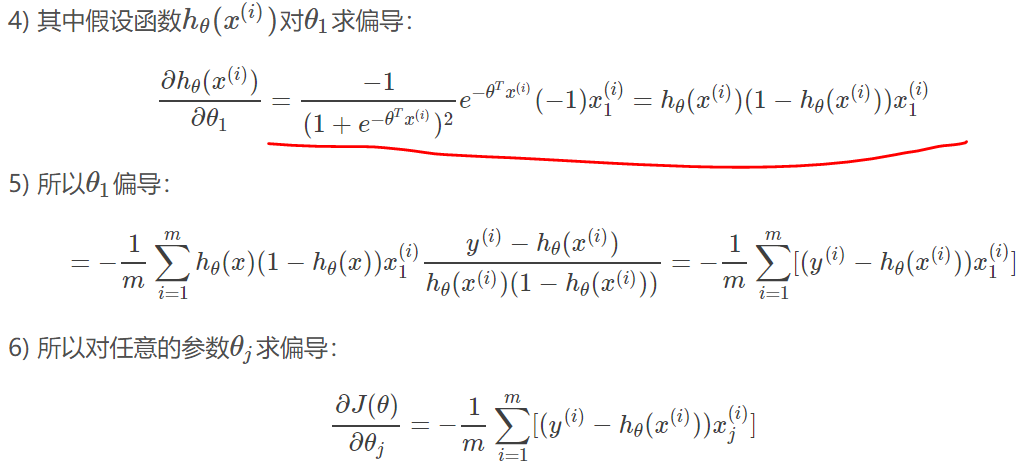

2019-1-18更————

转自:https://blog.csdn.net/jizhidexiaoming/article/details/80591994

求导过程:

//简直太厉害了,学习了。

3.逻辑回归与线性回归是不同的,

其中蓝色的式子是线性回归,红色的是逻辑回归。

其中蓝色的式子是线性回归,红色的是逻辑回归。

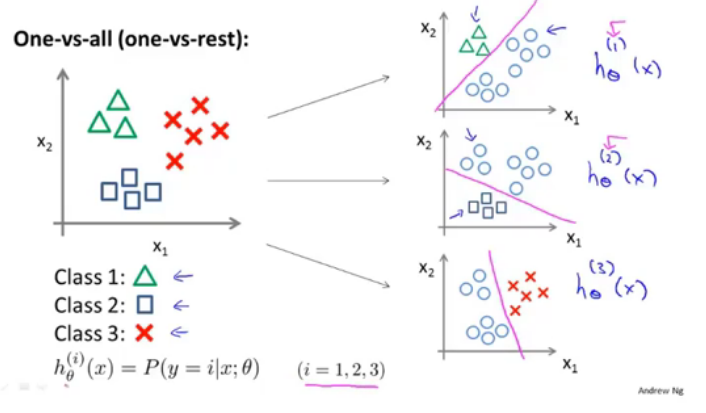

5.逻辑回归解决多分类

多分类问题,比如给邮件加上标签;对不同的文件进行分类;疾病诊断;天气判断;

也就是y可以取多个值。

对多分类问题,进行多次不同的标记训练,one-vs-all.如图这样就训练了三个分类器hθ(x),那么在有新样本输入时,就max hθ(x);